OpenAI近期確實經歷了一些重要的變動,先是AGI安全團隊流失,現在則是「AGI Readiness」團隊。

AGI Readiness團隊的解散並不意味著OpenAI放棄了對AGI的研究和開發,而是在組織結構和研究方向上進行調整,一切為L2級AI開路。換言之,這不是什麽高層動蕩,而是有計劃的整軍,整軍之後即將一路狂奔,遙遙領先。

他們是如何產生了整軍的需求呢?這個調整意味著什麽,又對行業帶來什麽影響?

一、我們先看看這個AGI Readiness團隊是幹啥的。

簡單說,這個團隊類似國內某些大廠的政策研究團隊,而非技術研發團隊。

AGI Readiness團隊負責評估全球對於AGI技術的準備情況,並提供相應的政策建議。他們的工作是確保AI技術的發展能夠安全、可靠且有益地服務於社會。

該團隊還涉及到對AI技術進行安全監督,以預防潛在的技術濫用和誤用,保護社會免受可能的負面影響。

AGI Readiness團隊進行的研究和分析對於制定有效的AI政策至關重要,這些政策有助於引導AI技術的發展方向,確保技術的健康發展。

AGI Readiness團隊的工作與AI對齊的目標緊密相關,即確保AI系統的行為與人類的價值觀和目標保持一致,避免技術發展帶來的潛在風險 。

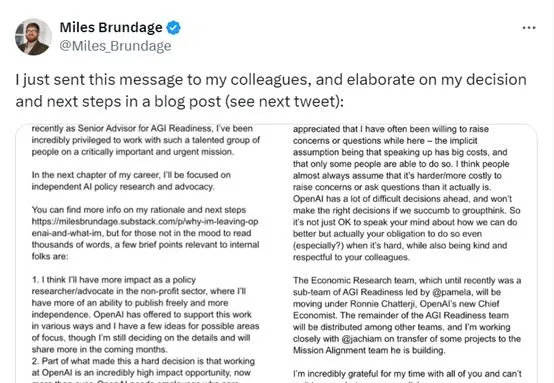

二、這個團隊的負責人Miles Brundage是一個什麽人物?

他是一位專註於人工智慧政策和研究的學者。

他在2018年加入OpenAI,擔任了多個重要職務,包括研究科學家、政策研究負責人以及高級AGI顧問。

在OpenAI工作期間,Brundage領導了外部紅隊計劃,透過模擬攻擊來測試OpenAI的AI系統的安全性和魯棒性,並推動了OpenAI的「系統卡」報告的建立,這些報告詳細記錄了AI模型的能力和局限性,為公眾和研究者提供了重要的透明度。

Brundage在政策研究方面也發揮了重要作用,他積極參與了有關AI進展評估、AI安全監管、AI經濟影響以及有益AI套用加速推進等方面的研究。他提出的「AI大戰略」概念,旨在制定確保人工智慧廣泛造福人類的框架。

在加入OpenAI之前,Brundage曾在牛津大學的未來人類研究所工作,專註於AI政策和治理問題。他的學術背景包括公共政策和科學技術研究,這為他提供了在AI政策領域工作的堅實基礎。

Brundage在亞利桑那州立大學完成了他的博士學位,專註於負責任的人工智慧治理、評估、理論框架和探索。他的研究興趣涵蓋了評估和預測AI進展、前沿AI安全的監管問題、AI的經濟影響、有益AI套用的加速推進和計算治理。

在學術貢獻方面,Brundage發表了一系列關於人工智慧社會影響的論文,包括但不限於AI的合作發展、AI模型的能力和局限性、以及AI的惡意使用等主題。他的工作不僅在學術界產生了影響,也為政策制定者和行業實踐者提供了寶貴的見解和指導。

三、Miles Brundage離開OpenAI的原因是什麽?

綜合公開的報道,可以看到Brundage表達了如下幾個原因,對AGI學術態度偏保守,下面括弧裏是簡單解讀:

1.追求獨立的AI政策研究:Brundage 希望跳出行業,從外部影響和推動人工智慧的發展。他認為在外部進行研究會更具影響力,並希望減少偏見。

(解讀;公司內部存在阻力)

2.研究釋出限制的增加:Brundage 提到,離職的主要原因之一是研究釋出的限制日益增加。他希望在人工智慧政策討論中成為獨立的聲音。

(解讀:內部限制多)

3.對OpenAI及全球AGI準備狀態的評估:Brundage 認為,OpenAI及世界在AGI(通用人工智慧)籌備方面「尚未準備好」。

因此,他計劃建立自己的非營利組織或加入現有的組織,專註於AI政策研究和倡導。

(解讀:「尚未準備好」觀點持有人離職,說明內部不同意「尚未準備好」這一判斷,內部存在較大分歧)

4.對AI安全和監管的關註:Brundage 對於前沿 AI 安全與保障的監管問題有深刻的認識,他認為改善前沿AI安全與保障是當務之急。

(解讀:OpenAI可能認為對AI安全與保障沒有那麽急切)

5.對AI經濟影響的考量:Brundage認為,人工智慧很可能會帶來足夠的經濟增長,從而使人們可以輕松地提前退休,過上高標準的生活。他希望政策制定者能夠迅速采取行動,以確保AI帶來的財富能夠公平分配。(解讀:這豈不是影響VC發財?)

6.對AI有益套用的推進:Brundage 還對AI的有益套用表示了興趣,他認為即使對(幾乎)只專註於降低AI風險的人來說,認真考慮 AI的有益套用也是有意義的。

7.計算治理:Brundage 對於計算硬體在人工智慧政策中的重要性有獨到的見解,他認為計算治理是人工智慧政策的一個重要焦點。

四、OpenAI解散其「AGI Readiness」團隊意味著什麽?

OpenAI在獲得66億美元巨額融資後,其估值飆升至1570億美元。這可能使得公司更加註重短期的財務報酬,而不是長期的技術準備和安全問題。

OpenAI可能正在重新評估其在AGI領域的戰略,並將資源重新分配到其他優先事項上,比如商業化。

隨著OpenAI在商業化道路上的快速發展,公司可能認為在人工智慧安全建設方面的步伐相對遲緩。這表明公司可能更專註於產品的叠代和商業化,而不是長期的AI安全問題。

從Brundage自己的離職聲明前三點來看,OpenAI公司內部有阻力,給他的研究帶來不少限制,

他認為世界還未做好準備迎接AGI的到來,這表明公司內部對於AGI的未來發展和潛在風險存在分歧。

綜合OpenAI和Brundage情況來看,Brundage的存在已經成了公司發展的絆腳石,必須去之而後快。

這一變動也反映了OpenAI已經迅速做出了取舍---

在整個行業對於AGI準備狀態還處於左右搖擺的時候,OpenAI已經看到了方向,放下了原本的顧慮,一路狂奔。

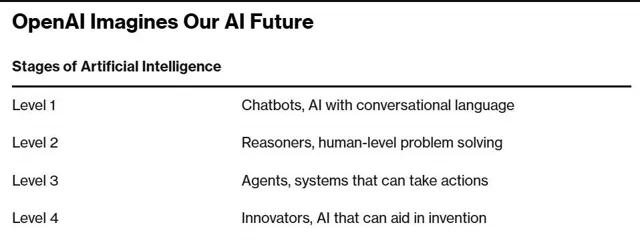

OpenA看到了什麽方向?參考OpenAI的AGI的5級路線圖:

L1:聊天機器人 - 具有對話能力的AI。

L2:推理者 - 像人類一樣能夠解決問題的AI,預計能解決博士水平的基本問題。

L3:智慧體 - 不僅能思考,還可以采取行動的AI系統。

L4:創新者 - 能夠協助發明創造的AI。

L5:組織者 - 可以完成組織工作的AI,標誌著實作AGI。

目前,OpenAI自稱其AI模型正處於L1級別,即將達到L2級別。OpenAI的CTO曾透露,公司將致力於研究特定任務上博士級別的智慧,並可能在一年半之內實作。這表明OpenAI的技術實力正在迅速發展,預計在未來18個月內推出達到L2級別的下一代模型。

阻擋openAI在這條道路發展的安全團隊已經消滅,阻礙發展的Readiness團隊也已經解散....

明後年AI博士即將出現,行業壓力陡增。國內還在尋找商業化道路的大小廠,不久就將感受到openAI帶來的寒意,瑟瑟發抖。