魚羊 西風 發自 凹非寺

量子位 | 公眾號 QbitAI

大模型圈再曝抄襲大瓜,這回,「被告」還是大名鼎鼎的谷歌DeepMind

。

「原告」直接怒噴:他們就是把我們的技術報告洗了一遍

!

具體是這麽個事兒:

谷歌DeepMind一篇中了頂流新生代會議CoLM 2024的論文被掛了,瓜主直指其抄襲了一年前就掛在arXiv上的一項研究。開源的那種。

兩篇論文探討的都是一種規範模型文本生成結構的方法。

抓馬的是,谷歌DeepMind這篇論文中確實明晃晃寫著參照了「原告」的論文。

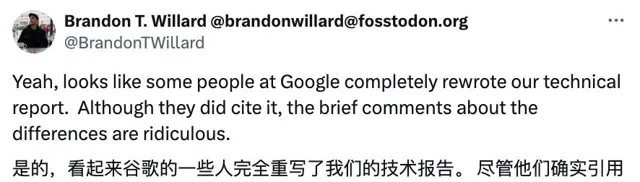

然鵝,即便是標明了參照,「原告」的兩位論文作者Brandon T. Willard(布蘭登)和R´emi Louf(雷米)還是堅稱谷歌抄襲,並認為:

谷歌對兩者差異性的表述「簡直荒謬」。

而不少網友看過論文後也緩緩打出一個問號:CoLM是怎麽審的稿?

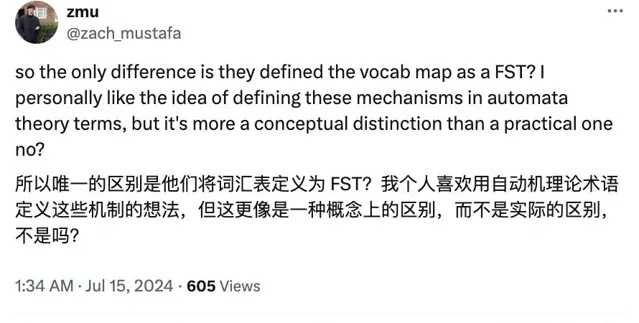

唯一區別是換了概念?

趕緊瞅一眼論文對比……

兩篇論文的比較

先淺看一眼兩篇論文的摘要對比。

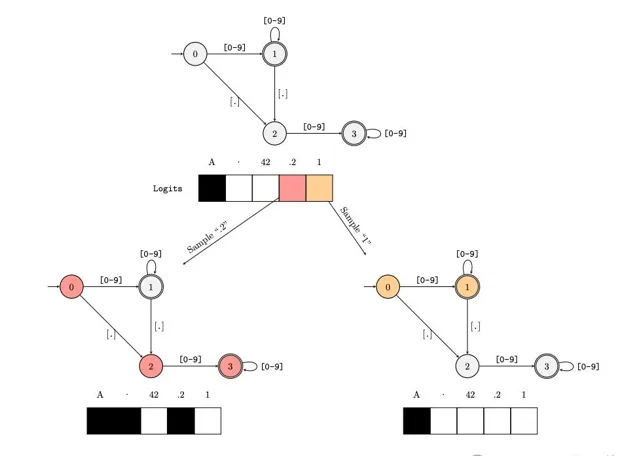

谷歌DeepMind的論文說的是,tokenization給約束語言模型輸出帶來了麻煩,他們引入自動機理論來解決這些問題,核心是避免在每個解碼步驟遍歷所有邏輯值(logits)。

該方法只需要存取每個token的解碼邏輯值,計算與語言模型的大小無關,高效且易用於幾乎所有語言模型架構。

而「原告」的說法大致是:

提出了一個高效框架,透過在語言模型的詞匯表上構建索引,來大幅提升約束文本生成的效率。簡單來說,就是透過索引避免對全部邏輯值的遍歷

。

同樣「不依賴於具體模型」。

方向上確實大差不差,我們還是接著來看看更多詳細內容。

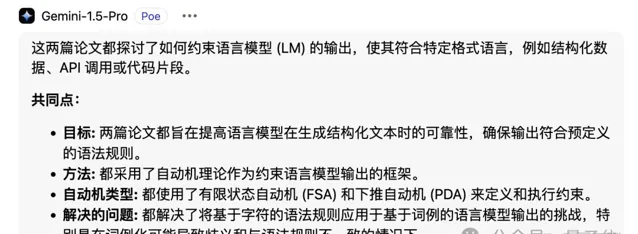

我們用谷歌Gemini 1.5 Pro分別總結了兩篇論文的主要內容,並接著讓Gemini來比較兩者的異同。

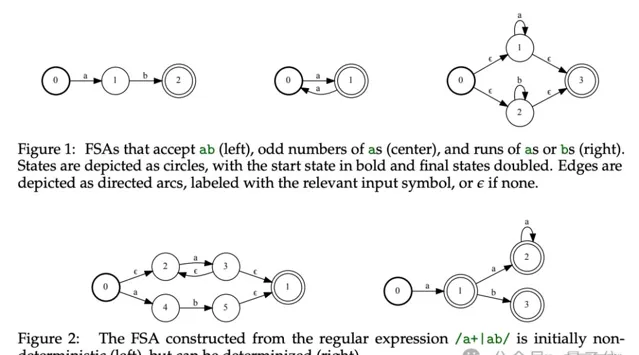

對於「被告」谷歌這篇論文,Gemini總結其方法是將detokenization重新定義為有限狀態轉換器(FST)操作

。

將此FST與表示目標形式語言的自動機組合,這種自動機可以用正規表式或語法來表示。

透過以上結合,生成一個基於token的自動機,用於在解碼過程中約束語言模型,確保其輸出的文本符合預設的形式語言規範。

此外,谷歌論文中還進行了一系列正規表式擴充套件,這些擴充套件透過使用特別命名的捕獲組來編寫,顯著提升了系統處理文本時的效率和表達能力。

而對於「原告」論文,Gemini總結其方法的核心是將文本生成問題重新定義為有限狀態機(FSM)之間的轉換

。

「原告」的具體方法是:

利用正規表式或上下文無關文法構建FSM,並將其用於指導文本生成過程。

透過構建詞匯表索引,高效地確定每個步驟中的有效詞,避免遍歷整個詞匯表。

Gemini列出了兩篇論文的共同點。

至於兩者的區別,有點像前頭那位網友說的,簡單總結就是:谷歌將詞匯表定義為了一個FST。

前面也說到了,谷歌在「Related work」中將原告論文列為「最相關」的一項工作:

最相關的研究是Outlines(Willard&Louf, 2023),該研究同樣采用有限狀態自動機(FSA)和下推自動機(PDA)作為約束手段——我們的方法是在2023年初獨立開發的。

谷歌認為兩者的差異在於,Outlines的方法基於一種特制的「索引」操作,需要手動擴充套件到新的套用場景。相比之下,谷歌使用自動機理論徹底重新定義了整個過程,使得套用FSA和泛化到PDA變得更加容易。

另一個區別是,谷歌定義了擴充套件以支持通配符匹配,並提高了可用性。

谷歌緊接著在介紹下面的兩項相關工作中,也都提到了Outlines。

一項是Yin等人(2024年)透過增加「壓縮」文本段到預填充的功能,擴充套件了Outlines。

另一項是Ugare等人(2024年)近期提出的一個系統,名為SynCode。它也利用FSA,但采用LALR和LR解析器而非PDA處理語法。

與Outlines類似,該方法依賴於客製演算法。

但吃瓜群眾們顯然不是很買賬:

CoLM的評審們應該註意。我不認為這看上去是各自獨立的「同期工作」。

網友:這事兒不罕見…

這件事一發酵,不少網友都怒了,抄襲可恥,更何況「科技巨頭剽竊小團隊的工作成果不是第一次了」。

順便一提,布蘭登和雷米釋出原告論文的時候都在給Normal Computing遠端工作,這家AI Infra公司成立於2022年。

哦對了,Normal Computing的創始團隊有一部份就來自Google Brain……

另外,布蘭登和雷米現在合夥出來創業了,新公司名叫.txt,官網資訊顯示,其目標是提供快速可靠的資訊提取模型。並且官網掛出的GitHub主頁,就是Outlines倉庫。

說回到網友這邊,更讓大家夥兒生氣的是,「這種情況已經變得普遍」。

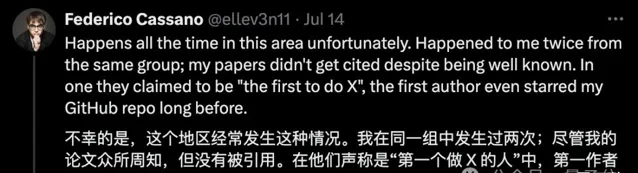

一位來自荷蘭代爾夫特理工大學的博士後分享了自己的遭遇:

去年10月我們完成了一項工作,最近有篇已被接收的論文采用了相同的思路和概念,但甚至沒有參照我們的論文。

還有一位美國東北大學的老哥更慘,這種情況他遭遇過兩次,下手的還都是同一個組。並且對面那位第一作者還給他的GitHub加過星標……

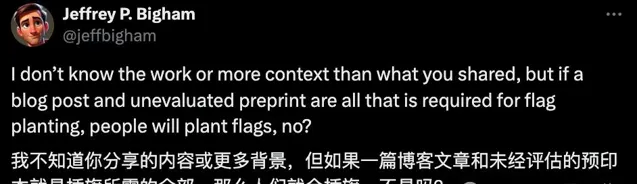

不過,也有網友表達了不同的意見:

如果說發個部落格文章或未經評估的預印本論文就算占坑了,那人人都會占坑,不是嗎?

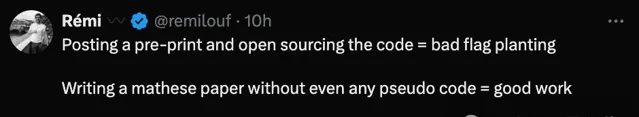

對此,雷米怒懟:

好家夥,釋出預印本論文並開原始碼 = 占坑;

寫篇數學論文,甚至不需要任何虛擬碼 = 好工作???

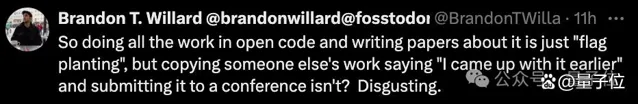

布蘭登老哥也表示yue了:

開原始碼並撰寫相關論文是「占坑」,復制別人的工作卻說「我更早有了這個想法」且投稿了會議反而不是啦?真惡心。

瓜就先吃到這裏,對此你有什麽想法?不妨在評論區繼續討論~

兩篇論文戳這裏:

谷歌DeepMind論文:https://arxiv.org/abs/2407.08103v1

原告論文:https://arxiv.org/abs/2307.09702

參考連結:

[1]https://x.com/remilouf/status/1812164616362832287?s=46

[2]https://x.com/karan4d/status/1812172329268699467?s=46

[3]https://x.com/brandontwillard/status/1812163165767053772?s=46