作者 | 程茜

编辑 | Panken

芯东西3月26日报道,上周,在AMD AI PC创新峰会上,AMD董事会主席及CEO苏姿丰盛赞AI PC,并秀出了AMD 大举布局AI PC的肌肉。

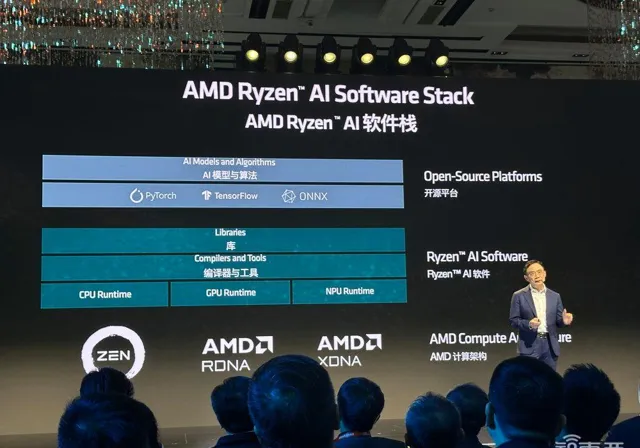

在技术布局上,AMD利用了三种计算引擎:基于「Zen」架构的CPU,基于AMD RDNA 的集成或独立GPU,以及基于AMD XDNA的AI引擎NPU,来满足对于延迟、计算、功耗等有不同需求的AI应用。

具体来说,AMD高级副总裁、GPU技术与工程研发王启尚在峰会现场重点介绍了4种不同架构,也就是为了满足广泛的AI需求,AMD从云、边缘到终端开发的4种不同架构,其中,Zen主要用于通用处理和AI推理,CDNA用于HPC、AI训练与密集推理,RDNA用于游戏和基于AI的内容开发,XDNA聚焦于低功耗、一直在线的AI推理需求。

随着丰富的大模型应用出现,用户对其的感知更高且需求更为明确时,会有很多工作负载可以在与用户距离更近的边缘端、终端运行。因此,王启尚认为,未来的发展方向会更偏向数据中心运行的基础模型、本地运行的模型相结合的「hybrid AI」(混合人工智能)方式。

在这背后,AMD的优势在于已经全栈布局了面向数据中心、边缘端、终端的技术基础,能覆盖AI从云端到边缘端,甚至终端的生态链,实现端到端优化。

AMD AI PC创新峰会后,芯东西等媒体与AMD高级副总裁、GPU技术与工程研发王启尚进行了深入交流,深入剖析面对AI PC这一新物种,AMD在其中扮演了什么样的角色,以及背后的技术秘籍。

▲AMD高级副总裁、GPU技术与工程研发王启尚

一、3大原因加速推动,AI PC换机潮将涌现

去年,AI PC概念首次出现,并被定义为AI PC元年,IDC的数据预测显示,2024年中国AI PC新机出货占比将超过50%。可以看出,AI PC的市场渗透率正在加速增长。

相比于目前可以在AI PC上使用的生成式AI应用而言,AI PC将会带来一波换机潮。在王启尚看来,这背后涉及三大原因。

首先,AI PC支持本地化使用AI软件和工具,并且能够离线使用。

第二点是具有很好的隐私保护功能 ,如果用户通过AI来处理一些私人文件和照片时不希望上传到云端去做处理,通过AI PC就可以实现本地化处理,使得用户的AI使用需求得以满足的同时,也确保了个人隐私的保护。

与此同时,相比于通过云端AI处理方案,AI PC则是在本地化进行任务处理,有效解决了延迟问题,提升了效率,因为它不需要像云端作业那样,等待上传和反馈。另外,云端的AI应用也并非免费服务,用户使用AI PC就可以享受到原生本地化AI服务,只需要花费购买电脑的费用,而不需要再为AI应用软件额外付费。

第三点是在内容创作方面,因为 AI PC已经具备了基础AI能力 。所以,当用户使用办公软件或召开视频会议的时候,不需要再另行加载AI工具进行辅助操作和效果优化,例如制作幻灯片时需要通过AI软件提供灵感支持;召开视频会议时需要美颜效果和背景模糊处理等,AI PC已经内置了这些原生态功能,可以直接帮助用户实现这些基础的AI应用需求。

这背后将AI应用部署到AI PC中时,王启尚解释说,AMD的 XDNA架构 将AI部署到AI PC上的用户体验中,主要依赖于其特殊的设计和架构。它可以将架构区分成不同的区域,每个区域同时处理任务而互不干扰,这一点是传统的GPU架构所不具备的能力。另外,XDNA的每瓦性能非常高,因此可以在低功耗的条件下执行AI工作任务,并且实现多任务并行处理,带给用户新一代的作用系统和更优质的用户体验。

二、绝对算力+每瓦算力性能提升,应对多元化算力需求

今年年初,OpenAI的文生视频模型亮相,其惊艳的视频生成效果震惊大模型产业。当越来越多能力强大的大模型走向云端或本地时,算力无疑会面临严峻的挑战。

王启尚认为:「我相信未来对算力的要求会越来越高,无论是在云端还是本地。就我个人而言,认为未来的发展方向会更偏向 「hybrid AI」(混合人工智能)方式 。也就是通过数据中心来进行基础的大模型训练与推理,日常功能性的需求则通过AI PC在本地化进行处理,不再需要将需求上传至云端。这样不但可以实现节能并降低延迟,还可以省去很多花费,又保护了隐私安全。」

此外,他补充道,并不是所有问题都需要通过大型数据中心解决,「混合式AI」是一个不错的解决方案,让云端数据中心和本地化AI PC各自执行相应的任务,这样并不但能解决高功耗问题,还能够提升效率。因此,这也是一个有效解决「电力荒」问题的方案。

谈到Ryzen Al软件平台时,王启尚称, Ryzen AI软件 已经具备了定向编译能力,即可以将编译任务指定派发给CPU、GPU或NPU来执行。三者的运算单元各有其自身的优势。AMD希望可以实现智能化编译,通过对任务进行需求分析,根据硬件架构,智能化地分配给CPU、GPU或NPU,使得不同类型的编译需求分配给最适合的角色进行处理,使得CPU、GPU、NPU实现智能联动,充分发挥各自的优势能力。

除了绝对的算力提升外,AMD还在关注每瓦算力性能的平衡。

王启尚提到了数据流架构DataFlow,传统的GPU架构的工作模式是把任务逐层传递,并且在显卡和内存之间反复执行「读」与「写」的动作,使得PC的功耗增大。

而数据流架构则可以并行执行「数据访问」和「数据计算」不需要逐级执行任务,这种架构可以消除指令操作导致的额外时间开销,避免了运算单元和外界显存之间的多次往返交互,从而使得每瓦性能得以提升。

结语:AI PC加速PC产业新周期到来

随着大模型落地部署加速,诸多端侧、边缘侧设备中涌现了承载大模型应用的能力,尤其是作为人们日常的生活、娱乐、工作工具的PC,与大模型有着天然适配性。

作为PC芯片玩家,AMD基于自己丰富的技术布局,对无论基础模型还是在端侧部署的小模型都进行了优化,在此之上,会推动更多具有创新应用的AI PC产品面世。