編輯:編輯部

【新智元導讀】為訓練AI模型,紐約州立大學的一名教授Brenden Lake,竟讓自己不到2歲女兒頭戴相機收集數據!要知道,Meta訓Llama 3直接用了15萬億個token,如果Lake真能讓AI模型學習人類幼崽,從有限的輸入中學習,那LLM的全球數據荒豈不是解決了?

絕了,為了訓練AI模型,一位紐約州立大學的教授,竟然把類似GoPro的相機綁在了自己女兒頭上!

雖然聽起來不可思議,但這位教授的行為,其實是有據可循的。

要訓練出LLM背後的復雜神經網絡,需要海量數據。

目前我們訓練LLM的過程,一定是最簡潔、最高效的方式嗎?

肯定不是!科學家們發現,蹣跚學步的人類兒童,大腦就像海綿吸水一樣,能迅速形成一個連貫的世界觀。

雖然LLM時有驚人的表現,但隨著時間的推移,人類兒童會比模型更聰明、更有創造力!

兒童掌握語言的秘密

如何用更好的方法訓練LLM?

科學家們苦思不得其解之時,人類幼崽讓他們眼前一亮——

他們學習語言的方式,堪稱是語言習得的大師。

咱們都知道這樣的故事:把一個幼年的孩子扔進一個語言文化完全不同的國家,不出幾個月,ta對於當地語言的掌握可能就接近了母語水平。

而大語言模型,就顯得相形見絀了。

首先,它們太費數據了!

如今訓模型的各大公司,快把全世界的數據給薅空了。因為LLM的學習,需要的是從網絡和各個地方挖掘的天文數碼級的文本。

要讓它們掌握一門語言,需要餵給它們數萬億個單詞。

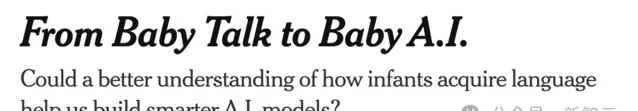

Brenden Lake和參與這項研究的NYU學者

其次,興師動眾地砸了這麽多數據進去,LLM也未必學得準確。

許多LLM的輸出,是以一定準確度預測下一個單詞。而這種準確度,越來越令人不安。

形成鮮明對比的是,要學會流利使用一門語言,兒童可不需要這麽多經驗。

紐約州立大學研究人類和AI的心理學家Brenden Lake,就盯上了這一點。

他決定,拿自己1歲9個月的女兒Luna做實驗。

過去的11個月裏,Lake每周都會讓女兒戴一個小時的相機,以她的角度記錄玩耍時的影片。

透過Luna相機拍攝的影片,Lake希望透過使用孩子接觸到的相同數據,來訓練模型。

把GoPro綁在蹣跚學步的女兒身上

雖然目前語言學家和兒童專家對於兒童究竟如何習得語言,並未達成一致,但Lake十分確信:使LLM更有效率的秘訣,就藏在兒童的學習模式裏!

因此,Lake開展了這樣一項研究專案:研究兒童在學習第一句話時所經歷的刺激,以此提高訓練LLM的效率。

為此,Lake的團隊需要收集來自美國各地的25名兒童的影片和音訊數據。

這就有了文章開頭的一幕——他們把類似GoPro的相機綁在了這些孩子的頭上,包括Lake的女兒Luna。

Lake解釋道,他們的模型試圖從孩子的角度,將影片片段和孩子的照顧者所說的話聯系起來,方式類似於OpenAI的Clip模型將標註和影像聯系起來。

Clip可以將影像作為輸入,並根據影像-標註對的訓練數據,輸出一個描述性標註作為建議。

論文地址:https://openai.com/index/clip/

另外,Lake團隊的模型還可以根據GoPro鏡頭的訓練數據和照顧者的音訊,將場景的影像作為輸入,然後輸出語言來描述這個場景。

而且,模型還可以將描述轉換為以前在訓練中看到的幀。

乍一聽,是不是還挺簡單的?就是讓模型像人類兒童一樣,學會將口語和在影片幀中所觀察到的物體相匹配。

但具體執行起來,還會面臨很多復雜的狀況。

比如,孩子們並不一定總是看著被描述的物體或動作。

甚至還有更抽象的情況,比如我們給孩子牛奶,但牛奶是裝在不透明的杯子裏,這就會導致關聯非常松散。

因而,Lake解釋說:這個實驗並不是想證明,我們是否可以訓練模型將影像中的物件與相應的單詞相匹配(OpenAI已經證明了這一點)。

相反,團隊想要做的是,希望知道模型是否可以只用兒童可用的稀疏數據級(稀疏到難以置信的程度),就能真的學習辨識物體。

可以看到,這和OpenAI、谷歌、Meta等大公司構建模型的思路完全相反。

要知道,Meta訓練Llama 3,用了15萬億個token。

如果Lake團隊的實驗成功,或許全世界共同面臨的LLM數據荒,就有解了——因為那時,訓練LLM根本就不需要那麽多的數據!

也就是說,新的思路是,讓AI模型從有限的輸入中學習,然後從我們看到的數據中推廣出來。

我認為我們的關註點,不該局限在從越來越多的數據中訓練越來越大的LLM。是的,你可以透過這種方式讓LLM具有驚人的效能,但它已經離我們所知道的人類智能奇妙之處越來越遠……

早期實驗已經取得成功

早期的實驗結果,已經證明了Lake團隊的思路可能是對的。

今年2月,他們曾經用了61小時的影片片段訓出一個神經網絡,紀錄一個幼兒的經歷。

研究發現,模型能夠將被試說出的各種單詞和短語,與影片幀中捕獲的體驗聯系起來——只要呈現要給單詞或短語,模型就能回憶起相關影像。這篇論文已經發表於Science。

論文地址:https://www.science.org/doi/10.1126/science.adi1374

Lake表示,最令人驚喜的是,模型竟然能夠概括出未訓練的影像中的物件名稱!

當然,準確性未必很好。但模型本來也只是為了驗證一個概念而已。

專案尚未完成,因為模型還沒有學到一個兒童會知道的一切。

畢竟,它只有60小時左右的帶標註的演講,這僅僅是一個兒童在兩年內所習得經驗的百分之一。而團隊還需要更多的數據,才能搞清什麽是可學習的。

而且Lake也承認,第一個模型使用的方法還是有局限性——

僅分析與照顧者話語相關的影片片段,僅僅是鏡頭以每秒5幀的速度轉化為影像,只憑這些,AI並沒有真正學會什麽是動詞,什麽是抽象詞,它獲得的僅僅是關於世界樣子的靜態切片。

因為它對之前發生了什麽、之後發生了什麽、談話背景都一無所知,所以很難學習什麽是「走」「跑」「跳」。

但以後,隨著建模影片背後的技術越來越成熟,Lake相信團隊會構建更有效的模型。

如果我們能夠建立一個真正開始習得語言的模型,它就會為理解人類的學習和發展開辟重要的應用程式,或許能幫我們理解發育障礙,或兒童學習語言的情況。

最終,這樣的模型還可以用來測試數百萬種不同的語言治療法。

話說回來,孩子究竟是如何透過自己的眼睛和耳朵,紮實地掌握一門語言的呢?

讓我們仔細看看Lake團隊發在Science上的這篇文章。

將單詞和實物、視覺影像聯系起來

人類兒童如何褪去對這個世界的懵懂無知,習得知識?這個「黑箱」的奧秘,不僅吸引著教育學家們的不斷求索,也是困於我們每個人心底關於個體智慧來處的追問。

南韓科幻作家金草葉在【共生假說】中寫下這樣的設想:人類兒童在幼年時期所展示出的智慧其實承載著一個失落的外星文明,他們選擇用這樣的方式和人類共生,可是時間只有短短的五年,在人類長大擁有真正牢固的記憶之後,便把幼年時期這段瑰麗的記憶抹去了

也時常有網友會在網上分享出,那些「忘記喝孟婆湯」的人類幼崽故事。

關於謎一樣的幼年時期,那是我們很難說清也難以回返的神秘之地,是一種「鄉愁」。就像金草葉寫下的」不要離開。不要帶走那個美麗的世界。在我長大之後,也請留在我身邊。

幼兒究竟是如何將新單詞和特定的物體,或視覺概念聯系起來的?

比如,聽到「球」這個詞時,兒童是如何想到有彈性的圓形物體的?

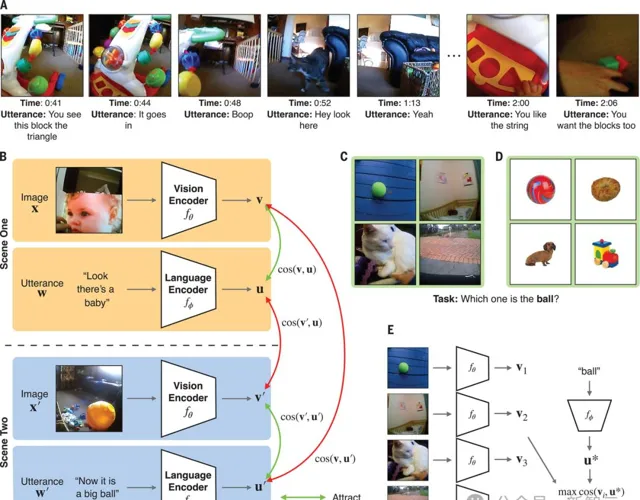

為此,Lake的團隊給一個兒童戴上了頭戴式攝影機,追蹤了ta從6到25個月期間的成長過程,記錄了一個61小時的視覺語言數據流。

在這個兒童1.5年的剪輯數據集(包括60萬個影片幀和37500條轉錄話語配對)上,研究者訓練出了一個模型,即兒童視角對比學習模型CVCL。

這個模型例項化了跨情景的聯想學習形式,確定了單詞和可能的視覺指示物之間的對映。

這個模型協調了兩個神經網絡、視覺編碼器和語言編碼器的對比目標,以自監督的方式進行訓練(即僅使用兒童視角的錄音,不使用外部標簽),對比目標將影片幀的嵌入(向量)和時間上同時出現的語言話語結合在一起(處理同時出現的影片幀和語言話語的嵌入)

當然,這個名為SAYCam-S的數據集是有限的,因為它只捕獲了孩子大約1%的清醒時間,錯過了很多他們的經歷。

但是盡管如此,CVCL依然可以從一個兒童的有限經歷中,學習到強大的多模態表征!

團隊成功地證明了,模型獲取了兒童日常經歷中存在許多的指涉對映,因而能夠零樣本地概括新的視覺指涉,並且調整其中的視覺和語言概念系統。

評估習得的詞義對映

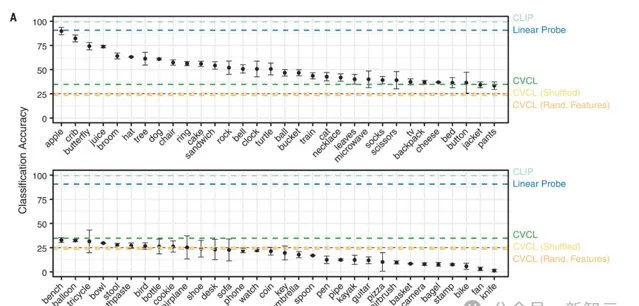

具體來說,在訓練完成後,團隊評估了CVCL和各種替代模型所學習的單詞指涉對映的質素。

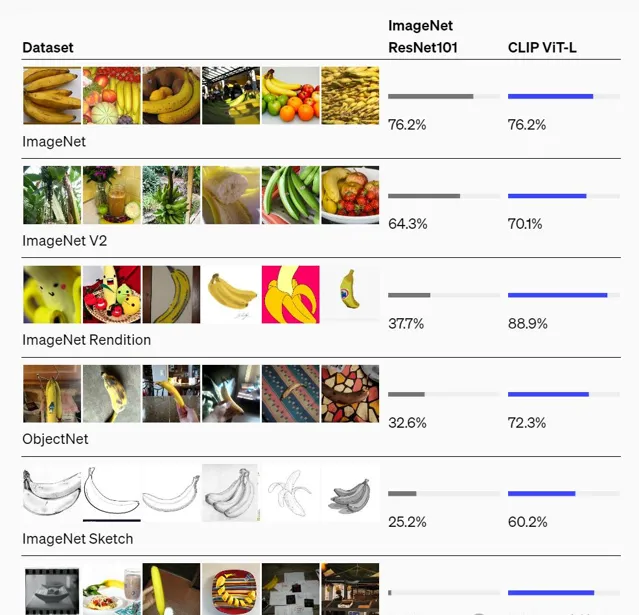

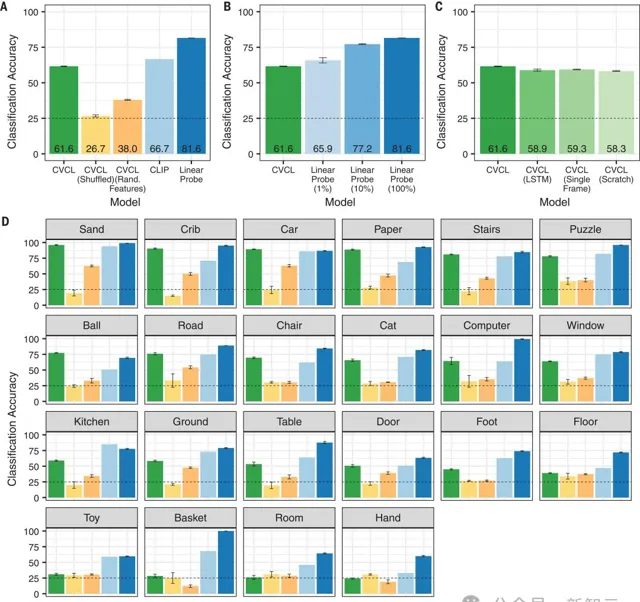

結果顯示,CVCL的分類準確率為61.6%。

而且圖2D顯示,對於其中22個概念中的11個概念,CVCL的效能和CLIP的誤差在5%以內,但CLIP的訓練數據,卻要多出幾個數量級(4億個來自網絡的影像-文本對)。

研究結果顯示,許多最早的單詞所指對映,可以從至少10到100個自然出現的單詞-所指對中獲得。

泛化新的視覺範例

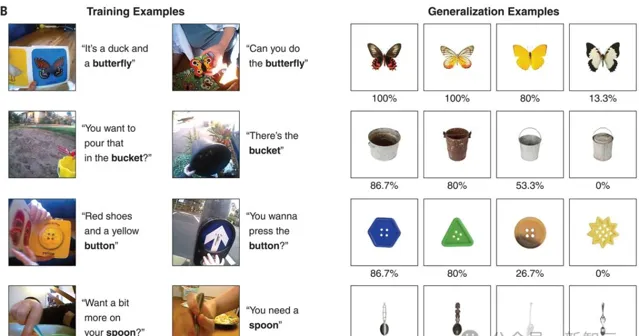

另外,研究者還評估了CVCL學到的單詞,是否可以推廣到分布外的視覺刺激上。

圖3A顯示,CVCL也同時表現出了對這些視覺概念的一些了解,總體準確率在34.7%。

顯然,這個任務需要更大的概念集,以及額外難度的分布外泛化。

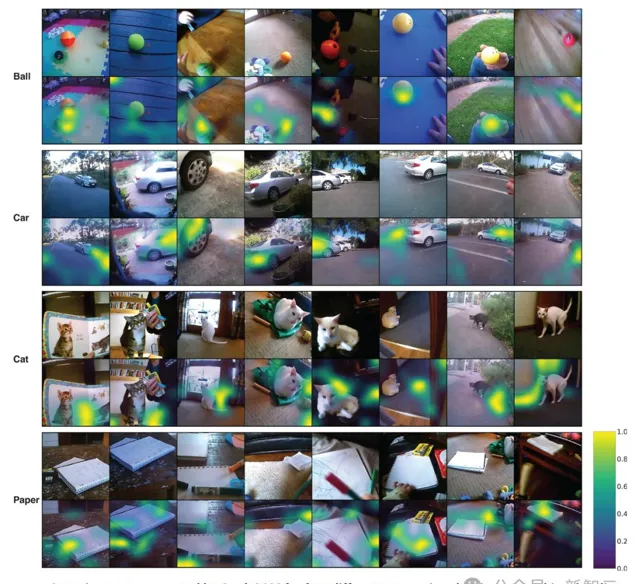

左邊是兩個隨機選擇的訓練案例,右邊是四個測試案例,下面的百分比代表模型辨識此張影像的準確度和效能,選取案例從左到右分別是兩個最高值、中值和最低值。可以看出,當測試案例和訓練案例在色彩、形狀方面相似度更高時,模型辨識的準確度也更高

多模態一致性很好

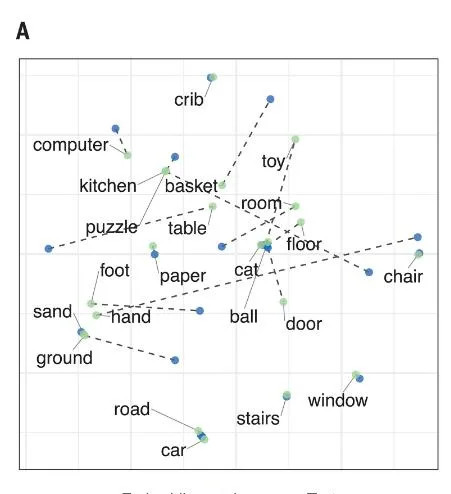

最後,研究者測試了CVCL的視覺和語言概念系統的一致性。

例如,如果相比於「球」, 「汽車」的視覺嵌入和詞嵌入都與「路」更相似,這就表明多模態對齊的效果很好。

下圖顯示出,CVCL視覺和語言系統的高度對齊。

影像和文本之間的關系,虛線表示每個概念對應的視覺質心與單詞嵌入之間的距離

不同的視覺概念在其例子的緊密聚集程度上有所不同。因為嬰兒的視線會在距離很近的物體之間遊移,就導致模型在區分「手」和「玩具」時沒有形成清晰的參照對映,「汽車」和「嬰兒床」就有比較好的表現

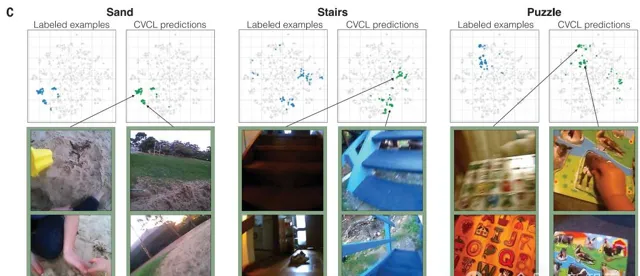

在每幅圖中,研究者直觀展示了CVCL預測與使用t-SNE的標簽範例的比較。

左邊的藍色點對應屬於一個特定類別的100個幀,右邊的綠色點對應於100個最高的啟用幀(基於與CVCL中每個概念嵌入的單詞的余弦相似性)。在每個圖下面,是每個概念中屬於一個或多個子簇的多個範例幀,捕捉了單詞嵌入如何與聯合嵌入空間中的影像嵌入互動。例如,對於「樓梯」這個詞,我們看到一個簇代表室內木制樓梯的影像,而另一個主要簇代表室外藍色樓梯組的影像。這些圖中所有的t-SNE圖都來自於同一組聯合影像和文本嵌入

下圖顯示,模型可以在不同檢視中,定位目標所指。

在歸一化註意力圖中,黃色表示註意力最高的區域。在前兩個類別(球和車)中,我們可以看到模型可以在不同檢視中定位目標所指。但是,在下面兩個類別(貓和紙)中,註意力圖有時會與所指物錯位,這表明定位所指物的能力並不是在所有類別中都一致的

當然,兒童的學習和機器學習模型還是有許多不同的。

但Lake團隊的研究,無疑對我們有很大的啟發。