晶圓級AI芯片WSE-3效能揭秘:80億參數模型每秒生成1800個Token

WSE-3晶圓級人工智能芯片效能釋出:80兆參數模式,每秒產生1800個替代品

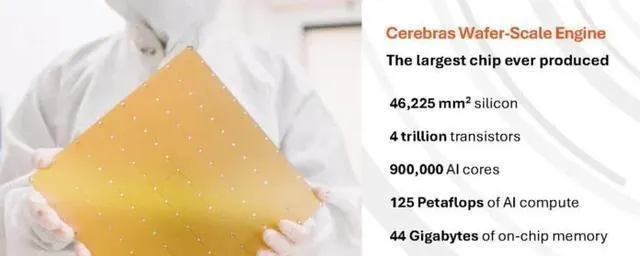

今年三月,人工智能芯片初創企業 Cerebras系統釋出了第三代人工智能芯片WSE-3,該芯片的效能比上一代WSE-2提高了一倍,可以用來訓練大型人工智能模型。最近, Cerebras系統在2024的熱芯片大會上展示了這種芯片的人工智能推理能力。

據官方透露,WSE-3仍采用台積電5 nm制程制造,芯片面積46225平方毫米、40億晶體管、90萬個人工智能核、44 G記憶體、21 PB/s整體記憶體頻寬214 PB/s。這樣,WSE-3將獲得125FP16 PetaFLOPS的最高效能。WSE-3具有125FP16 PetaFLOPS的最高效能,相比於之前的WSE-2,其效能提升了一倍。

與之相比,WSE-2芯片只有46,225平方毫米,采用台積電7 nm制程工藝制造而成,其晶體管數達2600萬個, AI核850萬個, SRAM 40 GB,記憶體頻寬20 PB/s,架構頻寬達到220 PB/s。

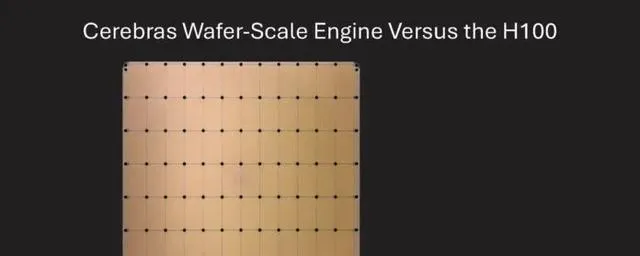

相比於輝達的p00,WSE-3具有57倍的面積、52倍的內核、880倍的片內記憶體、7000倍的記憶體頻寬和3715倍的結構頻寬(HBM3e只有4.8 TBps)。

在"熱芯片2024"大會上,塞雷布拉斯展示了WSE-3的更大效能,用於操作大的人工智能模型。

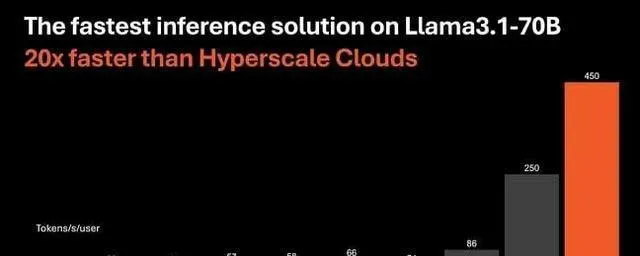

Cerebras宣稱,與采用輝達p00的微軟 Azure相比, Llama3.1-8B的計算速度要快20倍。研究表明,在現代生成型人工智能任務中,記憶體頻寬對推理效能的影響遠大於計算能力。換言之,較大的記憶體頻寬可以加快模型推理的速度。

安德魯-費爾德曼(Andrew Feldman)表示,使用44 GB片內 SRAM的WSE-3可以在16位元精度下每秒產生1800多個標記,而采用輝達p00的WSE-3每秒產生242個標記。記號

同時,塞雷布拉公司也展出了以WSE-3為基礎的CS-3超級電腦,它可以訓練出24億億次的人工智能模型。該超級電腦支持1.5 Tb、12 Tb和1.2 petch記憶體,可以在一個邏輯空間記憶體儲大量模型,簡化訓練過程,提高編程效率。

Cerebras最新開發的軟件框架,對 PyTorcp.0及最新人工智能模型與技術(如:多模態模型、視覺轉換器、專家合成、傳播等)提供原生支持。Cerebras是目前國際上僅有的一種針對非結構化稀疏表示的硬件加速平台,其訓練速度比輝達DGX-100系統快8倍。訓練速度比輝達的DGX-100電腦要快8倍。

它同樣可以達到450個令牌/秒,執行分布在4個CS-3加速器上的700萬參數版本的 Llama3.1模型。與之相比,p00最好的效能是128個令牌/秒。

費爾德曼相信,隨著寬頻的增長,這一效能水平會給人工智能套用帶來新的機會。」現在,我想我們進入了一個通用的人工智能手機時代。」他提到了第一批產生型人工智能應用程式,這些應用程式在響應請求方面可能會有很大的延遲。

他認為,如果能夠快速地處理請求,那麽代理套用就可以建立在多種模型之上,而不用擔心延遲問題。在 Feldman看來,這一效能上的優點還有另外一種用途,那就是 LLM可以透過多個步驟來叠代它的響應。如果標記的處理速度夠快,您可以在後台處理更多的事情。

盡管WSE-3在16位元精度下執行 lama3.18 B,每秒可以產生1800多個 Token,但是由於系統的運算能力有限,WSE-3的速度還能再快一些。

這款產品是 Cerebras的一項變革,此前,該公司將重點放在人工智能培訓上。費爾德曼表示,他們使用的是同樣的WSE-3芯片以及CS-3系統來進行推理與培訓。

費爾德曼解釋道:「我們要做的就是擴大編譯器的能力,這樣它就可以同時把不同的層次放到芯片上。」

SRAM是快速的,但是增加了 HBM的能力

SRAM雖然在效能方面優於 HBM,但是卻存在容量上的不足。44 GB的容量對大語言模式(LLM)來說不算大,這是因為關鍵值緩存在WSE-3目標大批時占用了大量空間。

Meta公司的Llama83B (16 GBFP16)是WSE-3最理想的解決方案,整個模型可裝入片內 SRAM,預留28 GB的鍵值緩沖空間。

費爾德曼表示,WSE-3型導彈除了具有超高的產量外,還可以擴大生產規模。然而,這家初創企業不願透露其擴充套件到何種程度,以及如何維持每位使用者產生代幣的速率。「我們當前的批次規模經常變動。我們預期在第四季會有雙位數碼的訂單。

費爾德曼補充道:「目前,我們的批次生產尚未成熟,因此我們並不想提供這種產品。」這個系統的結構設計是可以量產的,我們希望能在接下來的幾個星期裏達到這個目標。

就像現在的圖形處理器一樣,塞雷布拉斯處理了這個挑戰,它在多個CS-3系統中的模型並列化。特別地, Cerebras采用了流水線並列技術,把模型的層次分散到不同的系統中。

Llama370B要求140 GB的記憶體,80層型號被分配到4個CS-3系統,它們由乙太網路相互連線。由於數據必須經過這些連線,這會導致效能下降。

由於WSE-3只有44 GB的 SRAM,所以為了支持更大的型號,需要連線多個加速器。

然而,據費爾德曼所說,節點與節點之間的延遲並沒有你想像中的那樣長。"這裏確實有延遲,但是它非常小,並且是由芯片上其他各層的 Token共享的,」他解釋道,「最後,從晶片到晶片的延遲大約是整個延遲的5%。

對於大型模型,比如最近公布的擁有4050億參數的拉瑪3型,塞雷布拉預計,如果采用12組CS-3系統,其速度將達到每秒350個令牌。

用更快的片內 SRAM代替 HBM並非新鮮事物, Cerebra的競爭對手 Groq也在這麽做。

Groq語言處理單元(LPU)采用了片內 SRAM (片內 SRAM)技術.不同的是, GroqLPU內部的 SRAM容量很小,所以需要用光纖來連線更多的加速器來支持更大的模型。

Cerebras需要4組CS-3系統來執行 lama370B,其速度可達到450 degree/s/s, Groq之前表示,要達到300 degree/s的速度,需要576 LPU。

費爾德曼也註意到,塞雷布拉公司沒有采用定量方法就能做到這點。Groq采用8位元的量化方式來達到它的效能目標,這樣就可以以犧牲精度為代價,降低模型的規模,降低計算開銷,降低記憶體壓力。

但是,僅僅對效能進行比較而忽略了整體成本,這是不公平的。畢竟,單片WSE-3晶片的成本也比格洛克 LPU高得多。