昨天,OpenAI 風輕雲淡地丟出一個新模型,結果,炸翻了整個 AI 圈!

Sora 的出現,讓文生影片領域從以秒 為單位的 突破,變成了以分鐘 為單位。

這是一個跨越式,足以將之前行業所有公司掀下牌桌的改變。

將 Sora 的出現,稱之為文生影片領域的「iPhone時刻」,似乎也毫不為過。

AI 博主 @歸藏 將同一個 Prompt 丟給 Sora、Runway、Pika 和 SVD 四大文生影片模型,結果,Sora 以碾壓的方式獲得勝利。

下面是完整影片對比,效果更震撼↓

這樣的對比還有很多:

同一個 Prompt,截然不同的視覺呈現。

淪陷你,與你無關。

繼 ChatGPT 之後,OpenAI 再一次將【三體】中這句經典的台詞活生生地甩給整個 AI 世界。

就連一向和 OpenAI 不對付的馬斯克也甘心承認 Sora 的強大,並盛贊 「在未來的幾年裏,人類借助 AI 的力量,將創造出卓越的作品。」

官宣 Sora 模型幾個小時後,OpenAI 的技術報告也隨之公開:在報告中,Sora 模型被稱為「裏程碑式」的突破。

Sora 是怎樣煉成的?

眾所周知:OpenAI 曾在 LLM(大語言模型)上取得巨大的成功,那這種模式能不能套用到文生影片領域呢?

答案是可以。

受 LLM 成功實踐經驗的啟發,OpenAI 引入視覺塊嵌入程式碼(patches),這是一種高度可延伸且有效的視覺數據表現形式,能夠極大地提升生成模型處理多樣化影片和影像數據的能力。

與「Patch」對應的是我們熟悉的 「Token」 。

在大語言模型中,Token 之所以會如此成功,得益於 Transformer 架構,它與 Token 互為補充、相得益彰。

同樣,Sora 作為一個影片生成擴散模型,區別於主流影片生成擴散模型采用了 Transformer 架構。

( 主流影片生成擴散模型較多采用 U-Net 架構 )

在技術路線上,OpenAI 直接顛覆之前所謂的」主流路線「。

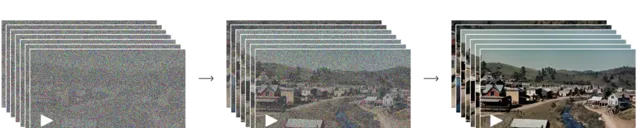

從 Prompt 輸入到影片輸出,主要有4個核心步驟:

√

第一步

:壓縮,OpenAI 將影片資料壓縮到一個低緯潛在空間;

√ 第二步

:

分解,

再將其分解為時空嵌入,從而將影片轉化為一系列編碼塊;

√ 第三步

:

生成

,Sora 在壓縮後的潛在空間中進行訓練,並生成影片;

√ 第四步

:

解碼

,借助」解碼模型器「,將這些潛在表征還原為像素級的影片影像。

借助 patchs 的獨特效能,Sora 能夠適應不同分辨率、持續時間及寬高比的影片和影像。

在生成新影片內容時,可以透過將這些隨機初始化的 patchs 按照需要的大小排列成網格,來控制最終影片的大小和形式。

大家可以把它理解成」拼圖遊戲「,並且 隨著訓練計算量的提升,Sora 可以用來選擇的素材就越多,生成影片質素就越高!

傳統文生影片模型,往往會將影片、影像統一調整到一個標準尺寸,比如4秒鐘、分辨率256x256的影片。

然而,OpenAI研究者發現,直接在數據的原始尺寸上進行訓練有更多優勢:

√

生成的影片能更好的自訂時長;

√ 生成的影片能夠更好的自訂影片尺寸;

√ 影片會有更好的取景和構圖;

除了引入 Transformer 架構,OpenAI 還將在 DALL·E 3 中的重新標註技術套用到影片上。

借助 GPT,OpenAI 將使用者的簡短提示轉換成更長的詳細說明 ,然後發送給影片模型,從而使得 Sora 能夠生成高質素的影片。

除了可以從文字轉化而來,Sora 還能接受圖片或已有影片的輸入。

這項功能讓 Sora 能夠完成各種圖片和影片編輯任務,比如制作 無縫迴圈影片、給靜態圖片添加動畫效果、延長影片的播放時間等 。

基於 DALL·E 3 影像生成影片。

將影片沿時間線,向前或向後擴充套件。

從整體來看,你會發現 Sora 模型的成功並非偶然,它並不是 OpenAI 無中生有、憑空捏造的超級模型。

而是借助過去的成功經驗,最終訓練而成。