OpenAI近期确实经历了一些重要的变动,先是AGI安全团队流失,现在则是「AGI Readiness」团队。

AGI Readiness团队的解散并不意味着OpenAI放弃了对AGI的研究和开发,而是在组织结构和研究方向上进行调整,一切为L2级AI开路。换言之,这不是什么高层动荡,而是有计划的整军,整军之后即将一路狂奔,遥遥领先。

他们是如何产生了整军的需求呢?这个调整意味着什么,又对行业带来什么影响?

一、我们先看看这个AGI Readiness团队是干啥的。

简单说,这个团队类似国内某些大厂的政策研究团队,而非技术研发团队。

AGI Readiness团队负责评估全球对于AGI技术的准备情况,并提供相应的政策建议。他们的工作是确保AI技术的发展能够安全、可靠且有益地服务于社会。

该团队还涉及到对AI技术进行安全监督,以预防潜在的技术滥用和误用,保护社会免受可能的负面影响。

AGI Readiness团队进行的研究和分析对于制定有效的AI政策至关重要,这些政策有助于引导AI技术的发展方向,确保技术的健康发展。

AGI Readiness团队的工作与AI对齐的目标紧密相关,即确保AI系统的行为与人类的价值观和目标保持一致,避免技术发展带来的潜在风险 。

二、这个团队的负责人Miles Brundage是一个什么人物?

他是一位专注于人工智能政策和研究的学者。

他在2018年加入OpenAI,担任了多个重要职务,包括研究科学家、政策研究负责人以及高级AGI顾问。

在OpenAI工作期间,Brundage领导了外部红队计划,通过模拟攻击来测试OpenAI的AI系统的安全性和鲁棒性,并推动了OpenAI的「系统卡」报告的创建,这些报告详细记录了AI模型的能力和局限性,为公众和研究者提供了重要的透明度。

Brundage在政策研究方面也发挥了重要作用,他积极参与了有关AI进展评估、AI安全监管、AI经济影响以及有益AI应用加速推进等方面的研究。他提出的「AI大战略」概念,旨在制定确保人工智能广泛造福人类的框架。

在加入OpenAI之前,Brundage曾在牛津大学的未来人类研究所工作,专注于AI政策和治理问题。他的学术背景包括公共政策和科学技术研究,这为他提供了在AI政策领域工作的坚实基础。

Brundage在亚利桑那州立大学完成了他的博士学位,专注于负责任的人工智能治理、评估、理论框架和探索。他的研究兴趣涵盖了评估和预测AI进展、前沿AI安全的监管问题、AI的经济影响、有益AI应用的加速推进和计算治理。

在学术贡献方面,Brundage发表了一系列关于人工智能社会影响的论文,包括但不限于AI的合作发展、AI模型的能力和局限性、以及AI的恶意使用等主题。他的工作不仅在学术界产生了影响,也为政策制定者和行业实践者提供了宝贵的见解和指导。

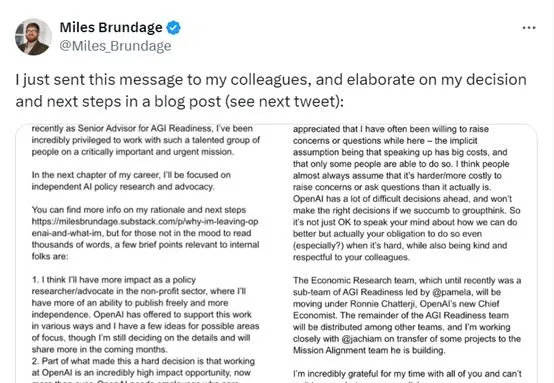

三、Miles Brundage离开OpenAI的原因是什么?

综合公开的报道,可以看到Brundage表达了如下几个原因,对AGI学术态度偏保守,下面括号里是简单解读:

1.追求独立的AI政策研究:Brundage 希望跳出行业,从外部影响和推动人工智能的发展。他认为在外部进行研究会更具影响力,并希望减少偏见。

(解读;公司内部存在阻力)

2.研究发布限制的增加:Brundage 提到,离职的主要原因之一是研究发布的限制日益增加。他希望在人工智能政策讨论中成为独立的声音。

(解读:内部限制多)

3.对OpenAI及全球AGI准备状态的评估:Brundage 认为,OpenAI及世界在AGI(通用人工智能)筹备方面「尚未准备好」。

因此,他计划创建自己的非营利组织或加入现有的组织,专注于AI政策研究和倡导。

(解读:「尚未准备好」观点持有人离职,说明内部不同意「尚未准备好」这一判断,内部存在较大分歧)

4.对AI安全和监管的关注:Brundage 对于前沿 AI 安全与保障的监管问题有深刻的认识,他认为改善前沿AI安全与保障是当务之急。

(解读:OpenAI可能认为对AI安全与保障没有那么急切)

5.对AI经济影响的考量:Brundage认为,人工智能很可能会带来足够的经济增长,从而使人们可以轻松地提前退休,过上高标准的生活。他希望政策制定者能够迅速采取行动,以确保AI带来的财富能够公平分配。(解读:这岂不是影响VC发财?)

6.对AI有益应用的推进:Brundage 还对AI的有益应用表示了兴趣,他认为即使对(几乎)只专注于降低AI风险的人来说,认真考虑 AI的有益应用也是有意义的。

7.计算治理:Brundage 对于计算硬件在人工智能政策中的重要性有独到的见解,他认为计算治理是人工智能政策的一个重要焦点。

四、OpenAI解散其「AGI Readiness」团队意味着什么?

OpenAI在获得66亿美元巨额融资后,其估值飙升至1570亿美元。这可能使得公司更加注重短期的财务回报,而不是长期的技术准备和安全问题。

OpenAI可能正在重新评估其在AGI领域的战略,并将资源重新分配到其他优先事项上,比如商业化。

随着OpenAI在商业化道路上的快速发展,公司可能认为在人工智能安全建设方面的步伐相对迟缓。这表明公司可能更专注于产品的迭代和商业化,而不是长期的AI安全问题。

从Brundage自己的离职声明前三点来看,OpenAI公司内部有阻力,给他的研究带来不少限制,

他认为世界还未做好准备迎接AGI的到来,这表明公司内部对于AGI的未来发展和潜在风险存在分歧。

综合OpenAI和Brundage情况来看,Brundage的存在已经成了公司发展的绊脚石,必须去之而后快。

这一变动也反映了OpenAI已经迅速做出了取舍---

在整个行业对于AGI准备状态还处于左右摇摆的时候,OpenAI已经看到了方向,放下了原本的顾虑,一路狂奔。

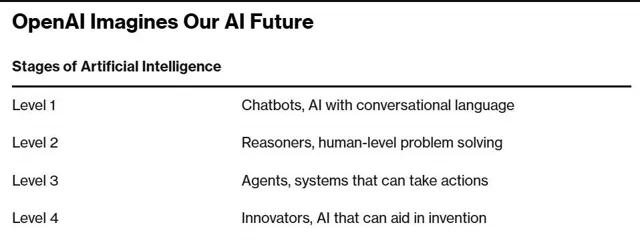

OpenA看到了什么方向?参考OpenAI的AGI的5级路线图:

L1:聊天机器人 - 具有对话能力的AI。

L2:推理者 - 像人类一样能够解决问题的AI,预计能解决博士水平的基本问题。

L3:智能体 - 不仅能思考,还可以采取行动的AI系统。

L4:创新者 - 能够协助发明创造的AI。

L5:组织者 - 可以完成组织工作的AI,标志着实现AGI。

目前,OpenAI自称其AI模型正处于L1级别,即将达到L2级别。OpenAI的CTO曾透露,公司将致力于研究特定任务上博士级别的智能,并可能在一年半之内实现。这表明OpenAI的技术实力正在迅速发展,预计在未来18个月内推出达到L2级别的下一代模型。

阻挡openAI在这条道路发展的安全团队已经消灭,阻碍发展的Readiness团队也已经解散....

明后年AI博士即将出现,行业压力陡增。国内还在寻找商业化道路的大小厂,不久就将感受到openAI带来的寒意,瑟瑟发抖。