2024世界頂尖科學家論壇於10月25日—27日在上海臨港舉行。本屆論壇以「卓越科學 創新致成」為主題,舉辦青年科學大會等十多場專題會議,圍繞材料、能源、生命科學、智慧科學、物質科學等話題進行案例分享,推動科學家、創業者、企業家、投資人等開展思想的交流碰撞。

會上,科學家深度聚焦人工智慧,就人工智慧帶來社會深刻變革,開啟科學研究新紀元,以及人工智慧帶來的倫理挑戰和監管需求等進行了深刻討論。

數位驅動

人工智慧帶來深刻變革

世界頂尖科學家談如何讓人工智慧更好地為人所用、向善發展? 一起去看看↓

人工智慧被廣泛套用的時代已經到來

本次論壇邀請來自全球近20個國家和地區的近300位科學家,其中包括11位諾貝爾獎得主在內的50余位海外頂尖科學家、40余位中國兩院院士及資深科學家。科學家們表示,人工智慧被廣泛套用的時代已經到來。

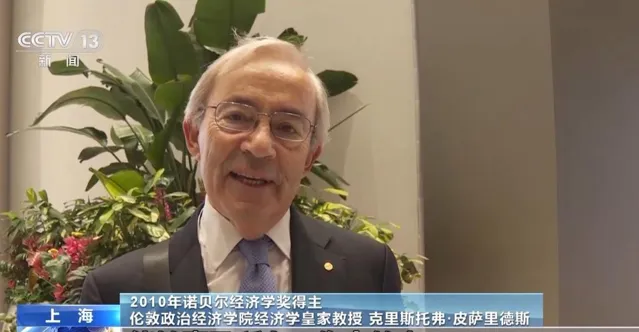

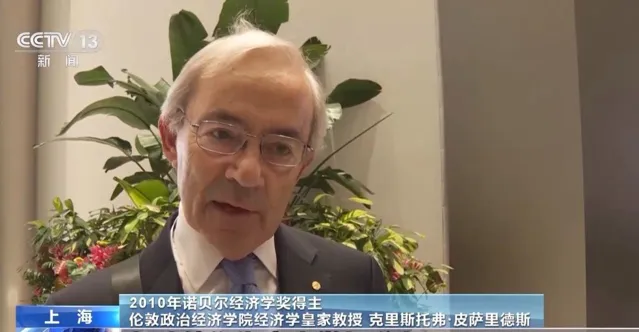

2010年諾貝爾經濟學獎得主、倫敦政治經濟學院經濟學皇家教授 凱瑞斯托弗·皮薩瑞德斯: 人工智慧已經在許多公司得到了套用,並且未來會套用得更多。我的主要研究目標是確保人工智慧的套用,能夠惠及所有工作中的人,這也是我演講的主題,討論如何實作這一目標。

培訓人工智慧相關技能 避免員工對其擔憂

凱瑞斯托弗·皮薩瑞德斯表示,很多企業在運用人工智慧時並不透明,人工智慧和自動化裝置讓員工覺得降低了工作品質。

2010年諾貝爾經濟學獎得主、倫敦政治經濟學院經濟學皇家教授 凱瑞斯托弗·皮薩瑞德斯: 公司需要花時間為員工進行培訓,幫助他們為未來做好準備。員工需要具備一些基本的科學、技術、工程和數學技能,公司內部的正式會議也應該有更好溝通,讓每個人都清楚自己的職責以及他們在公司中的定位,這樣可以避免目前員工對人工智慧的恐懼和擔憂。

人工智慧開啟科學研究新紀元

人工智慧跨領域的套用研究已經變得非常普遍,今年諾貝爾物理學獎花落機器學習領域兩位學者, 「人工智慧是否屬於物理學」 的話題引發廣泛關註和討論。對此,頂尖科學家們是怎麽看的?

在本屆論壇上,多位與會科學家都提到了本月頒發的2024年的諾貝爾獎在人工智慧領域取得了重大突破,特別是在物理學和化學兩個獎項中。在物理學領域,諾貝爾物理學獎獲得者,利用統計物理學的基本概念,設計了能夠作為聯想記憶並從大數據集中尋找模式的人工神經網路。此外,化學獎獲得者開發的AlphaFold AI工具,對於預測蛋白質結構具有革命性的影響。

與會科學家表示,人工智慧的套用已經深入科學研究的各個領域,從蛋白質結構的預測到材料科學、天文學等多個領域,人工智慧都在幫助科學家們處理大量復雜的數據,發現新的模式和知識。這些成就表明,人工智慧已經成為現代科學研究不可或缺的工具,它的跨學科特性和強大的數據處理能力正在推動科學的邊界不斷擴充套件。

審視人工智慧

帶來的倫理挑戰與監管需求

隨著人工智慧的廣泛使用,專家學者認為,不僅要關註人工智慧在產業升級、最佳化生活體驗方面的無限潛力, 更應深刻審視其帶來的倫理挑戰與監管需求 。

2024頂科協獎的獲得者克雷因伯格認為,在設計演算法時,要兼顧演算法目標、使用數據、訓練方法等各方面。比如在數據層面,演算法作為敏感資訊的儲存庫,其背後有大量數據支撐,所以應該保護這些數據的完整性,兼顧數據所代表的各方利益。

中國新一代人工智慧發展戰略研究院執行院長 龔克: 人工智慧在生成內容的時候,它一定是帶價值觀的,聯合國教科文組織在兩年前推出了聯合國的第一個檔,就是關於人工智慧倫理的建議書,就是為了它的治理建立一個基礎。這個建議書提出了4個最重要的價值觀原則,在這個價值觀原則上構建了10個倫理的原則。在地緣政治沖突這麽嚴重的情況下,怎麽把這些不同的,比如今天我們在上海的論壇,在英國的論壇,在南韓的,把它們能連線起來,形成一個全球的共識,現在是一個非常嚴重的挑戰。

建立全球監管機制 讓人工智慧向善發展

如今,人工智慧其快速發展及普及正為社會帶來深刻變革,同時也帶來了不可忽視的潛在威脅。因此, 建立一套跨越國界、種族、文化的統一的全球人工智慧監管機制勢在必行。

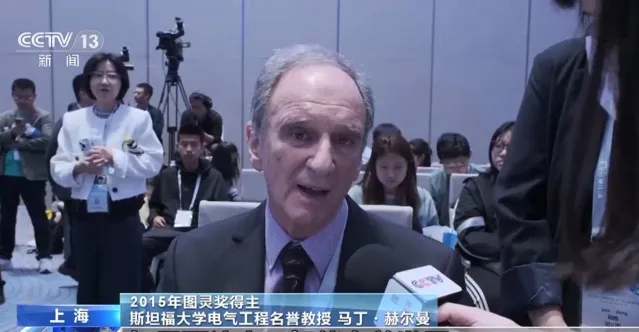

2015年圖靈獎得主、史丹佛大學電氣工程名譽教授 馬丁赫爾曼: 我很多次強調,如果要讓人工智慧向善發展,必須停止人工智慧在武器系統的套用,但是我們現在看到正在向這個趨勢發展,所以我們要想辦法透過合作來解決。

失去人類控制的智慧

現在還看不到影子

隨著各種大模型、生成式人工智慧套用層出不窮,重視通用人工智慧發展已成為行業共識。通用人工智慧時代何時到來?人工智慧未來是否會超越人類甚至不受人類的控制?對此, 中國新一代人工智慧發展戰略研究院執行院長龔克表示,失去人類控制的智慧,現在還看不到它的影子。