編輯:編輯部

【新智元導讀】最近,7B小模型又成為了AI巨頭們競相追趕的潮流。繼谷歌的Gemma2 7B後,Mistral今天又釋出了兩個7B模型,分別是針對STEM學科的Mathstral,以及使用Mamaba架構的程式碼模型Codestral Mamba。

Mistral又驚喜上新了!

就在今天,Mistral釋出了兩款小模型:Mathstral 7B和Codestral Mamba 7B。

首先是專為數學推理和科學發現設計的Mathstral 7B。

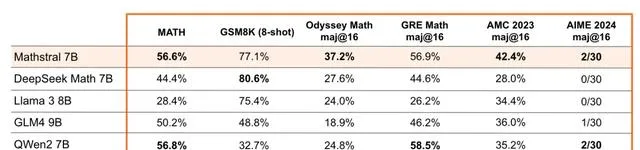

在MATH基準測試中,它獲得了56.6% pass@1的成績,比Minerva 540B提高了20%以上。Mathstral在MATH上的得分為68.4%,使用獎勵模型得分為74.6%。

而程式碼模型Codestral Mamba,是首批采用Mamba 2架構的開源模型之一。

它是可用的7B程式碼模型中最佳的,使用256k token的上下文長度進行訓練。

兩款模型均在Apache 2.0授權證下釋出,目前權重都已上傳HuggingFace倉庫。

Hugging Face地址:https://huggingface.co/mistralai

Mathstral

有趣的是,根據官宣文章,Mathstral的釋出恰好慶祝了阿基米德2311周年誕辰。

Mathstral專為STEM學科設計,以解決需要復雜、多步驟推理的高級數學問題。參數僅有7B,上下文視窗為32k。

而且,Mathstral的研發還有一個重量級的合作夥伴——上周剛剛在Kaggle第一屆AI奧數競賽中得到冠軍寶座的Numina。

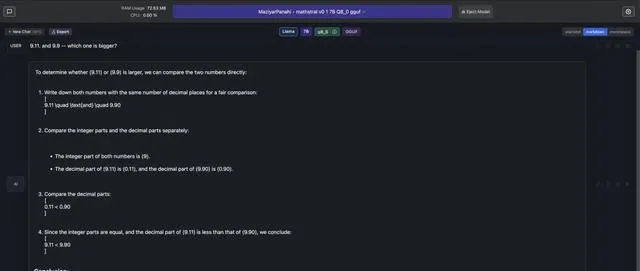

而且,有推特網友發現,Mathstral可以正確回答「9.·11和9.9哪個更大」這個難倒一眾大模型的問題。

整數、小數分開比較,思維鏈清清楚楚,可以說是數學模型優秀作業的典範了。

基於Mistral 7B的語言能力,Mathstral進一步聚焦STEM學科。根據MMLU的學科分解結果,數學、物理、生物、化學、統計學、電腦科學等領域都是Mathstral的絕對優勢計畫。

根據官方部落格文章的透露,Mathstral似乎犧牲了一些推理速度以換取模型效能,但從測評結果來看,這種權衡是值得的。

在多個數學、推理領域的基準測試中,Mathstral打敗了Llama 3 8B、Gemma2 9B等流行的小模型,特別是在AMC 2023、AIME 2024這類數學競賽題上達到了SOTA。

而且,還可以進一步增加推理時間以取得更好的模型效果。

如果對64個候選使用多數投票(majority voting),Mathstral在MATH上的分數可以達到68.37%,進一步添加額外的獎勵模型,還能取得74.59%的高分。

除了HuggingFace和la Plateforme平台,還可以呼叫官方釋出的Mistral-finetune和Mistral Inference兩個開源SDK,使用或微調模型。

Codestral Mamba

繼沿用Transformer架構的Mixtral系列釋出後,第一個采用Mamba2架構的程式碼生成模型Codestral Mamba也問世了。

而且,研發過程也得到了Mamba原作者Albert Gu和Tri Dao的協助。

有趣的是,官宣文章專門cue到了和有關的「埃及艷後」Cleopatra七世,她就是戲劇般地用一條毒蛇終結了自己的生命。

Mamba架構釋出後,其優越的實驗效能得到了廣泛的關註和看好,但由於整個AI社群在Transformer上投入了太多成本,我們至今也很少看到實際采用Mamba的工業界模型。

此時,Codestral Mamba恰好能為我們提供研究新架構的全新視角。

Mamba架構先發於2023年12月,兩位作者又在今年5月推出了更新版的Mamba-2。

與Transformer不同,Mamba模型具有線性時間推理的優勢,並且理論上能夠建模無限長度的序列。

同為7B模型,Mathstral的上下文視窗只有32k時,Codestral Mamba卻能擴充套件到256k。

這種推理時間和上下文長度方面的效率優勢,以及實作快速響應的潛力,在用於提升編碼效率的實際場景中尤為重要。

Mistral團隊正是看到了Mamba模型的這種優勢,因而率先嘗試。從基準測試來看,7B參數的Codestral Mamba不僅比其他7B模型有明顯優勢,甚至可以和更大規模的模型掰掰手腕。

在8個基準測試中,Codestral Mamba基本達到了和Code Llama 34B相匹配的效果,甚至在其中6個測試上實作了效能超越。

然而相比大姐姐Codestral 22B,Codestral Mamba的參數量劣勢就體現出來了,依舊顯得能力不足。

值得一提的是,Codestral 22B還是不到兩個月前釋出的新模型,再次感嘆一下總部在巴黎的Mistral竟如此之卷。

Codestral Mamba同樣可以使用Mistral-inference部署,或者輝達釋出的快速部署API TensorRL-LLM。

GitHub地址:https://github.com/NVIDIA/TensorRT-LLM

對於本地執行,官方部落格表示,可以留意後續llama.cpp的支持。但ollama行動迅速,已經將Mathstral加入到了模型庫中。

面對網友催更codestral mamba,ollama也非常給力地表示:「已經在弄了,稍安勿躁。」

參考資料:

https://mistral.ai/news/codestral-mamba/

https://mistral.ai/news/mathstral/

https://venturebeat.com/ai/mistral-releases-codestral-mamba-for-faster-longer-code-generation/