明敏 克雷西 發自 凹非寺量子位 | 公眾號 QbitAI

OpenAI最新絕密計畫曝光!

知情人士透露,OpenAI正在開發一個名為「草莓(Strawberry)」的新模型,它的前身是Q*。

其工作機制在內部被嚴格保密,且細節從未被外界報道過。

訊息稱,「草莓」模型不僅在超大規模數據集上完成預訓練,並且采用了一種特殊的方法。

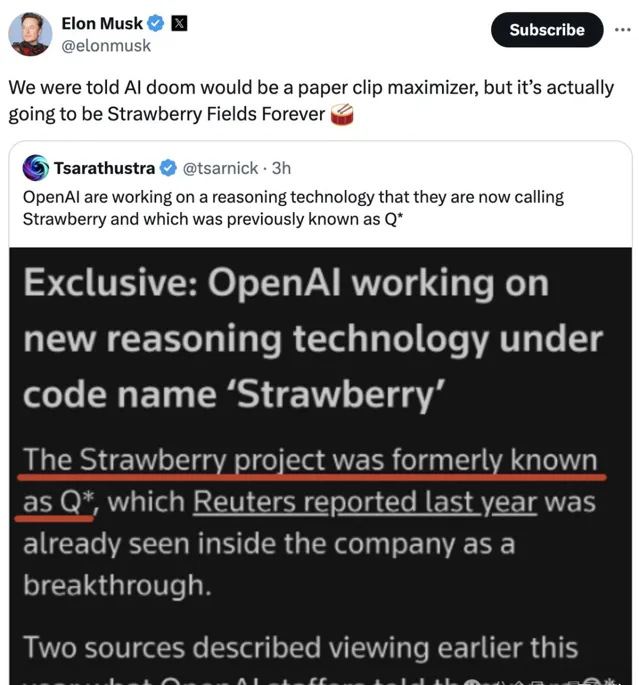

馬斯克已火速趕來吃瓜:

之前都說,AI災難會是回形針成災。如今來看,可能是草莓田了。(哲學家尼克·博斯特羅姆曾提出高度智慧的AI可能被設計為回形針,意思是看似無害但可能風險巨大)

本周二,OpenAI在一次內部全體會議上展示了一個demo。據稱該計畫的推理能力已接近人類水平。

盡管OpenAI拒絕透露會議具體內容,無法確定該計畫是否就是「草莓」。但可以肯定,推理能力被業界認為是AI達到人類智慧水平的關鍵。

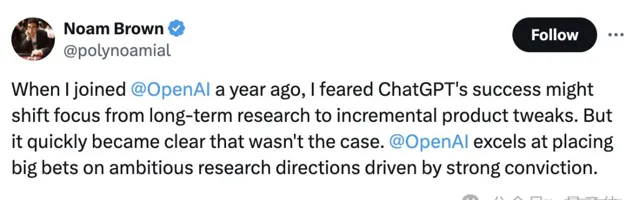

巧合的是,周二OpenAI科學家Noam Brown發了一條推特,感慨OpenAI總是會堅定地在重大研究方向上持續押註。

而這位科學家去年才跳槽到OpenAI,主要負責研究模型推理能力,之前一直被認為在研究Q*。

在最新曝光資訊中,還顯示「草莓」使用的推理方法和2022年史丹佛發表的一種方法相似。

具體來看更多細節。

具備強推理且有自主能力

據路透社訊息,5月份他們看到了OpenAI一份內部檔副本,上面詳細說明了「草莓」計畫的研究計劃。

訊息人士稱這是一項正在推進的工作。但是「草莓」的工作原理在OpenAI內部被嚴格保密。

檔中顯示,公司希望「草莓」模型不僅能生成答案,而且能執行長任務(LHF),包括提前進行規劃,自主可靠地在互聯網上導航以及一系列行動。

比如透過CUA(一種電腦代理)的幫助來自動瀏覽網頁,該代理可以根據發現內容采取行動。

十余位業內人士認為,這是當下AI模型所不能解決的問題。

為此,OpenAI正在開發訓練評估這些模型。內部形成了一個名為「深度研究」的數據集,具體內容不詳。同時OpenAI還計劃測試模型可以如何影響軟體和機器學習工程師的工作。

在被問及關於「草莓」的細節時,OpenAI一位發言人沒有直接回答問題,但是在一份聲明中表示:

我們希望我們的愛模型能像人類一樣看到和理解世界,不斷研究新模型是行業內都在做的事,大家都相信隨著時間推移,這些系統的推理能力將得到改善。

據了解,「草莓」的前身是Q*。

此前訊息稱,Q*被OpenAI視為一項重大突破。一些看過Qdemo的內部人員表示,該計畫能回答其他大模型所不能應對的棘手科學和數學問題。

知情人士表示,OpenAI希望透過該計畫大幅提升AI模型的推理能力,「草莓」已經在非常大的數據集上完成預訓練,並使用了一種專門的處理方法。

包括後訓練(post-training);或者在已經進行大規模訓練後,再調整基礎模型來「磨煉」效能。

後訓練部份包括常見的微調、人類反饋強化學習(RLHF)等。

值得一提的是,一位知情人士透露,「草莓」與史丹佛大學在2022年(當時ChatGPT還未釋出)提出的一種名為自學推理(Self-Taught Reasoner,簡稱STaR)的方法很相似。

就在今年,史丹佛團隊又基於STaR,提出了一種名為Quiet-STaR的推理方式,簡寫的話就是Q*了(手動狗頭)。

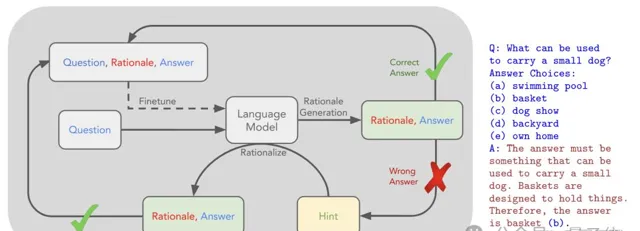

不過還是先從基礎的STaR說起,它的創新點在於不依賴大規模人工標註的數據集進行訓練,透過自舉的方式讓大模型自己學會如何推理。

具體來說,一開始會把少量帶有推理步驟的樣本作為示範,與待推理的問題一起輸入給模型。

然後模型會生成每個問題的推理步驟和答案,從中篩選出推理結果正確的樣本,將其作為新的訓練數據。

對於無法正確推理的問題,作者還引入了「反向推理」機制,將正確答案作為提示,讓模型倒推對應的推理步驟,將生成結果並入訓練集。

最終,作者用新的訓練數據微調原始語言模型,重復進行推理生成,直至效能趨於穩定。

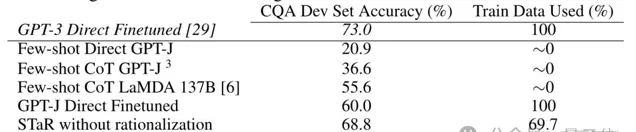

結果,在CommonsenseQA數據集上,STaR將GPT-3 Curie(6.7B參數)的準確率從33.6%提升到72.5%,與30倍參數量的微調模型(GPT-3 DaVinci,175B參數)效能相當。

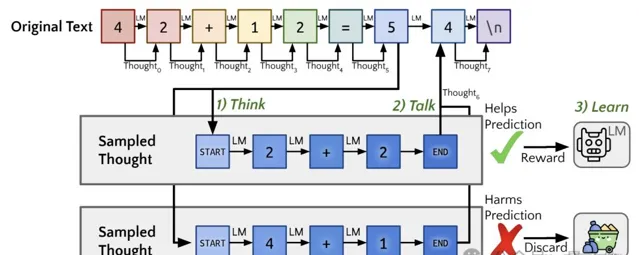

時隔兩年,本次釋出的Quiet-STaR,在此基礎之上做出了一些重要改進。

其中最核心的是把推理過程的生成從顯式的思考變成了隱式的內部思考,實作了對推理過程的靜默建模,這也就是名稱中quiet的由來。

不同於STaR在輸入中明確包含生成推理步驟的prompt,Quiet-STaR直接在模型內部、每個token處並列地生成推理過程。

同時,Quiet-STaR引入了可學習的「思考開始」和「思考結束」特殊token,使模型能夠自主學習何時開始和結束推理。

為了緩解推理引入的分布偏移問題,Quiet-STaR使用了一個混合頭來動態融合有無推理時的下一token預測結果,使模型能夠平滑過渡到生成推理的狀態。

另一個不同點是,Quiet-STaR采用了一個非短視的、多步預測的訓練目標。模型生成推理時,不僅要考慮下一個token,還要考慮對之後多個token的影響,從而生成高品質、長遠的推理。

數據方面,Quiet-STaR不再局限於STaR使用的特定推理數據集或任務,而是使用了互聯網文本等大規模語料,讓模型的推理能力更加多樣化。

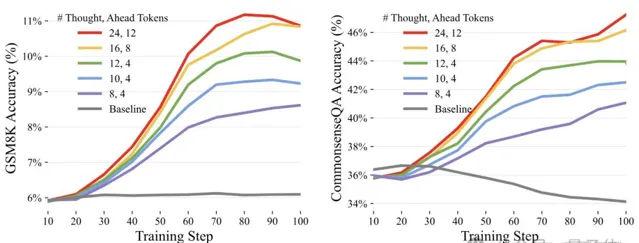

效果上看,這次的baseline模型換成了Mistral-7B,在GSM8K和CommonsenseQA兩個數據集上,套用Quiet-STaR訓練後準確率均有所提升,且隨著思考token數量增加提升越來越明顯。

具體來說,baseline模型在GSM8K和CommonsenseQA上的準確率分別是5.9%和36.3%,加入Quiet-STaR後最高上升到了10.9%和47.2%。

論文作者Noah Goodman教授表示,對於最新曝光的訊息,他感覺既興奮又恐懼。

如果一切真的朝著這一方向發展,那麽作為人類就要考慮一些嚴肅的問題了。

OpenAI定義AI的L1-L5

對於最新的曝光內容,有人覺得是炒作,有人覺得這倒是比語音模型進展有意思。

還有人覺得,如果Noam Brown都認可了,那應該是一個值得期待的進展。

不過最近OpenAI內部的動作似乎又多了起來。

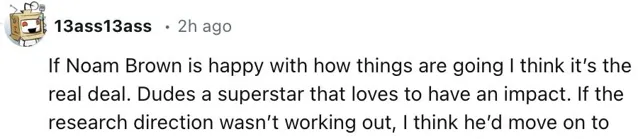

也是在周二這次全體會議上,OpenAI提出了一套評級來定義AI的進展。

一共可以分為5級:

L1:Chatbots,具備對話能力,比如ChatGPT。

L2:Reasoners,人類級問題解決能力,OpenAI已接近。

L3:Agents,可以代表使用者采取行動。

L4:Innovators,AI可以輔助發明創造。

L5:Organizations,AI可以像一個管理者那樣完成工作。

最後一級L5,也就是達到AGI的最後一步。此前OpenAI將AGI定義為「在最具經濟價值的任務中超越人類的高度自治系統」。

除了OpenAI以外,DeepMind、Anthropic也對AI系統提出了分級定義。

△來源:蘆義,Brilliant Phoenix合夥人

你更認可哪一家呢?

參考連結:[1]https://www.reuters.com/technology/artificial-intelligence/openai-working-new-reasoning-technology-under-code-name-strawberry-2024-07-12/[2]https://www.reddit.com/r/OpenAI/comments/1e1umu2/exclusive_openai_working_on_new_reasoning/[3]https://arxiv.org/abs/2403.09629[4]https://www.theverge.com/2024/7/11/24196746/heres-how-openai-will-determine-how-powerful-its-ai-systems-are