不久前,科大訊飛作為第一完成單位的「多語種智慧語音關鍵技術及產業化」計畫,榮獲2023年度國家科學技術進步獎一等獎,這是過去十年人工智慧領域第一個國家科學技術進步獎一等獎,對引領中國的語音產業,支撐智慧制造產業出海和升級等都有重要意義。 觀察者網·心智觀察所日前與科大訊飛研究院院長劉聰進行了一次交流,討論了科大訊飛最新的語音技術進展、現有語音技術與大模型的結合、國產芯片及生態建設等問題。在對話中,劉聰提到了訊飛現有多語種智慧語音技術的領先優勢,目前已經套用在多個產品中,支撐中國智造出海。訊飛采用國產芯片做語音模型訓練,難度很大,工作開展異常艱苦,劉聰呼籲各個企業聯合建設更完善的軟體生態。

計畫主要完成人代表在領獎後合影

對話全文如下:

心智觀察所:科大訊飛這次作為第一個完成多語種智慧語音關鍵技術及產業化的單位,獲得了國家科學技術進步獎一等獎。據聞,這是過去十年人工智慧領域第一個一等獎。請您總體上介紹一下此計畫的基本情況,它的背景和意義。

劉聰:我們這次得獎計畫的核心是智慧語音技術,也是訊飛的初心。在這個計畫歷經的十年間,深度學習領域發展迅速,也代表著人工智慧第三次浪潮的快速發展。在這一背景下,此次也是過去十年人工智慧領域第一個國家科學技術進步獎一等獎。

智慧語音領域對我們一直很重要。過去十年裏,我們一直強調語音作為人類最自然、最便捷的交流方式,是萬物互聯、人機互動的關鍵入口。

在人工智慧領域裏,多語種智慧語音廣受關註。訊飛雖然是從中文語音技術起家,但我們在過去十年裏逐步拓展到更多語種以及方言領域當中,這是一個非常重要的跨越。

國家科學技術進步獎主要考量兩大方面,一是提報計畫需要有核心技術創新,代表中國從技術原創角度在世界上取得領先。另一方面,與其他獎項不同,國家科學技術進步獎特別強調提報計畫的技術創新能否帶來大規模的產業化落地。

從技術創新上來看,語音領域涉及合成、辨識等技術,本計畫主要針對智慧語音關鍵技術產業化中攻克了多項技術難題,例如面向很多復雜場景時,會出現語音辨識聽不準、語音合成不自然、口語理解歧義等問題,以及當我們從中英文向多語種拓展、走向全球化的時候,出現數據資源稀缺的問題。在持續攻關中,我們提出了四個方面的關鍵技術創新:復雜語音訊號解耦建模關鍵技術突破、多語種共享建模關鍵技術突破、語音語意聯合建模關鍵技術突破、語音語意聯合建模關鍵技術突破、國產異構硬體平台訓練及推理加速關鍵技術突破。透過這些技術創新,我們解決了剛剛所說的技術難題,實作了在多個行業領域和智慧裝置上的套用落地。

總結來說,本計畫的意義,第一在於開創引領了中國的語音產業,支撐智慧制造產業出海和升級。

第二,透過支持多語言互通,助力民族團結,促進全球語音語言互通,協助「一帶一路」建設。在這個過程中,我們很好支撐了北京冬奧會和冬帕拉林匹克運動會、進博會、博鰲論壇等國家重大活動。

第三,我們一直強調自主可控,本計畫整個構建了自主可控的多語種智慧語音技術,以及全球的產業生態。

第四,我們認為技術也要有溫度,所以本計畫裏面的相關技術也持續助力公益,關註關愛我們的弱勢群體和特殊人群。

心智觀察所:我稍微補充問一下,請問此計畫的發起時間大概是什麽時候?訊飛雖然是第一完成單位,但獲獎團隊不止是訊飛這一家。請問獲獎團隊的構成如何?

劉聰:這個計畫開始時間大概是在2012年左右,至今差不多是一個十年左右的周期。

除了訊飛作為第一單位牽頭,過去十年裏在該計畫上與我們有緊密合作的還有一些科研機構,如中國科學技術大學、清華大學,訊飛與這兩所高校都有聯合共建的實驗室;還有產業鏈上的相關單位,如華為終端有限公司、中移(杭州)資訊科技有限公司、訊飛醫療、訊飛智元等。

心智觀察所:語音辨識研究當中有一個非常有挑戰的問題名叫雞尾酒會效應,請問訊飛是怎麽突破這個難題的?然後,能否用一些比較通俗的比喻來向公眾解釋一下其中的原理。

劉聰:雞尾酒會是語音領域一個非常具有挑戰性的難題,討論的是在復雜環境下分辨聲音種類的問題。人的聽覺系統非常強大,例如你如果參加一個雞尾酒會的話,周圍非常吵鬧,酒會裏有非常多的雜訊、談話聲、音樂聲以及酒杯碰撞的聲音。此時,如果你想聽清楚誰在和你說話,你會將你的聽力系統集中過去,在周圍很吵的環境下專註於某一個特別定向的人發出的聲音,這是人類所具備的一個能力。

在我們做語音辨識、語音合成技術時,若要衡量語音辨識系統的優劣,就要跟人的水平去做對比。在雞尾酒會難題裏,由於雜訊很多,所以對機器來說進行精準的語音辨識是非常難的。我從學生時代起就在研究透過單點技術來降噪,此後也嘗試過透過多麥克風陣列來提升整個前端的效果。雖然做了很多的工作,但是都只是在循序漸進,很難徹底解決這樣的問題。

此次獲得國獎的計畫中第一個創新點——復雜語音訊號解耦建模關鍵技術突破,其中有兩項技術能夠比較好地解決雞尾酒會問題。

我們在降噪裏面的一個關鍵問題是要把語音裏面的人聲和非人聲解構出來,這就叫解耦。對語音來說非常困難,因為語音是一個一維訊號。在這個一維訊號當中包含了很多的資訊,如人聲、雜訊等。甚至如果再進一步細化,可能還有人聲裏面的說話人聲音,及其音色、內容、性別等資訊。

為了解決這個問題,我們首先基於深度學習的框架,針對性地對語音裏每一個人的每一種內容做了針對性的建模。建模之後,我們就可以將剛才所說的雜訊、人聲的各類內容比較清楚地顯示出來。通俗來講,我們可以更加精細地把控語音裏面原來混雜在一起的、各種各樣的內容。此後,我們就可以更好地對雜訊做分離處理,也可以知道語音裏的聲音是跟說話人還是跟雜訊的聲音更接近。

同時,如果我們用聲學前端多麥克風陣列的多通道訊號來采集語音的話,還可以對這個訊號的時間、空間等內容進行分離。

這樣,一方面實作了人聲和雜訊的精確分離,另一方面,多維度的語音內容結構可以進一步地把聲音裏的內容、韻律、音色等處理出來,如此可以進一步地去解決雞尾酒會問題。過去幾年,訊飛連續4屆參與並獲得國際多通道語音分離和辨識權威賽事CHiME的冠軍,充分證明我們的語音辨識技術突破了更加復雜的場景。再進一步結合大模型,就是我們今年6月27日舉行的訊飛星火V4.0釋出會上呈現的極復雜語音轉寫技術,基於訊飛星火大模型的多模態能力,現場在雜訊環境下三人同時說話,正常人耳難以聽清,但我們做到了將每個人的聲音較為準確分離,並且即時轉寫出來。

訊飛星火V4.0釋出會上展示的極復雜語音轉寫

作為一項技術框架的創新,復雜語音訊號解耦建模關鍵技術還可以再延伸一下,套用到語音合成上。在過去,語音合成需要一個人錄制自己很多的聲音語料之後才能進行合成。如果我們沒有研發剛才所說的語音內容解耦技術的話,我們就很難把很多人的聲音合成為一個合成聲音,因為若將所有的聲音全混在一起的話,可想而知會變成一個「四不像」。但是,當我們透過這項技術把每一個人的聲音內容解耦出來之後,就可以把很多人的語音混在一起,訓練一個合成的模型,並且能夠分辨每個人的聲音之間的一些共性和特性是什麽。

此後,你如果希望模擬某個人的聲音,只需要用這個人聲音的特性以及相關的數據去建模即可。我們將這些內容進一步去建模、去控制時,如果面對一些新的發聲人,可能就不再需要那麽多的語音。以前語音合成需要錄制一個人十個小時左右的語音,近幾年只需要幾分鐘;目前在大模型框架之下,只需要一句話就可以了。所以,有了語音內容解耦技術,我們不僅能解決語音辨識的問題,同樣還可以達到對特定人更好的語音合成效果。

心智觀察所:本次國獎的獲獎計畫為訊飛研究多年的成果,而近些年面對大模型的突然崛起,業界有聲音質疑獲獎計畫是否被大模型的到來所顛覆。請問您會如何回應這些質疑,並請您簡單講述訊飛將如何將大模型與國獎計畫相結合。

劉聰:最早的大模型技術關註的並非語音領域,包括OpenAI的ChatGPT在內的大模型大部份是文本大模型,重點在於文本。

智慧語音技術更多是聲學層面,但以語音辨識為例,語音轉變成文字的過程中牽扯到了語言模型,即文本模型的一種。以ChatGPT等為代表的文本大模型,因為它的模型更大、語料更多、長文本的建模能力更強,本身能夠直接提升語音辨識和語音轉譯等效果。

語音合成則是反方向的,從文本到語音。當我們對文本做前端分析的時候會用到一些語言模型的技術,所以同樣也會文本大模型能力的提升帶來更好的效果。

其次,我們也可以進一步從文本大模型進行延伸。當有了文本大模型之後,業界開始研發一些其他種類的大模型。我們比較熟知的是從文本大模型拓展到多模態大模型,例如文生視訊模型、文生圖模型、多模態視覺理解模型等。當然,業界也有專門研究語音大模型的,套用文本大模型的框架來做語音大模型的框架。

雖然此次我們的國獎獲獎計畫並沒有直接使用大模型,但是針對語音提出的一些演算法創新,可以在大模型時代進一步與語音大模型進行結合。舉個例子,我們剛才提到的語音內容解耦、語音訊號時空分離等創新技術,本質上是對原始的語音訊號進行處理之後,獲得更高品質的語音編碼向量。我們可以將更高品質的語音編碼向量處理之後,再輸入到大語言模型裏,這樣做會比直接把原始語音訊號進行建模的效果更好,能夠完成前端的預處理及預訓練。

原來在多語種領域裏,國際上做得最好的一般是谷歌、微軟,他們有很多的多語種數據。但OpenAI在釋出文本大模型ChatGPT之後,去年11月釋出了Whisper v3的多語種語音大模型,效果非常驚人。訊飛則在去年12月開始,針對性結合此次國獎獲獎計畫的一些技術訓練星火語音大模型,並於今年1月30日釋出訊飛星火語音大模型。一經釋出之後,在中文、英語、法語、俄語等首批37個主流語種的語音辨識效果已超過了Whisper v3。

此外,我們之前也釋出了超擬人語音合成,意味著我們與機器進行語音對話時,能聽到像真人一樣的合成聲音,並且有情緒感知能力,不論在語音合成的自然度和擬人度上都有更好的表現。

今年1月30日訊飛星火語音大模型正式釋出

這個計畫涉及的創新方法結合場景套用,可以在通用大模型的基礎之上,進一步對語音問題有更好的建模和理解,同時也降低我們對多語種海量數據的需求。本計畫的技術跟大模型之間可以形成互相借鑒、互相結合的關系。

心智觀察所:現在訓練大模型因為各種原因,需要更多地使用國產芯片。那麽使用國產芯片來開展智慧語音演算法模型訓練和推理的時候,有哪些難點需要被克服?請問訊飛專門做了哪些最佳化?

劉聰:國產化也是本計畫的一大特點。我們一直強調國產自主可控,一方面是重視自己能夠掌握的演算法創新,另一方面註重跟硬體相結合。2019年訊飛被美國列入「實體清單」時,我們就開始做儲備。目前,國產芯片本身在制造等方面被「卡脖子」,在效能上有一定的差距,而且芯片的軟體生態也有待發展。

對比影像,在本計畫裏用國產芯片做語音模型訓練相對而言難度更大。說同樣一個詞,我可以說得慢、也可以說得快;在語音模型裏做芯片的適配時,不同的語音長度可能會導致對算子的適配度不一樣。即使芯片在硬體參數上水平相當,但算子適配不好的情況下去直接訓練模型,很可能剛開始只有百分之二三十的效率。這樣同樣訓練一個模型,需要的時間更長,還有些算子會不支持,實際上是很重要的一個問題。

從現在領域裏比較關註的端側適配的角度來看,一些國外的芯片在端側使用這些模型時,量化適配做的比較好,不論什麽模型在量化後損失可控。而國產化的一些端側芯片量化之後,積累的誤差損失會比較大。

所以針對效能低、適配難以及語音變長等問題,計畫提出了硬體親和的變長輸入算子融合和聯合統一量化感知訓練技術,透過軟硬體協同最佳化的動態張量算子自動融合方法,實作對語音等變長輸入的訓練效能最佳化達到國際主流芯片同等水平;透過多硬體聯合的量化計算模擬,達到模型單次訓練後可在不同硬體平台上一鍵部署,解決了智慧語音技術硬體平台的「卡脖子」問題。現在訊飛很多的硬體產品,例如錄音筆、掃描筆、辦公本、學習機等都使用了國產芯片,也基本在使用上面提到的演算法,證明了有效性。

值得一提的是,由於我們被列入「實體清單」,導致這些工作的開展異常艱苦。但是如果沒有這些經驗和積累,我們此後就無法與華為聯合攻關,在去年共同建設出全國第一個國產萬卡算力集群「飛星一號」,並且此後基於「飛星一號」推出訊飛星火大模型V3.5、V4.0,這些星火新版本都是在全國產平台上訓練出來的。據我所知,如此大規模使用國產化平台訓練模型成功的只有訊飛。

去年10月24日,「飛星一號」正式釋出

所以我想強調的是,此獲得國獎的計畫不光是解決了歷史上智慧語音技術相關模型的國產化問題,更是為大模型時代的國產化能力奠定堅實的基礎,讓大家看到在全國產算力平台上訓練對標國際頂尖水平的大模型是完全可行的。

心智觀察所:您剛才談到了第一個萬卡的全國產算力平台「飛星一號」,我們想了解一下它目前的基本情況,請問此平台目前表現怎麽樣?

此外,因為您剛剛也談到為國產硬體芯片做專門的最佳化非常辛苦。作為走過這條路的企業來說,你覺得國產芯片除了硬體的計算效能之外的軟體生態建設方面,您還有什麽呼籲和建議嗎?

劉聰:從進展來說,去年底「飛星一號」整體訓練效能相對於輝達集群已提升到90%,並且之後還在不斷最佳化提升,但是整體和國外先進水平對比還是有一定差距。由於模型與模型之間的適配邏輯不完全一樣,有些不同尺寸結構的模型需要持續地適配,我們的重點在訓練最主要的模型上,同時持續地訓練和叠代多模態模型、語音模型等。我們也將繼續與華為合作,深入完成全國產算力平台相關的工作。

我認為生態是共建的,而不是靠某一家企業的算力和人工智慧。如果我們想要做到輝達一般的生態和框架,能足以應對任意一個模型,就要對各種各樣的結構、尺寸、模型創新有充足的支撐,以及在硬體的底層能力上持續進行演進,變得更加友好。

對此,我有另外一個呼籲:開放算子庫。開放的方式有很多,例如從底層的算子庫到上層的框架,以及配合一些社群的內容。目前,訊飛和華為共建的算子庫大部份都已經共享到庫中,未來如果有更多能夠比較開放地使用算子庫的企業,他們自己的很多創新演算法就可以用這些算子去驗證,並且會不斷地去發現問題、閉環問題,這對於我們行業很關鍵,核心還是大家要去用。

心智觀察所:據了解,如奇瑞、一汽等車企也做過一些比較,認為訊飛的多語種智慧語音技術效果全面領先於競品賽輪思。華為隨後也做過一個測評,稱訊飛領先於谷歌。請問在這些評比中具體比較的是一些什麽樣的計畫?

劉聰:一般評測指標有兩種,第一種為技術指標。技術指標一般需要我們要透過國際上權威的評測來做,可以理解成純演算法本身的比拼。例如我們在2021年國際低資源多語種語音辨識挑戰賽OpenASR,獲得了15個語種22項第一。故此,這種指標是一個較為學術性的指標。

你剛剛提到的這些測試主要是站在產品的層面來做評估,考驗端到端效果。舉個例子,在奇瑞、一汽等車企的評測裏,它評估的不只是一個單點的語音辨識指標,而是考慮整個汽車語音互動的流暢度、任務的資訊傳達準確性、功能多樣性、喚醒成功率等各種各樣的維度。

與我們競爭的是國際上的語音辨識王者賽輪思,前身為被微軟收購的Nuance。在車企的互動測試裏,我們的系統效果全面領先賽輪思。同時,由於中國過去幾年在汽車出海上表現優秀,本計畫也經歷了多語種的互動效果評測,國內現在出海的汽車,其車載語音互動系統絕大部份選擇的是訊飛的多語種智慧語音互動系統。

華為的評測在當時主要是考慮面向歐洲的手機出海,所以它的評測計畫主要是手機的語音助手。我們的主要對手就不再是賽輪思,而是谷歌;華為采取的同樣是端到端產品層面的測試。當時評測了英語、法語、西班牙語、義大利語等語種,訊飛也都全面超過谷歌,最終由我們提供了整個系統。所以,在去年全球1024開發者節大會上,華為副董事長、輪值董事長徐直軍提到目前華為公司在全球所有使用的智慧終端的語音技術,都是來自於科大訊飛,而且不僅僅是中文。

這些企業在產品層面的遴選都非常嚴格,既要求效果又要求效率,還有可靠性。他們卻不約而同地選擇訊飛,充分證明了我們站在客戶視角做出的端到端效果和體驗很優秀。

心智觀察所:我看到有提出多語種技術存在一個卡脖子的問題,請問這個問題的由來是硬體層面還是演算法層面?然後,訊飛提出了一種多語種統一音素韻律體系,並提到一個基於語族分組的共享建模技術,請問這些技術又是一個怎樣的情況?

劉聰:某種程度上,這次的計畫獲獎與卡脖子非常相關,許多國產化計畫其實都是在這個背景之下催生的。

卡脖子既包含軟體和硬體。硬體在剛才已經講述了一些,例如從2019年斷供人工智慧的關鍵芯片,後來愈演愈烈;2022年10月,美國再一次極限施壓,升級對華半導體管制,導致我們基本上無法購買任何美國生產的硬體。另外在芯片層面,隨著大模型的崛起,美國也進一步加大對硬體層面卡脖子的力度。

在軟體層面,美國直接掐斷了多語種語音技術的支持,很多語種技術服務無法使用,使得中國每年龐大的手機、家電出口受限。當然,訊飛的多語種技術也因此受到了很大的影響,訊飛在中文語音領域全球領先,在數據方面有多年儲備,但是我們當時關註的60多個語種不可能都像中文這樣去投入:一是因為多語種數據資源缺乏,很多語種沒有那麽多數據;二是即使我們能夠獲得一些小語種的數據,但是每個語種的知識及語言專家都很難找,知識匱乏。

為了應對小語種智慧語音系統構建所面臨的知識匱乏、訓練數據稀缺等難題,除了前面提到的語音內容解耦共性技術在多語種領域有一些套用之外,我們在多語種共享建模關鍵技術上也實作了突破:設計了全新的多語種通用音素體系RGP(Rough Global Phone)和基本語言單元,結合字音轉換自動學習和人類語言專家的校驗反饋,讓不論哪個語種的詞語都能使用這套共性的音素體系,實作了多語種統一音素韻律體系的構建;

再透過基於元學習的多語種預訓練和基於語族分組的多語種共享建模——通俗地說,就是將不同的小語種進行分類,找到同類語種的共同規律,進行分析建模和訓練。基於以上技術創新,我們使需要的小語種數據數量大大降低,最終也顯著提升了小語種語音系統效能。

心智觀察所:關於這次獲獎,您剛才也提到和中科大的合作,從校企合作的這個角度來說,攻克核心技術,促進復合人才發展,推動科技成果轉化,請問從您的角度來說,您覺得還有哪些工作是可以總結或是需要繼續完善,繼續去進一步做?

劉聰:將本次獲獎算在內,訊飛一共三次獲得國家科技進步獎。每次獎項都凝結了十年左右的積累和突破,我們自稱「十年磨一劍」。

訊飛從成立之初,就非常關註產學研。當年,訊飛創始人、董事長劉慶峰等六名在校大學生加上十二名員工,一共十八個人創業成立科大訊飛,我們也是第一家在校大學生創業之後成功上市的企業。如此看到,訊飛源頭的核心技術來自中科大,特別是王仁華老師建立起的中國最早的人機語音通訊實驗室。除了中科大之外,訊飛也整合了源頭核心技術資源,包括語言所、聲學所以及後來清華大學等,將國內在語音方面最有優勢的產學研資源全都集中。此後,我們也不斷基於研究方向和許多外部實驗室合作。故此,我們從創立之初到現在一直高度重視產學研。

我們現在產學研模式與成立初期有一些變化。早期我們的產業模式更多是一個橫向計畫,這意味著每當企業有一個任務需要高校的創新能力時,就需要高校從原始創新的角度去解決這樣的任務。但是,我們現在的問題大多源於產業裏很復雜的一些問題,解決它們也需要一個比較復雜的產業鏈。所以雖然橫向計畫仍然存在,但現在很多的組織方式變為和高校共同申報國家的計畫。企業的問題中可能會解析出一些不同的技術難題,有的需要原始創新、適合高校去研究;有些需要工程能力或系統性創新能力,適合企業去完成,因此現在校企之間變成了一個更大的創新聯合體概念。

多年以來,我們一直堅持產學研,但伴隨著科技創新在不同時代所要解決的問題不同,企業、高校在其中扮演的角色也一直在變化。

那麽,我們訊飛產學研的邊界在哪裏?從訊飛這些年的經驗來講,我們的業務部門在做「今天的事」——在產品研發過程中,我們不可能在技術仍然是「期貨」狀態時就馬上推出產品,產品推出時技術應該已經成熟,使得使用者在使用體驗之後,技術還能夠持續叠代;

訊飛研究院則是在研究「明天的事」。研究院會進行技術孵化,例如做出一個技術demo給大家展示,雖然還沒有進入產品和套用,但是有了技術雛形。此後結合套用場景、產品的具體需求,這些技術會繼續打磨叠代,直至真正套用;

高校所考慮的甚至更加長遠一點,想的是「後天的事」。有些高校裏的技術可能仍然存在於論文之內,離工程化還有一定的距離,但卻代表了下一代,甚至是下下一代產品的技術可能與方向。

所以,我們需要分配好我們的產學研資源,在企業我們強調技術的套用落地,在研究院裏完成技術的預研的孵化,在學校裏探索布局下一代前瞻技術。

訊飛研究院上一任院長胡國平曾經提出過一個理念:台階的重要性,意思是對於企業來說,如果等一個技術完全成熟之後再去布局,可能就會為時已晚;所以在技術不斷進步的前提下,上一個台階技術相對成熟,我們就要預估技術進步的未來趨勢,以及能夠達到的具體程度,提前布局下一個台階裏更高難度的技術和更廣闊的套用場景。

打個比方,我們2010年推出了訊飛輸入法,開啟語音輸入的時代。但大家使用語音輸入法的時候一般是自己思考一下再說出來,這種場景下的語音辨識難度顯然比不上兩人聊天、多人開會。雖然當時在深度學習技術的加持下,語音辨識水平有了顯著提升,但套用到會議場景準確率就會驟降,因此2011、2012年我們叠代訊飛輸入法的時候開始思考,如何讓語音辨識技術拓展到訪談、會議等場景裏套用。

2015年時,訊飛輸入法效果已經非常不錯,那一年我們在年末的釋出會上又推出了語音轉寫技術的成果——訊飛聽見,全程將釋出會上劉慶峰董事長的發言進行精準的轉寫,實作了技術突破。

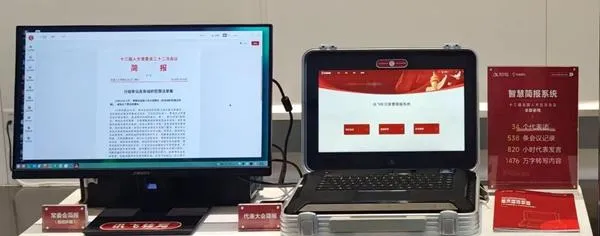

此後,我們又逐漸叠代技術,並且基於此推出了錄音筆等智慧硬體,訊飛聽見也服務了越來越多的重要大會,並且在語音轉寫之外還實作了轉譯等功能。今年,訊飛聽見已經服務全國政協兩會六周年,全面覆蓋人大政協各個駐地會議三周年,訊飛聽見智慧簡報系統助力了兩會期間駐地的記錄服務工作,同時還幫助數十家媒體的多位記者采訪記錄、高效出稿。

我們今天之所以能夠達到這種水平,離不開之前所設定的「台階」。所以要基於技術發展的速度,合理地預判趨勢來提前做產業轉化的布局。