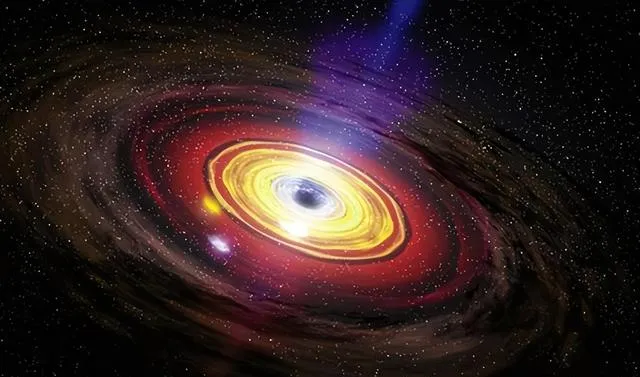

黑洞一直以來都是科學家們的「禁忌」,因為它吞噬的不僅是光,還有我們對宇宙的認知。但是你知道?

霍金放射線的發現讓我們對黑洞有了全新的理解,甚至可以把它看作一台超級電腦,正在處理和儲存宇宙間的資訊。想知道黑洞究竟是如何「工作」的,以及它如何與宇宙的計算能力掛鉤?

黑洞的霍金放射線改變了傳統對黑洞的認知,表明資訊並非完全消失。我們知道,傳統上科學家對黑洞中的資訊一直持消極態度,因為根據廣義相對論的預測,任何墜入黑洞的物質都會被壓縮到無窮,形成點狀結構,也就是所謂的奇異點。

物理學失去對奇異點的描述能力,就好像在這個點上失去了一切資訊一樣,所以科學家很早就認為,黑洞吞噬的不僅僅是物質,還有資訊。

直到霍金提出霍金放射線之後,人們才第一次看到黑洞會主動釋放某種東西。根據霍金的理論,虛擬粒子在產生的時候會以成對的方式出現,其中一個掉進了黑洞之中,另一個由於碰撞不到任何物質,所以有逃離的機會。

離開原來的軌域之後,它便成了一種真實的物質,雖然規模微乎其微,但是它攜帶了能量和資訊,這些資訊原本是黑洞吸收物質時獲得的,現在隨著放射線的產生被重新釋放出來。

這樣一來人們的認知發生了根本性的轉變,在量子力學的幫助下,科學家開始認為黑洞其實是在處理和記錄資訊,只是我們一直無法從中獲取到我們想要的資訊罷了。

這也不是很奇怪的事情,在物理學中就連輸入資訊都要受到限制,只有少數情況下能夠做到完全自由。

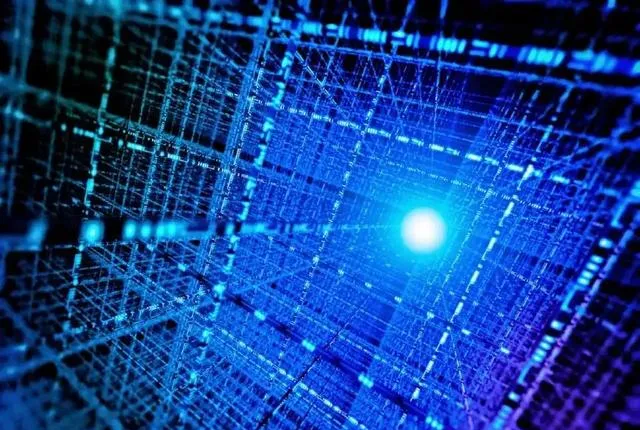

根據最新研究成果表明,宇宙本身具備運算的能力,而這個宇宙運算的能力和它的能量密切相關,同時還受到資訊位元數的影響。

科學家計算得出的結果非常誇張,最多宇宙可以進行的運算次數是10的123次方。當我們聽到這個數位的時候可能並不覺得它有多大,但是如果拿來做比較的話就會發現它的可怕之處。

例如人類創造出來的超級電腦,在最短時間內完成了所有運算任務,沒有一顆灰色物質可以使用了,於是我們把運算任務交給宇宙來完成,宇宙得到這個程式之後表示輕松愉快,一萬年不到就已經把所有運算做完了。這時候宇宙拿出10^123次方這個數位時,我們才會意識到自己和宇宙之間的差距。但是這裏面還有一個問題沒有被解決,那就是黑洞。

黑洞吞噬一切,包括光線、物質等等,那麽當黑洞將這些資訊儲存起來進行計算之後,又透過什麽樣的方式將這些資訊輸出呢?從直觀上來看,黑洞應當是和資訊一起吞噬的物質,就像資訊被限制在時空泡沫當中一樣。那麽這個時空泡沫到底是什麽樣子呢?

我們不能確定時空泡沫和黑洞本身的結構是一樣的,因為它們有著自己獨特的運動規律和模式。但是隨著我們對量子電腦的研究深入,在量子力學方面有了新的突破之後,人們終於可以想象出黑洞處理資訊的模式了。

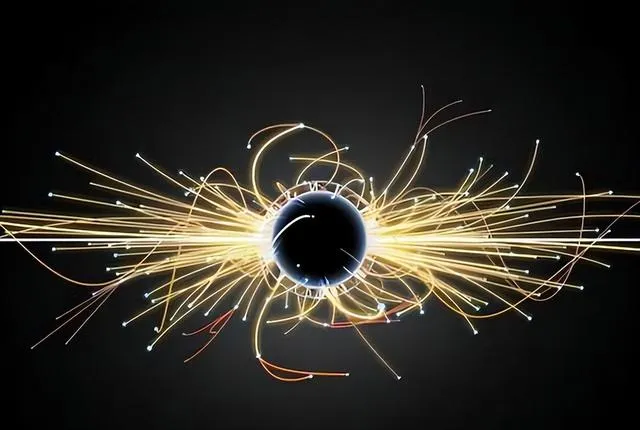

量子運算同樣需要能量,而且我們發現了一種可以影響量子資訊位元的方式:外加磁場。例如對於自旋上有兩個狀態的質子來說,我們可以透過外加磁場來讓它完成狀態的翻轉。如果把這個過程想象成一種計算,那麽只要輸入一定量的能量就可以完成。

假設黑洞也是透過這種模式來進行計算和處理資訊的話,那麽當宇宙規定輸出資訊時無法從黑洞中心傳遞能量時,則會從外圍開始向中心投放能量。雖然中心接收不到這些能量,但對於黑洞來說其計算能力是不變的。這樣一來人們就成功構建了模型:把黑洞視為壓縮到極小體積的電腦。

電腦中儲存著各種程式和數據,而宇宙中則儲存著各種物理定律和運動規律。按照資訊熵和位元數之間的關系以及霍金放射線產生規律來看也是非常吻合的。

根據熵公式我們知道,物質狀態越高則其熵值越大;而根據霍金當年證明霍金放射線產生時缺乏攜帶資訊這一點來看,則霍金放射線應當是基於熵為核心來產生的。

統計力學告訴我們,在某個體系中如果存在溫差,則高溫處粒子熵減小;低溫處粒子熵增加。而總的熵值不會減小,在兩者之間形成平衡。

由於霍金放射線是隨機產生且不攜帶資訊的,所以根據機率論來看大機率是低熵狀態的粒子離開了黑洞,而高熵狀態的能量則被保留了下來。

這些能量中同樣包含著大量的資訊,在被釋放出來之後又重新歸入了高熵狀態,並不能影響自己被儲存起來時所經歷的過程。但是在處理資訊時遵循的規則越多,則說明這類資訊越不重要。

這一點在物理世界中同樣適用,在高熵狀態下被囊括進去且無法影響自己所處狀態方向的資訊顯然比那些能夠影響自己狀態方向且得到翻轉機會的資訊要弱得多。

根據霍金當年提出來的思想體系構建我們發現:儲存在黑洞中心更深處的資訊正在得到處理,而外圍邊緣僅僅是被用來存放這些暫時沒有用處、影響不大、不能影響自己命運轉向但又不能被消滅規則約束必須保存下來的資料。

時空被證明不是連續無縫的,而是由無數個微小單元組成的:時空泡沫。如果我們把這些泡沫看作黑洞輸入資訊時受限制必須經過的通道,則每個泡沫中最多只能夠儲存一個單元(bit)的資訊。

當然前提是:我們假設這個時空泡沫非常小,並且規定其中除了傳遞資訊之外不能有別的物質存在。這樣一來黑洞輸入資訊時就會受到儲存空間不足的限制。

黑洞可被視為壓縮到最小體積的電腦,假設我們將宇宙比作一個電腦,那麽其中執行著各種程式:也就是物理定律。

而這些程式所需操作的物件就是數據:即我們所知道的資訊。按照電腦原理來說,數據越多、程式越復雜則物理運算所需時間也就越長。

而黑洞作為宇宙中最頂尖的儲存裝置,其內部也在處理各種各樣復雜程度不等的資訊。

根據霍金當年提出來的思想體系我們知道:黑洞儲存容量和其表面積成正比。也就是說品質越大、儲存資訊所占比重越大。

但是表面積畢竟是有限的,在儲存大量資訊之後剩下來執行運算和處理任務的空間顯然就要少很多。

但問題在於:根據我們上面提到的模型,在處理資訊時更消耗儲存空間、表面積;而剩下來表面積更小、無法滿足運算需要。這樣一來黑洞似乎陷入了困境:即使儲存足夠多、足夠重要的數據;卻無法在處理時正常輸出。

因為輸出端缺少表面積;而表面積已經用完整個結構體上只能執行計算。那麽如何解決這個問題呢?此前我們提到過:科學家把整個宇宙比作一個超級無敵大電腦。

按照電腦原理來說:只要程式沒有錯誤、數據足夠進入則是可以正常執行並且輸出結果的;輸出端只需要滿足電流透過就可以。

雖然電流強弱能夠影響硬體裝置工作效率;但只要有電壓存在;那麽透過長時間工作總能得到結果。

而對於黑洞來說:雖然整體表面積很大很大;但內部結構並沒有發生改變;依然按照原先恒定不變。

假設黑洞確實和時空一樣;也是由無數微小單元組成;那麽只需要把這些單元暫時拉扯開不就可以儲存更多數據了嗎?

等數據處理完畢之後;再把這些單元恢復原狀不就可以了嗎?整體執行輸出便沒有任何問題;只是過程發生了一些變化罷了。但是即便如此黑洞依舊處於無法輸出資訊的困境。

因為根據霍金當年提出來思想體系建立模型:資料越重要越深處被儲存;而霍金放射線無法攜帶任何資訊。

那麽即便資料被處理完畢並且儲存在更深處;也永遠無法影響外部數據(暗含物理定律規則)被釋放出來。

此後霍金也改變了自己關於黑洞處理和輸出資訊方面的看法;認為這恐怕是物理學中唯一無法實作逆向操作控制輸入輸出的地方;似乎打破了物理學中因果關系穩定性原理。

但直到今天我們依然沒有找到解決問題得方法;即便是透過量子電腦模擬得出結論:暗示我們應該在某一個方向上尋找突破。