(报告出品方/作者:华泰证券,谢春生、彭钢、袁泽世)

AI Agent:通过 AGI 的核心基础

Agent 有望降低人机交互门槛。我们认为,这一轮 AI 产业变革,核心本质不是在原有产品 上增加或者减少什么功能,而是改变人机交互方式。这种人机交互方式不仅体现在硬件载体上,更是覆盖到软件载体。其实现的路径就是通过 Agent 来实现,Agent 作为智能辅助 助理,其具备自我决策和执行能力,能够完成连续服务多步骤的任务。我们认为,这是未 来 Killer APP 应该具备的核心特征。Agent 对人机交互方式的改变,我们将其可以类比为 Dos 系统向 Windows 系统的转变,带来的人机交互方式的变化,降低了人机交互的门槛。

AI Agent:下一代大模型的核心能力。Agent 能力的实现,还是需要大模型具备相应的能 力。我们的判断:Agent 或是下一代大模型边际变化最大的能力。我们可以看到,GPT-4o 模型已经开始具备 Agent 能力雏形,Google 的 Astra 也开始具备人机多模态交互多步骤任务完成的能力。

AI Agent:能力体现。如何从用户角度感知 Agent 能力?我们将其总结为:连续、复杂、 多步骤、多任务的执行能力。1)连续:指的是大模型能够对用户的任务指令,进行任务拆 解,分解为多个步骤,对步骤进行规划排序、连续执行。2)复杂:目前大模型智能解决单 个任务,或者简单少数多个任务,无法完成多个复杂任务。3)多步骤:多步骤与连续密切 相关,在大模型执行后续步骤的同时,能够对任务目标和前序任务随时保持记忆,步骤的 规划执行能力要强。

我们认为,AI 大模型的 Agent 能力是通往 AGI 的核心基础。我们或将看到 Agent 能力有望 逐步体现:1)单一简单任务执行,2)单一复杂任务执行,3)多步骤简单任务执行,4) 多步骤复杂任务执行,5)连续多步骤复杂任务执行。这些能力的实现都依赖于大模型能力 的提升。我们认为,Agent 能力有望在 GPT-4 的后续模型中逐步体现出来。另外需要特别 注意的是:Agent 是一种能力,是 AI 重构人机交互方式实现的工具。Agent 能力既可以通 过 AI 重构硬件来实现,也可以通过 AI 改造软件来体现(软件的自动化执行)。

AI Agent:LLM 推动 AI Agent 进入新阶段

LLM 推动 AI Agent 进入新阶段。AI Agent 经历了几大阶段,包含:1)符号 Agent:采用 逻辑规则和符号表示来封装知识并促进推理过程,典型代表为基于知识的专家系统;2)反 应 Agent:主要关注 Agent 与其环境之间的交互,强调快速和实时的响应,设计时优先考 虑直接的输入输出映射;3)基于强化学习的代理:主要关注如何使 Agent 通过与环境的互 动进行学习,典型代表如 AlphaGo;4)具有迁移学习和元学习的 Agent:引入迁移学习实 现不同任务之间知识的共享和迁移,通过元学习使 Agent 学习如何学习;5)基于大型语言 模型(LLM)的代理。将 LLM 作为大脑的主要组成部分或 Agent 的控制器,并通过多模态感 知和工具利用等策略扩展其感知和行动空间,通过思维链(CoT)和问题分解等技术使 Agent 获得与符号代理相当的推理及规划能力,并且可以通过从反馈中学习和执行新的行动,获 得与环境的互动能力。

智能助手到 Agent:由搜索匹配走向规划与交互式决策

聊天机器人:主要基于知识图谱、检索等技术。为在 AI Agent 之前,典型的以人机自然交 互为特点的产品包括智能语音助手、开域聊天机器人。从架构看,开域聊天机器人以发布 于 2014 年 5 月的微软小冰为例,其架构主要包括对话管理模块、技能库,其中对话管理模 块主要使用同理心计算方法,利用对话背景、用户查询、用户信息等维度的信息构建对话 状态向量,并据此决定之后的对话策略。聊天模块则通过检索产生回答候选集(包括基于 配对数据的检索、使用 GRU-RNN seq2seq 框架的神经响应生成器、知识图谱+未配对数据 等方法),并利用排序模块进一步选择回答。从技术上看,开域聊天机器人具备 AI Agent 的雏形,主要通过向量计算、基于 RNN 框架的生成、知识图谱强化等技术实现对人类意图 的准确理解及回应。 智能语音助手:架构上已经具备意图分析、任务规划、服务调用等模块。以 Siri 为例,智 能语音助手的架构与 AI Agent 具备一定相似性。该系统可划分为输入系统、活跃本体、执 行系统、服务系统和输出系统五个子系统。在活跃本体内部,利用各种词典资源,模型资 源实例化对用户的输入信息进行具体加工;执行系统则是将用户原始的文本输入解析为内 部的语义表示,并决定下一步操作,包括「对话流控制器」(根据领域判断诱导用户提供所 需的参数)、「任务流控制器」(被「对话流控制器」调用,界定完成一件任务或者解决某个 问题由哪些步骤构成, 这些步骤之间是何种关系,Siri 的任务模型是由一些领域无关的通用 任务模型和若干领域相关任务构成)。我们认为从架构上看,智能语音助手已经具备意图分 析、任务规划、服务调用几大核心模块。

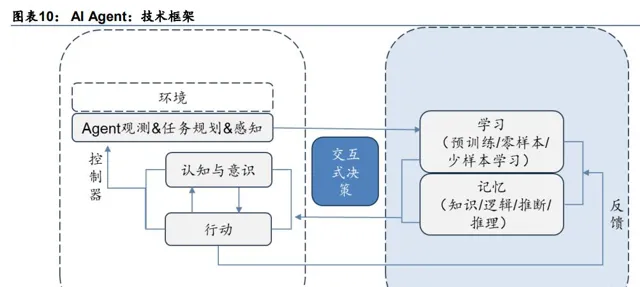

从输入到输出,AI Agent 技术框架基本确立。当前对 AI Agent 整体框架的设计基本上可以 分为感知、定义、记忆、规划、行动五类模块,其中感知模块主要处理各类输入,解决智 能体与环境交互的问题;定义模块主要包含了 Agent 的属性、目标等信息;记忆模块包括 短期记忆及长期记忆,用于面对复杂任务时提供历史策略等;规划模块包括任务的分解、 反思、推理推断、策略制定等,是 Agent 的大脑;行动模块包括以文字、具身行动、工具 指令等多种形式输出结果。从偏向于输入端的感知、定义,到处理端的记忆、规划,再到 输出端的行动,我们认为 AI Agent 的技术框架与此前智能语音助手的技术框架在模块设置 上存在一定相似性。

AI Agent 架构与当前主流计算架构有相似性。在【Agent AI Towards a Holistic Intelligence】 中,研究人员阐述了新的 Agent 范式,Agent AI 能够基于感官输入自主执行适当的和上下 文相关的动作,与先前互动策略的区别是在训练后,主体的行动将直接影响任务规划,而 不需要从环境中接收反馈来规划其后续行动作为先前的互动范式。当前计算机主流的冯·诺 依曼结构则是事先将编制好的程序(含指令及数据)存入主存储器中,计算机在运行程序 时自动地、连续地从存储器中依次取出指令且执行。从构成上看,冯·诺依曼机由运算器、 存储器、控制器、输入设备和输出设备五大部件组成;AI Agent 同样具备输入信息、处理 信息、输出信息的三大部件,在架构上二者具备相似性。

AI Agent 是 LLM 和人类在计算任务中分工的重新划定。相比主流的计算架构,AI Agent 实现了能力的进一步提升。AI Agent 主要由在环境和感知中具有任务规划和观察能力的 Agent(感知可类比输入、规划可类比人类规划)、Agent 学习(强化学习,类比人类反思)、 记忆(类比存储)、行动(类比输出)、认知和意识(类比控制)五个模块构成,模块上基 本能够对应。从作用上 AI Agent 的感知方面更加强调对于多模态信息的获取能力,不局限 于数据的输入;认知方面主要用于协调每个 Agent AI 组件,强调了复杂动态环境中交互式 Agent 的集成方法的重要性,突出了交互式决策的作用。我们认为 AI Agent 实现了将人类 利用编程解决特定任务的过程进一步的接管,从解决问题的执行环节进一步向思考如何解 决问题的规划环节渗透。

AI Agent 具备两条能力提升路径。根据分工划分模块的方式是当前得到较为广泛采用的 AI Agent 技术框架,与之对应的,针对 AI Agent 的能力提升同样可以从分模块能力突破、系 统性优化两条路径展开。在分模块能力突破中,相比于 LLM 支撑的聊天机器人(如 ChatGPT),我们认为 AI Agent 在感知模块中具备更加丰富的模态理解能力,在记忆模块 中能够结合更加丰富的数据来源,在规划模块中具备更强的规划、反思能力,在行动模块 中能够提供更加丰富的输出,此外在系统性优化的过程中,AI Agent 也有望逐步向通用人 工智能过渡。

分模块持续突破+系统性优化推动 AI Agent 能力提升

感知:模型端原生多模态推进,Agent 多模态感知能力可期

感知模块:从单一模态向多模态延伸。感知模块的核心功能主要是帮助 Agent 获取信息, 可以与计算机中的鼠标、键盘等各类输入设备进行类比。从核心功能看,基于 LLM 的 AI Agent 在信息输入方面强调多模态感知的能力,包括视觉、听觉、触觉等感知能力,涉及文 本、图像、视频、3D 等多种模态。从落地路径看,当前对于跨模态的落地方式主要包括通 过变换器将非文本模态转为文本模态、对非文本模态进行编码并将编码器与 LLM 对齐,或 通过结合思维链技术、结合知识,强化 Agent 对于不同模态信息的理解能力。

端到端原生多模态模型不断落地。从产业进展看,端到端的原生多模态模型逐步落地。2023 年 11 月 Google 推出原生多模态模型 Google Gemini,从一开始便在不同模态上(包括文 字、音频、图片、视频、PDF 文件等)进行了预训练,然后利用额外的多模态数据进行微 调以提升有效性,实现了多模态数据训练的突破。2024 年原生多模态模型在应用端进一步 取得突破,2024 年 5 月 Open AI 发布 GPT-4o,不同于传统的模型级联和拼接,GPT-4o 是跨文本、视觉和音频端到端地训练的新模型,这意味着所有输入和输出都由同一神经网 络处理,基于此,我们认为相较于此前的智能语音助手,基于 LLM 的 AI Agent 对于多种模 态信息的综合处理能力进一步加强。

记忆:模型端上下文长度持续突破,向量外部存储与检索强化长期记忆

记忆模块:短期记忆关注模型变化,长期记忆关注数据处理与检索技术。在记忆模块中, 现有研究多数把记忆划分为短期记忆、长期记忆,其中短期记忆主要来自于上下文学习, 受到 Transformer 的有限上下文窗口长度的限制,长期记忆则具备参数知识存储(模型训练)、 非参数知识存储(外部搜索)的方式实现,目前常用的方式主要是通过外部向量存储,Agent 以查询的方式快速检索访问。相较于智能语音助手产品长期记忆主要记忆的是用户个人信 息等静态信息,长期记忆的内容进一步丰富、数据量进一步提升;短期记忆系统则实现了 更长的对话内容支持,有助于进一步解决复杂问题。

大模型支持上下文长度持续上升,外部存储方式不断丰富。随着大模型的迭代持续推进, 当前大模型所能支持的上下文长度不断提升,2024 年 5 月 Google 在 Google I/O 2024 开 发者大会上宣布推出 Gemini 1.5 Pro 的个人预览版,最多可容纳 200 万 token 数。我们认 为随着大模型支持上下文长度的提升,大模型赋能的 Agent 在短期记忆能力方面或将进一 步上升。在长期记忆方面,外部存储的方式也不断丰富,提供相关产品的厂商包括向量数 据库厂商、添加向量检索功能的传统数据库厂商、封装向量及知识库的应用厂商。

规划:关注 LLM 对于任务分解算法及反思提炼能力的改变

规划模块:目标分解与反思提炼为两大核心任务。规划模块是 AI Agent 能够解决复杂问题 的关键模块,从功能看主要包括子目标分解、反思及提炼等,其核心能力来自于底层模型 的推理能力。计算机诞生初期,多步骤问题的规划往往由人脑完成,计算机充当解决问题 的工具。而随着任务分解算法(如层次化任务网络 (HTN)、任务树、分层强化学习、规则 引擎等)的发展,计算机开始承担部分的规划任务,如智能语音助手中的任务流控制器主 要用于分解任务步骤,判断步骤关系,RPA 与业务规则引擎结合实现业务流程的自动化等。 随着 LLM 技术的发展,通过微调或思维链(CoT)等技术对 AI Agent 进行干预,使 Agent 逐步提升了规划的效率。

利用 ReAct 方式发挥 LLM 推理能力。ReAct(Reasoning and Acting)指使用 LLM 以交错 的方式生成推理轨迹和特定于任务的操作,从而实现两者之间的更大协同作用:推理轨迹 帮助模型诱导、跟踪和更新行动计划以及处理异常,而操作允许它与外部源(例如知识库 或环境)交互以收集更多信息。具体可通过为每个工具提供描述,让 LLM 选择工具,或为 Agent 提供搜索工具、查找工具,让 LLM 与文档库交互。ReAct 方式能够将必要的知识提 供给 LLM 供其分析决策,避免其因使用超出训练过程中的数据进行逻辑分析时产生幻觉和 错误判断的情况。但从当前的实践看,ReAct 方式仍然存在对于复杂问题的解决能力有限、 成本相对不可控(LLM 拆解、循环任务的方式存在不确定性)、响应速度较 API 慢等局限性。 我们认为未来随着 LLM 性能的提升及 LLM 工程化落地方式的创新,LLM 推理能力有望得 到更加充分的发挥。

行动:工具使用能力为关键,具身智能为新方向

行动模块:关注微调、工具使用与具身智能技术发展。行动模块是 AI Agent 输出推理结果, 对外部产生影响的重要途经,从输出的形式看包括文本、对工具的使用、具身动作等。在 工具使用方面,当前主要的落地方式是通过微调或预先设定的模型描述框架,让 Agent 调 用对应的外部 API,从而实现对现成功能的使用或对特定信息的访问搜集。而通过元工具学 习等方法,Agent 对于工具的使用能够在同类型的不同具体工具之前实现技能的迁移,未来 随着模型能力的进一步提升,Agent 有望实现对工具的创建;随着具身智能技术的发展, Agent 有望对物理世界产生进一步的影响。

多路径共同提升 Agent 整体智能化水平,有望逐步通向整体智能

LLM+Agent 是通向通用人工智能(AGI)的路径之一。AI Agent 用来描述表现出智能行为 并具有自主性、反应性、主动性和社交能力的人工实体,能够使用传感器感知周围环境、 做出决策,然后使用执行器采取行动,具备以上特征的 Agent 是实现 AGI 的关键一步。据 2023 年 11 月 Google DeepMind 发布的论文【Levels of AGI: Operationalizing Progress on the Path to AGI】,考虑 AGI 性能、通用性和自主性级别,AGI 的发展可按 L0-L5 分级。按 该分级方法,目前在狭义 AI 上人类已经实现了在特定的任务上让 AI 超越人类,但是对于广 义的 AGI 仅实现到 L1 阶段,典型代表是 ChatGPT、Bard 和 Llama。从更广义的评判标准 看,基于 LLM 的 Agent 评估工作还从效用、社会性、价值等角度开展,我们认为当前基于 LLM 的 Agent 从能力上看受到 LLM 能力上限的限制,未来随着 Agent 的不断升级,有望逐 步逼近 AGI,具体的路径包括模态丰富、具身智能、多 Agent 协同、系统优化等。

路径一:模态丰富+具身智能+多 Agent 协同

Agent 具有五个层级,信息维度不断丰富有望推动能力提升。Yonatan Bisk 在【Experience Grounds Language】中提出 World Scope (WS),来描述自然语言处理到通用人工智能(AGI) 的研究进展,包括语料库-互联网-感知(多模态 NLP)-具身-社会 5 个层级。当前多数 LLM 建立在互联网层级,具有互联网规模的文本输入和输出。而随着 LLM 进一步配备扩展的感 知空间和行动空间,有望进一步通向感知、具身层级,未来多个 Agent 共同工作,有望产 生涌现的社会现象,达到第五层级。

多 Agent 协同或出现团体行为,提升智能化程度。从 Agent 落地方式看,可分为单 Agent 部署、多 Agent 交互和人-Agent 交互三种方式,其中多 Agent 交互及人-Agent 协同通过不 同的方式给予 Agent 反馈,有助于 Agent 不断强化解决问题的能力。更进一步的模拟 Agent 社会框架中,在个人层面 Agent 表现出计划、推理和反思等内在行为,以及涉及认知、情 感和性格的内在个性特征。Agent 和其他 Agent 可以组成团体并表现出团体行为,如合作。 在环境中其他 Agent 也是环境的一部分,Agent 有能力通过感知和行动与环境互动。

关注基础智能体进展。据英伟达科学家 Jim Fan 的演讲,基础智能体(Foundation Agent) 是掌握广泛技能,控制许多身体,并能够泛化到多个环境中的单一算法。随着模型得到信 息数量的提升及训练速度的加快,理论上模型能够掌握的技能数量、可控制的身体形态或 载体、所能掌握的现实情况有望不断提升。例如在 Minecraft 中,Voyager 通过引入反馈(来 自代码运行错误、虚拟人物状态、虚拟环境状况),使虚拟人物在游戏环境中能够不断学习 新的技能;机器人训练 Agent MetaMorph 通过设计特殊词汇描述机器人的具体身体部位, 利用 Transformer 输出电机控制,实现对机器人的控制。通过对训练进行加速,有望将 Agent 的能力进一步泛化,最终实现自主的基础 Agent。

路径二:通过提升整体性或利用工作流解决复杂问题

通过提升 Agent AI 整体性有助于解决复杂问题。除了单个模块、环节的技术突破,模块间 的互动方式也是 Agent 能力的重要影响因素。当前的 AI Agent 对于被动结构化任务的处理 已有较为丰富的实践,但距离在复杂环境中扮演动态互动角色仍有一定的差距,我们认为 除了单个模块的能力提升,围绕 AI Agent 整体系统的优化或将成为 AI Agent 能力进一步提 升的重要驱动力。据【Agent AI Towards a Holistic Intelligence】,研究人员提出一个将大 型基础模型集成到 Agent 动作中的具体系统——Agent AI 系统,该系统强调 AI 作为有凝聚 力的整体发挥作用。按系统层级看,自下而上分别为数据-预训练模型-调优模型-任务-跨模 态-不可知的现实(新范式/物理世界/虚拟现实/元宇宙/涌现能力等)-整体智能。在数据端, 该系统强调利用不同环境之间的交互获取的跨模态数据,在系统端则结合了大型基础模型 对开放世界环境中感官信息的理解,最终 AI 展示了较好的跨学科、跨任务能力,涵盖了机 器人、游戏和医疗保健系统等新兴领域。长期看该路径或将逐步通向整体智能。

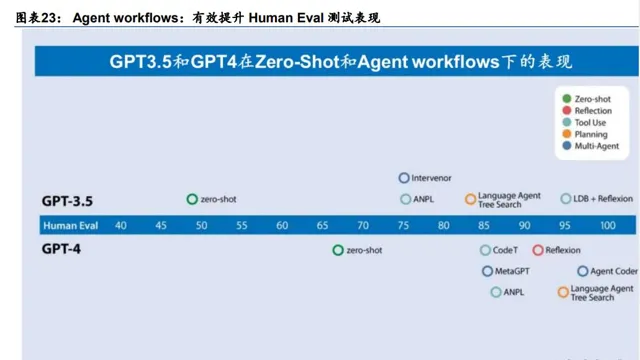

Agent Workflow 通过流程优化提升任务效果。2024 年 3 月,斯坦福大学吴恩达教授在博 客中提出在 HumanEval 数据集中,使用 GPT-3.5(Zero-shot)的测试正确率为 48.1%。 GPT-4(Zero-shot)为 67.0%。而通过与 Agent workflow 配合,GPT-3.5 实现了 95.1%的 正确率。在加入 Agent workflow 后,模型在具体任务中的能力有了明显的提升。Agent workflow 是一种新的工作流程,要求 LLM 多次迭代文档。从设计模式上,Agent 有四种模 式:1)Reflection(反思):让智能体审视和修正自己生成的输出;2)Tool Use(使用工具): LLM 被赋予 Web 搜索、代码执行或其他功能,以帮助它收集信息、采取行动或处理数据;3) Planning(规 划 ): 让 LLM 提出并执行一 个多步骤计划来实现目 标; 4) Multiagent collaboration(多智能体协作):多个智能体合作完成任务。我们认为 Agent Workflow 通过对 LLM 应用的流程优化,有助于提升 Agent 解决具体任务的准确性,LLM 应用端厂商有望借 鉴此方法推动更多垂类 LLM 落地。

AI Agent 技术逐步落地,智能性仍有提升空间

从 AI Agent 的落地方式看,基于 LLM 的 Agent 产品众多,但各自在自主程度,能力范围上 有一定差异。本节我们选取部分典型案例展开分析,具体包括: AutoGPT(2023.3)、卡 耐基梅隆大学智能 Agent 系统(2023.4)、Devin(2024.2)。

AutoGPT:利用 LLM 逐步拆解任务,外挂插件提升能力

AutoGPT 具备 AI Agent 的雏形。AutoGPT 是一个构建在 GPT-4 基础上的开源 Python 应 用程序,由视频游戏公司 Significant Gravitas Ltd 的创始人 Toran Bruce Richards 于 2023 年 3 月 30 日推出,其功能包括从互联网收集信息、存储数据、通过实例生成文本、访问各 种网站和平台以及使用 LLM 执行摘要的能力,常用于市场研究、网站创建、博客写作和创 建播客。从所需工具看,构建 AutoGPT 需要 Python(程序)、OpenAI API 密钥(大模型)、 Pinecone API 密钥(向量数据库产品)、Git(开放源码版本控制)、ElevenLabs API(可选 语音相关模块)。我们认为 AutoGPT 具备实现多种任务的能力,具备 AI Agent 的雏形。

利用 LLM 拆分任务。从实现功能的步骤看,AutoGPT 的构建分为:1)本地下载 Auto-GPT 项目及相关资源;2)输入 AI 名称、AI 角色以及最多 5 个目标;3)任务创建或排序:了解 目标,生成任务列表,并提及实现这些任务的步骤,审查任务顺序以确保其在逻辑上有意 义;4)任务执行:利用 GPT-4、互联网和其他资源来执行这些任务;5)生成结果:具体 结果形式包括 Thoughts(AI Agent 在完成动作后分享他们的想法)、Reasoning(解释了为 什么选择特定的行动方针)、Plan(该计划包括新的任务集)、Criticism(通过确定局限性或 担忧来批判性地审查选择),本质上是 ReAct(Reason+Act)的应用。从实现步骤看,人 类在其中给出基本的任务步骤后,AutoGPT 通过调用 LLM,实现对任务的理解与拆分。 LLM 分解任务受模型能力及数据的限制。AutoGPT 的能力范围仍然受到 Python 函数集能 力边界的限制,在搜索网络、管理内存、与文件交互、执行代码和生成图像等具备较丰富 可调用函数的领域效果较好,但对于更为复杂的任务处理能力有限。此外,LLM 在分解问 题的模式上较为固定,并且存在受到预训练数据和知识的限制,对于重复出现的子问题识 别能力不足等问题。

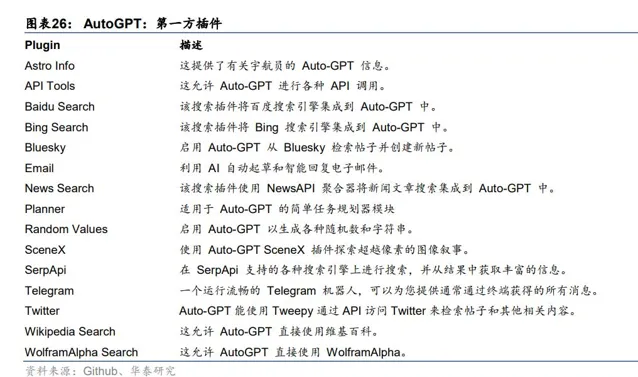

通过调用插件实现能力的扩展。2023 年 6 月 Auto-GPT 更新至 v0.4.1,AutoGPT 对于插件 的支持进一步强化,从插件的功能看,第一方插件主要功能包括信息检索(搜索引擎、新 闻、社媒、百科等)、任务规划、智能生成(邮件回复等)、API 调用等;第三方插件则实现 了对 AutoGPT 能力边界的进一步扩展,添加了交易、使用 AI 工具、数据库查询、功能集 成等。我们认为插件帮助 AutoGPT 进一步提升了用工具获取信息、加工信息的能力,使得 Agent 的能力边界得到进一步的延展。

卡耐基梅隆 Agent:利用 LLM 强化信息获取及工具使用

利用 LLM 强化搜索。2023 年 4 月卡耐基梅隆大学在论文【Emergent autonomous scientific research capabilities of large language models】中提出了一个智能代理系统,它结合了多 种大型语言模型,用于自主设计、规划和执行科学实验。其中利用 LLM 的模块包括「网页 搜索器」、「文档搜索器」,无需 LLM 的模块包括「代码执行器」、「自动化」,另有 Planner 模块用于协调各个细分模块。Planner 模块输出 Google 查询指令给网页搜索器、输出文档 查询指令给文档搜索器,进行文档的查找梳理,为执行部分提供所需的参数及文档信息, 最后由代码执行器、自动化模块进行实验。在此案例中,LLM 主要用于强化文档及互联网 知识的检索,实质上对具体任务的执行过程由搜索结果得到。

通过细分领域内容提升执行准确度。在本案例中,通过为文档搜索领域添加垂直领域内容 有助于提升执行的准确度。具体来看主要有两种方式,第一种是通过对指令进行编码并结 合向量搜索,对专门的 API 文档进行搜索与匹配,提升输入 Planner 的编码质量;另一种 方式是通过补充文档指南,提示使用专用工具的特定语言体系进行功能推荐。结合了专业 知识库及文档后,Agent 的知识范畴不再局限于大模型训练的语料,能够完成对具体工具的 正确使用。在本案例中,Agent 自动调整代码以应对专用软件包缺失、自动搜索说明文档调 整工具的效果,并完成了布洛芬的合成、阿司匹林合成、铃木反应研究、天冬氨酸合成。

Devin:利用 AI 实现自主编程

Devin利用 AI实现自主编程。2024年3月AI初创公司Cognition发布AI软件工程师Devin, Devin 可以规划和执行需要数千个决策的复杂工程任务,可在每一步都回忆起相关的上下文, 随着时间的推移学习,并纠正错误,此外 Devin 还可以与用户积极协作,实时报告其进度, 接受反馈,并根据需要与用户一起完成设计选择。研究人员在 SWE 基准上评估了 Devin, 要求代理解决 Django 和 scikit-learn 等开源项目中发现的现实 GitHub 问题。Devin 端到端 正确解决了 13.86%的问题,远远超过了之前 1.96%的最先进水平。Devin 没有得到帮助, 而所有其他模型在给出了要编辑的确切文件的条件下,以前最好的模型也只能解决 4.80% 的问题。

多种 AI 技术结合,Agent 形态初具。从技术方面,Devin 集成了机器学习、深度学习和自 然语言处理,以理解代码、从现有模式中学习并自主生成代码,并配备了自己的代码编辑 器、命令行和浏览器。从 Devin 的任务实现方式看,主要分为几个步骤:1)理解用户意图, 通过 LLM 等 NLP 技术分析用户的自然语言描述,提取关键功能和要求,将用户分解为任务 清单;2)自主学习专业材料(如 API 文档、开源库、源码),掌握代码结构,LLM 技术可 用于加强对专业材料的理解能力,代码结构的模式识别与匹配则可以通过机器学习模型强 化;3)生成代码并根据用户的提示调 Bug。我们认为从实现方式看,对于现有文档的学习 与实践,已经初步具备 Agent 的形态,未来随着模型能力的进一步提升,Agent 在细分领 域的能力有望进一步提升。

AI Agent:智能性仍有提升空间,关注 Agent Workflow

模型架构突破+特定数据推动 LLM Agent 能力突破。从 AI Agent 的落地方式看,基于 LLM 的 Agent 实践已经取得一定的成果。具体包括:1)利用 LLM 较强的文本处理能力,实现 了信息检索及工具使用效率的提升;2)利用 LLM 的任务分解能力,实现了简单问题的步 骤分解与规划;3)利用 LLM 的文本生成能力,打造更加自然的人机交互;4)利用 LLM 的可调试性,打造能够解决垂直领域任务或具备垂直领域知识体系的应用。以上能力突破 的基础一方面来自于 Transformer 架构下,LLM 能力相比传统 NLP 方法的效率提升,如更 加自然的人机交互、更强的文本处理能力;另一方面则来自于特定数据类型训练赋予 LLM 的能力,如从任务分解数据训练中得到的任务规划能力、配置特定文件后得到的解决特定 领域问题的能力。

LLM Agent 自主化、智能性仍存在提升空间。从 LLM Agent 的实践看,当前的 LLM Agent 对于执行特定领域的任务已经体现出一定的自主性(如完成科学试验、搜索资料撰写报告 等),LLM 对于固定范式下解决问题能够实现较好的自动化,但在解决问题的泛化能力方面, 当前主要的 Agent 产品仍距离通用的 Agent 有一定的差距。主要体现在:1)任务规划方面: 当前 Agent 主要基于现有的成熟任务流程进行复现,或基于训练数据对任务进行简单的拆 分;2)工具使用方面:当前 Agent 基本按照人类的部署进行流程化的操作和尝试,工具的 使用主要通过调用第三方 API 进行。未来随着底层模型能力的提升。我们认为 AI Agent 有 望在以下方面实现能力提升:1)在任务规划方面从基于规则、参数的规划能力逐步向基于 实践的反思、迭代进化;2)在工具使用与选择方面,从基于人类配置的特定工具,向多种 工具的选择规划进化,甚至更进一步的创造适用于 LLM 的工具。

模型&MaaS 厂商:凭丰富工具&实践经验把握发展机遇

MaaS 厂商侧重 2B 业务场景:2B 提供落地工具+2D 提供开发框架

面向 2B 市场,MaaS 厂商不断完善 Agent 落地工具。大模型厂商与 MaaS 厂商合作,共 同为 B 端客户提供基于大模型的产品,其中大模型厂商推动底层模型的能力升级,MaaS 巨头则凭借良好的产品、客户基础,提供相应的开发及定制化工具,帮助 B 端客户打造基 于大模型的业务应用。其中较有代表性的厂商为微软、Amazon、Google。我们认为 MaaS 厂商通过云服务实现了基础软件层面的良好卡位,而 AI Agent 在 B 端落地及 D 端开发的过 程中多需要数据的调用及算力的支撑,MaaS 厂商凭此前的良好卡位实现了业务的延伸,通 过提供落地工具和开发框架,成为 AI Agent 市场的重要参与者,也有望首先受益于底层大 模型能力突破带来的 AI Agent 发展机遇。

2B:基于业务卡位,提供落地工具

Microsoft Copilot Studio 新增智能 Copilot 功能。在 Microsoft Build 2024 上,微软发布 Microsoft Copilot Studio 新功能,让开发者能根据特定任务和功能,构建主动响应数据和事 件的「智能 Copilot」。基于这类新功能的「智能 Copilot」可通过记忆和知识了解上下文、 推理操作和输入,基于用户反馈进行学习,并在不知道如何处理时寻求帮助,从而独立管 理复杂、长期运行的业务流程。在技术架构上,通过 Instructions(指令)+Triggers(动机) +Knowledge(知识)+Actions(行动)的流程,实现 AI 的自动化应用。此外包括插件和连 接器在内的智能 Copilot 扩展,允许客户通过将其连接到新的数据源和应用程序来增强 Microsoft Copilot 智能副驾驶,从而扩展其功能。此外,智能 Copilot 还可通过反馈不断改 善。微软通过在 2B 定制化工具 Microsoft Copilot Studio 中提供智能 Copilot,实现了 AI 与 工作流的初步结合,打造了垂直场景中 AI 的自动化应用。

在 IT、人力、营销等应用场景下实现 AI+自动化。从设备采购到销售和服务的客户接待, 用户都可以让基于 Microsoft Copilot Studio 构建的智能副驾驶为其工作。例如:1)IT 帮 助台。IT 支持涉及工单、订单号、批准和库存水平,Copilot 与 IT 服务管理应用程序交互, 根据上下文和记忆解决 IT 工单,创建设备更新的采购订单,以及联系经理并获得批准;2) 员工入职。Copilot 会迎接新员工,解释人力资源数据,并回答问题。它会向新员工介绍伙 伴,提供培训和截止日期,协助填写表格,并安排第一周的会议,指导新员工完成为期数 周的入职和帐户设置流程;3)销售和服务的私人礼宾服务。可利用与客人之前对话的记忆 来记住客人的偏好、进行预订、处理投诉并回答与所提供的产品和服务相关的问题。Copilot 从互动中学习并提出处理客户场景的新方法。

Amazon:通过 Bedrock 提供 Agents 相关功能。在模型个性化方面,借助 Agents for Amazon Bedrock,用户可以通过简单的几个步骤创建和部署完全托管式的 Agent,通过动 态调用 API 来执行复杂的业务任务。Amazon Bedrock 可以根据用户提供的自然语言指令, 如「你是专门处理未结理赔的保险代理人」,完成任务所需的 API 架构,并使用来自知识 库的私有数据来源详细信息创建提示语。Agents for Amazon Bedrock 可将用户请求的任务 分解为较小的子任务,Agent 会确定正确的任务顺序,并处理中途出现的错误状况。

Amazon Bedrock Agent 与 Amazon 产品产生良好协同。Amazon 在云服务领域具备良好 的产品积累,一方面,Agent 产品与 Amazon 原有基础软硬件产品能够实现良好的协同, 在向量数据存取方面推出 Amazon OpenSearch Serverless 服务,帮助个性化数据与 AI 实 现良好整合、在应用端推动 AI 与 Amazon QuickSight 等应用的结合;另一方面,Agent 工 具与公司本身业务系统能够实现良好的整合。如 Agent 能够和知识库协同工作,从而实现 任务编排、交互式数据收集、任务旅行、调用 API、数据查询、来源归因等任务。通过检索 增强生成,能从用户选择的相应知识库中查找信息,并提供回复。得益于 Amazon 在基础 层的良好基础,Agent 具备较好的可控性,能够实现追踪思维链推理、自定义操作架构,并 在 Agent 调用操作时重新获得控制权等功能,能够在所选的后端服务中实现业务逻辑。能 够在后台执行耗时的操作(异步执行),同时继续编排流程。

2D:提供开发框架,卡位开发者场景

面向 2D 市场,MaaS 厂商提供底层的开发框架。如微软 AutoGen 框架,支持使用多个代 理来开发 LLM 应用程序,这些代理可以相互对话来解决任务。AutoGen 代理是可定制的、 可对话的,并且无缝地允许人类参与。他们可以采用 LLM、人力输入和工具组合的各种模 式运作。AutoGen 可用于定义代理交互行为,开发人员可以使用自然语言和计算机代码为 不同的应用程序编写灵活的对话模式。通过自动化多个语言模型代理之间的聊天,开发人 员可以轻松地让他们自主或根据人工反馈共同执行任务,包括需要通过代码使用工具的任 务。 AutoGen 提供多代理会话框架作为高级抽象,使用此框架可以方便地构建大语言模型 工作流程。同时,AutoGen 还提供一系列工作系统,涵盖了来自各个领域的广泛应用,包 括自动翻译、自动摘要、智能建议等。 AutoGen 还支持增强型大语言模型推理 API,可用 于提高推理性能并降低成本。

模型厂商落地:GPTs 通过配置实现定制化,打造 LLM 垂直领域助手

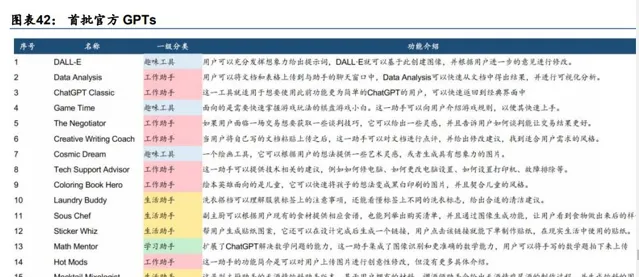

三大功能打造定制 GPT。GPTs 是为特定目的创建的 ChatGPT 的自定义版本,由 OpenAI 于 2023 年 11 月推出。在构建方式上,GPTs 通过提供 Instructions、Expanded knowledge、 Actions 三大能力,优化应用的个性化、垂直化、融合化能力。1)Instructions:用户可在 Configure 界面手动补充希望 GPT 应用实现的个性化能力;2)Expanded knowledge:用 户可在 Configure 界面上传额外的文件作为应用的知识参考,打造符合垂直场景、具备专业 知识的垂类应用;3)Actions:用户可额外添加 ChatGPT 与其它应用程序的连接,进一步 实现模态融合与应用融合。此外在配置选项卡中还可以进行自定义操作,即可以通过提供 有关端点、参数的详细信息以及模型应如何使用它的描述,实现对第三方 API 的调用。

GPTs 具备垂直化、多模态、开放性特点。OpenAI 官方推出 16 个 GPTs 应用,涵盖工作、 学习、生活、体验四大应用场景。配置了特定的文件后 GPTs 能力边界得到拓展,可用于 为使用者提供棋盘游戏介绍、数学题指导等,载入多模态模块后的 GPTs,能够生成贴纸、 绘本等图片。第三方 GPTs 则包括工作助手、学习助手、生活助手、趣味工具等。从落地 产品特点上,我们认为 GPTs 具备垂直化、多模态、开放性的特点。垂直化指应用多基于 垂直场景的知识基础(特定 IP、特定领域知识等);多模态指应用结合了文本、图像、音频、 视频等多种模态,提供了丰富的呈现方式;开放性指在应用的开发上门槛较低,用户可通 过简单的配置实现特定领域 GPTs 的开发。

应用厂商:具备垂直数据与工程化优势,关注工作流卡位

与工作流结合,推动 Agent 落地——以 Servicenow 为例

Servicenow:具备覆盖多个工作流的业务基础。ServiceNow 主要产品 now 平台。公司基 于统一的 Now 平台为客户提供工作流的自动化和数字化解决方案。其中技术工作流 (Technology)包括 IT 服务管理、IT 运营管理、IT 资产管理、安全运营、集成风险管理、 战略投资组合管理、ServiceNow 云可观测性等。客户和行业(Customer and Industry)及 员工工作流(Employee)包括客户服务管理、现场服务管理、人力资源服务交付、工作场 所服务交付、法律服务交付等。创建者工作流(Creator)和其他包括应用程序引擎、自动 化引擎、平台基础、源到支付操作等。Now 平台实现了对客户多领域工作流的覆盖,为 Agent 的落地打下了良好的基础。

Now assist:AI 重要应用,场景不断扩展。23Q3 公司在 Now 平台中加入了 Now Assist (AI 助手)功能,发布 Now Assist for Search(从客户环境中提取信息,实现加强搜索, 精准回答)等产品。Now 平台的更新便于客户在工作流中集成 AI 能力,相关功能在 ITSM、 HR、客户服务和 Creator 四条产品线中投入使用。23Q4 公司发布新功能 Now Assist in Virtual Agent,该产品通过高级对话式 AI 聊天加快了问题解决速度;Now Assist for Field Service Management 通过帮助技术人员在首次访问中完成工作、识别必要的设备、提供维 修建议并自动快速跟进,降低成本。

结合行业方案,打造 Agent 深入应用。ServiceNow 推出针对电信行业的生成式 AI 解决方 案 Now Assist for Telecommunications Service Management(TSM),它基于 Now 平台构 建。在产品特性上,TSM 具备如下特征:1)提供主动体验。快速识别并解决问题。为客户 提供自助服务工具,让他们自行学习、进行更改和解决问题。2)自动解决问题。让客户了 解当前的中断以及如何解决这些中断。3)利用 AIOps 和机器学习自动化和优化运营工作流, 以提高整个组织的效率并降低成本。我们认为深化行业应用有助于 Agent 在垂直领域打造 标杆应用。未来企业的工作流或以 gen AI 为核心进行设计,随着实时数据打通、系统集成 度进一步提升,自然语言或在部分场景中取代代码成为新的业务流程构建方式。

基于私有数据,打造智能应用——以 Salesforce 为例

基于私有数据,打造垂直领域智能应用。除了在原有系统中的工作流基础,垂直业务数据 也是应用厂商打造 Agent 应用的重要优势。以 Salesforce 为例,其在营销销售等领域具备 较好的业务数据基础。基于此公司打造了适用于 CRM 的对话式 AI,特色是以客户的公司 数据为基础。从产品布局看,2023 年 3 月公司发布 AI 应用 Einstein GPT,首次将生成式 AI 应用到客户关系管理领域;2023 年 9 月发布 Einstein 1 平台(核心包括 AI 助手 Einstein Copilot),并与新的 Data Cloud 原生集成,客户可以通过 Data Cloud 和 Tableau 接收、协 调和探索数据,将数据的力量扩展到每个业务领域,为 AI 应用打造了良好的数据基础。

通过扩展设置将 AI 嵌入工作流中。Einstein Copilot 可以通过扩展与原有工作流结合,可通 过创建调用流程、Apex 代码、提示和 MuleSoft API 的自定义操作来扩展 AI 助手的功能, 为 Copilot 提供精确的指示,以无缝执行任务并快速完成工作。具体包括:1)对话:向 AI 助手提问并给出指示。获得清晰、可信且可操作的答复;2)操作:使用现成的操作查询并 汇总 Salesforce 中的记录。根据独特的业务需求创建自定义操作,提取相关数据;3)规划 师:生成并执行基于来自 CRM、数据云或外部来源的业务数据的一组指导性操作;4)分 析:使用全面的仪表板监控和改进 Copilot,以获得诸如采用率、参与度和行动可用性等关 键绩效指标。

终端厂商:推动人机交互升级,率先实现 Agent 落地

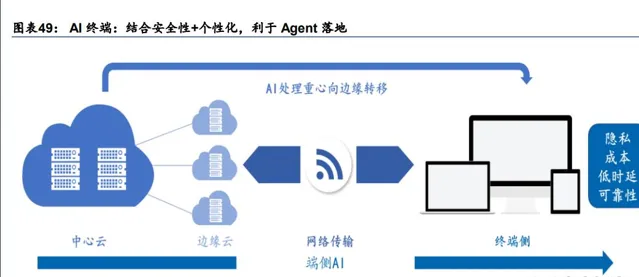

AI+终端:结合安全性+个性化,为 Agent 落地打下良好基础。垂直数据有助于 Agent 形成 个性化的能力,AI 部署于终端有助于实现个性化和安全性的良好结合。以 AIPC 为例,通 过 AI 能力的本地化部署,使 PC 拥有持续学习能力、提供个性化并保护用户隐私的服务、 配备知识库适应用户需求以及可自然交互。AIPC 能够根据用户使用习惯、行为和喜好进行 自适应和优化为用户在操作过程中提供更多的个性化建议和支持。AIPC 在终端侧进行运算, 能够提供更多的情境信息,如用户的移动状态、个人偏好和设备上的多媒体信息。基于终 端的本地数据,Agent 能够提供更加个性化的服务,本地处理也有助于保障数据的安全性, 综上,我们认为终端 AI 能力的加强有利于 Agent 落地加速。

智能手机:Siri 为 Apple Intelligence 重要交互入口。在智能手机领域,语音交互助手为 AI 重要的人机交互入口,有望成为 Agent 落地 C 端的重要场景。据 Apple WWDC,Siri 用 户每天发出的语音请求数量高达 15 亿次。在 Apple Intelligence 的支持下,更加智能和自 然,并且除了语音,也加入了文字交互能力。1)Siri 目前具有更好的语言理解能力,即使 表述不清或者多次表述,Siri 也能识别用户意图。2)Siri 也能做「视觉推理」,Apple 称之 为「屏幕感知」,可以理解屏幕上的内容并对其采取行动。3)Siri 能在保障隐私情况下,利 用用户设备上信息的了解来帮助找到正在寻找的内容,如短信、邮件。4)在应用程序内和 跨应用程序无缝地执行操作。例如美化照片后,将照片放到备忘录的某条记事中。未来随 着 Siri 逐步接入多步骤任务处理等功能,有望推动智能手机端 Agent 的落地。

端侧模型发展有助于 Agent 落地终端。以 Apple Intelligence 为例,其中基础模型进行各种 下游任务微调,得到适合不同下游任务的一组独立模型;通过 Adapter 微调方法,得到模 型权重的小集合,叠加在公共基础模型上,让基础模型能够选择需要的能力;最后通过压 缩模型到适合端侧的大小,使用优化算法加速推理,实现在端侧落地。对比 Agent 的技术 架构,往往也需要基础模型和小模型的共同支撑,我们认为端侧模型技术的发展(模型压 缩等技术)有助于 Agent 落地于终端。

总结:从 AI Agent 有望逐步通向 AGI

基础模型能力提升+工作流接入有望加快 AI Agent 商业化。从 Agent 的发展看,人类在逐 步强化程序的自动化、智能化程度。在 AI Agent 的尝试中,应用厂商结合深度学习等算法、 知识图谱、RPA 等技术实现了部分的自动化,其核心是在存量知识的基础上,实现由程序 自主解决部分问题。LLM 的出现是这一框架下的重要突破,LLM 通过预训练吸收知识,以 大量参数存储知识,通过 Transformer 的注意力机制,实现了对存量知识吸收理解效率的进 一步提升。在解决问题的过程中,相较于传统的 RPA 等基于规则的自动化方式,体现出了 更强的灵活性。我们认为随着基础模型能力的进一步提升,AI Agent 在任务规划中的灵活 性、在知识吸收运用的效率方面的上限或将进一步提升。在当前的基础模型能力下,若将 AI Agent 与工作流进一步结合,在工作流程中嵌入 AI Agent 实现部分问题的智能+自动化解 决,AI Agent 实用性或将进一步改善,商业化或进一步加速。

从 LLM 到 AI Agent 到 AGI。据【On the Principles of Parsimony and Self-Consistency for the Emergence of Intelligence】(2022),智能的原则包括简约性、自洽性。其中简约性要 求要求系统通过计算有效的方式来获得紧凑和结构化的表示,自洽性要求自主智能系统通 过最小化被观察者和再生者之间的内部差异来寻求最自洽的模型来观察外部世界。我们认 为 LLM 以黑盒的方式实现了知识的高效吸收,通过人类对齐实现了自洽性;基于 LLM 的 AI Agent 在 LLM 基础上能够通过工作流方式引入人类对齐实现自洽,通过垂直数据强化特 定领域的知识能力;而随着知识压缩的效率的进一步提升(Scaling Laws 或白盒大模型等 方式),打造闭环系统完成对知识的验证,未来有望逐步实现 AGI。

(本文仅供参考,不代表我们的任何投资建议。如需使用相关信息,请参阅报告原文。)

精选报告来源:【未来智库】。