1. 引言

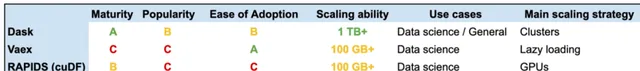

还记得那次处理一个10GB的CSV数据集时的经历吗?pandas加载时内存告警,电脑差点死机。这种情况想必很多数据分析师都遇到过。而今天要介绍的Vaex库,就是专门为解决大数据处理而生的Python库,它能让你像使用pandas一样优雅地处理TB级别的数据集。

2. 安装和配置

安装Vaex非常简单,只需要一行命令:

pip install vaex

如果你想要完整的功能支持,可以安装完整版:

pip install ‘vaex[complete]’

值得注意的是,Vaex支持Python 3.7及以上版本。在Windows系统上,建议使用Anaconda环境进行安装,可以避免一些依赖问题。

3. 核心特性

Vaex最令人惊叹的特性是它的内存效率。让我们通过一个简单的例子来感受一下:import vaex import pandas as pd

# pandas读取大文件df_pandas = pd.read_csv('large_file.csv') # 可能会导致内存溢出# vaex读取同样的文件df_vaex = vaex.from_csv('large_file.csv') # 几乎不占用额外内存

Vaex采用了内存映射(memory mapping)技术,这意味着它不会一次性将所有数据加载到内存中,而是根据需要按需加载。Vaex还提供了类似pandas的API,让我们可以轻松进行数据操作:# 基本统计操作 mean_value = df_vaex.column_name.mean() std_value = df_vaex.column_name.std()

# 数据筛选filtered_df = df_vaex[df_vaex.column_name > 100]# 分组统计result = df_vaex.groupby('category').agg({'value': 'mean'})

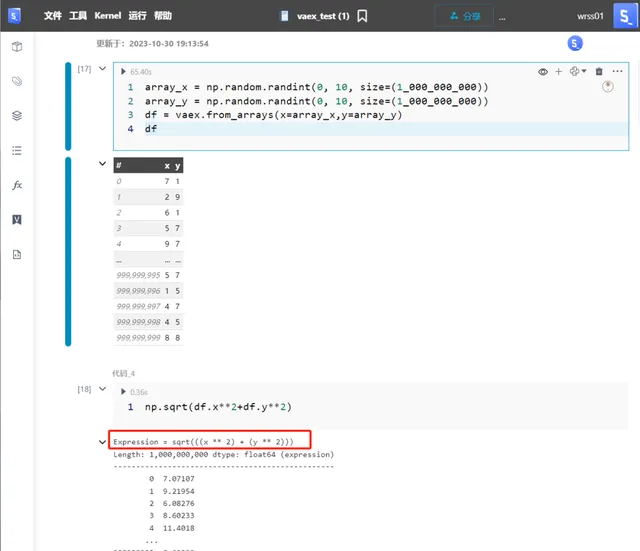

4. 进阶技巧

Vaex的真正威力在于它的延迟计算(lazy evaluation)特性。它会先构建计算图,只有在真正需要结果时才会执行计算:# 定义一系列操作 df_vaex[‘new_column’] = df_vaex.column_1 * 2 filtered = df_vaex[df_vaex.new_column > 100] grouped = filtered.groupby(‘category’)

# 直到这一步才真正执行计算result = grouped.agg({'new_column': 'mean'}).execute()

另一个强大的特性是它的可视化能力。Vaex可以直接处理上百万个数据点的散点图,而不会卡顿:# 创建包含百万数据点的散点图 df_vaex.plot(df_vaex.x, df_vaex.y, limits=‘99.9%’)

5. 实战案例

假设我们需要分析一个电商平台的用户行为数据:# 读取用户行为数据 df = vaex.from_csv(‘user_behaviors.csv’)

# 计算每个用户的购买频率purchase_freq = df.groupby('user_id').agg({ 'purchase_amount': ['count', 'sum', 'mean']})# 找出高价值用户high_value_users = purchase_freq[ (purchase_freq['purchase_amount_mean'] > 1000) & (purchase_freq['purchase_amount_count'] > 10)]

6. 总结与展望

Vaex的优势在于:

- 超高的内存效率,可处理TB级数据

- 类pandas的API,学习成本低

- 优秀的性能表现,支持并行计算

- 强大的可视化能力

不过也存在一些限制,比如功能相比pandas还不够完善,社区相对较小。但对于大数据处理场景,Vaex绝对是一个不可多忽视的选择。

如果你经常需要处理大规模数据集,或者厌倦了pandas处理大文件时的内存警告,不妨试试Vaex。它可能会成为你的新宠工具。

随着大数据时代的到来,Vaex这样的工具必将发挥越来越重要的作用。期待这个库能在未来得到更多关注和发展,为Python数据处理生态贡献更多力量。