(一)GPT-5 引关注

近期,关于 GPT-5 的传闻可谓此起彼伏。多个渠道消息显示,OpenAI 计划于 12 月推出其下一代模型,代号可能为 Orion,也就是众人所期待的 GPT-5。有研究人员表示,使用「合成数据」训练的 Orion 与之前的模型相比,会减少幻觉的产生。OpenAI 的一位高管曾表示,Orion 性能可能是 GPT-4 的 100 倍。9 月,知情人士透露,OpenAI 的研究人员为庆祝完成新模型的训练,举办了一次欢乐的庆祝活动。OpenAI CEO 奥特曼在 X 上发帖称,「期待冬季星座即将升起」,而猎户座恰好是冬季星座,这进一步引发了人们对 GPT-5 即将到来的猜测。然而,奥特曼随后回应称 GPT-5 将于 12 月发布的传言为「假新闻失控」,但他的回应并非直接否认,这让 GPT-5 的发布更加扑朔迷离。

(二)Claude 3.5 大升级

Anthropic 对 Claude 3.5 进行了重磅升级。Claude 3.5 Sonnet 不仅编程能力更强,还带来全新功能 computer use(计算机使用)。它可以遵循用户的命令在计算机屏幕上移动光标,点击相关位置,并通过虚拟键盘输入信息,模拟人们与自己计算机的交互方式。在 OSWorld 评估中,Claude 3.5 Sonnet 获得了 14.9%的分数,虽远低于人类水平的 70 - 75%,但远高于同类 AI 模型的 7.7%。在编码能力方面,它在 SWE-bench Verified 测试中,性能从 33.4%大幅提升至 49.0%,超越了所有公开可用的模型。Claude 3.5 Sonnet 的发布标志着 Anthropic 在商业 AI 模型领域的一项重要进展,它为用户带来了全新的人机交互范式,让人们对未来的 AI 发展充满期待。然而,Claude 的操作仍相对缓慢且容易出错,如拖拽、缩放等日常操作尚无法实现,且观察屏幕的方式可能会错过短暂的动作或通知。尽管如此,AI 操作电脑的能力代表了一种全新的人工智能开发方法,未来有望使软件开发等任务变得更加简单。

二、技术突破亮点多

(一)仿生机器人登场

波兰的 Clone Robotics 公司推出的仿生机器人 Torso 可谓是技术创新的典范。这款机器人采用人造肌肉技术,能够模拟人体动作,为仿生机器人技术树立了新的标杆。

Torso 的人造肌肉技术具有诸多特点。首先,它的外观独特,裸露的线犹如肌肉纹路,布满两只胳膊,再加上碳纤维制成的胸腔和没有五官的脑袋,给人一种怪异的美感。其次,它的动作灵活多样。脑袋可以上下左右转动,肩膀到指尖的每个关节都能活动,能做出抱拳、跳机械舞等动作。

Torso 的手部设计也十分精妙。名为 Clone Hand 的机械手是世界上最接近人类肌肉骨骼结构的机械手,由特制的液压肌肉和阀门驱动。它有 24 个可以动的地方,能像人的手指和手腕那样弯曲和转动,大小和形状也跟人手别无二致。所用材料是公司自研的一种聚合物,比金属轻但更结实柔软。手里面装了 37 条特殊的肌肉,收缩起来只需 0.3 秒,可以快速灵活地做动作,还能轻松拿起至少 12 公斤重的杠铃。

Torso 的动力系统也别具一格。它采用电液泵和能存水的容器作为动力来源,电液泵就像人的心脏一样,为肌肉提供动力。每个手臂还配有独立的电液阀门系统,可以精确控制力量和流量。电池藏在机器人的肚子里,为其长时间工作提供电力。

(二)动作捕捉工具革新

Runway 推出的 AI 视频生成工具 Act-One 为视频创作带来了革命性的变革。

Act-One 功能允许用户通过简单的输入,快速生成具有丰富表情的角色动画。它通过降低技术门槛,使得更多创作者能够探索新的故事叙述形式和艺术表达方式,在独立电影制作和数字媒体领域具有革新意义。

在面部表情捕捉方面,Act-One 表现出色。用户能够使用任何视频摄像头,包括内置于智能手机中的摄像头,来录制自己或演员的面部表情,随后这些表情将以极高的精确度被映射到 AI 生成的角色上,实现了前所未有的真实感。

Act-One 极大地简化了动画制作过程。传统上,制作面部动画涉及到动作捕捉设备、手工面部绑定和多角度的参考影像,非常复杂繁琐。而 Act-One 让用户只需提供一段简单的视频,就能将表演中的各个细节转移到一个或多个风格迥异的 AI 生成角色之上。

Act-One 在各种摄像机角度下都能呈现电影级的真实感。它能够精准捕捉演员在复杂场景中的情感深度和独特的表演风格,即使是最微妙的神态和动作也不放过,为创作者提供了更多的叙事可能。

Act-One 开启了更广阔的视频叙事能力。仅需一台普通的消费级相机,一位演员就能够表演多个不同的角色,为独立电影和数字媒体领域的创作者提供了前所未有的便利。

三、工具创新展实力

(一)语音定制新功能

Elevenlabs 推出的语音定制工具 Voice Design 为用户带来了全新的音频创作体验。这款工具允许用户通过简单的文本提示自定义生成独特的语音,开创了 AI 配音领域的新纪元。

用户只需描述所需声音的特征,如「温暖友好的中年女性声音,带着轻微英国口音」,系统便能快速生成符合要求的语音。Voice Design 支持调节多个语音参数,包括年龄、性别、口音、语调和音高等,确保生成的声音精确匹配用户需求。

除了模拟真实人声,Voice Design 还突破性地支持创作角色化语音。无论是精灵的空灵之音,还是机器人的金属音效,系统都能准确捕捉并还原这些虚拟角色的声音特征。用户可以反复调整参数,探索无限的创作可能,为游戏开发、有声内容制作等领域提供了强大的创意工具。

Elevenlabs 成立于 2022 年,创始人是一对好友:前谷歌机器学习工程师 Piotr Dabkowski 和前 Palantir 部署策略师 Mati Staniszewski。作为一家基于浏览器的语音生成应用,Elevenlabs 能够创建逼真的语音,并可调整语调、情感、节奏等关键声音特征。2024 年 1 月,Elevenlabs 在最新一轮融资中成功筹集了 8000 万美元,使其估值急速飙升至 11 亿美元,正式跻身独角兽行列,并入选福布斯 AI 50 强,跻身全球最具创新力的科技公司行列。

(二)视频生成新模型

Genmo 发布的视频生成模型 Mochi 1 是开源视频生成领域的重大突破。Mochi 1 采用创新的 Asymmetric Diffusion Transformer(AsymmDiT)架构,拥有高达 100 亿个参数,是迄今为止公开发布的最大视频生成模型。

Mochi 1 的最大亮点在于其卓越的运动质量和对文本提示的精准遵循。它能够生成长达 5.4 秒、帧率高达 30 帧/秒的流畅视频,其时间连贯性和逼真的运动动态令人惊叹。Mochi 1 还能模拟各种物理现象,例如流体动力学、毛发模拟等,其生成的人物动作自然流畅,几乎可以媲美真人表演。

为了方便开发者使用,Genmo 还开源了其视频 VAE,可以将视频压缩到原始大小的 1/128,有效降低了模型的计算量和内存需求。AsymmDiT 架构则通过多模态自注意力机制,高效处理用户提示和压缩视频标记,并为每种模态学习单独的 MLP 层,进一步提升了模型的效率和性能。

Mochi 1 的发布,标志着开源视频生成领域迈出了重要一步。Genmo 公司表示,他们将在年底之前发布 Mochi 1 的完整版本,包括支持 720p 视频生成的 Mochi 1HD,届时视频的保真度和流畅度将进一步提升。为了让更多人体验 Mochi 1 的强大功能,Genmo 还推出了免费的托管游乐场,用户可以在

genmo.ai/play

上进行体验。Mochi 1 的权重和架构也已在 HuggingFace 平台上公开,供开发者下载使用。

四、巨头发力促发展

(一)苹果发布新芯片

苹果公司发布的新款 AI 芯片 M4,在提升设备上的机器学习任务性能方面表现出色。M4 芯片采用 3 纳米制造技术,集成了 10 核 CPU、10 核 GPU 和一个神经引擎。其核心数量的增加和 GPU 架构的改进,为 iPad 平台带来了硬件加速的网格着色、光线追踪和动态缓存技术,极大提升了游戏和渲染任务的性能。在衡量 NPU 性能的 TOPS(每秒万亿次操作)指标上,M4 芯片达到了 38TOPS,远超市场上的其他竞争者。

M4 芯片的推出,伴随着新款 iPad Pro 系列的发布,预计将显著提升设备的性能和电池续航能力。这款价格亲民的设备,以其低于 1000 美元的售价,有望成为市面上最强大的 AI 设备之一。苹果对 M4 芯片的展示中,其视频编辑特性尤为突出,如即时在 4K 视频中分离对象或背景的能力,展示了其在 AI 领域的深厚积累。

(二)Adobe 推新工具

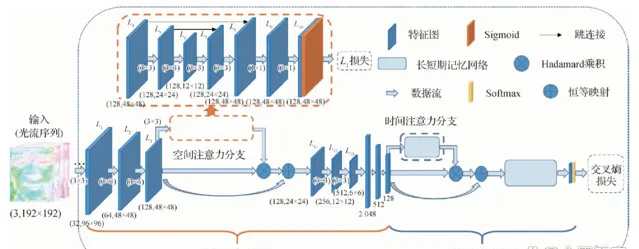

Adobe 发布的 VideoGigaGAN 是一项基于人工智能的视频超分辨率技术,能够将视频清晰度提高八倍,且显著减少了伪影的出现。该技术基于名为 GigaGAN 的大型图像上采样器构建,结合了「时间注意力」机制、特征传播、抗锯齿技术以及「HF 穿梭」(高频特征穿梭)技术,以创造出最终的高质量视频。

如果 Adobe 将 VideoGigaGAN 技术集成到其专业的视频编辑软件如 Premiere Pro 或 After Effects 中,这将使视频制作者能够显著提升低分辨率镜头的视觉效果。尽管目前 VideoGigaGAN 技术生成的剪辑仍然较短且播放速度有限(12fps),但这并不妨碍它成为未来视频处理技术的一大突破。

(三)Meta 开源新模型

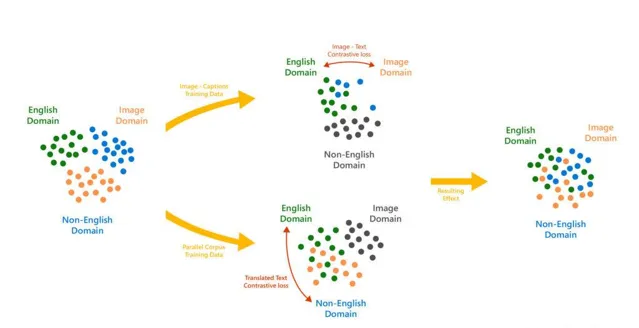

Meta 公司发布的开源模型 V-JEPA 为 AI 的发展提供了新的方向。V-JEPA 是一种从视频中学习表示的自我监督方法,可以应用于各种视频、图像任务,而无需调整模型参数。在图像分类、动作分类和时空动作检测任务的冻结评估中,V-JEPA 超越了之前的视频表示学习方法。

V-JEPA 的核心技术思路是,通过 Transformer 架构对视频序列进行编码,利用遮蔽自编码框架学习视频的关键特征表示。再通过基于查询的特征池化模块提取与任务相关的重要特征,最终通过联合嵌入预测架构进行特征预测任务,以学习视频中不同时间步骤之间的语义关系。

V-JEPA 模型中的「V」代表的是 Video 的意思,现阶段主要用于视频领域。但 Meta 表示,下一步将会把 V-JEPA 与音频相结合使用,并且可以充当早期的物理世界模拟器使用。

(四)OpenAI 新能力

OpenAI 为其流行的聊天模型 ChatGPT 增加了图像编辑能力,使用户能够通过文本指令编辑和生成图像,进一步扩展了 AI 的应用范围。用户可以通过画笔涂抹要添加、移除或改变的对象区域,然后告诉 ChatGPT 要改动的内容,支持中文对话。如果不使用画笔直接让 ChatGPT 修改会生成全新的图像,某些场景好用,比如换个风格。

此外,ChatGPT 还可以对整个图片的风格进行快速调整,例如将图片变成卡通风格或油画风格。如果在 ChatGPT 网页端没有 P 图功能可以先使用 APP 图,然后回到网页刷新就有了。目前 DALL·E 3 的图片编辑功能只能在 PC 端使用,未来会扩展至移动端或其他平台。二次修改的图片没有自动保存功能,修改完毕后用户需要自行下载,也无法保存历史记录。

五、AI 未来前景阔

本周的 AI 大事充分展示了该领域技术的快速发展态势,为未来多领域带来了巨大的影响和潜力。

从语言模型的新动向来看,无论是 GPT-5 的备受期待,还是 Claude 3.5 的重大升级,都预示着自然语言处理能力将不断提升。这些先进的语言模型不仅能够更好地理解和生成人类语言,还在编程等专业领域展现出强大的实力,为软件开发、知识管理等领域带来新的机遇。未来,随着语言模型的不断进化,我们可以期待更加智能、高效的人机交互,以及在教育、金融、医疗等领域的广泛应用。

技术突破方面,仿生机器人 Torso 的推出和动作捕捉工具 Act-One 的革新,彰显了 AI 在机器人技术和视频创作领域的巨大潜力。仿生机器人的发展将为制造业、医疗保健、科学研究等领域提供更强大的工具和解决方案。而动作捕捉工具的进步则将推动影视、游戏、广告等行业的创新发展,为创作者提供更多的可能性。

工具创新方面,语音定制功能和视频生成新模型的出现,为音频创作和视频制作带来了全新的体验。语音定制工具 Voice Design 使得用户能够轻松创建独特的语音,为有声书、游戏配音等领域提供了强大的创意工具。视频生成模型 Mochi 1 的开源则为视频制作行业带来了新的活力,降低了制作成本,提高了制作效率。

巨头发力方面,苹果的新芯片 M4、Adobe 的新工具 VideoGigaGAN、Meta 的开源新模型 V-JEPA 以及 OpenAI 的新能力,都展示了科技巨头在 AI 领域的积极布局和创新精神。这些举措将进一步推动 AI 技术在移动设备、视频编辑、人工智能研究等领域的发展,为用户带来更强大的功能和更好的体验。

总之,本周的 AI 大事为我们展示了一个充满活力和创新的领域。随着技术的不断进步,AI 未来在各个领域的应用前景将更加广阔。它将为我们的生活带来更多的便利和创新,推动社会的进步和发展。同时,我们也需要关注 AI 技术发展带来的挑战,如伦理道德、法律法规等问题,确保 AI 技术的健康、可持续发展。