打破壟斷並不容易。

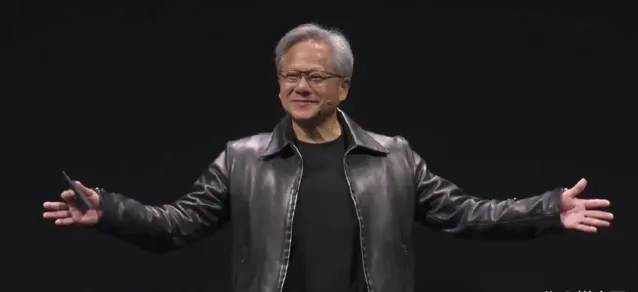

2022年11月底,ChatGPT的出現,不僅一把火點燃了生成式 AI 的浪潮,同時還將GPU巨頭輝達送上了神壇。

如今的輝達靠著AI 芯片的領先,不僅在市值上一路飛漲,同時壟斷了全球AI算力近90%的市場。

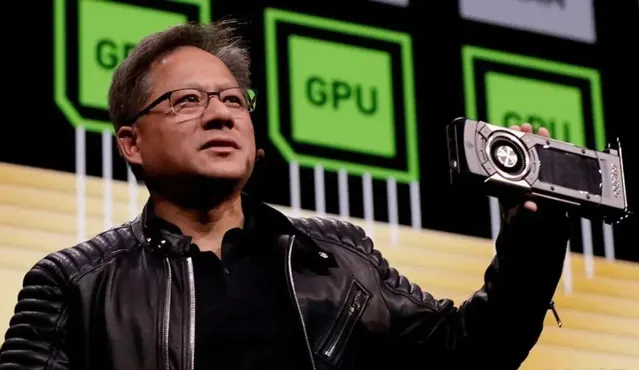

值得一提的是,GPU本身並不是專門為了AI而設計,不少芯片公司都推出過更專用化的AI芯片。

但輝達擁有自己的護城河——CUDA軟硬件協同技術。有了它,在很長一段時間裏,只有輝達的GPU才能處理各種復雜的AI任務。

這就造成了一個困境——所有人都被綁死在輝達這艘船上,很少能用替代品。

總有人希望擺脫壟斷,之前是PyTorch、 OpenAI ,現在有更多廠商站了出來。

巨頭聯合開發新軟件,意圖打破CUDA壟斷

據路透社報道,一個名叫UXL基金會的科技公司聯盟,正計劃透過開發新的技術底座,從而擺脫輝達的束縛。

從網上公開資料可知,UXL是Unified Acceleration(統一加速)的簡稱。其創始成員包括高通、谷歌雲、英特爾、Arm、三星在內的大型科技公司,足以看出該聯盟的含金量。

不過值得一提的是,整個基金會圍繞的核心其實是英特爾的oneAPI計劃,這是一套能夠為多種類別 AI 提供支持的軟件和工具,旨在簡化跨多架構的開發過程(如CPU、GPU、FPGA、加速器)。

從時間節點來看,該專案在去年的9月舉辦的Linux 基金會開源峰會上推出,計劃於今年上半年確定技術規範,而基金會的最終目的是希望從軟件入手,從而與輝達解綁,並幫助 AI 開發者不必依賴輝達平台。

在接受采訪時,谷歌高效能計算總監兼首席技術專家Bill Magro 表示:「具體來說,在機器學習框架的背景下,我們如何建立一個開放的生態系,並提高硬件的生產力和選擇。」目前,英特爾的 OneAPI已經被驗證可用,而下一步建立專為AI設計的標準計算編程模型。

除了最初參與的公司之外,基金會還計劃吸引亞馬遜雲端運算、 微軟Azure 等公司,以及其他芯片制造商,而輝達則被排除在外。

就在UXL 基金會之前,知名AI開發框架PyTorch正在拓展支持更多GPU與加速器,OpenAI旗下開源算力編程模型Triton也正試圖繞過輝達CUDA,從而支持輝達競品,而包括AMD也有自己的開發者工具 ROCm ,各方都開始「圍剿」輝達。

護城河難跨

CUDA之所以能成為輝達的護城河,正是因為其龐大的GPU軟件計算生態。

你可以把他理解成GPU的Windows系統,雖然有Linux這樣的替代品,但因為多年以來構成起來的生態以及使用者黏性,很少會有科技企業會放棄這個程式語言從頭訓練AI產品。

從本質上講,是否使用CUDA,還是取決於任務的需求。對於較小的AI器材的話,工程師確實可以使用其他開發工具替代CUDA。

但涉及到大公司的企業級任務,包括AI大模型、自動駕駛模型,CUDA憑借自身出色的速度以及可延伸性,始終是大公司的首選解決方案。

長期來看,雖然其他廠商也會推薦新的AI芯片以及非CUDA標準,但想要完全取代輝達芯片並不現實。

另外,輝達自身也意識到CUDA的地位可能在下滑。因此在今年GTC大會之前,開始禁止第三方硬件相容CUDA。

在過去,英特爾、AMD等公司會參與ZLUDA這樣的第三方專案,國產廠商也有類似的相容方案,這些非輝達GPU可以直接相容CUDA介面,從而直接執行CUDA 程式。

但現在來看,輝達希望再度加固CUDA系統的壟斷,客戶要麽重新選一個生態系,要麽繼續使用輝達的產品。

雖然競爭對手們一直在「炮轟」輝達的 CUDA,不少人都認為 開源軟件 開發框架會比CUDA更高效地使用。

但奈何英特爾、AMD等芯片廠商在硬件層面都很難追上輝達,更不要說帶著第三方開發者們放棄目前最好用的AI訓練生態。

我們可以說UXL基金會的願景很好,但想要取代CUDA,現在看起來似乎還挺遙遠的。

本文作者:jh,觀點僅代表個人,題圖源:網絡