還在猶豫什麽?好運的機會稍縱即逝!趕緊關註我,一起開啟幸運之旅吧!祝您財運亨通,心想事成!

晶圓級AI芯片WSE-3效能公布:80億參數模型上每秒生成1800個Token

Cerebras與Nvidia:一場關乎AI未來速度的「 SRAM 對 HBM 」之戰

**一場芯片界的「速度與激情」正在上演。**主角是新晉實力選手Cerebras Systems和老牌巨頭Nvidia。這兩家公司,一個手握著晶圓級AI芯片WSE-3,另一個則擁有GPU王者p00,正圍繞著AI推理速度展開著激烈的角逐。這場比賽,不僅僅是技術之爭,更是關乎AI未來發展方向的路線之爭。

一、 80億參數模型,每秒生成1800個Token:Cerebras向Nvidia發起挑戰

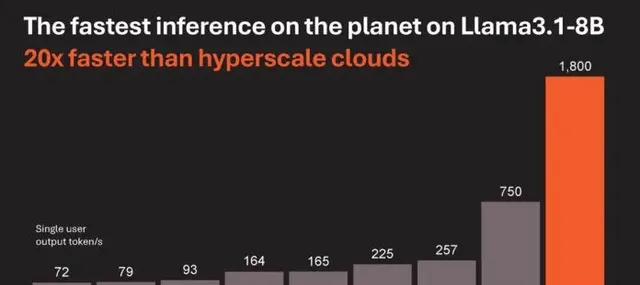

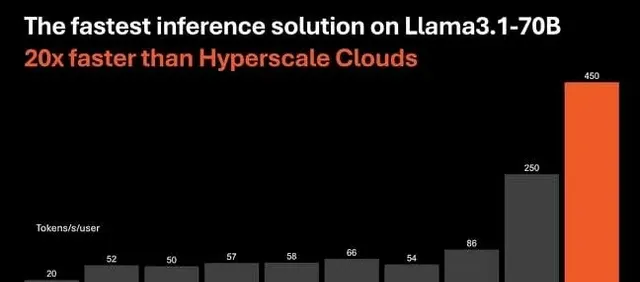

故事要從今年3月說起,Cerebras Systems釋出了第三代晶圓級AI芯片WSE-3,其效能較上一代WSE-2翻了一番。最近,在Hot Chips 2024大會上,Cerebras Systems公布了WSE-3在AI推理方面的驚人表現:在Llama3.1-8B模型上,WSE-3的推理速度比使用NVIDIA p00的微軟Azure等公司快了20倍!

這怎麽可能?

秘密就在於WSE-3采用了44GB的片上SRAM,而p00使用的是HBM3e記憶體。雖然HBM3e擁有更大的容量,但SRAM的速度優勢在AI推理中體現得淋漓盡致。Cerebras Systems行政總裁Andrew Feldman自豪地宣布,WSE-3在執行Llama 3.1 8B模型時,每秒能夠生成超過1800個Token,而效能最好的基於輝達p00的例項每秒只能生成超過242個Token。

這就好比兩輛賽車,Cerebras的賽車雖然油箱小,但發動機強勁,加速迅猛;而Nvidia的賽車雖然油箱大,但發動機動力不足,只能望「 SRAM 」興嘆。

二、SRAM與HBM:誰才是AI推理的未來?

Cerebras Systems的成功,也引發了業界對於AI芯片記憶體選擇的思考:SRAM和HBM,究竟誰才是AI推理的未來?

**支持SRAM的一方認為,**AI推理更依賴記憶體頻寬,而非單純的計算能力。SRAM憑借其速度優勢,能夠大幅提升AI推理的速度,尤其是在處理大型語言模型(LLM)時,SRAM的優勢更加明顯。

**而支持HBM的一方則認為,**SRAM雖然速度快,但容量有限,難以滿足日益增長的LLM對記憶體容量的需求。HBM雖然速度稍慢,但其大容量能夠更好地支持更大規模的AI模型訓練和推理。

這場爭論,就像是一場關於「速度」與「容量」的辯論,目前尚無定論。

三、Cerebras的野心:顛覆AI行業的「撥號時代」

Cerebras Systems並不滿足於僅僅在AI推理速度上超越Nvidia,他們的目標更加遠大:顛覆整個AI行業!

Feldman認為,WSE-3的超高推理速度,將為AI套用開辟新的機遇,就像寬頻的興起一樣,將AI帶入一個全新的「寬頻時代」。他舉例說,如果AI模型的推理速度足夠快,就可以基於多個模型構建代理應用程式,而不會因為延遲變得難以為繼。

Cerebras Systems的野心,無疑給整個AI行業註入了一劑強心劑。

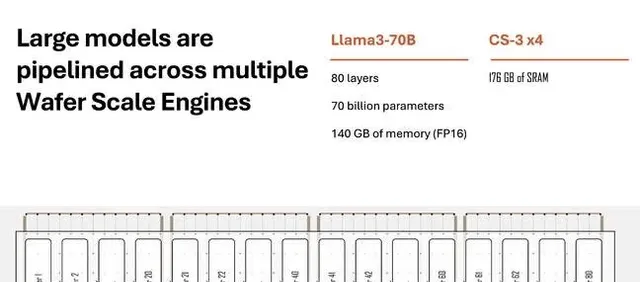

Cerebras Systems也面臨著一些挑戰。例如,WSE-3的SRAM容量有限,難以支持更大規模的AI模型;Cerebras Systems的生態系尚未完善,需要吸引更多的開發者和合作夥伴。

Cerebras Systems能否成功挑戰Nvidia的霸主地位,顛覆AI行業的「撥號時代」?讓我們拭目以待!

你認為SRAM和HBM,誰才是AI推理的未來?歡迎留言討論!

本文創作初衷在於傳播正能量,無任何侵犯他人權益的意圖。如有侵權,請聯系我們,我們將積極配合處理。