李瑞龍 騰訊研究院

騰訊研究院AGI路線圖系列專題研究二

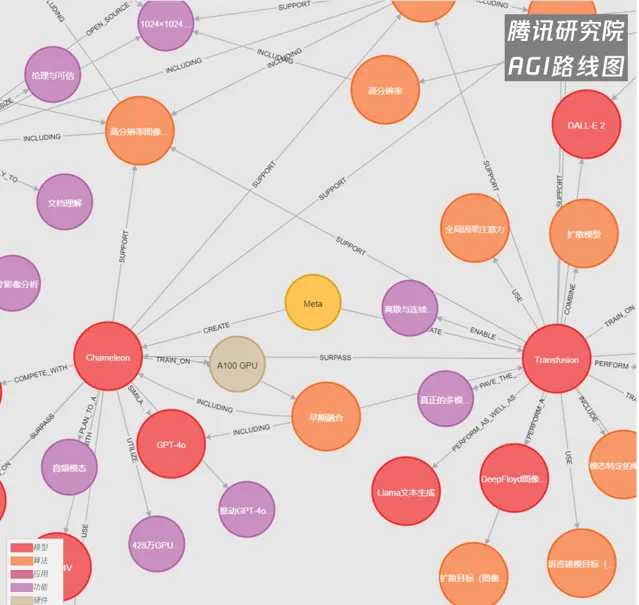

本期AGI路線圖中關鍵節點:DiT架構、Stable Diffusion 3.0、Flux.1、ControlNet、1024×1024分辨率、醫學影像、輝達Eagle模型、谷歌Med-Gemini系列模型、GPT-4o端到端、Meta Transfusion模型。

得益於人工智能演算法的進步和技術的普及,資訊與數據處理技術正在迅速變革。其中一個套用領域就是AI影像處理。

從AI影像生成、醫療成像、目標檢測和地圖繪制,到即時人臉檢測,人工智能在影像處理方面的能力被廣泛套用於傳媒、醫療、健康、安全等多個領域。

AI影像處理市場正在快速增長。數據顯示*,在AI影像編輯、生成、辨識等多個領域,2024年至2030年的復合年增長率或將分別達到11%、17%和23%,並廣泛套用於各行各業。

因此,我們有必要深入了解AI影像處理的基本原理、套用場景和最新技術發展,以便在不同的套用場景下,評估並把握AI影像處理的價值與機會點。

AI影像處理的精進之路

Transformer:從生成字元到「生成像素」

事實上,AIGC和電腦視覺(CV)技術已經有了相當長的發展歷史,但隨著大語言模型相關演算法和技術的飛速進步,傳統的AI影像處理技術在前沿套用中的可見度正在逐漸下降,而Transformer融合模型正迅速將生成下一個字元的能力擴充套件到「生成像素」的影像領域。

以公眾最為熟知的AI影像生成器為例,Stable Diffusion作為一種經典的潛空間擴散模型,能夠透過正向添加雜訊和反向去噪還原影像的方式來控制影像生成,這一過程中的關鍵,是讓模型學會從隨機雜訊到清晰影像的轉換方法。

自2022年釋出以來,Stable Diffusion在1.0至2.0階段中,這一關鍵環節由核心元件U-Net架構主導。U-Net作為編碼器和解碼器,負責將影像壓縮到潛在空間,並在潛在空間中執行擴散過程,對於生成高質素影像起到了至關重要的作用。

今年2月份,Stable Diffusion 3.0正式釋出,采用了MMDiT架構(Multimodal Diffusion Transformer,MMDiT),替代了原有的U-Net架構和骨幹網絡。結合Transformer強大的序列建模能力和流匹配技術,影像的可控性大幅提升。它能夠更好地理解涉及空間關系、構圖元素、動作和風格的復雜提示,並在高分辨率(1024x1024像素)、復雜區域(如手和臉)的細節處理以及文字拼寫方面,較上一代模型實作了顛覆性的進步。6月中旬,擁有20億參數的Stable Diffusion 3 Medium模型正式開源。該中等參數模型能夠在消費級PC上執行,具有較低的VRAM占用,適合處理小數據集和客製化需求,進一步重新整理了開源生產力。

Transformer架構的引入還開啟了AI影像模型訓練的Scaling Law。基於並列註意力的Transformer架構,較其它神經網絡結構,有著將scaling law代入生圖領域的重要潛力。它可以讓影像模型能夠消化更多的影像和影片數據,從而進一步增強影像領域的湧現能力。例如,引入Transformer架構後,上述最新版本的Stable Diffusion 3.0模型的可選參數範圍從800M到8B,8B的模型上限相比上一代提升了整整一個數量級。又例如,8月中旬,一家名為Black Forest Labs的新創公司(由前Stable Diffusion核心作者創立)成功釋出了Flux.1,透過融合架構的優勢,進一步將模型參數上限重新整理至12B(截至發稿日,Flux模型已最佳化叠代至Flux1.1版本,模型參數規模不變)。

當前,Flux模型現已成為當前開放權重影像模型領域的頂流代表。從技術報告來看,與Stable Diffusion 3.0類似,Flux.1采用MMDiT架構,並采用流匹配、旋轉位置嵌入和並列註意層等技術,重新定義了影像細節、提示遵循、風格多樣性以及場景復雜性等方面的最新技術水平(SOTA)。根據研究人員的說法,得益於大規模訓練,Flux.1 Pro和Flux.1 Dev在視覺質素、提示一致性、尺寸和長寬比的可變性、排版以及輸出多樣性等方面,已經超越了Midjourney v6.0、Dall-E3和Stable Diffusion 3 Ultra。從官方釋出的樣張和網友的測試情況來看,Flux.1幾乎達到了真假難辨的程度,AI影像生成的Scaling Law奏效了。(叠代版本Flux1.1相關技術尚未完全公開,官方稱其運算效率與表現更佳,仍在前進演化中)

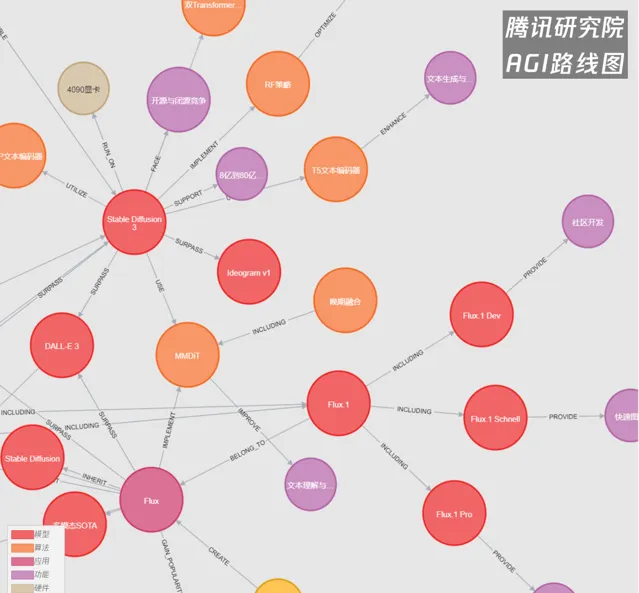

騰研AGI路線圖圖譜截選

Stable Diffusion 3與 Flux.1

從Prompt提示詞到ControlNet控制

在AI技術的套用過程中,指令遵循性是一個通用且至關重要的指標。影像生成控制的方法有很多,包括Prompt(提示詞)、LoRA(低秩介面卡) 、ControlNet(控制網絡)等等,還包括ComfyUI等一類用於配置工作流的外部應用程式。

Prompt是一個非常深入人心的概念,它是來自使用者的文本描述,指引模型生成特定的影像,例如,輸入「一個穿紅色裙子的小女孩」將促使模型生成符合該描述的影像。而透過調整prompt的內容和細節,使用者可以進一步控制生成影像的主題、風格和細節。

LoRA全稱Low-Rank Adaptation(低秩介面卡) ,最早是微軟在大語言模型的訓練中發明並使用的一種低成本的模型微調技術。其根本出發點是為了降低大語言模型finetune的代價和大量Finetune模型載入的代價問題,更輕松的部署在專業生圖領域,如建築設計等。

ControlNet是一種神經網絡結構,透過添加額外的條件輸入來控制現有模型(如Stable Diffusion)的輸出。它允許使用者在生成過程中引入更多的控制資訊,包括姿勢、深度或邊緣檢測等,從而精確地引導生成結果,線稿、深度圖或語意分割圖等均可以作為輸入條件。

實際上,ControlNet與LoRA的核心思路相似,都是透過旁路網絡幹預模型輸出。不同之處在於,LoRA透過低秩壓縮減少模型體積,但限制了其能力上限;而ControlNet則不壓縮模型參數,而是1比1復刻,實作更高的控制精度。

進一步展開,我們可以看到,ControlNet已經可以提供一系列讓人驚艷的精準控制能力:

例如,光影控制方面,ControlNet作者在5月釋出了IC-Light(全稱Imposing Consistent Light),用於操控影像的照明效果。該技術利用潛在空間一致性,確保在不同光源組合下外觀的一致性,實作自然的光照變化。使用者只需上傳任意圖片,系統會自動分離主體並選擇光源位置,配合說明,即可為影像自動添加AI打光效果。。

例如,在輪廓控制方面,7月中旬,ControlNet作者釋出了名為Paints-Undo的專案,靈感來源於繪畫軟件中的「撤銷」功能,模型的輸出過程類似於連續按下Ctrl+Z。該專案允許使用者透過上傳圖片倒推其創作過程,包括素描、上色等步驟,還能生成展示整個繪畫過程的25秒影片。高度一致的畫面效果展現了ControlNet卓越的輪廓控制力。

例如,在畫面構圖方面,ControlNet架構還可以作為中間載體,將使用者簡短的Prompt提示詞進行擴充套件,並精確控制影像生成的各項元素。ControlNet作者的新工具Omost透過LLM AI代理的自動擴充套件功能,能夠根據簡單的Prompt生成詳細的影像構圖描述,包括光照、輪廓、物件等全域和局部的具體要求。特定的生成器最終則根據LLM設計的藍圖來建立影像。

從Prompt提示詞到LoRA再到ControlNet的控制,再結合工作流程設計工具(如ComfyUI),當前的AI影像處理模型已經為使用者提供了極高的靈活性和控制能力。

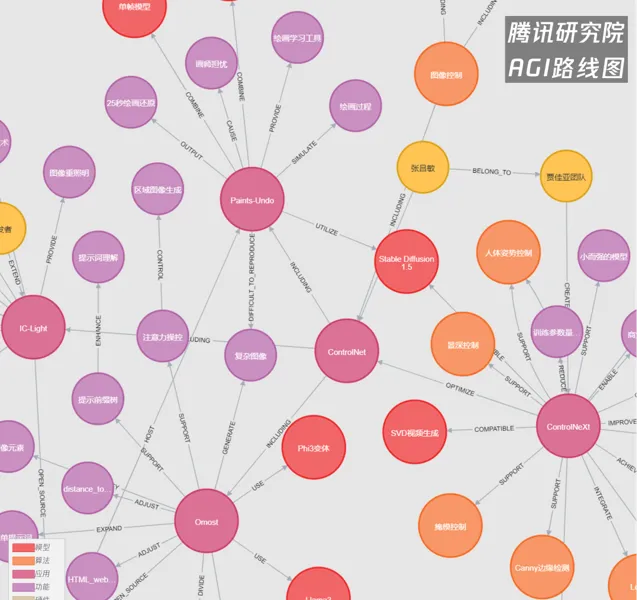

騰研AGI路線圖圖譜截選

ControlNet

生成與理解的產業化現狀

1K分辨率的產業意義:從生成到理解

類比於基礎語言模型的最長上下文,分辨率在AI影像處理中同樣至關重要。更高的分辨率使模型能夠捕捉更多資訊和細節。同樣地,當前的AI影像處理也會受到類似於「最長上下文」的限制,受制於計算資源、訓練數據集、模型架構以及效能與質素平衡等多方面的因素。

AI影像處理,無論是AIGC還是多模態理解與辨識,都已成功突破了1K分辨率的關鍵門檻。

例如,AI影像生成模型如Flux.1、Imagen 3、Midjourney v6、Stable Diffusion 3等,均可支持主流的1024×1024原生影像分辨率(一次生成),並且可以透過超分辨率技術進行2倍甚至更高的像素擴充套件,進一步提升影像細節;這對於藝術創作、廣告、遊戲開發以及影像制作等行業的輔助影像生成,可以起到較好的支持。

在影像理解方面,挑戰則主要體現在多模態基礎模型的輸入限制上。由於高分辨率影像處理需要在架構和數據集等方面進行大量適配與再訓練,這並非易事。

以GPT-4和GPT-4 Vision版本為例,它們在輸入影像時采取了嚴格的限制。根據官方檔描述:「提前將影像縮小至小於預期的最大尺寸可以提高模型的響應速度。在低分辨率模式下,建議影像為512px x 512px。在高分辨率模式下,影像的短邊應小於768px,長邊應小於2000px。」 同時,還列出了一系列「局限性」:不適用於醫學影像解讀、處理非拉丁文字效果較差、可能誤解旋轉或倒置的影像、對圖表和不同線條樣式的理解困難、空間定位能力有限等。

對於影像理解而言,為什麽1K分辨率同樣具有重要意義?以醫學影像為例,電腦斷層掃描(CT)的矩陣大小通常為512x512像素;磁共振成像(MRI)的分辨率範圍較廣,但一般在256x256到1024x1024像素之間;超聲成像的分辨率通常約為512x512像素。因此,多模態基礎模型需要基於或高於這些目標分辨率,改善模型以更好地處理醫學影像等高精度數據。

例如,9月,Mistral釋出了Pixtral 12B多模態大模型,采用專用視覺編碼器和24GB容量,並結合GeLU和2D RoPE技術,最佳化視覺適配能力,使其能夠更好地處理高分辨率影像(1024x1024像素)。同月,輝達推出了Eagle系列模型,能夠處理高達1024x1024像素分辨率的影像,顯著提升了視覺資訊的處理和理解能力。為了應對復雜的影像資訊,Eagle采用多專家視覺編碼器架構,不同編碼器針對特定任務進行專門訓練,實作了更全面的影像理解。

1K分辨率使生成式AI在影像理解方面具備了更高的套用潛力,尤其在法律、醫療、電子商務等行業中,這種能力有望帶來更廣泛的套用。

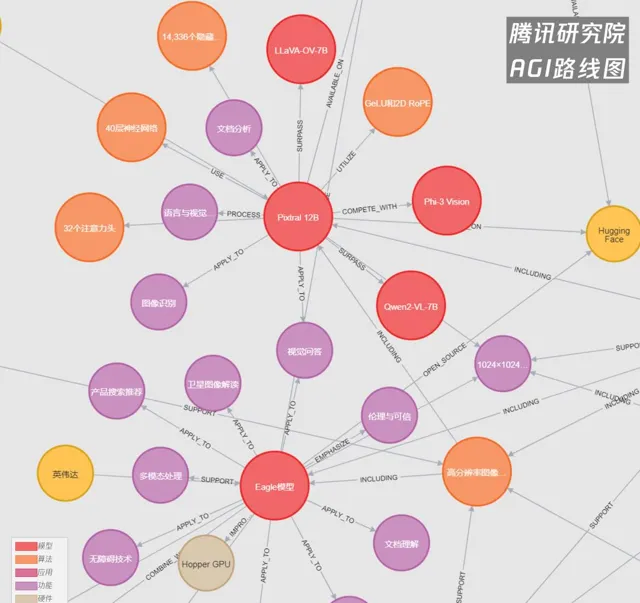

騰研AGI路線圖圖譜截選

Pixtral 12B 與Eagle

破解商業化:技術能力與產業場景的適配

在當前的生成式AI浪潮中,原生技術能力的展示已經能夠吸引大量流量。AI生成的文本、影像、影片甚至音樂等內容,由於能夠快速觸達使用者,並具備視覺化和娛樂化的特點,獲得了更多市場關註。然而,這並不一定能夠形成有效的商業閉環。

相反,許多知名的生成式AI應用程式由於商業模式的限制,正被大公司收購,或並入更大的套用平台,亦或透過資源整合進入特定行業。

例如,今年年中,Stability AI面臨嚴重的財務困境,虧損和債務不斷累積,不得不尋求新一輪融資以重組公司並緩解財務壓力。隨後,Stability AI任命【阿凡達】視覺特效公司前負責人Prem Akkaraju為新任CEO,借助其在Weta Digital的豐富技術和行銷經驗,推動Stability AI將影片、圖片、音樂等大模型與先進視覺特效技術相結合,以尋求財務狀況的改善。

一個月後,在2023年完成融資估值上億,目前年經常性收入3000萬美元,團隊規模120人的AI影像生成大廠Leonardo.ai,尋找Canva(一個用於圖形設計和內容建立的線上平台)的收購,交易價格僅約3億美元,整合其影片和影像生成模型。透過這次收購,Canva的主要目標是提升其AI技術儲備,與Adobe展開競爭,加速收入增長並吸引更多企業客戶。

從中可以看出,AI影像處理能力雖重要,但原生市場需求仍處於發育階段。相關企業不得不尋求與更高層次的AI影像編輯和影視制作市場的融合,透過曲線救國的方式,推動商業化落地。

相比AI影像生成市場,影像理解與分析的熱度雖稍低,但實際上早已更早地進入了行業融合的商業化模式。

醫療AI是其中最為矚目的賽道之一,谷歌在多模態任務與醫學領域投入了大量精力。5月份,谷歌DeepMind釋出了Med-Gemini系列模型,專門針對醫學領域的多模態任務進行最佳化,包括Med-Gemini-2D、Med-Gemini-3D和Med-Gemini-Polygenic。這些模型利用大規模醫學影像數據,在多個醫學影像分析任務上超越了現有最佳模型,特別是在胸部X射線、CT影像和基因組數據處理方面。測試結果顯示,生成式AI在多模態醫學AI任務中表現出色,尤其是在視覺問答和放射學報告生成領域。

類似的研究在學術界也取得了大量進展。例如,MIT開發的Mirai系統可以基於常規乳房X光檢查預測乳癌風險,嘗試提前五年發現潛在病例。另一個例子是上海交通大學的3D醫學大模型SAT,該模型能夠對497種人體器官和病竈進行3D影像分割,展現出強大的套用潛力。

此外,Geoffrey Hinton(謝菲·辛頓)、LeCun(楊立昆)以及吳恩達等AI領域的領軍人物也多次公開支持醫療AI及醫療影像分析方面的研究。

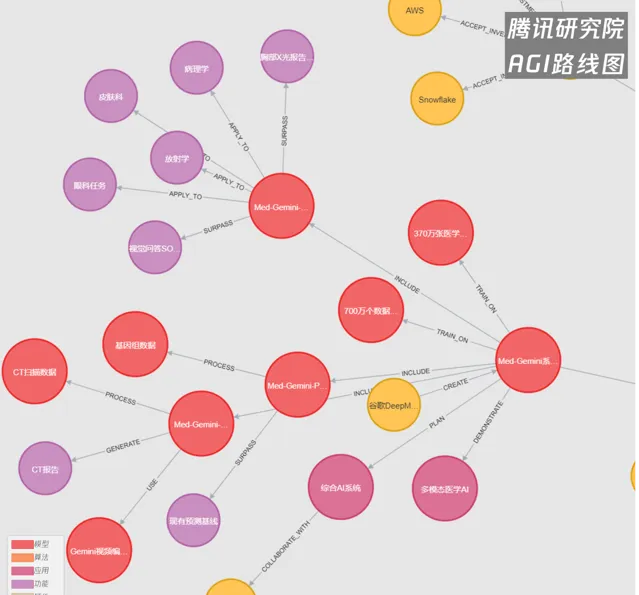

騰研AGI路線圖圖譜截選

Med-Gemini

技術到頭了嗎?遠遠沒有

AI影像處理的Scaling Law剛剛開始

目前,各大影像生成模型尚未完全披露其技術細節,但從整體趨勢來看,純Diffusion路線正逐步融合Transformer架構。如DiT架構(此處指代大的架構類別,包含MMDiT架構),這也是Sora和 Stable Diffusion 3,以及Flux.1、騰訊混元文生圖(首個中文原生DiT)的同款架構和關鍵技術,是一種基於Transformer架構的擴散模型。

正如上述,使用Transformer架構,可以擴充套件更多的影像數據處理能力,而這項技術的Scaling Law才剛剛開始不到半年時間。

回顧以往的各類擴散模型,大多數的參數量都在1B或更小的規模。而引入DiT架構後,Stable Diffusion 3和Flux.1的參數量分別達到了8B和12B。對比一年半前Midjourney V5驚艷全網的「情侶合照」,到如今Flux.1掀起的新一輪風暴,AI影像生成技術似乎邁上了一個全新的台階。禾頓商學院AI方向的副教授Ethan Mollick在看到Flux.1的生成效果後,預言AI將在18個月內完成一次重大前進演化。而事實上,距離Sora和Stable Diffusion 3大規模套用DiT架構,僅過去不到半年。

相比於基礎模型在文本訓練數據上的豐富性,影像處理和多模態領域仍有較大的提升空間。

首先,當前的數據生成環境中,影片和文本數據的數量仍在增長,尤其是影片數據,增速尤為顯著。據統計,全球每天生成約4.7億個影片,約相當於數十PB的數據。例如,YouTube每天處理約720,000小時的影片內容,總計約4.3PB的數據。這些海量圖片和影片數據將為影像處理和多模態領域的叠代提供源源不斷的訓練素材,推動技術持續進步。

其次,得益於開源生態,無論是DiT架構還是多模態基礎模型,如今都處於一個開放且活躍的探索階段。各行各業可以借助開源模型,針對特定業務場景進行客製化最佳化,從而探索每個領域的Scaling Law,例如在醫療影像和傳媒娛樂等不同方向的套用潛力。

最後,更多資本和人才的湧入將推動影像處理進入新階段。9月25日,導演占士·金馬倫宣布加入Stability AI董事會,強調AI與CGI的結合將開創全新的敘事方式,引發了國內外的廣泛關註。生成式AI與CGI的融合有望為藝術家提供前所未有的創作機會,推動視覺媒體的未來發展。隨著大規模產業套用的展開,更多算力和資源的不斷投入將持續提升AI影像生成能力。成功的商業模式將反過來促進技術進步,正如CGI產業多年的演進歷程一樣。

從late fusion到early fusion的探索

傳統AI,無論是文本生成文本(文生文)還是文本生成影像(文生圖),通常為每種模態采用特定的「編碼器」或「解碼器」,將不同模態分開處理,這種方法被稱為「晚期融合」(late fusion)。然而,這在一定程度上限制了模型的潛力,因為Transformer本身具備有效處理跨模態資訊的能力,模組的分離的處理方式削弱了這種優勢。

GPT-4o的釋出改變了這一點,作為首個「端到端」模型,它能夠透過單個神經網絡處理所有模態。5月16日,OpenAI總裁Greg Brockman透過X賬戶釋出了GPT-4o生成的首張公共影像。這張逼真的圖片展示了一位穿著印有OpenAI標誌的黑色T恤的人,在黑板上用粉筆寫著「不同模態之間的轉換。假設我們使用一個大型自回歸Transformer直接建模(文本、像素、聲音)。這樣做的優缺點是什麽?」。他還在釋出中寫道:「GPT-4o生成的影像——僅憑GPT-4o的影像生成能力,就有許多可以探索的領域。團隊正在努力將這些能力推向世界。」

而類似的技術嘗試仍在持續推進。GPT-4o釋出不到一周後,開源模型廠商Meta釋出了34億參數的「Chameleon」模型,能夠無縫處理文本和影像,使用10萬億token進行訓練,效能接近GPT-4V。Chameleon采用統一的Transformer架構,實作了文本和影像的「早期融合」(early fusion),重新整理了多模態視覺問答和影像標註的基準(SOTA)。盡管該模型的設計面臨技術挑戰(事實上,GPT-4o至今也尚未正式釋出其影像生成能力,網頁端僅提供非正式版本的體驗),但Meta透過架構創新和訓練技術,最佳化了早期融合多模態大模型的效能與穩定性。與GPT-4o的端到端方法類似,成為了當前的重要方向。

8月底,Meta再次釋出了最新研究成果——Transfusion模型,整合了Transformer和Diffusion技術,實作了文本與影像生成的統一。該模型在混合模態序列上進行訓練,結合了語言建模和影像擴散的優勢,大幅提高了模態之間的整合效率。實驗驗證表明,Transfusion在多模態AI領域表現出色,能夠生成高質素的文本和影像,有望引領多模態互動式套用的發展。

騰研AGI路線圖圖譜截選

「Chameleon」與Transfusion

在當前技術發展的浪潮中,不僅所有套用都值得被最新的AI技術重寫一遍,甚至所有相關的AI技術本身,也值得透過最新的AI架構和演算法重新構建。這種持續叠代的過程推動了整個領域的快速進步。

讓我們進一步展望未來,當Transformer架構的融合解決了scale up規模擴充套件的問題,顯著提升了影像的分辨率與豐富度;當「早期融合」(early fusion)和「端到端」架構正在努力提升跨模態資訊處理能力,推動大一統的行程。OpenAI最新的o1推理模型,是否能夠解決生成中的「邏輯」問題,而不僅僅是相關性,使影像生成與理解更加貼合物理規律?這一點仍然未知。但從目前的發展情況來看,AI影像處理革命或即將迎來新一輪突破,且其技術、市場發展還遠遠沒有達到上限。

(感謝騰訊研究院曹士圯、袁曉輝在本文撰寫中提供的幫助。)

參考資料:

騰訊研究院AGI圖譜數據庫、#騰訊研究院AI速遞、#AI每周關鍵詞Top50

https://www.gminsights.com/industry-analysis/ai-image-generator-market

https://www.psmarketresearch.com/market-analysis/image-recognition-market

https://www.grandviewresearch.com/industry-analysis/digital-image-processing-market-report

騰訊研究院AGI路線圖

AGI路線圖是騰訊研究院旗下的AI創新研究專項,依托對AI創新前沿的關註、技術積累與產品實踐,為探索AGI(通用人工智能)之路提供全方位的研究支持。該專項持續關註技術、場景、數據、生態和安全等多個維度,希望為AGI逐步落地及其產生的行業和社會影響,提供思想洞察和交流平台。如果您對這個主題感興趣,歡迎來稿,或與我們交流您的所思所想!

聯系地址:[email protected]

掃碼進入騰訊研究院AI&Society社群

獲取AGI路線圖-AI影像圖譜全部內容

(騰訊研究院AI&Society社群二維碼)