財聯社2月8日訊(編輯 史正丞) 看著三星剛釋出的AI手機「畫個圈就能編輯圖片」,iPhone使用者只能無奈地咽下口水。但最新論文卻顯示, 蘋果公司在AI領域的儲備,顯然要比市場預期得豐厚不少 。

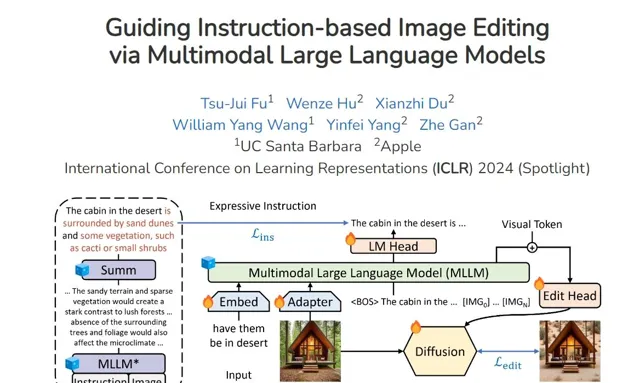

蘋果與加州大學研究人員在本周刊發的論文中,公開了一項 基於多模態大模型,能根據自然語言指示進行圖片編輯的開源「MGIE」AI模型 。開發人員直言,這個AI能夠進行「Photoshop式的修改」、全域最佳化和局部編輯。

(來源:arXiv)

這項研究的突破之處在於,雖然現在多模態大語言模型(MLLMs)在跨模態理解和視覺感知響應生成方面表現出了卓越的能力,但尚未被廣泛套用於影像編輯任務。而從這篇論文給出的一系列演示來看,光是MGIE展現出來的AI影像編輯能力,就足以推出一系列有趣的AI套用。

這個AI能做什麽?

使用多模態大語言模型編輯影像有兩個好處:首先, 模型能夠將自然語言指令轉譯成更容易讓機器執行的命令 。例如使用者輸入「讓圖片背景的天空更藍一些」時,MGIE會將提示詞轉化為「將天空區域的飽和度提高20%」。其次, 多模態大語言模型在視覺想象力、圖片生成等模組本身也具有一定的優越性 。

論文也給出了不少範例:

比如,「讓圖中食物變得更健康一些」,AI就會 在純肉披薩上,加一些小番茄和香草葉 。

還有網友們需求極大的「P圖」功能: 將背景裏的人去掉 ,這個AI也能摳得幹幹凈凈。

從多個同類AI的表現對比來看,MGIE在理解指令(例如在甜甜圈上覆蓋草莓醬淋面)和執行P圖命令(增亮、銳化圖片)方面,也展現出了業界頂級的效果。

(註:從左往右數,第一張為原圖,第四張為MGIE輸出效果)

目前MGIE的開原始檔已經被論文第一作者、加州大學聖塔芭芭拉分校的Tsu-Jui Fu上傳到Github上,同時在「抱抱臉」平台上開放了試用demo。論文顯示,Tsu-Jui Fu曾在2023年夏天在蘋果公司實習,MGIE的研究工作也是在那個時候完成的。

圍繞蘋果的AI爭論

MGIE和這篇論文,也展現了蘋果公司近些年來在AI領域確有相當水平的積累。

在被華爾街詬病「沒跟上AI時代」,以及科技爆料人嘴裏「蘋果高層驚慌失措」後,前不久才從世界市值第一上市公司的位置上掉下來的蘋果,勢將在今年對外展示iOS如何使用AI。 外界普遍預期,每年6月蘋果披露最新軟件成就的WWDC,今年將會成為釋出AI產品的主陣地。

在今年2月1日的財報電話會上,庫克也明確表示,公司在生成式人工智能方面正在開展大量工作,同時 在今年晚些時候,蘋果將討論一些「讓我們感到無比興奮的事情」 。

值得一提的是,蘋果公司在機器學習等領域一直都有投入,但在產品宣發層面卻不太喜歡使用AI這個詞。在去年WWDC上,蘋果釋出能夠自動修正拼寫錯誤的鍵盤功能,底層技術正是與ChatGPT類似的transformer模型,但是蘋果在釋出會上完全沒有提AI,僅使用了更為學術化的稱呼——機器學習。