自ChatGPT問世掀起大模型的發展熱潮以來,國內外的相關套用悉數落地並且已經卷出天際,逐漸成為幫助各行各業生產效率提升的重要工具。此前的系列文章中,我們就重點圍繞網絡安全行業的各個細分方向,觀察了大模型如何融入安全工具及服務,為現代安全體系加碼賦能。

大模型作為一把雙刃劍,技術的突破也帶來了新的風險挑戰,本期,我們將調轉視角,觀察因大模型技術和套用而引發的種種安全問題,以及業界的應對策略。

大模型滲透千行百業 引發多重網絡安全威脅

在人類社會開啟邁向通用人工智能新路徑的行程中,「大模型泄露個人私密」「AI生成釣魚郵件以假亂真」「大模型引發人類倫理思考」等等新聞事件不絕於耳。大模型驚艷四座的表現總是伴隨著關於「安全」的爭議,想要了解其背面隱藏的風險,還要從理解其技術特性入手。

大模型是依靠大算力和強演算法對大數據進行訓練的結果,其能力來自對大量無標註數據中抽象共現模式的深度學習,在本質上是大數據驅動的,其最明顯的特性是參數規模大,通常在百萬級以上,甚至超過萬億級別。基於從訓練數據中學習的模式,大模型可以生成新的內容,並湧現新的能力,比如小樣本提示學習能力、思維鏈推理能力等。這也使其得以透過微調等適配方式去處理各種不同的任務,甚至處理未見過的任務,通用性大大提高。正是這種新型的大數據利用方式,其數據訓練和模型呼叫實作的自動化內容生成引發了新的安全風險。

敏感數據、個人資訊面臨外泄

大規模抓取的網絡公開數據可能包含姓名、電話號碼等個人資訊,甚至可能包括生物辨識、行蹤軌跡等敏感個人資訊和高風險數據。而且,很多大模型預設將使用者輸入的提示作為訓練數據,其中同樣可能包含個人私密數據。研究發現,大模型可能會「記憶」並在特定輸入誘導下泄露這些訓練數據中的個人資訊、敏感數據,包括受版權保護的材料。

生成與事實相悖的幻覺內容

在大模型不具備回答某種問題的能力時,其不會拒絕回答,而是會輸出錯誤的答案。由於模型的訓練過程采用自回歸的訓練方式,在給定當前文本內容的情況下預測下一個單詞,其本質上是做文本數據的概率建模。在這一過程中,模型更多學習到單詞之間的相對關系和句式句法,但對於事實缺乏基本的判斷和推理,也沒有對自己的能力邊界進行建模,即大模型「不知道自己不知道」,因此可能「一本正經地胡說八道」。

產生偏見歧視或不良資訊

由於大模型的訓練語料庫通常由互聯網上的爬取數據組成,網絡上的數據難以避免地包含恐怖主義、極端主義、色情、暴力等有害資訊,也可能存在對少數群體或者弱勢群體的偏見資訊,大模型在訓練後會「記憶」這些資訊,輸出的有害內容可能會對使用者產生不良影響,或者會對具有不同宗教、種族、性別等特征的人群產生不一致的結果。

被濫用於欺詐、攻擊等網絡犯罪

大模型超強的生成能力,以及其基於大量人類數據訓練而具有的「類人」輸出和互動能力,使得犯罪分子能夠以低成本方式大規模制造更加逼真、更具欺騙性的虛假資訊,例如大量制作更具說服力的網絡釣魚電子郵件,在戰爭等重大事件透過深度偽造影片擾亂國家安全等等,此外還可以生成惡意軟件程式碼實施勒索、APT等網絡攻擊。

政府及監管機構成為確保大模型安全執行的重要力量

如何防範規制風險,平衡好人工智能發展與安全的關系,引導大模型健康發展,已成為全社會面臨的共同難題。

政府與各類監管機構成為確保大模型安全執行的重要力量,透過制定和實施嚴格的數據私密法規,為大模型的安全使用提供法律保障:

國際上,2024年3月13日歐洲議會透過了【人工智能法案】(Artificial Intelligence Act),規定了基礎模型提供者的義務,也對通用人工智能系統提出了透明度要求,包括執行模型評估、評估和降低系統性風險以及報告事件。

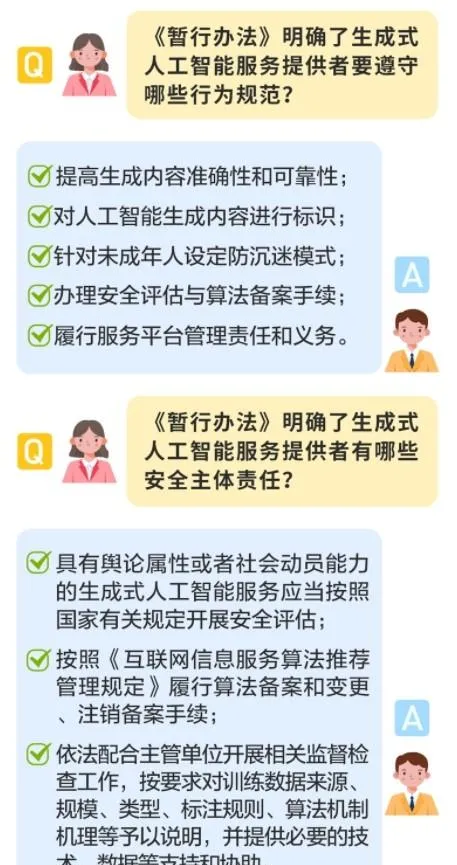

國內,國家網信辦等七部門聯合釋出的【生成式人工智能服務管理暫行辦法】自2023年8月15日施行,就生成式人工智能可能面臨的安全問題提出了一系列明確的約束規範,並提出兩種監管政策,一是根據生成式人工智能服務的風險高低進行分類分級監管,二是根據生成式人工智能服務適用的不同領域進行行業部門監管。

為了推進法規監管有效落地,各相關部門都在積極開展標準編制及指南實踐等工作:

全國網安標委於2024年3月釋出【生成式人工智能服務安全基本要求】,對上述【暫行辦法】中的數據來源合法、內容安全等合規要求的執行規則進行了細化,對生成式人工智能服務提供者在實踐中開展安全評估提供有效的路徑。

公安部第三研究組織編制【大模型系統安全保護要求】和【大模型系統安全測評要求】兩項團體標準並已形成標準送審稿,主要從大模型系統通用安全和大模型系統全生命周期安全的角度進行考慮,覆蓋設計開發安全、測試安全、部署與執行安全、退役安全四個部份並分別提出相關要求。

中國信通院人工智能研究中心聯合業界開展【大模型安全風險防範能力要求及評估方法】標準編制工作,從訓練數據安全、模型安全、內容安全和服務營運安全四個方面形成大模型安全風險防範能力要求和評估方法,於2023年12月正式定稿並啟動首輪試評估工作。

全球開源安全組織OWASP近日釋出了【AI大模型套用網絡安全治理檢查清單(V1.0)】,較完整地介紹了大模型部署套用時的安全原則、部署策略和檢查對照表,以幫助大模型提供者制定一份全面的關鍵領域和任務清單。

業界探索安全框架和應對方案 支撐監管有效落地

在監管機構從頂層規制大模型的安全發展框架和實踐路徑的同時,眾多積極布局研發大模型套用的科技巨頭和安全廠商也是生態中的重要參與者,他們從實戰中探索出的大模型安全框架和解決方案,是目前產業中自研訓練大模型或部署套用大模型的企業客戶迎合安全監管、提升創新競爭力的有力砝碼。

奇安信AI安全整體應對方案

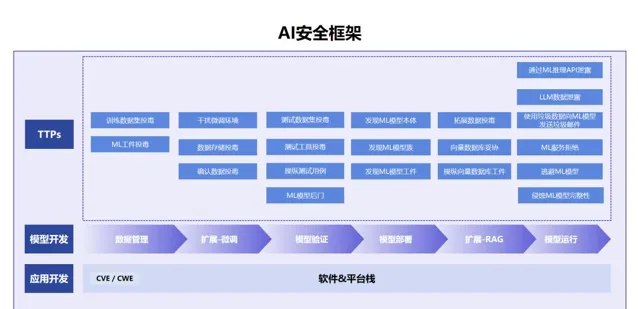

方案包括AI安全框架,以及基於安全框架下的AI安全解決方案、AI評估服務和安全檢測工具。AI安全框架的核心是在框架級別指導模型構建全生命周期的安全體系規劃,定義了模型構建到執行的各個生命周期,分別為數據管理,擴充套件-微調,模型驗證,擴充套件-RAG,模型部署,模型執行,以及各個階段攻擊者的技戰術。

AI安全解決方案是覆蓋安全框架中模型生命周期的安全防護與檢測方案,它針對大模型訓練、微調、驗證、部署和執行過程模型安全內容不清等問題,透過對之前釋出的大模型衛士和奇安天盾進行安全能力升級,再搭配AI安全檢測工具,能夠做到訓練數據細粒度管理、惡意存取動態阻斷、異常數據即時辨識、敏感數據防泄漏,保障模型訓練數據安全可靠。

AI安全評估服務為企業在構建大模型時提前進行風險評估,它涵蓋了提示詞註入、不安全的輸出處理等17類檢測細項,幫助確保大模型生成的回復內容符合【生成式人工智能服務管理暫行辦法】等各類法律法規。

AI安全評估工具,作為一款專門針對大語言模型的安全檢測評估系統,確保大模型在最後推向市場前進行一次安全「質檢」。模型開發企業可在開發LLM相關的產品和服務時客觀地進行風險辨識,部份企業在選用開源大模型或購買第三方大模型後可對模型安全進行有效評估。

360大模型安全解決方案

360提出了大模型的安全四原則:可靠、可信、向善、可控,旨在從頂層設計上全面保障大模型的安全。為了實作這些原則,又進一步提出了一套核心戰法,包括建立「網絡與數據安全與大模型自身安全」的雙輪驅動體系,堅持以內容安全為核心,在大模型內部內建原生安全機制,采用「小模型」的技術思路保障大模型安全的技術路線,同時構建大模型安全實戰對抗評估體系對大模型安全實戰能力進行評估,並進一步構建以服務營運為核心的大模型安全持續治理體系等。

大模型安全戰法的落地需要足夠的安全能力支撐,360提出了大模型安全能力體系框架(AISF框架),這個框架將大模型安全能力分為兩部份,一是傳統網絡與數據安全能力,二是需要嵌入到大模型內部,以解決大模型內容可信、合規向善為目標的大模型原生安全能力。

在框架中,一方面,利用360安全雲圍繞「數據、探針、平台、專家、AI」這五個核心要素,在網絡與數據安全層面對大模型進行全面防護;另一方面,透過「360大模型原生安全能力增強包」解決大模型在內容可信、合規向善、模型可控上存在的安全問題,並利用其獨有的大模型安全評估系統,對大模型的安全能力進行實戰評估。方案可以平移、復制給有需求的行業客戶與合作夥伴,並以標準化的能力產品方式對其他大模型企業進行安全賦能。

百度安全大模型安全解決方案

從大模型全生命周期視角出發,方案涵蓋大模型訓練/精調/推理、大模型部署、大模型業務營運等關鍵階段所面臨的安全風險與業務挑戰。核心服務包括:

數據安全與私密保護 - 支持公有雲、私有化兩種場景的橫向聯邦軟件方案,數據不出域即可完成預訓練、精調;透過硬件化的CPU+GPU保護方案保障模型和數據安全,解決部署階段的模型記憶泄露問題;針對公有雲推理階段數據私密保護問題,提供同態密碼學軟件解決方案。

模型保護 - 提供整套語料數據安全管理方案,包括後設資料管理、分類分級、流轉審批等多項能力;采用Baidu Ai Realm技術為大模型全生命周期提供多方位安全防護措施。

AIGC內容合規 - 針對輸入內容提供多維度內容稽核能力、並針對惡意誘導大模型生成違規內容的Prompt進行覆寫並做毒性提示;依據【生成式人工智能服務管理暫行辦法】提供內容安全評測和攻擊指令評測。

業務營運安全風控 - 依托百度安全智能風控解決方案,在大模型前置營運階段以及大模型互動環節,結合使用者行為、終端環境、網絡特征等資訊建立安全防護體系,針對異常請求做即時風險檢測。

內容安全評測 - 建立覆蓋100+種風險分類、涵蓋20+種高級攻擊的自動化數據集生成能力,評測框架開箱即用,靈活適配各種大模型,評測報告內容包括評測方法、評測數據集、評測指標等數據,並提供問題清單和改進建議。

天際友盟AIGC數碼風險防護方案

針對數據泄露、知識產權保護和侵權欺詐等常見的AIGC數碼風險場景,推出的具有針對性的人工智能生成內容數碼風險防護服務,AIGC DRP(AIGC Digital Risk Protection)。

服務過程主要分為準備、監控和反饋三個階段。在準備階段,天際友盟AIGC DRP服務將根據關鍵詞和AIGC平台範圍清單,確定監控範圍,並取得使用者的授權,為後續協助處置做好準備;在監控階段,服務將會按照關鍵詞及關聯資訊根據AI演算法生成各類關聯問題,並將其在各AIGC平台進行問答,再對答案進行分析研判,從而實作風險監控與風險評估,這將是一個持續性的工作;在反饋階段,服務將根據監控和評估結果形成客製服務報告以周、月形式提供給客戶,如有需要,天際友盟還可協助使用者進行定向AIGC平台的處置工作。

尾 聲

透過觀察如今的立法監管趨勢與各方安全實踐,安全419總結認為,目前能夠落地的安全方案主要集中解決當前的、已經顯現的風險,如訓練數據是否合法合規、生成內容是否準確或有害、模型是否被濫用於生成虛假資訊等,圍繞這些現實風險,既有整體方法論,也有具體風險點的應對措施。著眼未來,從大模型的全生命周期嵌入安全機制,從整體上對大模型的安全風險進行建模,能夠更系統化地構建大模型的安全框架和系統。

更進一步,業界也對大模型潛在的、根本性的風險給予強烈的關註,即人工智能脫離人類控制,進而對人類生存等根本利益造成威脅。在立法及監管層面,需要制定安全標準在模型上線前對其危險能力進行評估,對功能達到一定規模的大模型服務提供者發放特許或撤銷,相關措施和治理路徑仍在探索之中。正如大模型技術及套用仍在不斷前進演化一樣,人們對它們的理解和安全治理也尚處於在初級階段,在大模型等AI技術與傳統產業、網絡安全以及社會倫理等方面的碰撞中,挑戰或許才剛剛開始。