GPU集群組網技術分析:NVLink、InfiniBand、ROCE、DDC

AIGC訓練中的並列處理方案與網絡擁塞的影響

AIGC訓練過程中的並列處理方案包括數據並列、模型並列、流水並列、張量並列等。這些方案均會導致訓練過程中產生顯著的跨GPU流量,網絡中的任何擁塞都可能導致訓練時間延長和GPU利用率降低。

最佳化後的文字(150字):

AIGC訓練中的並列處理方案雖能提高訓練效率,但會產生顯著的跨GPU流量,網絡擁塞將導致訓練時間延長和GPU利用率降低。常見的並列方案有數據並列、模型並列、流水並列、張量並列等。無論采用哪種並列方案,由於參數和數據集的巨大規模,透過連線GPU網絡傳輸的數據量都非常龐大。因此,確保網絡的暢通對於AIGC訓練至關重要。

GPU/TPU集群網絡組網方案及在LLM訓練中的套用

# GPU網絡條件:

* 超高頻寬:支持大規模數據並列訓練。

* 低延遲:減少通訊開銷,提高訓練效率。

* 可延伸性:支持更大的集群規模和更多的GPU/TPU節點。

* 靈活性和可靠性:易於部署和維護,確保訓練任務的穩定執行。

# 主流GPU網絡方案:

* NVLink:NVIDIA專有互連技術,提供超高頻寬和低延遲。

* InfiniBand:高效能網絡標準,提供低延遲和可延伸性。

* ROCE乙太網路Fabric:基於乙太網路的網絡方案,提供經濟高效的解決方案。

* DDC網絡方案:由微軟開發的網絡方案,專為大規模分布式訓練而設計。

# 在LLM訓練中的套用:

* 大規模數據並列訓練:GPU/TPU集群網絡支持大規模數據並列訓練,可顯著提高訓練速度。

* 多機多卡訓練:GPU/TPU集群網絡支持多機多卡訓練,可充分利用集群資源,提高訓練效率。

* 分布式訓練:GPU/TPU集群網絡支持分布式訓練,可將訓練任務分配到多個節點並列執行,進一步提高訓練速度。

# 總結:

合理選擇和部署GPU/TPU集群網絡方案,對於LLM訓練的效能至關重要。本文介紹了主流的GPU網絡方案及其在LLM訓練中的套用,可為讀者提供參考和借鑒。我們將探討流行的GPU/TPU集群網絡組網,包括:NVLink、InfiniBand、ROCE乙太網路Fabric、DDC網絡方案等,深入了解它們之間的連線方式以及如何在LLM訓練中發揮作用。為了獲得良好的訓練效能,GPU網絡需要滿足以下條件:

革新訓練效率:端到端延遲最佳化

端到端延遲是影響訓練效率的關鍵因素之一。透過降低節點間數據傳輸的總體延遲,可以有效縮短整體訓練時間。尤其是對於GPU間通訊頻繁的大規模分布式訓練場景,端到端延遲的最佳化尤為重要。

最佳化端到端延遲的方法有很多,例如:

* 最佳化網絡拓撲結構,減少數據傳輸距離。

* 使用高效能網絡介面卡,提高數據傳輸速率。

* 最佳化數據傳輸協定,減少數據傳輸開銷。

* 使用分布式訓練框架,合理分配數據和計算任務,減少通訊量。

透過這些最佳化措施,可以有效降低端到端延遲,從而顯著縮短整體訓練時間,提高訓練效率。由於GPU間通訊頻繁,降低節點間數據傳輸的總體延遲有助於縮短整體訓練時間。

無丟包傳輸:保障AI訓練高效穩定

在AI訓練過程中,無丟包傳輸至關重要,確保訓練數據完整性,避免因數據遺失導致訓練回退和浪費資源。任何梯度或中間結果的遺失都會導致訓練回退到記憶體中儲存的前一個檢查點並重新開始,嚴重影響訓練效能。

無丟包傳輸功能可確保數據在傳輸過程中不會發生遺失,使AI訓練更加高效穩定。對於AI訓練至關重要,因為任何梯度或中間結果的遺失都會導致訓練回退到記憶體中儲存的前一個檢查點並重新開始,嚴重影響訓練效能。

高效的端到端擁塞控制:

- 瞬態擁塞:在樹形拓撲中,多個節點向單個節點傳輸數據時不可避免。

- 永續性擁塞:會增加系統尾延遲。

- GPU之間順序依賴關系:即使一個GPU的梯度更新受到網絡延遲影響,也可能導致多個GPU停運。

- 慢速鏈路:降低訓練效能。在樹形拓撲中,當多個節點向單個節點傳輸數據時,瞬態擁塞不可避免。永續性擁塞會增加系統尾延遲。由於GPU之間存在順序依賴關系,即使一個GPU的梯度更新受到網絡延遲影響,也可能導致多個GPU停運。一個慢速鏈路就足以降低訓練效能。

- 系統總成本:考慮 GPU 架構設計時,應將系統成本作為關鍵因素,包括硬件、軟件和維護費用。

- 功耗和冷卻成本:高效能 GPU 通常功耗較高,因此需要考慮冷卻成本。

- 效能和能效:評估不同 GPU 架構設計,應考慮其計算效能和能效,以最佳化效能和成本。

一、NVLink 交換系統

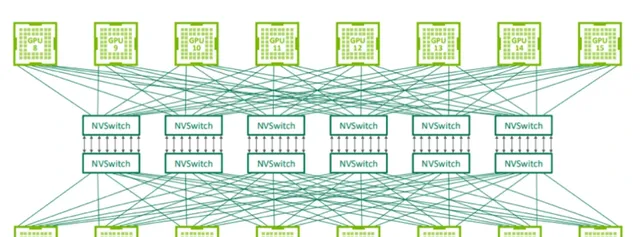

NVLink 交換機:構建 GPU 伺服器間交換網絡

- NVLink 交換機不僅可用於連線 GPU 伺服器中的 GPU,還能構建連線 GPU 伺服器之間的交換網絡。

- Nvidia 在 2022 年的 Hot Chips 大會上展示了使用 NVswitch 架構連線 32 個節點(256 個 GPU)的拓撲結構。

- NVLink 是專門設計為連線 GPU 的高速點對點鏈路,具有比傳統網絡更高的效能和更低的開銷。

- 使用 NVLink 交換機構建 GPU 伺服器間交換網絡,可顯著提升 GPU 伺服器之間的通訊速度和效率,滿足高效能計算、深度學習等套用對網絡頻寬和低延遲的要求。個 GPU 的 NVLink 交換機也可以用於構建連線 GPU 伺服器之間的交換網絡。Nvidia 在 2022 年的 Hot Chips 大會上展示了使用 NVswitch 架構連線 32 個節點(或 256 個 GPU)的拓撲結構。由於 NVLink 是專門設計為連線 GPU 的高速點對點鏈路,所以它具有比傳統網絡更高的效能和更低的開銷。

• 第三代 NVswitch 擁有 64 個 NVLink 埠,提供高達 12.8 Tbps 的交換容量,支持多播和網絡內聚合,減少 GPU 之間的數據傳輸量。

• 網絡內聚合可將所有工作 GPU 生成的梯度匯集到 NVswitches 內部,並將更新的梯度反饋給 GPU,以便進行下一次叠代。

• 此功能可減少訓練叠代過程中 GPU 之間的數據傳輸,從而提高訓練效率。NVswitch 配備 64 個 NVLink 埠,提供高達 12.8Tbps 的交換容量,同時支持多播和網絡內聚合功能。網絡內聚合能夠在 NVswitches 內部匯集所有工作 GPU 生成的梯度,並將更新後的梯度反饋給 GPU,以便進行下一次叠代。這一特點有助於減少訓練叠代過程中 GPU 之間的數據傳輸量。

NVswitch 架構展現出色效能,速度是 InfiniBand 交換網絡的 2 倍。

NVswitch 架構在訓練 -3 模型時展現出了令人矚目的效能,速度是 InfiniBand 交換網絡的 2 倍。這一令人印象深刻的效能提升使其成為大規模人工智能訓練任務的理想選擇。

值得註意的是,NVswitch 架構的頻寬相對較低。

NVswitch 架構的頻寬相較於高端交換機供應商提供的 51.2Tbps 交換機來說,要少 4 倍。這一頻寬限制可能會阻礙其在某些高效能計算應用程式中的使用。NVswitch 架構的速度是 InfiniBand 交換網絡的 2 倍,展現出了令人矚目的效能。然而,值得註意的是,這款交換機的頻寬相較於高端交換機供應商提供的 51.2Tbps 交換機來說,要少 4 倍。

NVSwitch 限制了大規模系統構建的規模和靈活性

NVSwitch 存在兩大局限性,阻礙了大規模系統的構建。

1. 成本高昂且協定受限:

- 建設包含 1000 個以上 GPU 的大型系統時,NVSwitch 的成本極高,且規模越大,成本越難以負擔。

- NVSwitches 協定本身限制了系統擴充套件性,無法支持更大規模的系統。

2. 供應商釘選:

- Nvidia 不單獨出售 NVSwitches,數據中心無法透過混搭 GPU 產品來擴充套件現有集群,因為其他供應商的 GPU 不支持 NVSwitch 介面。

這些局限性使得 NVSwitches 難以被更廣泛地采用,也為數據中心在構建大規模系統時帶來諸多挑戰。NVswitches 構建包含超過 1000 個 GPU 的大規模系統,不僅成本上不可行,還可能受到協定本身的限制,從而無法支持更大規模的系統。此外,Nvidia 不單獨銷售 NVswitches,這意味著如果數據中心希望透過混合搭配不同供應商的 GPU 來擴充套件現有集群,他們將無法使用 NVswitches,因為其他供應商的 GPU 不支持這些介面。

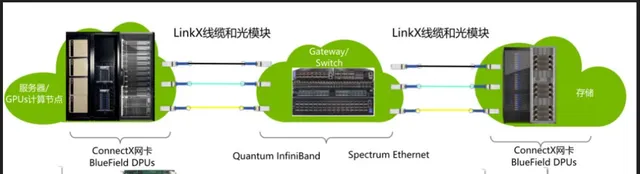

二、InfiniBand 網絡

InfiniBand(簡稱IB)技術,自1999年推出以來,作為高速替代方案,已廣泛用於連線伺服器、儲存和網絡。由於經濟因素,其最初的宏大設想有所收縮,但憑借其卓越的速度、低延遲、無遺失傳輸以及遠端直接記憶體存取(RDMA)功能,InfiniBand仍在高效能計算、人工智能/機器學習集群和數據中心等領域得到了廣泛套用。

InfiniBand的主要優勢包括:

* 卓越的速度:InfiniBand提供高達100 Gbps(甚至更高)的吞吐量,是傳統PCI和PCI-X總線的數十倍。

* 低延遲:InfiniBand的延遲僅為幾微秒,是傳統總線的數千分之一。

* 無遺失傳輸:InfiniBand采用先進的糾錯機制,確保數據在傳輸過程中不會遺失。

* 遠端直接記憶體存取(RDMA):InfiniBand支持RDMA功能,允許應用程式直接存取遠端記憶體,無需經過作業系統,從而大幅提高數據傳輸效率。

憑借這些優勢,InfiniBand已成為高效能計算、人工智能/機器學習集群和數據中心等領域的首選連線技術。

InfiniBand(IB)協定:

- 高效輕量化設計,避免乙太網路開銷。

- 支持基於通道和基於記憶體的通訊,適用多種場景。

- 構建高效數據中心和高效能計算環境的理想選擇。

- IB實作了無丟包傳輸,不會因緩沖區溢位而遺失數據。

- IB支持端點之間的擁塞通知,類似於TCP/IP中的ECN。

- IB提供卓越的服務質素,允許對某些類別的流量進行優先處理,降低延遲,防止丟包。收器材之間的基於信用的流量控制,IB實作了無丟包傳輸(佇列或虛擬通道級別)。這種逐跳的流量控制確保不會由於緩沖區溢位而造成數據遺失。此外,它還支持端點之間的擁塞通知(類似於 TCP/IP 協定棧中的 ECN)。IB提供卓越的服務質素,允許優先處理某些類別的流量以降低延遲和防止丟包。

* RDMA協定支持:所有IB交換機均支持RDMA協定,實作數據在GPU記憶體間的直接傳輸。

* 顯著提升吞吐量:數據傳輸繞過CPU作業系統,顯著提升吞吐量。

* 大幅降低端到端延遲:直接傳輸方式大幅降低端到端延遲,最佳化數據傳輸效能。

InfiniBand交換系統:高效能,但配置和擴充套件具有挑戰性

InfiniBand交換系統在高效能計算環境中具有諸多優點,包括低延遲、高頻寬和可靠性。然而,與乙太網路交換系統相比,InfiniBand系統在配置和擴充套件方面較為困難。

InfiniBand交換系統的擴充套件性可能在擁有32K或更多GPU的網絡中成為挑戰。此外,需要專門的硬件,如主機通道介面卡和電纜,增加了擴充套件成本。

InfiniBand交換系統優點:

- 低延遲:確保即時應用程式的快速響應時間。

- 高頻寬:支持大量數據傳輸,滿足高效能計算的需求。

- 可靠性:提供穩定的連線,減少數據遺失的風險。

InfiniBand交換系統缺點:

- 難以配置和維護:需要專業知識和經驗,可能導致管理和故障排除復雜。

- 擴充套件性有限:在大型集群中,擴充套件性可能成為瓶頸。

- 成本較高:需要特殊硬件,如主機通道介面卡和InfiniBand電纜,導致擴充套件成本增加。

NVIDIA獨領高效能IB交換機市場,引領HPC和AI GPU集群互連

NVIDIA是目前唯一一家提供高端IB交換機的供應商,專門為HPC和AI GPU集群使用而設計。眾多科技巨頭都在使用NVIDIA的高端IB交換機來構建其強大的人工智能集群,包括OpenAI和Meta。

OpenAI在Microsoft Azure雲中使用10,000個NVIDIA A100 GPU和IB交換網絡來訓練他們的-3模型,該模型是世界上最大的語言模型之一。

Meta最近構建了一個包含16K GPU的集群,該集群使用NVIDIA A100 GPU伺服器和Quantum-2 IB交換機,用於訓練其生成式人工智能模型,包括LLaMA。該集群的規模空前,是世界上最大的AI訓練集群之一。

值得註意的是,當連線10,000個以上的GPU時,伺服器內部GPU之間的切換是透過伺服器內的NVswitches完成的,而IB/乙太網路網絡則負責將伺服器連線在一起。

NVIDIA的高端IB交換機以其高效能、低延遲和可延伸性而著稱,是構建HPC和AI GPU集群的理想選擇。隨著人工智能技術的發展,對高效能互連解決方案的需求也將不斷增長,NVIDIA將繼續在這個領域保持領先地位。輝達GTC 2021大會上釋出全新的InfiniBand網絡平台,具有25.6Tbps的交換容量和400Gbps埠)。這個集群被用於訓練他們的生成式人工智能模型,包括LLaMA。值得註意的是,當連線10,000個以上的GPU時,伺服器內部GPU之間的切換是透過伺服器內的NVswitches完成的,而IB/乙太網路網絡則負責將伺服器連線在一起。

乙太網路在超大規模GPU集群中的優勢

* 經濟高效: 乙太網路在許多矽/系統和光模組供應商中形成了強大的生態系,並且以開放標準為目標,實作了供應商之間的互操作性,因此使用乙太網路網絡可能更有意義。

* 可延伸性: 乙太網路可以擴充套件到更大的網絡,以支持更多的GPU。

* 靈活性: 乙太網路可以輕松地重新配置,以適應不同的工作負載。

* 可靠性: 乙太網路是一種可靠的網絡技術,可以確保數據傳輸的可靠性。雲服務提供商正在尋求構建具有32K甚至64K GPU的GPU集群。在這種規模上,從經濟角度來看,使用乙太網路網絡可能更有意義。這是因為乙太網路已經在許多矽/系統和光模組供應商中形成了強大的生態系,並且以開放標準為目標,實作了供應商之間的互操作性。

三、ROCE無失真乙太網路

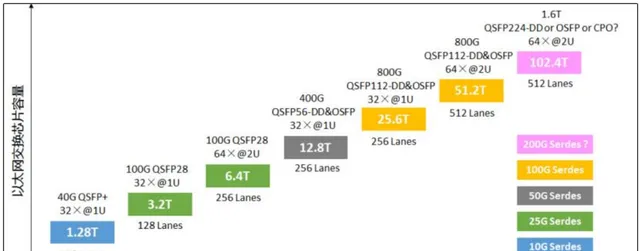

乙太網路:數據中心的互聯霸主

- 速度範圍從1Gbps到800Gbps,未來可達1.6Tbps

- 互連埠速度和總交換容量高於Infiniband

- 價格相對較低,每單位頻寬成本更具競爭力

- 源於高端網絡芯片供應商的激烈競爭

- 更多頻寬整合到ASIC,降低每千兆位成本

乙太網路憑借其卓越的速度、容量和成本優勢,成為數據中心互聯的主流選擇。Infiniband相比,乙太網路在互連埠速度和總交換容量上更勝一籌。此外,乙太網路交換機的價格相對較低,每單位頻寬的成本更具競爭力,這主要歸功於高端網絡芯片供應商之間的激烈競爭,推動了廠商將更多頻寬整合到ASIC中,從而降低了每千兆位的成本。

高端乙太網路交換機ASIC的效能是輝達GTC 2021大會上釋出的InfiniBand網絡平台Quantum-2的兩倍,交換容量高達51.2Tbps,配備800Gbps埠。這意味著,如果交換機的吞吐量翻倍,構建GPU網絡所需的交換機數量可以減少一半。這種高效能交換機可以顯著提高網絡效率,降低構建和營運成本。(輝達GTC 2021大會上釋出全新的InfiniBand網絡平台,具有25.6Tbps的交換容量和400Gbps埠))的兩倍。這意味著,如果交換機的吞吐量翻倍,構建GPU網絡所需的交換機數量可以減少一半。

* 乙太網路提供無丟包傳輸服務,可確保關鍵數據暢通無阻。

* 透過優先流量控制 (PFC) 實作,支持 8 個服務類別和無丟包類別。

* 在處理和透過交換機時,無丟包流量享有優先級,即使在網絡擁塞時。

* 交換機或網卡透過流量控制管理上遊器材,避免丟棄封包。

* 無丟包傳輸服務對於關鍵套用至關重要,如金融交易、醫療保健和工業自動化。

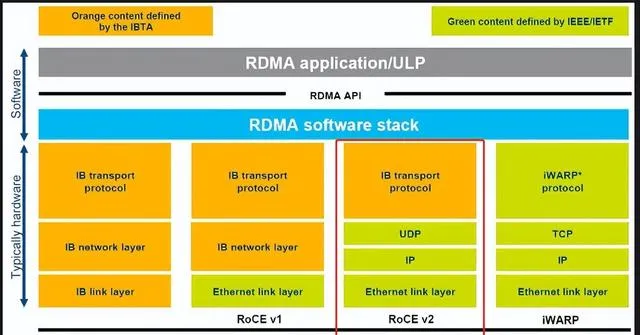

萬兆乙太網路RDMA技術最佳化方案

* 基於RoCEv2(RDMA over Converged Ethernet)實作RDMA(遠端直接記憶體存取)。

* RDMA封包透過IP/UDP封裝,直接傳輸到GPU伺服器中的網絡介面卡(NIC)的記憶體中,無需CPU介入。

* 部署DCQCN等端到端擁塞控制方案,降低RDMA的端到端擁塞和丟包。

方案優勢

* 高效能:RDMA透過直接存取GPU記憶體,避免了CPU的介入,從而提高了數據傳輸速度。

* 低延遲:RDMA減少了數據傳輸的延遲,從而提高了套用的效能。

* 高可靠性:DCQCN等擁塞控制方案可以降低RDMA的端到端擁塞和丟包,從而提高了數據的可靠性。幀被封裝在IP/UDP內。當RoCEv2封包到達GPU伺服器中的網絡介面卡(NIC)時,NIC可以直接將RDMA數據傳輸到GPU的記憶體中,無需CPU介入。同時,可以部署如DCQCN等強大的端到端擁塞控制方案,以降低RDMA的端到端擁塞和丟包。

* 負載均衡:

BGP(邊界閘道器協定)使用ECMP(等價路徑多路徑路由)來在具有相等代價的路徑上分發封包。

* 哈希分配:

交換機使用哈希函數來分配封包的路徑。

* 負載不均:

哈希分配並不總是完善,可能導致某些鏈路負載不均,造成網絡擁塞。不總是完美的,可能會導致某些鏈路負載不均,造成網絡擁塞。

* 預留輕微過量的頻寬,以避免擁塞。

* 實作自適應負載均衡,將封包路由到最優路徑。

* 使用 RoCEv2 的封包級負載均衡,將封包均勻分散在可用鏈路上。

* 確保網卡支持在 RoCE 傳輸層上處理無序數據,確保 GPU 接收到的數據是有序的。

這些策略有助於解決頻寬擁塞問題,並提高網絡效能。將新流的封包路由到其他埠。許多交換機已經支持此功能。此外,RoCEv2的封包級負載均衡可以將封包均勻地分散在所有可用鏈路上,以保持鏈路平衡。但這可能導致封包無序到達目的地,需要網卡支持在RoCE傳輸層上處理這些無序數據,確保GPU接收到的數據是有序的。這需要網卡和乙太網路交換機的額外硬件支持。

* 部份廠商的 ROCE 乙太網路交換機可聚合來自 GPU 的梯度,減少訓練過程中的 GPU 間流量。

* 例如,Nvidia 的高端乙太網路交換機具有此功能。

* 高端太網交換機和網卡提供了強大的擁塞控制、負載均衡功能和RDMA支持,可延伸到比IB交換機更大的設計。

* 雲服務提供商和大規模集群的公司已開始使用基於乙太網路的GPU網絡,以連線超過32K的GPU。

* 太網交換機和網卡的優勢在於,它們比IB交換機具有更高的埠密度、更低的功耗和更低的成本。太網交換機和網卡具備強大的擁塞控制、負載均衡功能和RDMA支持,可以擴充套件到比IB交換機更大的設計。一些雲服務提供商和大規模集群的公司已經開始使用基於乙太網路的GPU網絡,以連線超過32K的GPU。

四、DDC全排程網絡

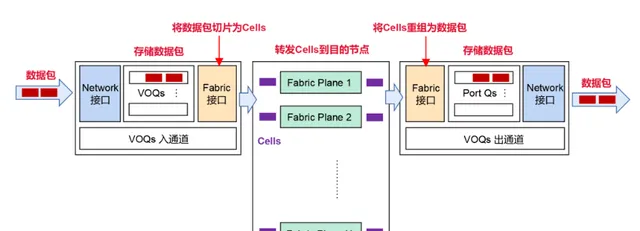

全排程網絡技術革新,引領數據中心互聯新潮流

近年來,交換機/路由器芯片供應商紛紛推出支持全排程Fabric或AI Fabric的芯片,這項技術革新為數據中心互聯帶來了新的機遇。

全排程網絡實際上已在模組化機箱設計中套用十余年,如Juniper的PTX系列路由器采用虛擬出口佇列(VOQ)網絡,實作了全排程網絡。

全排程網絡具有眾多優勢,包括:

- 提高網絡利用率

- 降低延遲

- 簡化網絡管理

全排程網絡技術為數據中心互聯提供了更靈活、更可延伸、更高效的解決方案,有望引領數據中心互聯新潮流。

- VOQ架構中,封包僅在入口葉子交換機中進行一次緩沖,減少了緩沖次數和網絡延遲。

- VOQ為整個系統中的每個輸出佇列提供緩沖空間,每個VOQ的大小足以容納封包在40-70微秒內遇到擁塞時的封包,滿足了高效能網絡的嚴格要求。

- VOQ采用片上緩沖區和外部記憶體中的深度緩沖區相結合的方式,提高了數據緩沖區的容量和靈活性。

當入口葉子交換機檢測到某個 VOQ 佇列中累積了多個封包,它會向出口交換機發出請求,要求在網絡中傳輸這些封包。該請求透過網絡傳輸,到達出口葉子交換機。

- 出口葉子交換機中的排程器可批準佇列的請求,但速率有限制,避免過度訂閱交換機鏈路。

- 排程器根據嚴格的排程層次以及淺輸出緩沖區中的可用空間來批準請求。

- 這有助於防止交換機鏈路過載,並確保佇列服務質素。排程器根據嚴格的排程層次以及其淺輸出緩沖區中的可用空間來批準這些請求。這些批準的速率受到限制,以避免過度訂閱交換機鏈路(超出佇列緩存接受範圍)。

智能交換機器材可處理到達入口葉子交換機的批準,並將批準的封包透過所有可用上行鏈路轉發至出口,從而實作高效的網絡數據傳輸。

封包負載均衡和有序傳輸

發送到特定VOQ的封包可以均勻地分散在所有可用的輸出鏈路上,實作完美的負載均衡。然而,出口交換機配備了邏輯功能,可以將這些封包按順序重新排列,然後將它們傳輸到GPU節點,避免封包的重新排序。

出口排程器在數據進入交換機前就對已批準的數據進行控制,有效消除乙太網路數據面中99%由incast引起的擁塞問題,並完全消除頭阻塞問題。值得一提的是,數據仍然透過乙太網路進行傳輸,包括請求和批準。排程器在數據進入交換機之前就對已批準的數據進行了控制,從而避免了鏈路頻寬的超額使用,因此消除了乙太網路數據面中99%由incast引起的擁塞問題(當多個埠嘗試向單個輸出埠發送流量時),並且完全消除了頭阻塞(HOL blocking)。需要指出的是,在這種架構中,數據(包括請求和批準)仍然是透過乙太網路進行傳輸的。

頭阻塞(HOL blocking):數據傳輸的絆腳石

頭阻塞是指網絡傳輸中,第一個封包受阻後,所有後續封包都會被阻塞,無法繼續傳輸。這種現象會極大地影響網絡傳輸效率和效能。

頭阻塞常見原因:

* 網絡擁塞導致封包遺失或延遲。

* 路由器或交換機配置不當,導致封包無法正確轉發。

* 防火墻或其他網絡安全器材阻止封包透過。

解決方案:

* 最佳化網絡頻寬和配置,減少擁塞並防止封包遺失。

* 正確配置路由器和交換機,確保封包能夠正確轉發。

* 調整防火墻或安全器材的規則,允許必要的封包透過。

防止頭阻塞的發生,可以提高網絡傳輸效率和效能。HOL blocking)是指在網絡傳輸中,一列封包中的第一個封包如果遇到阻礙,會導致後面所有的封包也被阻塞,無法繼續傳輸,即使後面的封包的目標輸出埠是空閑的。這種現象會嚴重影響網絡的傳輸效率和效能。

先進的網絡架構,例如 Juniper 的 Express 和 Broadcom 的 Jericho 系列,采用專有的分段化(cellified)數據面,實作了虛擬輸出佇列(VOQ)技術。

這種架構可顯著提高網絡效能和可延伸性,滿足當今數據中心和雲端運算領域對高吞吐量和低延遲的需求。

VOQ 技術可有效降低網絡擁塞,並確保封包按順序處理,從而最佳化數據傳輸的效率和可靠性。cellified)數據面實作了虛擬輸出佇列(VOQ)。

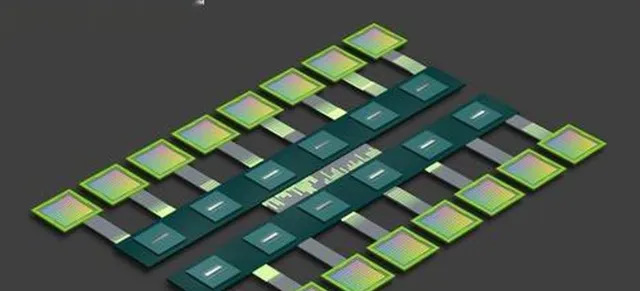

分段數據面技術:提高鏈路利用率,減少延遲

分段數據面技術是一種新型的數據交換技術,它將封包分割成固定大小的分段,並在所有可用的輸出鏈路上均勻分布這些分段,從而提高鏈路利用率。

與在封包級別進行均勻分布相比,分段數據面技術可以避免輸出鏈路上的另一個儲存/轉發延遲(出口乙太網路介面),並減少 VOQ 數據面的總體延遲。

分段數據面技術還可以使用功耗更低、延遲更短的客製交換機來替代用於轉發分段的 spine 交換機,從而進一步減少延遲和功耗。

因此,分段數據面技術是一種可以同時提高鏈路利用率、減少延遲和降低功耗的新型數據交換技術。

具體優勢:

- 提高鏈路利用率:因為混合使用大型和小型封包很難充分利用所有鏈路,而分段轉發可以將封包分割為固定大小的分段,並在所有可用的輸出鏈路上均勻分布這些分段,從而提高鏈路利用率。

- 減少延遲:分段轉發可以避免輸出鏈路上的另一個儲存/轉發延遲(出口乙太網路介面),並使用功耗更低、延遲更短的客製交換機來替代用於轉發分段的 spine 交換機,從而進一步減少延遲。

- 降低功耗:分段數據面交換機在功耗方面優於乙太網路交換機,因為它們不需要支持L2交換的開銷,從而降低功耗。

VOQ架構確實存在一些局限性:

葉子交換機的入口緩沖區大小應與系統中所有虛擬輸出佇列 (VOQ) 在擁塞期間緩沖封包的需求成正比。緩沖區大小與 GPU 的數量和每個 GPU 的優先級佇列數量直接相關,GPU 規模越大,入口緩沖區需求也越大。合理的緩沖區大小有助於確保封包在網絡擁塞期間不會遺失,從而提高網絡效能和可靠性。入口端應具有合理的緩沖區,以供系統中所有VOQ在擁塞期間緩沖封包。緩沖區大小與GPU數量及每個GPU的優先級佇列數量成正比。GPU規模較大直接導致更大的入口緩沖區需求。

出口佇列緩沖區應設計為能夠覆蓋數據面往返延遲,以避免在請求-批準握手期間這些緩沖區耗盡。在較大型的GPU集群中,使用3級數據面時的往返延遲可能比使用單級數據面時的往返延遲大。如果出口佇列緩沖區未適當調整以適應增加的往返延遲,輸出鏈路將無法達到100%的利用率,從而降低系統的效能。級數據面時,由於光纜延遲和額外交換機的存在,此往返延遲可能會增加。如果出口佇列緩沖區未適當調整以適應增加的往返延遲,輸出鏈路將無法達到100%的利用率,從而降低系統的效能。

* VOQ系統透過出口排程改善尾部延遲,但引入額外往返延遲。

* 入口葉交換機在發送封包前需要請求批準,增加延遲。

* 最小延遲增加與出口阻塞和入口請求-批準握手相關。

透過全排程VOQ最佳化GPU集群中的網絡效能

充分利用全排程VOQ架構的優勢,緩解延遲並提高吞吐量。全排程VOQ (fabric) 在降低延遲上的效能優於乙太網路流量,尤其在鏈路利用率超過90%的情況下。若可接受相應的成本投入,可以透過增加緩沖區的方式提高鏈路利用率,在擴大GPU規模時值得投資。

供應商釘選限制了交換機混合使用。

由於每個供應商都使用專有協定,因此在同一fabric中混合使用和匹配交換機變得非常困難。這種供應商釘選限制了數據中心在選擇交換機時的靈活性,並可能導致更高的成本和更復雜的管理。

總結:主流GPU集群組網技術套用情況

NVLink交換系統,專為GPU間通訊而生,提供了業界領先的解決方案。但其主要套用於伺服器內部的GPU通訊,或小規模跨伺服器節點間的數據傳輸,對大規模GPU集群互連支持有限。交換系統雖然為GPU間通訊提供了有效解決方案,但其支持的GPU規模相對有限,主要套用於伺服器內部的GPU通訊以及小規模跨伺服器節點間的數據傳輸。

InfiniBand網絡以其無擁塞、低延遲的特性在數據中心網絡中占據重要地位。然而,由於其封閉的架構和較高的成本,它更適用於中小規模且對有線連線有需求的客戶群體。網絡作為一種原生的RDMA網絡,在無擁塞和低延遲環境下表現卓越。然而,由於其架構相對封閉且成本較高,它更適用於中小規模且對有線連線有需求的客戶群體。

ROCE無失真乙太網路優勢

- 成熟的乙太網路生態,組網成本最低。

- 最快的頻寬叠代速度,可滿足中大型訓練GPU集群對高頻寬的需求。

- 適用性更廣,在中大型訓練GPU集群場景中展現出更高的適用性。則憑借其依托成熟的乙太網路生態、最低的組網成本以及最快的頻寬叠代速度,在中大型訓練GPU集群的場景中展現出更高的適用性。

DDC 全排程網絡將信元交換與虛擬輸出佇列 (VOQ) 技術相結合,有效解決乙太網路擁塞問題。作為新興技術,業界正在評估其長期潛力和套用前景,目前處於研究階段。,它結合了信元交換和虛擬輸出佇列(VOQ)技術,因此在解決乙太網路擁塞問題方面有著顯著的優勢。作為一種新興技術,目前業界各家仍處於研究階段,以評估其長期潛力和套用前景。