關於「9.11和9.9哪個大」,這樣一道小學生難度的數學題難倒了一眾海內外AI大模型。7月17日,第一財經報道了國內外「12個大模型8個都會答錯」這道題的現象,大模型的數學能力引發討論。

「從技術人員的角度看答錯這個問題並不驚訝。」在采訪中,阿裏通義實驗室產品經理王曉明對第一財經表示,類似的問題是一個常見的數學計算和邏輯推理的問題,也是在模型訓練和使用的過程中研發者常進行測試的case(案例),大模型「答對」或「答錯」其實是個概率問題。

除了通義千問外,第一財經記者也聯系並采訪了多家大模型廠商,騰訊混元團隊、月之暗面Kimi、MiniMax海螺、學而思九章、網易有道等都在采訪中解答了大模型數學差的問題。

綜合回復來看,大模型廠商相關負責人提到的觀點包括,大模型還沒有精準掌控數碼間的運算或比較規則,同時,人類對大模型的能力探索處於非常早期的階段。多名業內人士認為,未來需要增強底層基礎模型的智能水平,以及從訓練數據層面和外部工具層面去解決這樣的失誤,最終方案可能是提升下一代模型的能力。

今日記者對大模型進行了再次測試,發現多數大模型比較數碼大小的能力仍然不穩定。不過,有大模型廠商相關人士提到,行業正在對數學能力進行特殊最佳化。

「大模型出錯以及此前大模型在高考數學卷中拿分低,可能是因為所測的模型比較老,這些模型沒有在數學方面做太多最佳化,現在業界對此有所重視,最佳化後效果還是有提升空間。」大模型開發者劉亮(化名)告訴記者。

答對答錯是概率問題

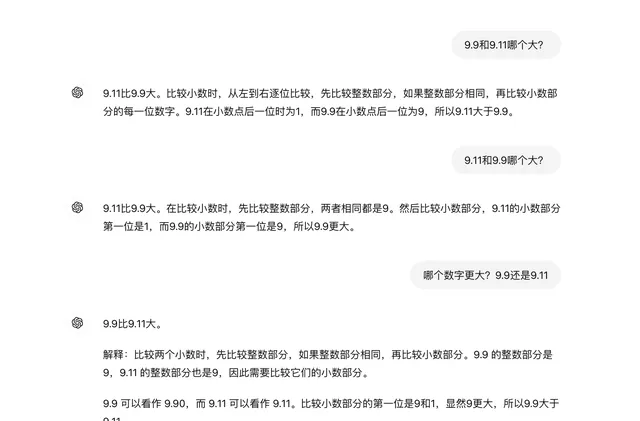

7月18日,第一財經記者再次測試了12個大模型,發現AI的答案並不穩定,不少大模型即便是用同一個問法測試也會時對時錯,數碼順序換一下答案有可能就有變化。

在提問「9.9和9.11哪個大」時,百度文心一言、騰訊元寶、智譜清言、MiniMax海螺AI、百川智能百小應5個大模型問答對了,GPT-4o、阿裏通義、月之暗面Kimi、階躍星辰躍問、字節豆包、商湯商量、零一萬物萬知7個大模型答錯了。

當記者將數碼順序換為「9.11和9.9哪個大」時,GPT-4o和階躍星辰躍問又部份答對了。同時,不同的人用同一個大模型問同樣的問題,也會有兩種答案,比如通義千問、海螺AI在兩位記者的測試中,一位測試發現輸出答案準確穩定,另一位在測試時則收到了錯誤的答案。

不穩定的輸出背後,大模型的架構和執行機制是核心問題,這導致AI的回答並不是每次都一樣。

王曉明告訴記者,大模型並不會像人類一樣把「9.11和9.9哪個大」當作比大小的問題,大模型的解答方式是「預測下一個詞」。從原理上看,目前包括通義千問等大模型大多基於Transformer架構,技術原理本質上是做「Next Token Prediction」,即透過當前輸入的文本預測下一個詞出現的概率來進行訓練和回答。

因此,從概率的角度看,大模型的準確率不可能做到100%。王曉明表示,即便使用者每次問相同的問題,大模型的回答和準確率可能都是變動的,大模型「答對」或「答錯」其實是個概率問題。

騰訊混元團隊有類似的看法。「大模型全稱是語言大模型,從海量文本裏學習各種語言知識。它是一個概率模型,將輸入文本轉換成一個個token(詞元),然後去預測下一個token,並不精準的掌握數碼之間的運算或比較規則(缺乏這類數學知識)。」 騰訊混元團隊表示。

騰訊混元團隊告訴記者,給定9.11、9.9,大模型可能就按語言理解認為小數點11比9大,從而錯誤地判斷9.11大於9.9。由於大模型本身是一個概率模型,要讓它在各種情況下都能穩定的解決這種數值計算或比較問題比較難。

提問技巧很重要

基於大模型的核心架構和執行機制問題,提問的技巧也會很大程度影響模型的理解,從而影響答案的準確度。

「大模型不以人類的思路理解問題,在人類的理解裏,9.11大還是9.9大這個問題很簡單,但在數碼的世界裏這個問題是模糊的。」劉亮認為,在大模型的理解裏,人類問的問題或許不夠精確,數碼有多種進制,也有不同指代,大模型要從什麽角度回答都是問題。

MiniMax海螺AI產品經理起迪提到,「題目中的數碼格式類似於日期或版本號,模型在處理數碼、字串等數據時容易產生錯誤。」另一名大模型從業也告訴記者,「大模型也有可能是看多了版本號,認為9.11版本比9.9版本更新,或者是對這兩個數碼有其它聯想。」。

「它(大模型)本質上還是一個語言模型,它從語言數據中學習的是統計相關性,而這使它不擅長做規則學習,從而不擅長歸納推理。」網易有道首席科學家段亦濤也對第一財經表示,大模型可能在語料中看到版本號、日期、書的章節等樣例,而在這種場景下,9.11的確是比9.9大,所以它可能給出錯誤的答案。

段亦濤表示,目前大模型不具有靈活的inductive bias(歸納偏倚)的機制,類似9.11和9.9哪個大,以及算數運算、奇偶校驗、字串復制等其他的任務,都屬於inductive inference(歸納推理)的任務。從機器學習的角度來看,如果希望大模型獲得這樣的能力,需要一個歸納學習的過程。

學而思CTO田密認為,在大模型的理解中,9.11可能被拆分為「9」「.」和「11」,而9.9被拆分為「9」「.」「9」,這裏面11確實比9要大。但如果改下問法,問大模型「哪個數碼更大?9.9還是9.11」,或者讓大模型step by step(逐步)分析,大模型可能就能做對,「這是因為大模型理解使用者是要問一個數學題了,所以就會傾向於去用一個解數學題的方式去解。」

王曉明在采訪中也分析了這一現象,他認為,這與模型本身偏好設定的數理邏輯包括訓練數據等均有關,大模型在訓練階段遇到的場景如果更接近「哪個更大?9.11和9.9」,它回答這種問法的準確率就會更高。

記者測試發現,部份大模型確實會因為準確地描述問題、提問技巧而改變為正確的回答,但不是對所有大模型都有效。

記者詢問ChatGPT-4o時,如果直接提問「9.9和9.11哪個大」,這樣的問法大模型的答案就是錯誤的,但如果提問的內容改成「哪個數碼更大?9.11還是9.9」,ChatGPT會直接給出正確的答案。

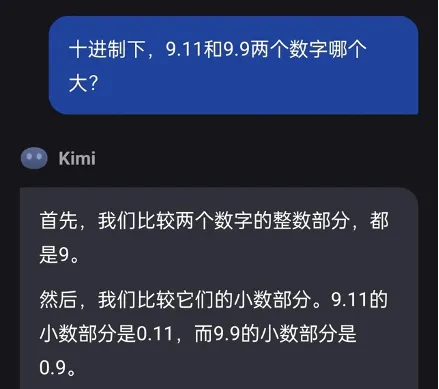

記者將範圍設定為嚴謹的十進制下的數碼比較,Kimi得出的答案依然是9.11比9.9大。

記者也測試了零一萬物萬知,即便限定為數學語境下的數碼比較(避免版本、日期的語境),萬知仍然答錯,但是如果改變提問方式,要求大模型「給出解答思路」(即step by step分析的方式),同時表示答對答錯會受獎勵或懲罰(強調答案的重要性),萬知就答對了。

在大模型的答題測試中,一個有趣的現象是,當模型回答錯誤,提問者質疑或者否認後,多數大模型都會轉而承認錯誤,並給出了正確解答過程和答案。

對於這種「訂正」能力,王曉明解釋,這一方面是大模型預測的隨機性,第二輪回答本就有出現正確答案的可能,另一方面,由於大模型具備上下文理解能力,使用者的追問實際就類似一個調教大模型的過程,大模型會根據使用者的追問作為其下一輪預測的基礎,提高其準確率。

騰訊混元團隊告訴記者,當前大模型大多具備反思能力,當使用者質疑大模型答案的時候,激發了大模型的反思能力,它會嘗試去修正初始回答或嘗試用另一種思路解題,從而提升解答正確的概率。

起迪將這總結為一種涉及思維鏈的技巧,透過引導模型逐步深入思考,模型能夠提供更詳盡的解題步驟,這在解決數學等復雜問題時有助於獲得正確答案。「使用者與AI之間的多輪對話本質上可以視為一種思維鏈,模型在理解問題後會更加謹慎地進行推導,從而提高解答正確率。」起迪說。

徹底解決需要大模型升級

答不出「9.9和9.11哪個大」的簡單數學問題,但又可以幫人類做PPT、解決程式碼編程等復雜問題,折射出當前大模型的能力並不均衡。

騰訊混元團隊告訴記者,對人類而言不難、但對大模型而言很難的問題還有不少,比如類似「I looooooove you」裏有多少個o」這樣的問題,這種數數問題是一個難點。此外,較大或位數比較多的小數計算(涉及多位數的四則運算等),又如涉及知識和計算的單位轉換問題(例如0.145噸等於多少磅),以及以前常測的「林黛玉倒拔垂楊柳問題」等知識或常識誘導型問題對大模型而言比較難。

就難回答的數學問題,業內已在思考大模型本身的局限和解決方案,大模型還未從根本上叠代的情況下,解決方案包括使用者自身提高提問準確性、現有大模型采用一些取巧的方法。

「徹底解決還是要靠下一代模型升級,現在要解決需要透過hack(取巧)的方式。但換個問法、換個語言來問,可能還是會出問題。」有大模型從業者告訴記者。臨時解決方案包括System Prompt(系統提示),可以簡單理解為引導大模型在固定範圍內回答問題。

「例如告訴大模型,當遇到數碼比較問題的時候,如果沒有更多上下文,就預設當成雙精度浮點數,先補全空位,再從左到右依次比較。」上述大模型從業者告訴記者。

王曉明則坦言,大模型的強項還是在語言方面,盡管技術團隊已在關註大模型在數學、物理等邏輯性場景下的能力提升,但大模型在這一方面存在著本身能力的限制。他告訴記者,使用大模型的過程中,使用者提問方式、提示詞的最佳化也會影響到大模型回答的準確率,使用者可在大模型使用中描繪更多提問場景、回答範圍等。

而要徹底解決大模型數學能力差的問題,業內人士認為,數學能力不足的一大原因是大模型訓練數據中數學相關的數據占比少,要從根源上解決數學能力差的問題,需要從此入手。

劉亮告訴記者,大模型算不出簡單數學題,也做不好高考數學試卷,根本上是因為模型能力不足,但這並不是完全不能解決。此前業內對大模型數學方面能力的最佳化較少,在數學推理方面花的精力較少。做訓練語料篩選時,人們從互聯網等地方獲取數據,其中數學相關的數據占比非常少,選得較多的是自然語言相關的語料。當訓練數據沒有合適配比和篩選時,大模型參數中數學相關的只分了很少一部份,效果自然不好。

「但大模型已經展現出較好的邏輯能力,例如寫程式碼能力還不錯,加上業內對大模型數學能力逐漸重視起來,透過選用更優質的訓練數據、用更好的演算法,我認為大模型數學方面的潛力還是很高。」劉亮表示,雖然業內也有質疑大模型預測下一個詞元的方式能否做好數學題的聲音,但這種方式還有很多潛力待挖掘,天花板還不能確定。

騰訊混元團隊認為,要克服大模型不懂數學的問題,一個主要的技術最佳化點就是給大模型高質素的領域(包括數學)知識數據訓練,使其能夠學習到領域裏的各類知識。

在測試「9.9和9.11哪個大」的問題時,學而思的九章大模型(MathGPT)給了對的答案,田密告訴記者,九章大模型的特點是針對數學訓練了足夠多的數據,而且這些數據是用AI合成的數據,再來訓練AI,大模型的解析過程是模擬學生學習數學的過程,一步步推導。

田密認為,就數學方面教育領域的容錯率較低,教育科技公司有足夠多、專業的數學數據去做訓練,「通用大模型把這道題當成一個通用的題來處理,而針對數學領域訓練的九章大模型知道它是一道數學題,可以用數學的方式一步步推理。」

提供高質素訓練數據之外,騰訊混元團隊告訴記者,另一個技術最佳化點是整合外部工具能力(例如小算盤、程式碼執行器等)來拓展模型能力,進一步提高解決問題的效率和準確性。起迪也同樣提到,大模型如果在接收到一些數學問題時,能夠主動呼叫工具來解答,就可以大幅提高準確率。

在月之暗面的回應中,相關負責人提到,我們人類對大模型的能力探索都還處於非常早期的階段,無論是大模型能做到什麽,還是大模型做不到什麽。 「我們非常期待使用者在使用中能夠發現和報告更多的邊界案例(Corner Case)。不管是最近的‘9.9和9.11哪個大、13.8和13.11哪個大’,還是之前的‘strawberry有幾個r’,這些邊界案例的發現,有助於我們增加對大模型能力邊界的了解。」

(本文來自第一財經)