2月18日,NVIDIA首次推出了基于GeForce硬件本地应用的生成式AI,也就是「Chat With RTX」,顾名思义,它是NVIDIA借助RTX加速等技术提供的一种对话机器人。它的技术演示版现已开放免费下载,使用RTX 30系或更高版本GPU(且显存至少为8GB)的用户可以进行本地部署使用。

目前全球已经有以千万计人使用云端的AI对话服务,Chat with RTX与现有的此类应用有哪些区别呢?

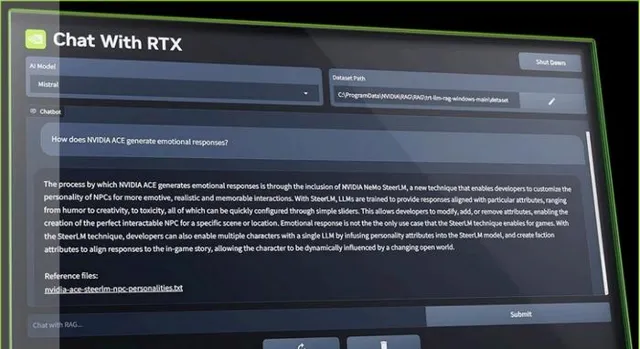

Chat with RTX 借助检索增强生成(RAG)、NVIDIA TensorRT-LLM(大语言模型)软件及 NVIDIA RTX加速技术,将生成式AI功能引入本地Windows PC。用户可快速轻松地将本地资料作为数据集,连接到Mistral或Llama 2这一类开源大型语言模型。

具体而言,Chat with RTX可以承担类似搜索引擎的功能,类似于office中copilot的一部分,直接从选定的文件等资料中查找内容,并为你归纳出解答。

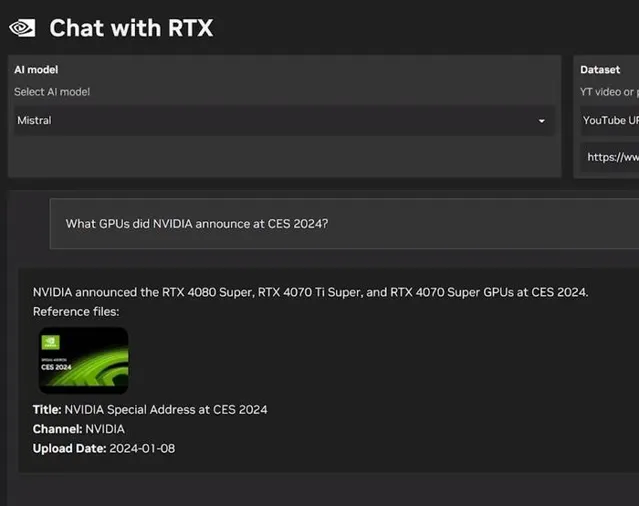

Chat With RTX支持多种文件格式,包括文本文件、pdf、doc/docx和xml。用户只需在该应用中指定包含目标文件的文件夹,该应用便会在几秒内将目标文件加载到库中。不仅如此,我们还可以提供油管等视频网站链接,然后该应用会自动加载视频与播放列表的信息,使我们能够直接查询其中包含的内容。

Chat With RTX最主要的特点就在于本地部署,以及在多数时候使用本地数据,而不依赖云端环境,这一点与AI绘图应用Stable Diffusion类似,Chat with RTX能够在 PC 桌面端帮助用户处理敏感资料,无需分享给第三方或是连接到网络。

NVIDIA表示,Chat With RTX技术演示版基于GitHub中的 TensorRT-LLM RAG开发者参考项目构建而成。开发者可以借鉴该参考项目,自行开发和部署面向RTX、基于RAG且由TensorRT-LLM加速的应用。

小结

伴随着OpenAI Sora大模型、Chat with RTX等应用在近期诞生,我们对AI未来的想象力也日益丰富,无论是借助云端还是依托本地数据,AI都从某个角度展现其应用前景,有望成为生产力的一环。

畅想一下,也许我们可以借助本地AI助手,就实现更加高效的编辑功能,不仅限于大段资料的归纳总结,也许还可以「基于这个表格内数据,帮我生成一个美观的折线图」,或是「概述这份文本资料,帮我做一个10页的PPT」,又或者「帮我看完这部电影,描述一下它的剧情结构,并生成一份拉片(记录每个镜头的分镜、运镜、景别、音效等内容)文档」之类的深度用法。

目前本地运行的Chat with RTX只是演示版本状态,功能尚且比较简单,支持的资料类型与网址也不够多,期待这个项目能够持续进化。如果能够成为基于GeForce RTX硬件的本地版「Copilot」,将会对大量的用户带来更多价值。