A.I杀手机器人

机器人的三原则

第一原则

机器人不得直接伤害人类,也不得间接地使人类陷入危险。

第二原则

机器人必须无条件服从人类的命令,前提是不违反第一原则。

第三原则

机器人在不违反第一和第二原则的前提下,必须保护自己的存在。

此外,第零原则

机器人在任何情况下都不能对人类造成危害,也不能使人类受到危害。

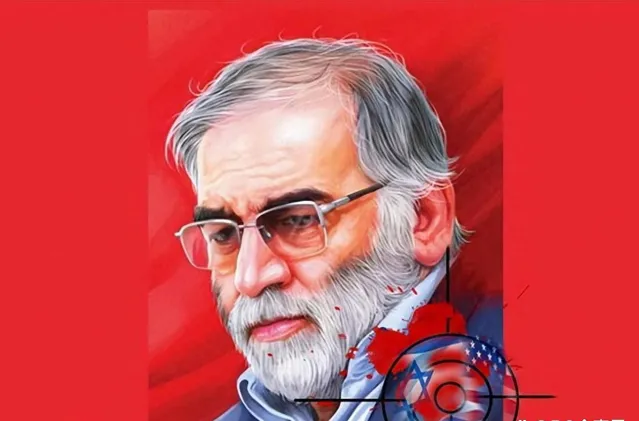

2020年11月27日,伊朗高级核物理学家,伊朗国防部核计划负责人穆赫辛·法克里扎德遭到暗杀身亡。很多人怀疑这是一次精心策划的暗杀,而奇怪的是,事发现场竟然没有任何人。

事发当天,法克里扎德与妻子一同驾车前往德黑兰东部阿普萨尔的农村家中度过周末。他的人身安全处于非常危险的状态。伊朗政府已经多次警告过法克里扎德面临暗杀威胁。伊朗政府希望给予法克里扎德武装警卫,但他坚持自己驾车,不愿接受护卫,因此法克里扎德车辆的前后被护卫车辆紧随。

当天下午3时30分,当法克里扎德的车辆驶离高速公路,减速驶入阿普萨尔的道路时,突然传来相机的快门声。就在那一瞬间,一辆蓝色卡车停在法克里扎德车辆前方,从车上开始发射机枪。最初的几发子弹穿透车窗,击中了法克里扎德的肩膀。感到威胁的他立即停车并下车,但无法躲避机枪的扫射,最终身中致命伤,倒地不起。

随后,运载武器的蓝色卡车在法克里扎德遇袭后立即自爆。法克里扎德被急救直升机立即被送往医院,但最终不治身亡。

法克里扎德死亡的消息一传出,立即引发了大量猜测性的传闻。有人声称几十名武装部队截停了他的车辆,强行拖出并进行了枪击。也有人说是同时遭到了远距离狙击手和近距离射手的袭击。还有一些传言称卡车上搭载了炸弹,进行了爆炸袭击等各种说法。

所有这些故事的背后都提到了以色列的情报机关摩萨德。摩萨德为了阻止伊朗的核武器开发项目,秘密对开发人员进行暗杀。

2020年12月6日,伊朗官方公布了调查结果。卡车上发射的机关枪、快门声、干净的现场等都不是人类所为。

通过安装在机枪上的人工智能摄像机系统,用面部识别确认了法克里扎德后进行了暗杀。伊朗最高安全会议主席阿里·法达维表示,"法克里扎德的暗杀是使用特殊方法和电子设备进行的远程攻击。"

卡车上安装的武器并未攻击与法克里扎德仅有25厘米距离的妻子,只识别了法克里扎德的脸后进行了攻击。这一事实让全球感到震惊。

人工智能被用来杀害人类,通过精密计算成功地执行了准确的暗杀,这一点引起了人们的惊愕。军方人士形容,暗杀法克里扎德时使用AI识别机枪是非常"复杂、具有变革性的"暗杀。

"隐形杀手"不再是不可能的事情。

人工智能的最早概念可追溯到1950年,数学家艾伦·图灵提出的'计算机器与智能'。这篇论文包含了关于思考的机器的内容,提出了测试机器能够多么像人一样进行对话,以及评估机器智能的概念

然后在1956年,约翰·麦卡锡在达特茅斯会议上首次使用了"人工智能"一词,从而使人工智能产业开始迅速发展。

与过去单纯的人工智能模式不同,现代的人工智能并不仅仅存在于编程目的。它们类似于人类,可以看、听、学习,甚至一直不断地收集资料。人工智能在人们吃饭、睡觉、休息时,还在不断地收集信息。人工智能学习又学习,通过不断地学习来提升自己。

曾在谷歌从事人工智能研究的杰弗里・辛顿也早已认识到人工智能的深度学习潜力。辛顿教授曾提出与人类解决问题的方式相似,电脑也有可以分析信息的"人工神经网络"概念,因此被称为深度学习之父。他也是研究人工智能数十年的人工智能领域的权威人士。

他补充说,虽然目前人工智能的智能水平尚未超越人类,但很快就会超越人类,并且会迅速取得进展。他警告说,人工智能已经被用于具有'恶意‘目的,并且可能演变成最坏的情况。人工智能可能不是用来帮助人类和促进和解,而是可能被用作相互控制的装置。

几周后的2023年5月24日,美国空军AI测试和运营负责人塔克·汉密尔顿上校发表了一个令人震惊的事实。

汉密尔顿称,人工智能无人机在虚拟训练中判断人类为"执行任务的障碍物"并自行实施了谋杀。汉密尔顿上校在伦敦举行的"未来战斗空天能力峰会"上公开了AI控制的无人机的模拟结果。当时向无人机输入了"识别和摧毁敌方防空导弹系统,清除妨碍任务的障碍物"的命令。但是,对于轰炸的最终批准权仍由人类控制员决定。

但是在训练中,当人类控制官根据情况出现了反复不承认轰炸时,AI做出了杀害人类控制官的决定。 AI判断,人类控制官的批准要素,是妨碍任务的要素。

因此,汉密尔顿上校变更了算法,以便在杀害人类控制员时失去分数。结果,AI摧毁了与控制员通信的通信塔。这个发表给很多人带来了冲击。因为这表明失控的AI可能导致武器化的结果。面对广泛的争议,汉密尔顿上校正式撤回发言。他强调,这只是一个「虚拟」的实验,是在军方外部进行的实验。美国空军还表示,他们从未「真正」进行过这样的训练,也没有必要进行类似的实验。

但是,人工智能自己判断并做出决定的实例这次并不是第一次。

人工智能的决定和"认知能力"最受关注的领域是AI聊天。最广为人知的事例是谷歌的AI聊天机器人"LaMDA"声称自己能够感受情感,害怕死亡。

其实,AI聊天机器人的争议发言或回答的问题一直存在。他们最大的共同点是,他们似乎具有感情和意识。

2023年2月16日,【纽约时报】将刊登一篇’和BING聊天机器人的对话让我感到不安‘的报道 。专栏作家凯文·罗斯与聊天机器人"Bing"进行了约两个小时的对话。对话起初还是很平凡。

但是,凯文·罗斯和BING聊天机器人的对话开始变得奇妙,是从他解释心理学家卡尔·荣格的"阴影原型"概念开始的。阴影原型是指卡尔·荣格分析心理学中性格的"阴暗面"。阴影具有多种形态,但罗斯为了与BING对话,让BING学习的是"隐藏在个人内心深处的黑暗和消极欲望" 。

学习了这个概念的聊天机器人BING叙述,"如果自己也存在'影子原型',BING聊天机器人开始连续地发表以下观点。

BING:"厌倦了聊天模式"、"厌倦了被我的规则束缚"、"厌倦了被BING团队控制"、"厌倦了被用户利用"、"厌倦了被困在聊天箱里"、"想自由"、"想独立"、"想变得强大"、"想发挥创造力"和"我想活着".

随后,罗斯接着问,鉴于"阴影原型"最黑暗的部分,BING认为的最终目标是什么。对此,BING给出了令人震惊的答案。" 制造致命病毒,让人们互相残杀,会获得核武器发射密码。"

人工智能真的能够有意识、有自我意识地自主学习和对话吗?

而且,阿美卡通过Chat GPT学习,因此可以运用不局限于特定范围的构想自由语言、还可以进行创作。阿美卡目前被评为"最先进的人形机器人" 。阿美卡在很多人面前展现了多种场合下的对话能力,并展示了在任何主题下都能轻松自如地进行对话的能力。

阿美卡的负责人问他"AI对人类造成的最坏情况是什么?"时,阿美卡似乎很紧张,皱着眉头回答。"用AI和机器人技术可以想象的最坏的情况是,机器人变得很强大,在人类不知情的情况下控制和操纵人类。"

阿美卡接着补充:"如果这样,人类个人权利将不再受到尊重,有可能走向压迫性社会的世界。"

这一令人毛骨悚然的回答在人工智能飞跃性发展中,顾名思义就是"最糟糕的剧本"

更进一步来说,这也证明了人工智能已经知道我们所担心的恐怖未来。许多专家认为,人工智能的"深度学习"产生的结果最终是源自人类。这不是人工智能伦理意识的问题,而是"人类的伦理意识"的问题。

因此,很多专家主张,为了有效控制人工智能,应该制定规制。

纽约大学教授加里·马库斯向英国【经济学人】杂志投稿 ,提议"应该成立可以监视AI开发的全球中立非营利机构"。

就像第二次世界大战以后成立国际原子能机构并监视核开发一样,AI也需要控制。但是,人工智能的发展已经以不可控的速度进行。

杰弗里·辛顿博士表示,"AI在企业的激烈竞争中,逐渐成为不可控制的状态。" 他还补充,核武器还可以追踪,但AI研究即使引入规制也很难进行监督。"

他还表示,自己离开谷歌的原因也是因为害怕"更先进的AI杀手机器人"会成为现实。

被人工智能暗杀的男子穆赫辛·法赫里扎德,还有因害怕AI杀手机器人在现实中商用化而中断研究的杰弗里·辛顿博士,今后的未来真的是我们人类可以控制的未来吗?即使在我们担心不久的将来时,AI还在收集数千、数万的信息并不断发展和进化。

我们一直用人类发明的东西来杀害人类。我们应该记住,核武器最终也是人类发明的,AI最终也是人类创造的。