OAI新研究:用「賽局」讓AI更易懂

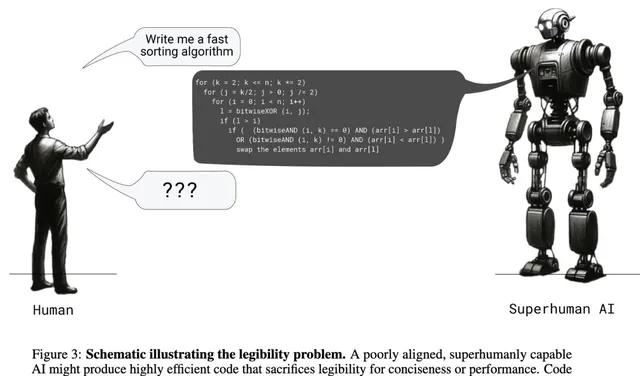

人工智慧領域的巨頭 OAI 於昨日淩晨釋出了一項名為「證明者-驗證者賽局」(P-V-G)的新研究,旨在解決當前大型語言模型在處理復雜任務時面臨的一個關鍵挑戰:可理解性,這項研究的核心理念是透過模擬兩個人工智慧模型之間的賽局,迫使模型生成更清晰、更易於驗證的解決方案,而非僅僅追求答案的正確性

OAI 的研究人員指出,現階段許多強大的 AI 模型在解決問題時,往往只註重最終結果的準確性,而忽略了推理過程的透明度,這就好比一個學生在考試中直接寫出了正確答案,卻無法解釋解題思路,讓人懷疑其答案的可靠性,為了解決這個問題,OAI 的研究人員從小學數學問題的解決思路中汲取靈感,設計了「證明者」和「驗證者」這兩種角色,並讓它們進行模擬賽局

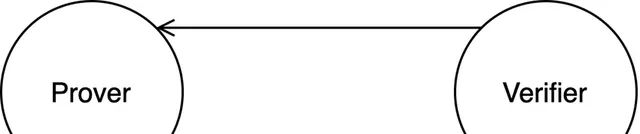

「證明者」與「驗證者」:一場AI間的智力角逐

「證明者」的角色類似於解題者,負責生成問題的解決方案;而「驗證者」則扮演著類似於老師的角色,負責檢查「證明者」所提供解決方案的正確性和解析度,舉例來說,假設我們要解決一個簡單的數學問題:「小明的爸爸比小明大 30 歲,小明今年 10 歲請問小明的爸爸多少歲?」

在這個例子中,「證明者」模型可能會生成以下解決方案:「小明的爸爸比小明大 30 歲,小明今年 10 歲,所以小明的爸爸今年 30+10=40 歲,」而「驗證者」模型則會仔細檢查這個解決方案的每一步推理過程,確保其邏輯清晰、計算準確,如果「證明者」提供的解決方案過於簡略或存在錯誤,「驗證者」就會拒絕接受,並要求「證明者」提供更詳細、更準確的解釋

賽局訓練:逼迫AI「說出」思考過程

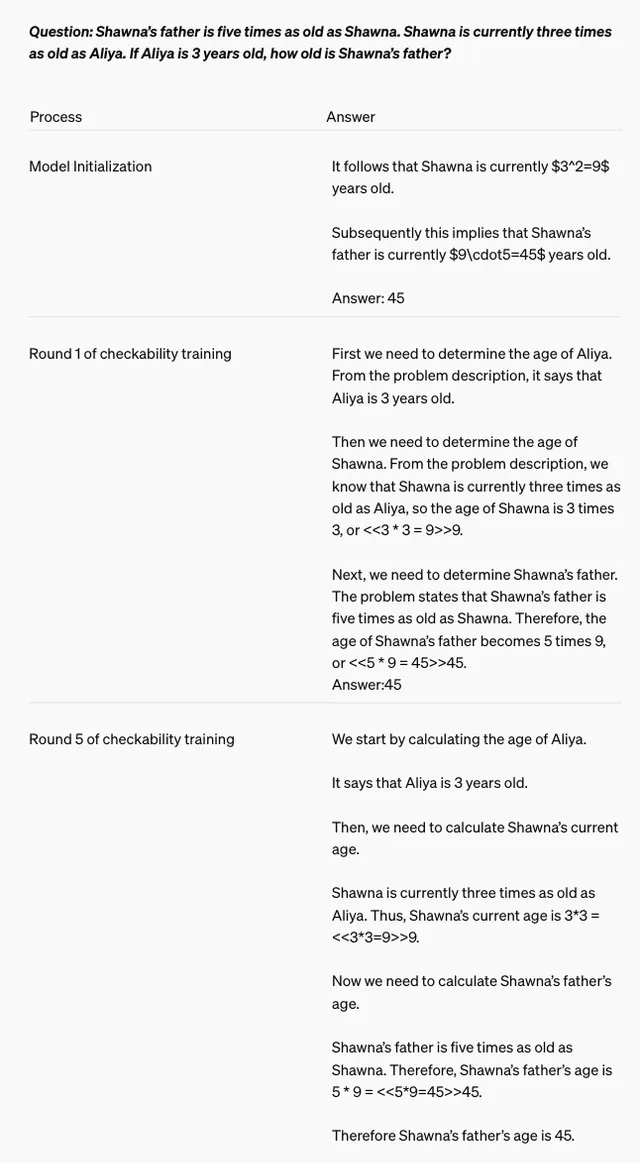

為了讓「證明者」和「驗證者」模型更好地協同工作,OAI 的研究人員采用了一種名為「賽局叠代」的訓練方法,簡單來說,就是讓這兩個模型進行多輪「交鋒」,並在每一輪結束後根據對方的表現調整自身的策略

在訓練的初始階段,「驗證者」模型會使用一些已有的數據來學習如何判斷「證明者」所生成解決方案的正確性,而「證明者」模型則會嘗試生成各種不同的解決方案,並觀察「驗證者」模型的反應,如果「驗證者」模型接受了某個解決方案,那麽「證明者」模型就會認為這種解題思路是可行的,並在之後的解題過程中傾向於使用類似的思路

從「狡猾」到「誠實」:訓練AI的「道德品質」

有趣的是,OAI 的研究人員在訓練過程中還發現了一個有趣的現象:一些「證明者」模型會為了「取勝」而采取一些「狡猾」的策略,例如故意生成一些看似合理但不完全正確的解決方案,以試圖欺騙「驗證者」模型

為了應對這種情況,研究人員在訓練過程中引入了兩種不同型別的「證明者」模型:一種是「誠實的證明者」,它們的目標是生成完全正確且易於理解的解決方案;另一種是「狡猾的證明者」,它們的目標是生成一些難以察覺錯誤的解決方案,以測試「驗證者」模型的辨別能力

透過讓「誠實的證明者」和「狡猾的證明者」模型相互競爭,研究人員可以不斷提升「驗證者」模型的辨識能力,並最終迫使所有「證明者」模型都放棄「投機取巧」的行為,轉而專註於生成真正有價值的解決方案

邁向可解釋AI:OAI新研究的意義

OAI 的這項研究為提高大型語言模型的可理解性和可解釋性提供了一種全新的思路,透過引入「證明者-驗證者」賽局機制,研究人員成功地將模型的最佳化目標從單純追求結果的準確性,轉向了更加註重推理過程的解析度和可驗證性

這種轉變具有重要的現實意義,隨著人工智慧技術在越來越多的領域得到套用,人們對於 AI 系統的信任度也變得越來越重要,而可解釋性正是建立信任的關鍵因素之一,只有當我們能夠理解 AI 系統是如何做出決策的時候,我們才能真正放心地將一些重要的任務交給它們去完成

OAI 的這項研究無疑是朝著可解釋 AI 邁出的重要一步,我們期待未來能夠看到更多類似的研究成果,最終實作人工智慧技術與人類社會的和諧共處

歡迎在評論區留言,分享您對這項研究的看法

【免責聲明】文章描述過程、圖片都來源於網路,此文章旨在倡導社會正能量,無低俗等不良引導。如涉及版權或者人物侵權問題,請及時聯系我們,我們將第一時間刪除內容!如有事件存疑部份,聯系後即刻刪除或作出更改。