隨著ChatGPT在2022年11月底的正式釋出,AI工具可以說是正式出現在了大眾的視野。隨後AI技術開始呈現井噴式的發展,誕生了許多功能各異的AI軟體。NVIDIA作為PC領域的領軍者,自然也研究了許多有用的AI工具。先前只能基於NVIDIARTX的雲端伺服器使用的ChatWith RTX ,目前也已經支持在WindowsRTX PC或工作站上進行本地部署。這不僅極大地提升了搜尋效率,更重要的是,它讓使用者在處理敏感資料時,無需再將數據上傳至第三方或連線至網路,從而確保了使用者在使用過程中的安全性。特別是對於耕升GeForceRTX 40SUPER系列顯卡的使用者來說,他們不僅在日常遊戲中享受到了流暢的幀數體驗,更在使用NVIDIA的AI工具時,感受到了顯著的速度提升。

ChatWith RTX 促進了使用者數據(無論是文件、筆記、視訊還是其他形式的內容)與LLMs之間的直接連線,增強了其對上下文的理解和個人化。透過檢索增強生成(RAG)、TensorRT-LLM和RTX加速,使用者可以與客製的聊天機器人交流,快速獲取根據其內容客製的答案。同時,使用者可以快速輕松地將桌面端上的資料作為數據集,連線到Mistral或Llama2 這一類開源大型語言模型,以便快速查詢與上下文有關的內容。

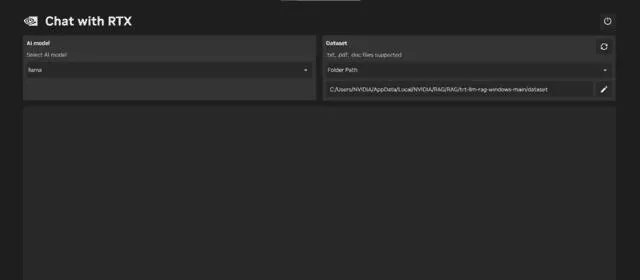

ChatWith RTX支持多種檔格式,包括文字檔案、PDF、DOC/DOCX和XML,實作了流程的簡化。只需在應用程式中指定包含目的檔的資料夾,幾秒鐘內,應用程式即可將它們載入到庫中。

ChatWith RTX還支持使用者輸入視訊網站YouTube播放列表的URL,使應用程式自動轉錄視訊的內容,以進行查詢,進一步豐富了對話體驗。相信後續也會進一步支持國內視訊網站的使用。

此外,對於開發者而言,ChatWith RTX是在GitHub上的TensorRT-LLMRAG 開發者參考計畫基礎上構建的。開發者可以從這個參考計畫中獲得靈感,打造和部署適用於RTX、基於RAG的套用,並由TensorRT-LLM加速,開啟人工智慧互動的新時代。

當然,強大的功能也需要優秀的硬體支持。要透過本地部署使用ChatWith RTX,使用者需要搭載GeForceRTX 30 系列或更高版本的GPU(至少8GB視訊記憶體),並且作業系統需要在Windows10 或者11,並更新至最新的NVIDIAGPU 驅動。

在此推薦最近釋出的耕升GeForceRTX 40 SUPER系列顯卡。該系列顯卡搭載NVIDIAAda Lovelace架構,效能較上代顯卡有著大幅提升。強大的AI效能能夠幫助使用者在使用ChatWithRTX和StableDiffusion時提升渲染速度,更快一步獲得結果。而在遊戲方面支持多項RTX技術,包括NVIDIADLSS 3.5和光線追蹤技術,使遊戲畫面更加逼真細膩。

其中耕升GeForceRTX 4070 SUPER星極皓月OC外殼采用純白的全金屬設計,外觀皎潔純凈。再加上全新的三風扇散熱器仿佛冰霜般凜冽,為使用者呈現出不同尋常的視覺和效能盛宴。對於對電競遊戲、生產力套用和AI創作有高需求的使用者來說,這款顯卡一定會是一個令人滿意的選擇。