金磊 假裝發自 上交大

量子位 | 公眾號 QbitAI

什麽是頂流?

AI大神李沐

回母校做演講,直接讓上交大

變成了大型追星現場——

現場可謂是人人從從眾眾,先來感受一下這個feel:

正式演講前的場外已經是排起了大長龍

,現場更是座無虛席。

即便是演講結束,李沐老師也是被熱情的上交大學子圍得裏三層外三層

:

許多學生更是把經典的【動手學深度學習】

這本書拿了過來讓李沐老師簽名

:

如此場景,甚至上交大電腦科學與工程系教授俞勇

都在朋友圈發出了這樣的感慨:

第一次親眼看到追「星」的盛況。

△圖源:俞勇教授朋友圈,已授權

對此,李沐老師也回應俞勇老師:

母校老師同學太熱情了。

而李沐老師此次回母校的演講,歸結兩個關鍵詞,就是LLM趨勢

和個人職業選擇

。

△圖源:小紅書使用者「昭曦」

尤其是正值李沐老師創業一年半(BosonAI)之際,他在現場基於自己的經歷,總結了三個不同階段中「每天在想的基本目標」:

大公司:你要想如何升職加薪

博士:你要想如何畢業

創業:你要想如何「結束」(要麽上市,要麽賣掉)

△圖源:B站使用者「Kimoyee」

金句之多,內容之精彩,引得在場師生掌聲、笑聲,聲聲不斷。

那麽李沐老師具體都講了什麽?我們繼續往下看。

(PS:完整演講視訊見文末)

談LLM趨勢

首先對於LLM的整體構成,李沐認為主要分為三大方面,分別是數據

、算力

和演算法

。

而整個LLM的過程非常像煉丹,「數據」就是找材料的環節。

就好比小說裏很內送流量備援容錯機制角去深山裏找材料一樣,搞數據是個很難的過程,是個體力活。

之後的「算力」就是煉「數據」,火量大一點、裝置先進一點,能煉出來的東西就越好。

至於「演算法」就相當於丹方,但這點與小說是不同的,因為它每年都在快速進步、變化,並且對細節的把控顯得格外重要。

對於LLM與上一次深度學習較大的區別

,李沐認為:

之前的深度學習「煉丹」是比較穩定的。

但現在LLM「煉丹」,(開發者或使用者)是希望有靈魂在裏面的,它能夠解決很多問題。

接下來,李沐便針對上述的三大方面進行了詳細的講解。

在LLM硬體方面,李沐認為最難且最重要的是頻寬

(bandwidth)。

這是因為現在大模型的訓練很難透過一個機器來搞定,而要做分布式,那麽瓶頸就會出現在頻寬上了。

畢竟現在基本上都會是多個伺服器機架甚至是集群,即便兩個機架間隔1公尺,但由此帶來的哪怕幾納秒的延遲也是不能忍的。

頻寬之後,LLM硬體難點便是記憶體

(Memory)。

大模型在訓練過程中,是把超大的資料壓縮到了一起,使得模型的體量動輒便是幾百個G,執行時的中間變量也會變得很大,因此需要很大的記憶體:

在未來,很有可能一個200G記憶體的芯片是走不動的。

這就意味著我們的模型大小一定程度上會被受限在某個尺寸;記憶體不夠,模型就大不了。

在頻寬、記憶體之後,便來到了算力

(Compute),對此,李沐認為:

莫耳定律依舊有效。

而模型到了一定尺寸之後,資源

(Resources)又成了問題,也就是供電。

李沐基於自身經驗分享到,發現自己造一個電廠,比付電費的成本要低。

至於價格,當算力翻倍的時候,價格目前不一定會保持不變,可能是1.4倍的價格;但當市場競爭足夠,長期來看可以做到價格不變。

至於芯片的替代品

(Alternatives),李沐認為谷歌的TPU、英特爾的Habana、AMD和Azure的芯片在做推理時是OK的;但訓練方面,可能還需要幾年的時間。

李沐在此做了個小總結:

模型訓練每年會以2倍的速度變得更便宜、更快、更大。

今年訓練的大模型,到明年的價值就會減半。

在模型

方面,李沐從語言(Language)、語音(Voice)、音樂(Music)、影像(Image)和視訊(Video)等不同模態方面做了介紹,並認為多模態是當下的一個趨勢。

李沐還給目前不同模態的現狀打了個分:

語言模型:80-85分左右,目前是gets good的狀態。

音訊模型:70-80分左右,目前是good enough的狀態。

視訊模型:目前還是比較弱的。

基於此,李沐給出了一個推論:

在長文本上的人機互動變得越發流行。

至於大模型的套用

(Applicaitions),李沐認為它們本質應該是可以為使用者提供無限的人力資源

。

而這些套用目前在白領和藍領職場上「上崗」或「協作」的效果如何,李沐做了個表格。

從結果上來看,只有白領、文科內容的簡單工作是hold得住的。

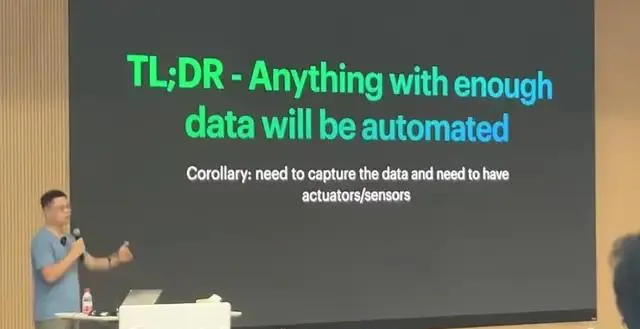

對於套用的總結,李沐認為:

只要數據足夠,萬物即可被自動化。

基於李沐創業一年半的經歷,他也分享了幾點技術上的思考。

首先,預訓練(pre-training)和後訓練(post-training)是同等重要的。

其次,沒有真正的垂直領域模型

;再垂直的模型,它的通用能力也是差不了的。

以及,在大模型評測

方面,李沐認為現在的評測太簡單了

,即使各種刷榜,但用起來的時候就能感受到真實效果。

因此他認為評測這件事雖然很重要,但真正做起來卻很難。

除此之外,李沐還分享了幾個觀點:

數據定義了大模型的能力上限

自建GPU不會比租GPU便宜太多

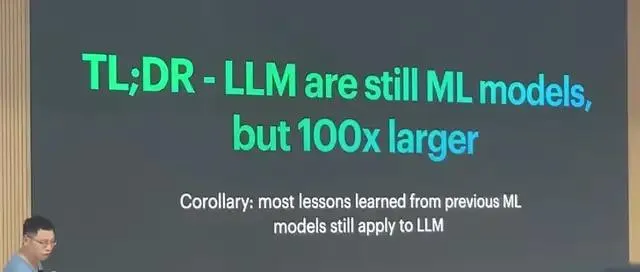

大部份機器學習時代的經驗,依舊適用於大模型時代

而除了技術之外,李沐在這次演講中也給上交大的師生們分享了自己在職場上的心得。

談個人「打卡式人生」

了解李沐的人或許對他的個人經歷比較熟知了。

本科和研究生就讀於上海交通大學,而後赴香港科技大學和CMU深造,在柏克萊和史丹佛擔任助理教授。

也曾任職於百度和亞馬遜等科技大廠,最近的一年半則是創業BosonAI

(第二次創業)。

李沐回顧自己的過往,在現場戲稱為「打卡式人生」

——什麽樣的地方都轉過了一遍了。

那麽李沐在經歷了種種之後,是一種什麽體驗?

這也正是我們文章開頭提到的「每天在想的基本目標」(精彩的內容必須再提一遍):

大公司:你要想如何升職加薪

博士:你要想如何畢業

創業:你要想如何「結束」(要麽上市,要麽賣掉)

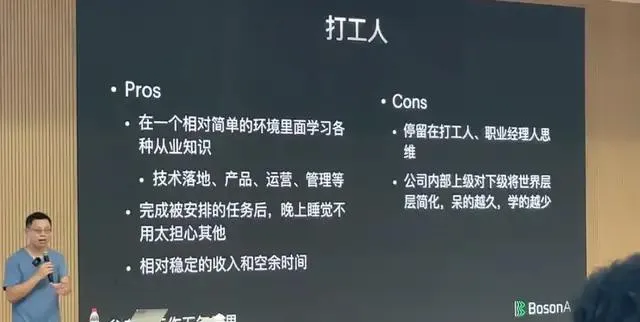

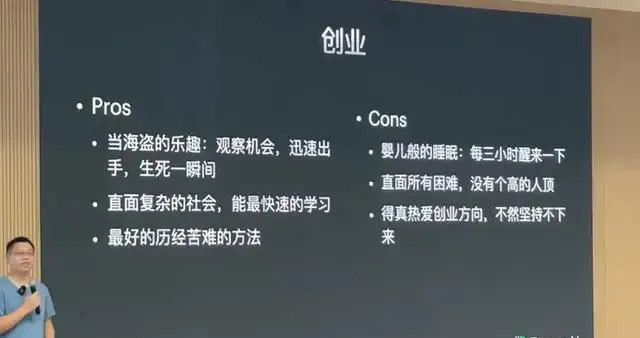

基於這三個大方面,李沐基於自己的經驗,將各自階段的優點

和缺點

羅列了出來。

例如對於「打工人」

這個角色,李沐的PPT剛出來,上交大的學子們便笑了出來:

讀博士期間的優點和缺點是這樣的:

聊到創業的優點,李沐形象地將這個過程比喻為:

可以體驗當(合法)海盜的樂趣,哪兒有錢就去搶一把,沒搶到就死掉了。

但李沐此次演講的兩個大part並非是割裂的,相反,是可以非常自然的做一個「有機結合」

。

他認為應該從「動機」出發去解決一個問題:

有學術價值:那就去做對LLM的理解(PhD/教職)

有商業價值:那就去做LLM上的新套用(創業)

有成長價值:那就去做LMM上的產品落地(打工人)

最後,李沐老師也給了上交大學生一點Tips:

而談到創業歸來,就在前幾天,李沐在知乎寫的一篇文章【創業一年,人間三年】

非常火爆。

不僅是李沐自述了創業一年來的進展,也在三言兩語之間,展現了大佬創業的勢能——

一開始沒打算直接做大模型,但張一鳴建議要創業就直接大模型;買卡需要排隊等不及只好給老黃寫信,沒想到老黃就給安排了;剛創業做遊戲的「老蔡」就來交流過了——米哈遊那個老蔡;在史丹佛和快手創始人宿華散步,感嘆創業心得……

總之,千字短文,但細節之精彩,故事之有趣,值得多讀幾遍:

【創業一年,人間三年】

One More Thing

目前已經有B站網友Kimoyee將李沐老師此次的演講視訊上傳,感興趣的小夥伴們可以文末連結「深度學習」下哦~

參考連結:

[1]https://www.xiaohongshu.com/explore/66c926d9000000001f01929c

[2]https://www.xiaohongshu.com/explore/66c81dd5000000001f014761

[3]https://www.bilibili.com/video/BV1vBWDepECq/?spm_id_from=333.337.search-card.all.click