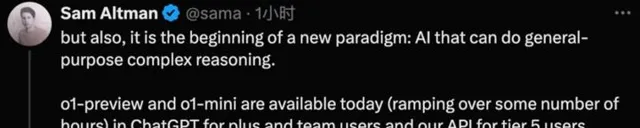

OpenAI最近釋出了其最新語言模型o1,被內部昵稱為「 🍓 」模型。雖然這只是一個預覽版,不是最終版的強力模型,但它的新穎之處在於其獨特的推理模式。它首先構建一個「思維鏈」(Chain of Thought,CoT),經過一系列的「思考」後,再生成最終的回答。這種前置思維鏈的方式大幅提升了模型在編程和數學等問題上的表現能力。

推理規模擴充套件定律

這種新的思維方式其實是一種推理規模的擴充套件表達。傳統的規模擴充套件定律(Scaling Law)主要側重於訓練過程——即訓練數據越多、計算力越強、模型參數越大,則模型的效能也就越出色。

而o1模型的推理規模擴充套件則開啟了新的視角:在完成訓練後,模型透過大量的計算和時間投入在推理過程中獲得效能提升。

o1模型在生成答案前會花費大量的算力在構建思維鏈上,這顯著提高了其解決復雜問題的能力,如奧數題等。這種「讓我們一步一步思考」的方式看似簡單,但在自動化這一過程面臨重大挑戰,因為模型需要自主探索每個問題的最優思維路徑。

訓練方法的變革

雖然OpenAI未具體透露使用何種訓練方法,但可以推測o1模型的成功套用了強化學習,在模型的後期訓練階段,透過大量的數學題和程式碼庫訓練模型去生成解題的思維鏈。

透過這些最佳化步驟,根據結果和過程來獎勵或處罰模型,進一步提升了生成思維鏈的能力。

思維的前進演化與內部見解

OpenAI 最近推出的o1模型在數學和編程領域的表現非常突出,同時在文字解密領域也展現了不俗的實力。盡管其他領域的推理能力尚在成長階段,但 OpenAI 內部人士對此模型的未來發展充滿信心。

Greg Brockman 的觀點:Greg Brockman指出,根據今年國際資訊學奧林匹克競賽(IOI)的數據,o1模型在模擬常規參賽者條件下的表現位於中等水平,但當送出次數大幅增延長,它的得分遠超過金牌線,顯示出模型潛在的巨大能力。

Jason Wei 的評述:AIME 和 GPQA 的結果確實很好,但這不一定能轉化為使用者可以感受到的東西。AI 使用人類語言來建模思維鏈在很多方面都很棒。該模型可以做很多類似人類的事情,比如將復雜的步驟分解為更簡單的步驟、辨識和糾正錯誤以及嘗試不同的方法。遊戲已被徹底重新定義。

Shengjia Zhao 的期待:它不會完美,也不會適合所有事情,但它的潛力再次讓人感到無限。再次感受到 AGI。

William Fedus 的比喻:ChatGPT 現在可以先仔細思考,而不是立即脫口而出答案。最好的類比是,ChatGPT 正在從僅使用系統 1 思維(快速、自動、直覺、容易出錯)前進演化到系統 2 思維(緩慢、深思熟慮、有意識、可靠)。這讓它能夠解決以前無法解決的問題。從今天 ChatGPT 的使用者體驗來看,這是向前邁出的一小步。在簡單的提示下,使用者可能不會註意到太大的差異(但如果您遇到一些棘手的數學或編碼問題,您會註意到的 🙂 )。但這是未來發展的重要標誌。

o1模型的開發標誌著AI在推理能力上的重大進步。雖然目前在某些領域的表現還不夠成熟,但隨著技術的不斷完善,預期o1將在科學研究、工程設計、復雜數據分析等更多專業領域表現出更強的套用潛力。

怎麽和 o1 聊天更合適

OpenAI 給了以下四條建議:

提示詞簡單直接:模型擅長理解和響應簡短、清晰的指令,不需要大量的指導。

避免思維鏈提示詞:模型會在內部執行推理,所以沒有必要提示「一步一步思考」或「解釋你的推理」。

使用分隔符讓提示詞更加清晰:用‘‘‘ ’’’、<>、§等分隔符,清晰地區分prompts的不同部份,以幫助模型分批次處理問題。

限制檢索增強生成中的額外上下文:僅包含最相關的資訊,防止模型的響應過於復雜。

總而言之,不要寫太復雜的提示詞,在o1裏最好的prompts是直接而簡潔的,o1 已經實作了思維鏈的自動化,承擔了提示詞工程師的一部份職責,因此無需再花費過多的精力在提示詞上。

隨著時間的推移,o1有望在人工智慧的道路上,開辟出一片新的天地。在這個由數據驅動的新世界裏,o1就像一束新的光芒,照亮了人工智慧的未來。

o1的出現,或許預示著這樣一個"能力稀疏化"的趨勢。未來的人工智慧,會從單一的大模型,逐漸演化為知識、推理、創意、情感等不同能力模組的靈活組合,並與人類形成更加緊密和高效的協作。o1只是一個開始,期待百花齊放的未來。

來源:AI免費寫作