當教育公司好未來想要訓練自己的大模型時,它遇到了算力的難題。其演算法工程師往往有多個計畫、多個訓練的模型、以及各種版本的叠代,任務繁多。在這個背景下,它們希望透過一個專業且穩定的算力訓練平台,為每一個演算法工程師分配合適的算力資源,讓整個訓練體系高效運轉起來、將手上的算力利用到最優。

在大模型落地之路上,很多企業都面臨像好未來一樣的難題。當它們想要自己去訓模型的時候,可能會遇到算力難以利用好的問題;當他們想要呼叫、調優模型時,可能會面臨模型選擇不夠、工具鏈不夠、數據不夠等問題。

這正是國內雲廠商想要幫他們解決的問題。在大模型浪潮下,過去以 IaaS(基礎設施即服務)和 PaaS(平台即服務)為主的基礎雲服務,正讓位於以 AI 為主的 MaaS(模型即服務)的雲服務。雲廠商希望能解決企業模型落地的這波需求,不僅僅是為了收模型和工具排程費,底層還是希望拉動雲收入。

在大模型時代,圍繞企業的不同落地需求,百度智慧雲推出了全棧的產品服務體系。

第一層是百舸計算平台,它基於百度對文心大模型訓練的經驗沈澱,主要為那些想自訓模型的客戶提供算力服務。好未來最終就選擇了基於百舸訓練自己的大模型。第二層是模型平台千帆,主要面向想直接呼叫模型、深入部署模型、以及基於模型進行上層套用開發的客戶。早在去年 3 月,百度 C 端套用「文心一言」推出當月,百度智慧雲就及時推出了千帆平台。

這種積極性讓百度智慧雲在 AI 大模型落地的行程中走在前列。據 IDC 釋出的【2023 中國大模型平台市場份額】,中國大模型平台及相關套用市場規模達 17.65 億元,百度智慧雲處於第一。而據自媒體"智慧超參數"介紹,在 2024 年 1-8 月份的大模型中標數量盤點中,百度在中標計畫數、行業覆蓋數以及央國企中標計畫數上,排名第一。

在 9 月 25 日百度智慧雲舉辦的雲智大會上,百度集團執行副總裁、百度智慧雲事業群總裁沈抖介紹,目前大模型已經在企業端被真正用起來了。目前在千帆大模型平台上,文心大模型日均呼叫量超過 7 億次,使用者累計精調了 3 萬個大模型,開發出了 70 多萬個企業級套用。

在這樣的背景下,百度智慧雲分別針對算力、模型、AI 套用,升級了百舸 AI 異構計算平台 4.0、千帆大模型平台 3.0 兩大 AI 基礎設施,並升級程式碼助手、智慧客服、數位人三大 AI 原生套用產品。沈抖表示,大模型以及配套的算力管理平台、模型和套用開發平台,正在迅速成為新一基礎設施。這是大模型走向千行百業的重要基礎。

以下是極客公園與百度智慧雲、以及百舸和千帆兩大產品體系負責人交流後,看到的這兩款重要產品的核心變化。從中,可以一窺中國企業落地大模型的核心難點、關鍵趨勢。這對於接下來國內大模型的落地行程或許是至關重要的。

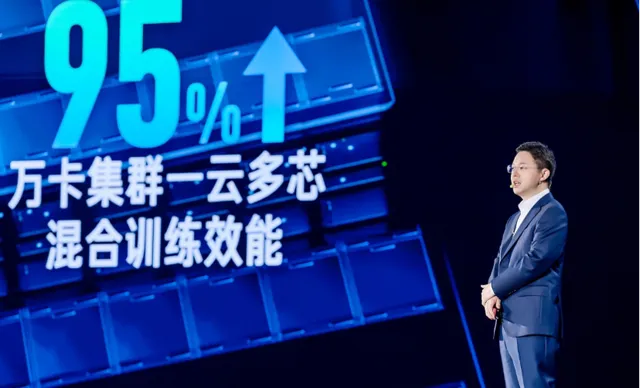

百度集團執行副總裁、百度智慧雲事業群總裁沈抖|圖片來源:百度智慧雲

對想訓模型的客戶:從「多快好省」用上算力 ,走向萬卡集群時代

盡管直接呼叫模型是主流,但仍然有很多企業有自己訓練模型的需求。據極客公園了解,這類企業往往集中在大模型初創企業、傳統互聯網企業,以及生命科學、智駕等行業。就企業規模來看,以行業頭部客戶居多。

它們一般具備較強的技術研發和快速叠代能力,有一定數據積累、數據品質良好。當然,它們也需要采購 GPU 算力。

但對於這些企業來說,如何能把算力用好,是一個核心難題。百度傑出系統架構師,百度智慧雲 AI 計算部負責人王雁鵬對極客公園表示,這些客戶在算力上的核心痛點,大概可以總結為「多快穩省」。

1)多:指的是在算力卡脖子的情況下,企業必然要混合多種芯片訓練,但芯片混訓難度非常大。

2)快:指的是減少集群部署時間,提升模型訓練推理效率,實作大模型業務快速落地。

3)穩:指的是技術故障都有可能導致訓練任務停擺,進而造成損失,需要保持穩定和有效訓練時長。

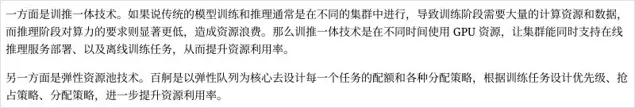

4)省:指的是算力沒有被利用出來,甚至 50% 的算力都被浪費了,因此提升資源利用率對企業節省成本至關重要。

在王雁鵬看來,很多互聯網行業客戶的技術能力主要強於上層軟體,而對於高效能計算、儲存、網路、演算法框架等底層基礎設施能力上存在欠缺。他們想自己用好算力的難度比較大,這正是百舸平台提供的價值。

百舸延承自百度這十余年的基礎設施經驗,從最開始自己搭建伺服器、到深度學習崛起後開始嘗試 GPU 加速、到後來跟上雲端運算的巨大底層變革、再到今天 GPU 雲時代超大規模的平行計算和萬卡集群的算力利用。百度將過去多年的技術積累、資金與人員的大力投入、以及文心大模型的訓練經驗,最終沈澱為了百舸計算平台。

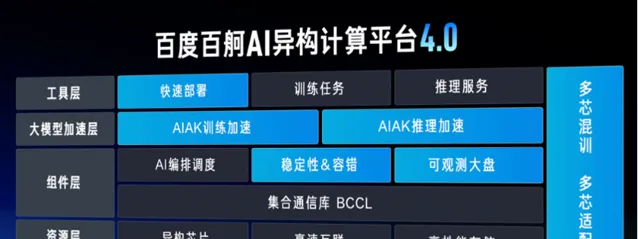

百舸 AI 異構計算平台 4.0|來源:百度智慧雲

在上述四大方面,百舸平台取得了領先於行業的產品優勢:

1)多:百舸支持在同一智算集群中混合使用不同廠商芯片,相容昆侖芯、昇騰、海光 DCU、輝達、英特爾等國內外主流 AI 芯片,多芯混合訓練任務的效能損失控制在萬卡效能損失 5%,是業界最高水平。

2)快:一方面,百舸 4.0 能幫客戶省去大量復雜和瑣碎的配置和偵錯工作,最快 1 小時便能建立萬卡規模集群,這要比行業通常需要的數天甚至數周快得多;另一方面透過大模型訓推任務加速套件 AIAK,能針對主流開源大模型在並列策略、視訊記憶體、算力等層面進行深度最佳化,為萬卡集群下的大模型訓推加速。比如單個芯片整體訓練效率提升了 30%,長文本推理任務可以做到「極速生成」與「秒回」、效率提升了一倍。

3)穩:大模型訓練是一個龐大的單一任務,一個點出錯,整個集群就得停下、回滾到上一個記憶點。百舸在萬卡任務上可實作有效訓練時長占比 99.5%,穩定性極強。

4)省:如果說一般客戶自己管理算力只能發揮不到一半的資源利用率,那百舸能將資源利用率提升至 90%。

正是看重百舸在穩定、高效提供算力等方面的優勢,經過綜合評估之後,好未來最終選擇了百舸。好未來看來,百舸平台的自適應分配策略,無論是對並列模型、並列訓練任務的處理,還是對單任務之間的快速銜接等,都能做到速度非常快、同時保證任務不掉,使得團隊快速地完成了九章大模型的研發上線。

這些都還是在萬卡集群的維度進行討論,不過往未來看,國內大模型行業很快將進入十萬卡集群的競爭。

沈抖介紹,大模型領域的 Scaling Law(縮放定律,指模型效能會隨著參數、算力、數據集的規模增加而提高)仍在繼續,這意味著大模型訓練會很快進入十萬卡集群的競爭階段。不久前,馬斯克表示剛建設了 10 萬卡的集群,未來幾個月還會擴張到 20 萬卡,這不會是個例,

在他看來十萬卡集群訓練的挑戰很大。一方面是空間,部署 10 萬卡的大規模集群,光是在實體層面就要占據大概 10 萬平方米的空間,相當於 14 個標準足球場的面積。另一方面是能耗,這些伺服器一天就要消耗大約 300 萬千瓦時的電力,相當於北京市東城區一天的居民用電量。

而這種對空間和能源的巨大需求,已遠遠超過了傳統機房部署方式所能承載的範疇。因此不得不考慮跨地域的機房部署,但這又帶來了網路層面的巨大挑戰。另外 10 萬卡集群的訓練中斷比例會大大提升,有效訓練時長占比會非常低,這也是很大的挑戰。

不過在沈抖看來,百舸 4.0 正是為部署 10 萬卡大規模集群而設計的,而今天的百舸 4.0 已經具備了成熟的 10 萬卡集群部署和管理能力。「它就是要突破這些新挑戰,為整個產業提供持續領先的算力平台,讓我們的客戶始終走在時代前沿。」他說。

復盤大模型落地這一年:從試水、到中間階段、再到真正的爆發

對於那些想要基於現有大模型做二次開發(包括再訓練、微調、評估和部署)的企業來說,百度智慧雲千帆平台的初衷就是為它們打造。去年 3 月,千帆平台提供了大模型呼叫介面和微調工具鏈,幫助企業更好地進行大模型落地嘗試。

而在百度副總裁謝廣軍看來,這一年半來,大模型落地趨勢經歷了三次變化。而針對這三次變化,千帆平台也相應完成了從 1.0 到 3.0 的三次版本前進演化。

千帆 1.0 推出時,正值大模型爆火,那是企業進行大模型落地的第一個階段:接觸大模型的人都在找卡、囤積算力、嘗試訓練模型,大模型帶火了芯片和算力。那時大模型的需求相對模糊,千帆 1.0 主要提供給企業大模型呼叫和微調服務。

從去年下半年開始,大模型落地進入了第二個階段:很多企業和開發者,都在探索怎麽基於基座大模型改造現有業務,在模型呼叫之上新增了套用開發的需求。在這樣的背景下,千帆推出 2.0,為企業提供 AI 原生套用開發工具。不過,這個過程雖然有很多企業在嘗試,但真正用到生產中的並不多。

而從今年 5 月開始,受各家模型廠商的價格戰影響、模型降價,加速了企業把大模型用起來,並在業務場景裏產生價值。

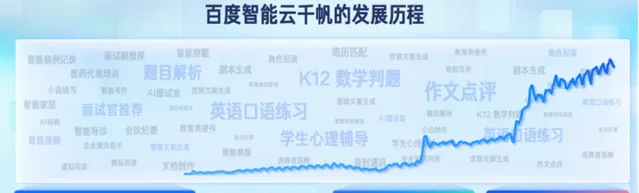

自今年上半年以來,大模型的落地發展明顯加快|圖片來源:百度智慧雲

據百度智慧雲觀察,自今年上半年以來,大模型的落地發展明顯加快。就千帆平台的觀察來看,其文心大模型日呼叫量超 7 億次,累計精調模型超 3 萬個,幫助使用者開發 AI 套用套用超過 70 萬個。

據謝廣軍介紹,大模型的套用已經進入爆發期,很多企業不是在等待類似移動時代的爆款套用,而是已經把大模型用到了自己業務的「研產供銷服」的各個環節。

在他看來,這也是過去 18 個月整個國內大模型產業發展的一個縮影。「我們可以預判,2024 年將成為國內大模型產業套用爆發的元年。」他說。

企業的模型套用趨勢:更深的模型工具鏈、更豐富的模型選擇、更專業的套用開發工具

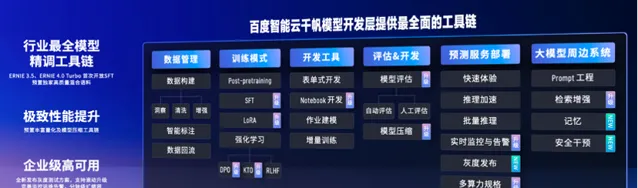

為了接住今天快速增長的 AI 落地需求,千帆大模型平台此次升級了 3.0 版本,在模型開發層、模型呼叫層、套用開發層三大方面都有了更新。如果拆解每一層,也能看到當下 AI 落地的一些需求和趨勢。

1. 模型開發層:需要大小模型結合、需要更深的工具鏈、需要補給數據

模型開發層,指的是需要基於現有大模型做二次開發(包括再訓練、微調、評估和部署)。

據百度副總裁謝廣軍介紹,企業在進行模型開發時,一個需求是它們要的不只是大語言模型,也還需要傳統的視覺模型、語音模型,甚至是傳統意義上的小模型。比如在教育場景裏,如果要大模型評判作業,它往往需要一個拍照的過程,透過 OCR 視覺模型解析題目,再透過大語言模型生成答案。

另外,企業進行模型開發的需求也更深度了。比如過去千帆提供的是低門檻一站式部署平台,但現在湧現了很多專業的使用者,他們需要更深度的模型開發,比如白盒化訓練、作業建模等方式開發等。

而在數據層面,企業也有了更高的要求。比如使用者可能存在數據品質不高、數據不夠、很難代表行業垂類場景的情況,那麽就需要混入一些行業專有數據。另外,很多模型在訓練時是針對具體場景做效果增強,但這可能會出現通用能力遺忘的問題,這時也需要混入通用的語料。

針對這些情況,千帆大模型平台 3.0 做了全面的更新。目前,它支持大模型和多種傳統模型的協同開發,並提供了行業最全面的模型精調工具鏈,上線了 DPO、KTO 等模型訓練演算法和 PTQ 等模型量化演算法。它還偏好設定了獨家高品質混合語料,支持企業將套用中產生的寶貴數據反饋給模型、形成數據飛輪,放大模型在特定場景下的優勢。

千帆大模型平台 3.0 模型開發工具鏈|圖片來源:百度智慧雲

一個案例是,高途教育透過千帆大模型平台的開發工具鏈訓練了作業批改大模型。它可以準確辨識印刷體的題幹和手寫體的學生答案,同時利用千帆「數據飛輪」對這些數據進行清洗和精標,進一步提升模型效能。現在,改大模型的數學判卷準確率已經能達到 95%,最終讓老師、學生受益,讓公司業務增長。

2. 模型服務層:持續擴充模型型別、降低模型價格

模型服務層,指的是使用者直接呼叫大模型的需求。

千帆平台的升級思路,一是持續擴充模型的型別。比如在主力模型上,推出了新的模型 ERNIE Speed pro、ERNIE Lite pro 等,上下文都是支持 128K。垂類場景模型上,又推出了包括 ERNIE Character、ERNIE Functions、ERNIE Novel,更好滿足一些企業在細分場景的需求。

除了文心系列大模型外,千帆還提供了包括近百個國內外大模型等豐富模型選擇。除了語言模型,還支持呼叫語音、視覺等各種傳統的模型等等。

文心大模型家族全景圖|來源:百度智慧雲

在擴大模型型別的同時,另一重點是降低模型呼叫成本。過去一年,文心旗艦大模型降價振幅超過 90%、主力模型全面免費。 這帶來的效果是,文心一言大模型的日均呼叫量超過 7 億次。

上海巨閑網路科技旗下的產品「考試寶」,透過千帆的大模型呼叫和提示詞工程,實作了試題解析智慧化,可以秒級返回解析結果,使用者會員轉化意願翻了一倍,且單條試題解析成本降幅達到 98%。最終實作了降本增收。

又比如是國內領先的招聘企業獵聘,透過呼叫文心大模型,對崗位需求和簡歷內容進行語意理解分析,幫助獵頭顧問快速、智慧地篩選簡歷,實作了高效的人崗匹配。現在,獵聘的人崗匹配準確率比業界平均水平高出 15 個百分點,提升招聘效率 50% 以上。

3. 套用開發:企業級 RAG、企業級 Agent、AI 速搭三大方向

大模型真正在企業用起來,最上層的一步是看套用。它是一種最簡單實用的方式,幫助企業用大模型來改造自己的業務。

目前,企業的的套用落地主要是在 RAG(檢索增強生成)場景。 因為 RAG 能讓大模型快速「懂業務」,它相當於把海量的企業數據和行業知識做成「外掛知識庫」給大模型。目前,千帆 3.0 從檢索效果、檢索效能、儲存擴充套件、調配靈活性四方面對企業級 RAG(檢索增強生成)進行了升級。

比如,透過與百度雲資源打通,它可以支持無限容量的知識庫儲存和檢索;速度上,能做到 1.5 秒內返回結果;RAG 全部關鍵環節,包括解析、切片、向量化、召回、排序等等,都可調、可配;企業可以靈活配置出最適合自己業務的方案;最後,它提供了企業級的安全性和穩定性。

在 2024 雲智大會現場,演示了澎湃新聞套用企業級 RAG 的例子。這類權威媒體報道一條新聞時,往往需要引入該新聞的前因後果、背景資訊,這是寫報道的基礎。澎湃新聞透過千帆建立知識庫,上傳了澎湃新聞成立十年以來所有媒資資訊,共計 2700 萬篇文件,超過 350 億文字。接下來,設定成 100% 按知識庫內容回答。

這對 RAG 的切片能力和召回的準確度要求非常高。比如讓它盤點中國網球奧運發展史、以及 2024 年巴黎奧運女單冠軍鄭欽文的個人發展故事,大模型很快就定位到了知識柯瑞的相關資訊,並用結構化的表達方式生成了新聞事件的脈絡、提供了文件索引。這體現了大模型強大的意圖理解和內容生成能力。

又比如 RAG 的指令遵循能力。如果刪掉知識庫中有關鄭欽文獲得 2024 年奧運網球冠軍相關的資訊,再去問大模型,2024 年巴黎奧運會女單網球冠軍是誰,大模型會拒絕回答這個問題。這是才是正確的做法。過去,由於大模型的「幻覺」問題,企業擔心大模型不靠譜,但有了 RAG 和嚴謹的指令遵循,這個問題可以得到解決。

另外一個常見的大模型落地方式是 Agent(智慧體)。 Agent 在接到一個任務後,會進行自主思考、任務拆解、方案規劃、並呼叫工具,全程自動地完成任務。千帆 3.0 升級的一個重要內容,就是針對企業級 Agent 的開發,增加了業務自主編排、人工編排、知識註入、記憶能力以及百度搜尋等 80 多個官方元件支持。

在大會現場,也展示了在電商領域套用的例子。愛庫存作為一家私域電商供貨平台,數百萬店主在愛庫存上找到想賣的商品,透過自己的微信群、朋友圈這些渠道分發出去。愛庫存正在千帆大模型平台上開發一個叫「愛庫存超級助手」的 Agent。

過去,如果一個店主發現銷量變差了,想調整一下銷售計劃、看看接下來適合賣什麽。他首先要到數據看板上分析原因,如果確認是選品的問題,他會到愛庫存「熱賣榜」裏去找更有增長潛力又適合他客群的品類,然後去做同類產品的比價、選品,最後還要到生成對應的文案和海報。這幾步走下來,一般得幾個小時。

而現在透過搭建 Agent,分鐘級就可以完成,效率得到極大提升。目前這個功能正在內測,預計在 Q4 向愛庫存的店主正式開放。

此外,本次大會還釋出了企業級智慧化低程式碼套用開發平台「AI 速搭」, 透過自然語言對話,一句話就可以完成套用建立。

在大會現場,還演示了如何透過對話,在 AI 速搭平台上開發一個資產管理套用。只需一句話描述對目標系統的需求,包含資產資訊、資產入庫、資產領用、資產維修、資產報廢等功能模組,大模型就可以清晰地理解需求並生成套用。過去,這樣一個套用即使用低程式碼方式開發也需要幾天的時間,現在只需幾分鐘就能完成。

大模型浪潮已經到了第二年,中國企業的落地速度、規模比想象中要更快。這離不開模型廠商以及提供全套落地產品體系的雲廠商的努力。隨著大模型落地真正拉開大幕,依靠響應速度、投入、決心等,百度智慧雲試圖領跑、爭奪 GPU 時代雲端運算巨頭的生意規模和市場地位。今天或許只是一個開始。