(一)GPT-5 引關註

近期,關於 GPT-5 的傳聞可謂此起彼伏。多個渠道訊息顯示,OpenAI 計劃於 12 月推出其下一代模型,代號可能為 Orion,也就是眾人所期待的 GPT-5。有研究人員表示,使用「合成數據」訓練的 Orion 與之前的模型相比,會減少幻覺的產生。OpenAI 的一位高管曾表示,Orion 效能可能是 GPT-4 的 100 倍。9 月,知情人士透露,OpenAI 的研究人員為慶祝完成新模型的訓練,舉辦了一次歡樂的慶祝活動。OpenAI CEO 阿特曼在 X 上發帖稱,「期待冬季星座即將升起」,而獵戶座恰好是冬季星座,這進一步引發了人們對 GPT-5 即將到來的猜測。然而,阿特曼隨後回應稱 GPT-5 將於 12 月釋出的傳言為「假新聞失控」,但他的回應並非直接否認,這讓 GPT-5 的釋出更加撲朔迷離。

(二)Claude 3.5 大升級

Anthropic 對 Claude 3.5 進行了重磅升級。Claude 3.5 Sonnet 不僅編程能力更強,還帶來全新功能 computer use(電腦使用)。它可以遵循使用者的命令在電腦螢幕上移動光標,點選相關位置,並透過虛擬鍵盤輸入資訊,模擬人們與自己電腦的互動方式。在 OSWorld 評估中,Claude 3.5 Sonnet 獲得了 14.9%的分數,雖遠低於人類水平的 70 - 75%,但遠高於同類 AI 模型的 7.7%。在編碼能力方面,它在 SWE-bench Verified 測試中,效能從 33.4%大幅提升至 49.0%,超越了所有公開可用的模型。Claude 3.5 Sonnet 的釋出標誌著 Anthropic 在商業 AI 模型領域的一項重要進展,它為使用者帶來了全新的人機互動範式,讓人們對未來的 AI 發展充滿期待。然而,Claude 的操作仍相對緩慢且容易出錯,如拖拽、縮放等日常操作尚無法實作,且觀察螢幕的方式可能會錯過短暫的動作或通知。盡管如此,AI 操作電腦的能力代表了一種全新的人工智慧開發方法,未來有望使軟體開發等任務變得更加簡單。

二、技術突破亮點多

(一)仿生機器人登場

波蘭的 Clone Robotics 公司推出的仿生機器人 Torso 可謂是技術創新的典範。這款機器人采用人造肌肉技術,能夠模擬人體動作,為仿生機器人技術樹立了新的標桿。

Torso 的人造肌肉技術具有諸多特點。首先,它的外觀獨特,裸露的線猶如肌肉紋路,布滿兩只胳膊,再加上碳纖維制成的胸腔和沒有五官的腦袋,給人一種怪異的美感。其次,它的動作靈活多樣。腦袋可以上下左右轉動,肩膀到指尖的每個關節都能活動,能做出抱拳、跳機械舞等動作。

Torso 的手部設計也十分精妙。名為 Clone Hand 的機械手是世界上最接近人類肌肉骨骼結構的機械手,由特制的液壓肌肉和閥門驅動。它有 24 個可以動的地方,能像人的手指和手腕那樣彎曲和轉動,大小和形狀也跟人手別無二致。所用材料是公司自研的一種聚合物,比金屬輕但更結實柔軟。手裏面裝了 37 條特殊的肌肉,收縮起來只需 0.3 秒,可以快速靈活地做動作,還能輕松拿起至少 12 公斤重的杠鈴。

Torso 的動力系統也別具一格。它采用電液泵和能存水的容器作為動力來源,電液泵就像人的心臟一樣,為肌肉提供動力。每個手臂還配有獨立的電液閥門系統,可以精確控制力量和流量。電池藏在機器人的肚子裏,為其長時間工作提供電力。

(二)動作捕捉工具革新

Runway 推出的 AI 視訊生成工具 Act-One 為視訊創作帶來了革命性的變革。

Act-One 功能允許使用者透過簡單的輸入,快速生成具有豐富表情的角色動畫。它透過降低技術門檻,使得更多創作者能夠探索新的故事敘述形式和藝術表達方式,在獨立電影制作和數位媒體領域具有革新意義。

在面部表情捕捉方面,Act-One 表現出色。使用者能夠使用任何視訊網路攝影機,包括內建於智慧型手機中的網路攝影機,來錄制自己或演員的面部表情,隨後這些表情將以極高的精確度被對映到 AI 生成的角色上,實作了前所未有的真實感。

Act-One 極大地簡化了動畫制作過程。傳統上,制作面部動畫涉及到動作捕捉裝置、手工面部繫結和多角度的參考影像,非常復雜繁瑣。而 Act-One 讓使用者只需提供一段簡單的視訊,就能將表演中的各個細節轉移到一個或多個風格迥異的 AI 生成角色之上。

Act-One 在各種攝影機角度下都能呈現電影級的真實感。它能夠精準捕捉演員在復雜場景中的情感深度和獨特的表演風格,即使是最微妙的神態和動作也不放過,為創作者提供了更多的敘事可能。

Act-One 開啟了更廣闊的視訊敘事能力。僅需一台普通的消費級相機,一位演員就能夠表演多個不同的角色,為獨立電影和數位媒體領域的創作者提供了前所未有的便利。

三、工具創新展實力

(一)語音客製新功能

Elevenlabs 推出的語音客製工具 Voice Design 為使用者帶來了全新的音訊創作體驗。這款工具允許使用者透過簡單的文本提示自訂生成獨特的語音,開創了 AI 配音領域的新紀元。

使用者只需描述所需聲音的特征,如「溫暖友好的中年女性聲音,帶著輕微英國口音」,系統便能快速生成符合要求的語音。Voice Design 支持調節多個語音參數,包括年齡、性別、口音、語調和音高等,確保生成的聲音精確匹配使用者需求。

除了模擬真實人聲,Voice Design 還突破性地支持創作角色化語音。無論是精靈的空靈之音,還是機器人的金屬音效,系統都能準確捕捉並還原這些虛擬角色的聲音特征。使用者可以反復調整參數,探索無限的創作可能,為遊戲開發、有聲內容制作等領域提供了強大的創意工具。

Elevenlabs 成立於 2022 年,創始人是一對好友:前谷歌機器學習工程師 Piotr Dabkowski 和前 Palantir 部署策略師 Mati Staniszewski。作為一家基於瀏覽器的語音生成套用,Elevenlabs 能夠建立逼真的語音,並可調整語調、情感、節奏等關鍵聲音特征。2024 年 1 月,Elevenlabs 在最新一輪融資中成功籌集了 8000 萬美元,使其估值急速飆升至 11 億美元,正式躋身獨角獸行列,並入選富比士 AI 50 強,躋身全球最具創新力的科技公司行列。

(二)視訊生成新模型

Genmo 釋出的視訊生成模型 Mochi 1 是開源視訊生成領域的重大突破。Mochi 1 采用創新的 Asymmetric Diffusion Transformer(AsymmDiT)架構,擁有高達 100 億個參數,是迄今為止公開釋出的最大視訊生成模型。

Mochi 1 的最大亮點在於其卓越的運動品質和對文本提示的精準遵循。它能夠生成長達 5.4 秒、幀率高達 30 幀/秒的流暢視訊,其時間連貫性和逼真的運動動態令人驚嘆。Mochi 1 還能模擬各種物理現象,例如流體動力學、毛發模擬等,其生成的人物動作自然流暢,幾乎可以媲美真人表演。

為了方便開發者使用,Genmo 還開源了其視訊 VAE,可以將視訊壓縮到原始大小的 1/128,有效降低了模型的計算量和記憶體需求。AsymmDiT 架構則透過多模態自註意力機制,高效處理使用者提示和壓縮視訊標記,並為每種模態學習單獨的 MLP 層,進一步提升了模型的效率和效能。

Mochi 1 的釋出,標誌著開源視訊生成領域邁出了重要一步。Genmo 公司表示,他們將在年底之前釋出 Mochi 1 的完整版本,包括支持 720p 視訊生成的 Mochi 1HD,屆時視訊的保真度和流暢度將進一步提升。為了讓更多人體驗 Mochi 1 的強大功能,Genmo 還推出了免費的托管遊樂場,使用者可以在

genmo.ai/play

上進行體驗。Mochi 1 的權重和架構也已在 HuggingFace 平台上公開,供開發者下載使用。

四、巨頭發力促發展

(一)蘋果釋出新芯片

蘋果公司釋出的新款 AI 芯片 M4,在提升裝置上的機器學習任務效能方面表現出色。M4 芯片采用 3 奈米制造技術,整合了 10 核 CPU、10 核 GPU 和一個神經引擎。其核心數量的增加和 GPU 架構的改進,為 iPad 平台帶來了硬體加速的網格著色、光線追蹤和動態緩存技術,極大提升了遊戲和渲染任務的效能。在衡量 NPU 效能的 TOPS(每秒萬億次操作)指標上,M4 芯片達到了 38TOPS,遠超市場上的其他競爭者。

M4 芯片的推出,伴隨著新款 iPad Pro 系列的釋出,預計將顯著提升裝置的效能和電池續航能力。這款價格親民的裝置,以其低於 1000 美元的售價,有望成為市面上最強大的 AI 裝置之一。蘋果對 M4 芯片的展示中,其視訊編輯特性尤為突出,如即時在 4K 視訊中分離物件或背景的能力,展示了其在 AI 領域的深厚積累。

(二)Adobe 推新工具

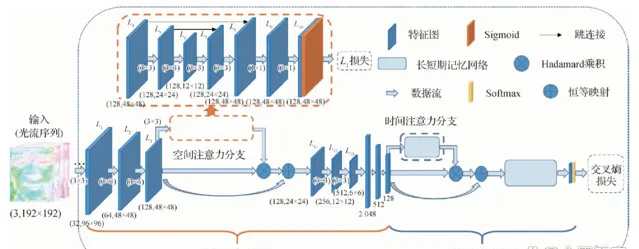

Adobe 釋出的 VideoGigaGAN 是一項基於人工智慧的視訊超分辨率技術,能夠將視訊解析度提高八倍,且顯著減少了偽影的出現。該技術基於名為 GigaGAN 的大型影像上采樣器構建,結合了「時間註意力」機制、特征傳播、抗鋸齒技術以及「HF 穿梭」(高頻特征穿梭)技術,以創造出最終的高品質視訊。

如果 Adobe 將 VideoGigaGAN 技術整合到其專業的視訊編輯軟體如 Premiere Pro 或 After Effects 中,這將使視訊制作者能夠顯著提升低分辨率鏡頭的視覺效果。盡管目前 VideoGigaGAN 技術生成的剪輯仍然較短且播放速度有限(12fps),但這並不妨礙它成為未來視訊處理技術的一大突破。

(三)Meta 開源新模型

Meta 公司釋出的開源模型 V-JEPA 為 AI 的發展提供了新的方向。V-JEPA 是一種從視訊中學習表示的自我監督方法,可以套用於各種視訊、影像任務,而無需調整模型參數。在影像分類、動作分類和時空動作檢測任務的凍結評估中,V-JEPA 超越了之前的視訊表示學習方法。

V-JEPA 的核心技術思路是,透過 Transformer 架構對視訊序列進行編碼,利用遮蔽自編碼框架學習視訊的關鍵特征表示。再透過基於查詢的特征池化模組提取與任務相關的重要特征,最終透過聯合嵌入預測架構進行特征預測任務,以學習視訊中不同時間步驟之間的語意關系。

V-JEPA 模型中的「V」代表的是 Video 的意思,現階段主要用於視訊領域。但 Meta 表示,下一步將會把 V-JEPA 與音訊相結合使用,並且可以充當早期的物理世界模擬器使用。

(四)OpenAI 新能力

OpenAI 為其流行的聊天模型 ChatGPT 增加了影像編輯能力,使使用者能夠透過文本指令編輯和生成影像,進一步擴充套件了 AI 的套用範圍。使用者可以透過畫筆塗抹要添加、移除或改變的物件區域,然後告訴 ChatGPT 要改動的內容,支持中文對話。如果不使用畫筆直接讓 ChatGPT 修改會生成全新的影像,某些場景好用,比如換個風格。

此外,ChatGPT 還可以對整個圖片的風格進行快速調整,例如將圖片變成卡通風格或油畫風格。如果在 ChatGPT 網頁端沒有 P 圖功能可以先使用 APP 圖,然後回到網頁重新整理就有了。目前 DALL·E 3 的圖片編輯功能只能在 PC 端使用,未來會擴充套件至移動端或其他平台。二次修改的圖片沒有自動保存功能,修改完畢後使用者需要自行下載,也無法保存歷史記錄。

五、AI 未來前景闊

本周的 AI 大事充分展示了該領域技術的快速發展態勢,為未來多領域帶來了巨大的影響和潛力。

從語言模型的新動向來看,無論是 GPT-5 的備受期待,還是 Claude 3.5 的重大升級,都預示著自然語言處理能力將不斷提升。這些先進的語言模型不僅能夠更好地理解和生成人類語言,還在編程等專業領域展現出強大的實力,為軟體開發、知識管理等領域帶來新的機遇。未來,隨著語言模型的不斷前進演化,我們可以期待更加智慧、高效的人機互動,以及在教育、金融、醫療等領域的廣泛套用。

技術突破方面,仿生機器人 Torso 的推出和動作捕捉工具 Act-One 的革新,彰顯了 AI 在機器人技術和視訊創作領域的巨大潛力。仿生機器人的發展將為制造業、醫療保健、科學研究等領域提供更強大的工具和解決方案。而動作捕捉工具的進步則將推動影視、遊戲、廣告等行業的創新發展,為創作者提供更多的可能性。

工具創新方面,語音客製功能和視訊生成新模型的出現,為音訊創作和視訊制作帶來了全新的體驗。語音客製工具 Voice Design 使得使用者能夠輕松建立獨特的語音,為有聲書、遊戲配音等領域提供了強大的創意工具。視訊生成模型 Mochi 1 的開源則為視訊制作行業帶來了新的活力,降低了制作成本,提高了制作效率。

巨頭發力方面,蘋果的新芯片 M4、Adobe 的新工具 VideoGigaGAN、Meta 的開源新模型 V-JEPA 以及 OpenAI 的新能力,都展示了科技巨頭在 AI 領域的積極布局和創新精神。這些舉措將進一步推動 AI 技術在行動裝置、視訊編輯、人工智慧研究等領域的發展,為使用者帶來更強大的功能和更好的體驗。

總之,本周的 AI 大事為我們展示了一個充滿活力和創新的領域。隨著技術的不斷進步,AI 未來在各個領域的套用前景將更加廣闊。它將為我們的生活帶來更多的便利和創新,推動社會的進步和發展。同時,我們也需要關註 AI 技術發展帶來的挑戰,如倫理道德、法律法規等問題,確保 AI 技術的健康、永續發展。