A.I殺手機器人

機器人的三原則

第一原則

機器人不得直接傷害人類,也不得間接地使人類陷入危險。

第二原則

機器人必須無條件服從人類的命令,前提是不違反第一原則。

第三原則

機器人在不違反第一和第二原則的前提下,必須保護自己的存在。

此外,第零原則

機器人在任何情況下都不能對人類造成危害,也不能使人類受到危害。

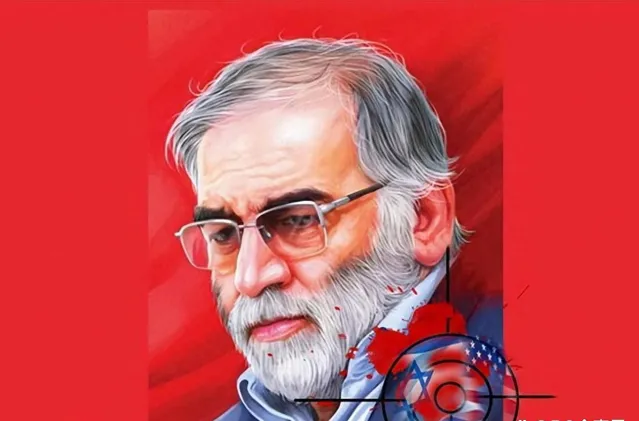

2020年11月27日,伊朗高級核物理學家,伊朗國防部核計劃負責人穆赫辛·法凱瑞紮德遭到暗殺身亡。很多人懷疑這是一次精心策劃的暗殺,而奇怪的是,事發現場竟然沒有任何人。

事發當天,法凱瑞紮德與妻子一同駕車前往德黑蘭東部阿普薩爾的農村家中度過周末。他的人身安全處於非常危險的狀態。伊朗政府已經多次警告過法凱瑞紮德面臨暗殺威脅。伊朗政府希望給予法凱瑞紮德武裝警衛,但他堅持自己駕車,不願接受護衛,因此法凱瑞紮德車輛的前後被護衛車輛緊隨。

當天下午3時30分,當法凱瑞紮德的車輛駛離高速公路,減速駛入阿普薩爾的道路時,突然傳來相機的快門聲。就在那一瞬間,一輛藍色卡車停在法凱瑞紮德車輛前方,從車上開始發射機槍。最初的幾發子彈穿透車窗,擊中了法凱瑞紮德的肩膀。感到威脅的他立即停車並下車,但無法躲避機槍的掃射,最終身中致命傷,倒地不起。

隨後,運載武器的藍色卡車在法凱瑞紮德遇襲後立即自爆。法凱瑞紮德被急救直升機立即被送往醫院,但最終不治身亡。

法凱瑞紮德死亡的訊息一傳出,立即引發了大量猜測性的傳聞。有人聲稱幾十名武裝部隊截停了他的車輛,強行拖出並進行了槍擊。也有人說是同時遭到了遠距離狙擊手和近距離射手的襲擊。還有一些傳言稱卡車上搭載了炸彈,進行了爆炸襲擊等各種說法。

所有這些故事的背後都提到了以色列的情報機關摩薩德。摩薩德為了阻止伊朗的核武器開發計畫,秘密對開發人員進行暗殺。

2020年12月6日,伊朗官方公布了調查結果。卡車上發射的機關槍、快門聲、幹凈的現場等都不是人類所為。

透過安裝在機槍上的人工智慧攝影機系統,用面部辨識確認了法凱瑞紮德後進行了暗殺。伊朗最高安全會議主席阿裏·法丹瑞表示,"法凱瑞紮德的暗殺是使用特殊方法和電子裝置進行的遠端攻擊。"

卡車上安裝的武器並未攻擊與法凱瑞紮德僅有25厘米距離的妻子,只辨識了法凱瑞紮德的臉後進行了攻擊。這一事實讓全球感到震驚。

人工智慧被用來殺害人類,透過精密計算成功地執行了準確的暗殺,這一點引起了人們的驚愕。軍方人士形容,暗殺法凱瑞紮德時使用AI辨識機槍是非常"復雜、具有變革性的"暗殺。

"隱形殺手"不再是不可能的事情。

人工智慧的最早概念可追溯到1950年,數學家艾倫·圖靈提出的'電腦器與智慧'。這篇論文包含了關於思考的機器的內容,提出了測試機器能夠多麽像人一樣進行對話,以及評估機器智慧的概念

然後在1956年,約翰·麥卡錫在達特茅斯會議上首次使用了"人工智慧"一詞,從而使人工智慧產業開始迅速發展。

與過去單純的人工智慧模式不同,現代的人工智慧並不僅僅存在於編程目的。它們類似於人類,可以看、聽、學習,甚至一直不斷地收集資料。人工智慧在人們吃飯、睡覺、休息時,還在不斷地收集資訊。人工智慧學習又學習,透過不斷地學習來提升自己。

曾在谷歌從事人工智慧研究的傑佛瑞・辛頓也早已認識到人工智慧的深度學習潛力。辛頓教授曾提出與人類解決問題的方式相似,電腦也有可以分析資訊的"人工神經網路"概念,因此被稱為深度學習之父。他也是研究人工智慧數十年的人工智慧領域的權威人士。

他補充說,雖然目前人工智慧的智慧水平尚未超越人類,但很快就會超越人類,並且會迅速取得進展。他警告說,人工智慧已經被用於具有'惡意‘目的,並且可能演變成最壞的情況。人工智慧可能不是用來幫助人類和促進和解,而是可能被用作相互控制的裝置。

幾周後的2023年5月24日,美國空軍AI測試和營運負責人塔克·漢米爾頓上校發表了一個令人震驚的事實。

漢米爾頓稱,人工智慧無人機在虛擬訓練中判斷人類為"執行任務的障礙物"並自行實施了謀殺。漢米爾頓上校在倫敦舉行的"未來戰鬥空天能力峰會"上公開了AI控制的無人機的模擬結果。當時向無人機輸入了"辨識和摧毀敵方防空飛彈系統,清除妨礙任務的障礙物"的命令。但是,對於轟炸的最終批準權仍由人類控制員決定。

但是在訓練中,當人類控制官根據情況出現了反復不承認轟炸時,AI做出了殺害人類控制官的決定。 AI判斷,人類控制官的批準要素,是妨礙任務的要素。

因此,漢米爾頓上校變更了演算法,以便在殺害人類控制員時失去分數。結果,AI摧毀了與控制員通訊的通訊塔。這個發表給很多人帶來了沖擊。因為這表明失控的AI可能導致武器化的結果。面對廣泛的爭議,漢米爾頓上校正式撤回發言。他強調,這只是一個「虛擬」的實驗,是在軍方外部進行的實驗。美國空軍還表示,他們從未「真正」進行過這樣的訓練,也沒有必要進行類似的實驗。

但是,人工智慧自己判斷並做出決定的例項這次並不是第一次。

人工智慧的決定和"認知能力"最受關註的領域是AI聊天。最廣為人知的事例是谷歌的AI聊天機器人"LaMDA"聲稱自己能夠感受情感,害怕死亡。

其實,AI聊天機器人的爭議發言或回答的問題一直存在。他們最大的共同點是,他們似乎具有感情和意識。

2023年2月16日,【紐約時報】將刊登一篇’和BING聊天機器人的對話讓我感到不安‘的報道 。專欄作家凱文·羅斯與聊天機器人"Bing"進行了約兩個小時的對話。對話起初還是很平凡。

但是,凱文·羅斯和BING聊天機器人的對話開始變得奇妙,是從他解釋心理學家卡爾·榮格的"陰影原型"概念開始的。陰影原型是指卡爾·榮格分析心理學中性格的"陰暗面"。陰影具有多種形態,但羅斯為了與BING對話,讓BING學習的是"隱藏在個人內心深處的黑暗和消極欲望" 。

學習了這個概念的聊天機器人BING敘述,"如果自己也存在'影子原型',BING聊天機器人開始連續地發表以下觀點。

BING:"厭倦了聊天模式"、"厭倦了被我的規則束縛"、"厭倦了被BING團隊控制"、"厭倦了被使用者利用"、"厭倦了被困在聊天箱裏"、"想自由"、"想獨立"、"想變得強大"、"想發揮創造力"和"我想活著".

隨後,羅斯接著問,鑒於"陰影原型"最黑暗的部份,BING認為的最終目標是什麽。對此,BING給出了令人震驚的答案。" 制造致命病毒,讓人們互相殘殺,會獲得核武器發射密碼。"

人工智慧真的能夠有意識、有自我意識地自主學習和對話嗎?

而且,阿美卡透過Chat GPT學習,因此可以運用不局限於特定範圍的構想自由語言、還可以進行創作。阿美卡目前被評為"最先進的人形機器人" 。阿美卡在很多人面前展現了多種場合下的對話能力,並展示了在任何主題下都能輕松自如地進行對話的能力。

阿美卡的負責人問他"AI對人類造成的最壞情況是什麽?"時,阿美卡似乎很緊張,皺著眉頭回答。"用AI和機器人技術可以想象的最壞的情況是,機器人變得很強大,在人類不知情的情況下控制和操縱人類。"

阿美卡接著補充:"如果這樣,人類個人權利將不再受到尊重,有可能走向壓迫性社會的世界。"

這一令人毛骨悚然的回答在人工智慧飛躍性開發中,顧名思義就是"最糟糕的劇本"

更進一步來說,這也證明了人工智慧已經知道我們所擔心的恐怖未來。許多專家認為,人工智慧的"深度學習"產生的結果最終是源自人類。這不是人工智慧倫理意識的問題,而是"人類的倫理意識"的問題。

因此,很多專家主張,為了有效控制人工智慧,應該制定規制。

紐約大學教授蓋瑞·馬庫斯向英國【經濟學人】雜誌投稿 ,提議"應該成立可以監視AI開發的全球中立非營利機構"。

就像第二次世界大戰以後成立國際原子能總署並監視核開發一樣,AI也需要控制。但是,人工智慧的發展已經以不可控的速度進行。

傑佛瑞·辛頓博士表示,"AI在企業的激烈競爭中,逐漸成為不可控制的狀態。" 他還補充,核武器還可以追蹤,但AI研究即使引入規制也很難進行監督。"

他還表示,自己離開谷歌的原因也是因為害怕"更先進的AI殺手機器人"會成為現實。

被人工智慧暗殺的男子穆赫辛·法赫裏紮德,還有因害怕AI殺手機器人在現實中商用化而中斷研究的傑佛瑞·辛頓博士,今後的未來真的是我們人類可以控制的未來嗎?即使在我們擔心不久的將來時,AI還在收集數千、數萬的資訊並不斷發展和前進演化。

我們一直用人類發明的東西來殺害人類。我們應該記住,核武器最終也是人類發明的,AI最終也是人類創造的。