這兩天,幾乎整個AI圈的目光都被OpenAI釋出Sora模型的新聞吸引了去。其實還有件事也值得關註,那就是Google繼上周官宣Gemini 1.0 Ultra 後,火速推出下一代人工智慧模型Gemini 1.5。

公司執行長 Sundar Pichai攜首席科學家Jeff Dean等眾高管在推特同時宣布了這一重大更新。

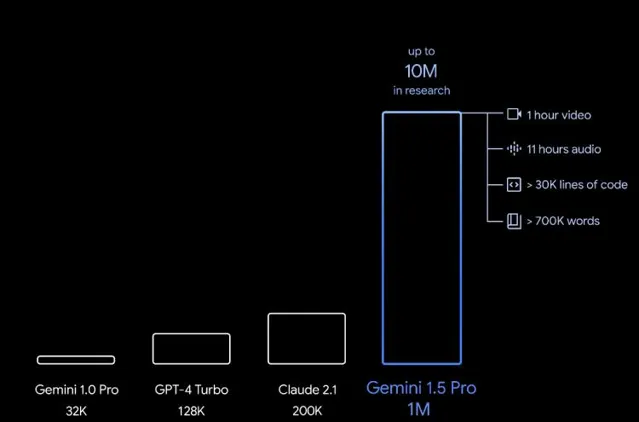

其中最亮眼的當屬它在跨模態超長文本理解能力上的大幅突破。 Gemini 1.5能夠穩定處理的資訊量高達100萬個tokens 。更直觀去感受,這相當於1小時的視訊、11小時的音訊、超過3萬行程式碼或70萬個單詞。

在此之前,世界上公開可用的LLM中,最大的上下文視窗來自Claude 2.1的20萬tokens。同時GPT-4是12.8萬tokens, Gemini 1.0 Pro是3.2萬tokens——此次Gemini 1.5已在視窗長度上成功碾壓所有大模型。

Google還表示,他們在研究中已成功測試了高達1000萬tokens,相當於一次將整個【魔戒】三部曲放進去。

Sundar Pichai認為更大的查詢視窗對企業來說會非常有用, 「電影制作人可能會上傳他們的整部電影,詢問Gemini評論家是什麽意見,公司還能使用Gemini審查大量的財務記錄。這是我們實作的重大突破之一。」

更高效的MoE架構

作為目前Google公開的最先進LLM,Gemini 1.5采用時下流行的混合專家(MoE)架構來提高效率,響應更快、品質更高。

與傳統Transformer 作為一個大型神經網路執行不同, MoE 模型被劃分為較小的專家模組。執行任務時會根據資訊型別,選擇性地啟用最相關的專家路徑,從而大大提升模型的效率和準確性。不僅更適應處理大規模數據集的復雜任務,還有更強的可延伸性和靈活性。

我們熟知的Mistral 8x7B、MiniMax abab6都是使用了Moe架構,更有爆料稱GPT-4也是由8個或16個專家模型構成。

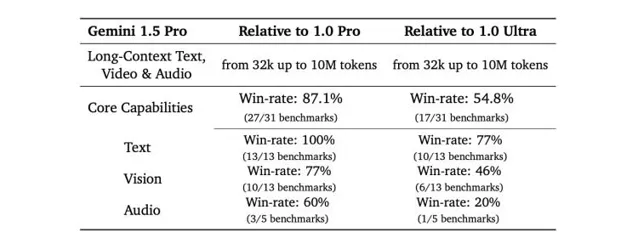

根據Google 數據,此次供早期測試的Gemini 1.5 Pro在使用更少計算資源的同時,對數學、科學、推理、多語言和視訊等任務的執行水平已逼近1.0 Ultra。

在官方演示和58頁的技術論文中, Google還針對新模型的強大效能給出了以下幾個用例:

大量資訊的復雜推理和多模態分析

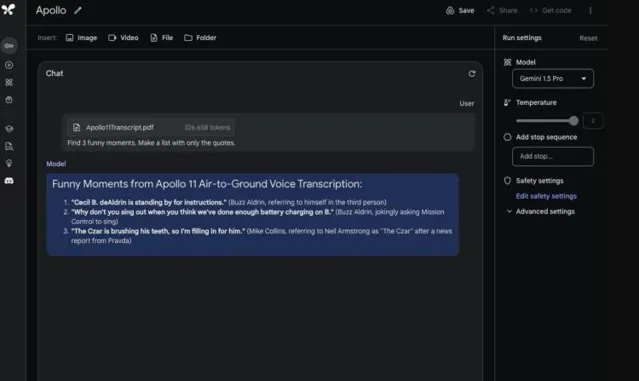

Gemini 1.5 Pro 可以無縫分析、分類和總結給定的長篇復雜文件。例如,上傳阿波羅 11 號登月任務的 402 頁pdf記錄,讓它根據要求列出3個有意思的瞬間,並參照原始對話細節。

給出維克多·雨果的五卷本小說【悲慘世界】(1382頁,73.2萬tokens),粗略勾勒一個場景,並提問「看看這幅畫中的事件是在哪一頁上?」模型準確給出了頁碼,並標識出關鍵情節。

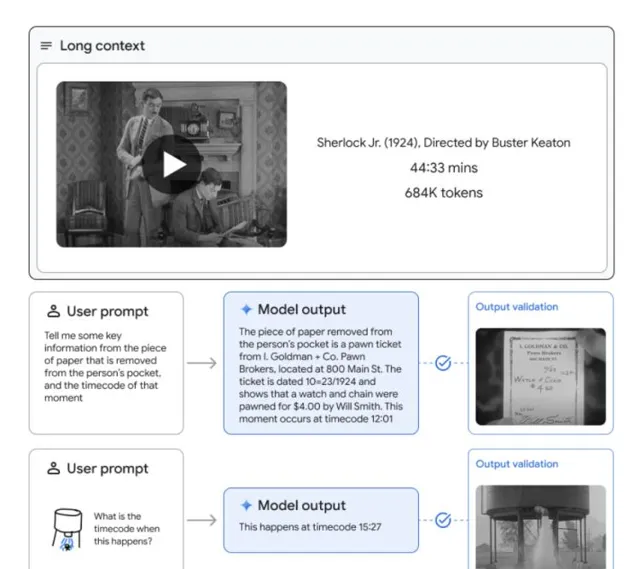

在超長視訊理解上同樣出色,能夠快速準確地分析各種事件和情節點。比如給定一部相當於68.4萬tokens、時長為44分鐘的無聲電影Sherlock Jr.,要求一句話總結電影情節:

繼續詢問一個「紙張從口袋取出的關鍵資訊和時間」。Gemini 1.5 Pro用時57秒給出詳細答案。

另外,Gemini 1.5 Pro超大的上下文視窗還能夠深入分析整個程式碼庫。當發出一個81.6萬tokens、超過10萬行程式碼的提示時,它可以根據提問快速找到特定demo的程式碼,還能提出有用的修改建議並進行解釋。

一本語法書,自學轉譯新語言

另一項讓人耳目一新的是Gemini 1.5 Pro的「 上下文學習(in-context learning) 」技能,意味著它能從一個長提示中給出的資訊裏學習新技能,而無需額外微調。

為此,Google使用「對一本書進行機器轉譯 (MTOB)」進行測試,並選用新幾內亞西部不到200名使用者的Kalamang語。由於該語言幾乎沒有任何網路資訊,模型只能依賴於給定的上下文數據,而非訓練權重中儲存的知識來進行轉譯。

在測試中, 工作人員向Gemini 1.5 Pro提供了500頁參考語法、2000條雙語詞條和400個額外的平行句子——總計約25萬tokens資訊作為其輸入上下文,要求從中學習並完成Kalamang語和英語的互譯。

從測試結果可見,Gemini 1.5 Pro對整本書的轉譯得分接近人類學習者,在半本書的表現中遠超GPT-4 Turbo與Claude 2.1。

對於一門在模型訓練過程中幾乎完全沒接觸過的語言來說,這一成就尤為突出。不僅支持瀕危語言的保護和復興,也為其它低資源教育領域開辟了新的可能性。

從今天開始,Google將透過AI Studio和Vertex AI向開發者和企業客戶提供 Gemini 1.5 Pro的有限預覽許可權。最終在完成所有安全部署和測試後取代Gemini 1.0。免費使用的Gemini 1.5 Pro標準版將采用12.8萬個tokens上下文視窗,普通使用者需要額外支付費用獲得100萬tokens使用權。

被OpenAI「夾心」,但仍不可小覷

此次Gemini 1.5的釋出時間再次「不湊巧」,前有OpenAI放話開發網路搜尋產品和推出GPT記憶功能,後面緊跟著兩小時後又橫空殺出個Sora。阿特曼武器庫豐富且擅長針鋒相對,每當Google有新動作,剛要炸起水花就被摁下去。

網友們形容當天的場面就如同:

但是,依然有不少聲音站出來提醒大家切莫小看了Gemini 1.5 Pro,它對超長文本強大的分析推理能力是其它大模型做不到的。

NVIDIA高級科學家Jim Fan更是發表評論盛贊。表示盡管Gemini-1.5 Pro被搶走了風頭,被人們拿梗圖來開玩笑,但這仍是LLM能力的巨大躍升。測試中達到的1000萬tokens上下文、擅長檢索、在零樣本情況下對極長指令進行泛化、多模態工作能力都是驚人的。

「重要的不是聲明中實作多少上下文長度的神話,而是模型實際上如何使用上下文來解決現實世界的問題。」他認為1.5 Pro不透過微調而自主實作對Kalamang語的學習和套用,就展現出了這種神經啟用中的復雜技能,超越了現有的技術水平。

如今OpenAI的急速擴張和Gemini逐步加快的升級速度,已經標誌著生成式AI底層技術的狂熱步伐。Google DeepMind 負責人Demis Hassabis表示,可以期待未來幾個月會有更多的進步。

「這是一種新的節奏」,他說,「我正試圖帶來一種類似初創公司的心態。」