近日,OpenAI 釋出新款輕量級大模型GPT-4o mini,引發行業對輕量級模型與端側模型落地的討論。

2024年是端側模型落地套用的年份,多家企業對記者表示,今年重點放在套用落地、商業化變現方面。申萬菱信基金經理廖裕舟表示, OpenAI推出的GPT-4o或標誌著AI正式走向端側,走進使用者,這使得AI套用落地變得更加清晰可見。

邏輯上,輕量級模型和端側模型都旨在降低模型的計算復雜度和儲存需求,以便在資源受限的裝置上高效執行。只是在實作方法上,輕量化模型通常透過模型剪枝、量化、知識蒸餾等技術來減少模型大小和提高執行效率。端側模型側重於將這些輕量化技術套用於終端裝置上,以實作快速響應和低延遲。

在輕量級模型技術發展與端側模型不斷落地的推動下,廖裕舟認為未來端側AI帶動的創新主線有望拉動電子行業進入新的增長周期,A股硬科技公司或將迎來估值重塑階段。

輕量級模型密集釋出

2024年,多家廠商先後釋出輕量級模型。2月,谷歌釋出比Gemini更小、更輕的版本Gemma,包括Gemma 2B(20 億參數)與Gemma 7B(70 億參數)兩個版本,可以在桌上型電腦或者膝上型電腦上本地執行;4月,蘋果研究團隊在Hugging Face模型庫上釋出包含四種小型語言模型的OpenELM系列,包括2.7億參數、4.5億參數、11億參數及30億參數;7月,法國AI創企Mistral AI推出面向程式設計師和開發人員的程式碼生成模型Codestral Mamba 7B,以及專為數學相關推理和科學發現而設計的AI模型Mathstral 7B。

最近的動態是OpenAI釋出輕量級大模型GPT-4o mini,OpenAI官網文章稱,「我們預計GPT-4o mini將擴大人工智慧的套用,讓人工智慧變得更實惠。」GPT-4o mini輸入價格為15美分(0.15美元)/百萬tokens(詞元),輸出價格為60美分(0.6美元)/百萬tokens,比GPT-3.5 Turbo便宜60%。

面壁智慧聯合創始人、CEO李大海猜測,GPT-4o mini可能是一個「寬 MOE」(expert的數量比較多)的模型,而非端側模型。作為一個價效比很高的雲端模型,GPT-4o mini一方面將雲端API市場卷到了一個新高度,另一方面也極大降低大模型落地產業成本,令行業對大規模行業套用的興起抱有更強信心。

李大海認為,OpenAI的輕量級模型體現出在不斷提升大模型參數的方向之外,行業在更小尺寸方向上追求高效高效能,這是另一條挖掘智慧潛力極限、又可降低成本的路徑。他稱,大模型的科學化,對底層的洞察、對模型規模能力的預測,越來越成為大模型研究的核心能力。行業認知底層達成了某種一致:知識密度是大模型另一個核心指標,且越來越重要。

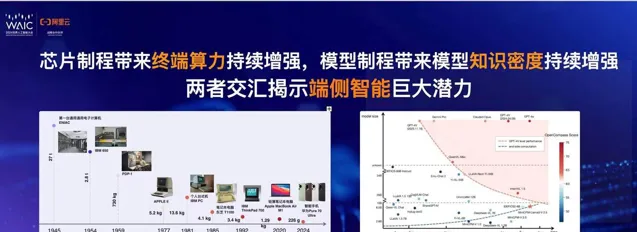

在面壁智慧看來,知識密度是模型能力除以參與計算的模型參數,類似芯片制程。而模型知識密度每8個月提高1倍,伴隨終端算力持續增強,輕量高效能模型潛力極大。

輕量級模型的設計目標是在保持模型效能的同時減少模型的計算復雜度、參數數量和模型大小,使其更適合在資源受限的裝置上執行,這使得知識密度成為其中一個關鍵考量因素。面壁智慧的方式是在真正訓練一個模型之前,在沙盒裏做演練,高效尋找最優數據、超參配置,再外推到大模型上。2024年2月,面壁智慧推出的MiniCPM 2.4B版本模型,具備超過Llama2-13B的能力。

如果類比芯片行業,清華大學電腦系長聘副教授、面壁智慧首席科學家劉知遠表示,過去80多年的時間裏,芯片制程的不斷增強帶來終端算力的提升,進而推動算力小型化。大模型的發展也會持續提升模型制程,帶動模型知識密度的增強,兩者的交匯點便是未來端側智慧的潛力。

端側承接AI落地

基座模型廠商推動輕量級AI技術發展,端側不斷開拓場景進行承接,在產業鏈上滿足模型套用落地的需求,具體包括PC、手機、XR、汽車、物聯網等。Canalys預測,相容AI的PC有望在2027年滲透率達到60%。AI手機方面,三星、小米等廠商在大模型及作業系統等方面持續探索。

端側AI並非新事物,2020年時任華為諾亞方舟實驗室技術專家王雲鶴便分享過端側AI模型的技術發展。李大海對記者表示,過去行業沒有關註端側,或暫未出現高品質的端側模型,便只能雲端模型來做事情。當雲端模型不夠用,便針對性進行微調。

如今,李大海稱,端側模型在技術發展推動下,將大模型科技生態的拼圖拼得更完整,所帶來的好處如私密安全,未來很多場景也會對終端推理可靠性提出要求,這也是端側非常好的落地方向。

賽迪顧問電子資訊和人工智慧產業研究中心分析師楊天宇將AIPC視為推動大模型落地最重要的第一終端,主因從算力承載力來看,PC較手機、智慧型手錶等其他終端產品體積更大,能夠配置更強處理器、記憶體等部件,具有支持百億級參數大模型執行的能力;從算力套用場景來看,PC較其他終端產品的套用領域更加廣闊,能夠承載娛樂、生活、工作等多場景,有利於推動端側大模型的套用推廣。

但需註意的是,端側模型是一件復雜工程,需要硬體、系統、算力等多方配合,即便如微軟、谷歌等大廠在端側部署的反饋成果也差強人意。NVIDIA亞太區高級產品行銷長許哲銘認為,AIPC現在是當紅最熱門話題之一,而當下的AI跟以往AI有一個根本上的不同——現在的AI絕大部份是生成式AI。因此從算力資源的角度來看,本地應配備一個GPU,對生成式AI進行運算,滿足生產力上的需求。另外軟體側的解決方案效率也決定了整個系統執行的效率,如NVIDIATensorRT。許哲銘對記者表示,端側模型中,NVIDIA也好,大模型廠商也好,包括硬體廠商,都應參與進來,共同建設生態。

軟通動力相關負責人對記者表示,目前大模型平台在端側AI方面的表現每年都有大幅提升,尤其是AIPC具有先天算力優勢,這使其在本地就可處理絕大多數套用負載,減少了雲端壓力,降低了企業AI套用的雲服務費用。同時需註意的是,端側需要平衡效率與功耗,多模態大模型在端側執行也面臨較大的效率挑戰。總體而言,端側AI的發展前景廣闊,但需要進一步最佳化以滿足不同場景的需求。

另外針對雲端協同,該負責人稱,端側AI的發展推動了端雲協同的普及,這種模式不僅是一種智慧推理的方式,更是模型前進演化的革新範式。目前國內市場在端側部署方面更側重於私有化部署,特別是在政務和科研場景中,私有雲的套用得到了廣泛落地。同時,輕量化大模型和NPU等技術的發展也促進了AI在端側在地化部署。總體來看,端雲協同已成為未來大模型套用的主流模式。當越來越多AI計畫的ROI都能跑通,在商業端得到驗證,形成正向迴圈,這種改變一定會加速,行業「入口」也可能會隨之改變。

(本文來自第一財經)