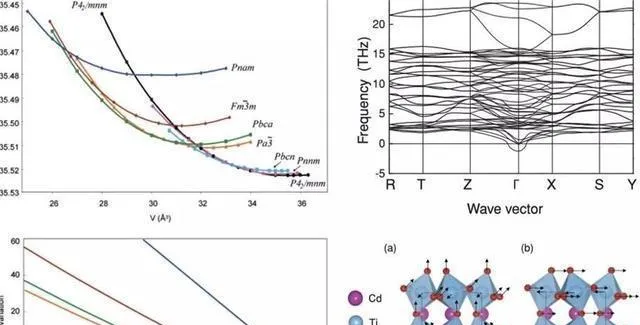

好多時候,之所以用人工神經網路去模擬熱物理性質,是因為缺少對應類別物質的恰當物理模型。這人工神經網路是由多層通常高度相互連線的神經元構成的。

這些神經元層會把輸入(不管是來自其他神經元還是訓練數據)收集起來,放進啟用函式裏,然後把轉換完的資訊傳給其他神經元(或者是網路的輸出層)。

要是增加神經元還有互連,或者選更復雜的啟用函式,那人工神經網路的靈活性差不多能無限提升。多層的人工神經網路叫做深度神經網路。人工神經網路能搞定復雜的元件描述符。

比如說,分子圖能當成所謂的圖形神經網路(GNNs)的輸入。GNNs 還被拿來模擬混合物的熱物理性質。在這個領域使用人工神經網路的情況,像預測瓦斯溶解度以及混合物的體積特性。

好多來自監督學習的其他辦法,都已經成功地用在模擬熱物理性質上了。

像支持向量機和隨機森林這些,為了簡單點,咱在這就不再更詳細地說這些方法了。

選擇包含相關資訊的合適組分描述符這事兒,在熱物理性質的監督學習裏挺明顯的。不同復雜程度和型別的元件描述符都用在這上面了,大概能分下面這些類:

監督學習和無監督學習最根本的不同就在於,無監督學習不需要那種有標簽的訓練數據。

要是圖裏展示的這個方案沒人監督,ML 演算法不會曉得對映預先指定的描述符 d ,而是會自己去發現一組給定數據裏的結構 y 數據,之後能拿來做預測。

所以啊,無監督學習能讓人開發出混合物的模型,而且不用依靠任何有關純組分的明確資訊。

在所示的這個情境裏,無監督學習的運用能算作特征學習的一種,就像推薦系統裏那樣(比如視訊流供應商和線上零售商使用的這類系統)。

無監督的 ML 演算法能從使用者的行為裏把使用者特征(還有電影或者商品的特征)給提取出來,而且不需要任何有關使用者(或者電影、商品)的額外資訊。

在混合建模裏,學到的特征屬於純組分的特征。不過呢,和監督學習一對比,無監督的 ML 演算法並不需要相關特征事先就知道,也不需要是在物理上能看得見摸得著的。

反過來講,要是相關特征是潛在的,藏在混合數據裏頭,能從這裏把它們找出來。

無監督的特征學習不是要先選成分描述符,而是能產生一種新的這類描述符,直接從混合數據裏學。

矩陣完成方法(MCMs)構成了一種特別有意思的混合物熱物理性質的特征學習手段。

這些模型挺有意思的,原因在於二元混合物(給定狀態點那種)的性質數據能輕松地按矩陣形式去排列,一行代表一種成分,一列代表另一種成分。

因為實驗混合物的數據不多,矩陣老是被稀疏地占著;所以,對缺失條目的預測屬於矩陣補全的問題。

到現在為止,MCMs 已經能成功用來預測二元混合物的一些不同熱物理性質了,像活度系數、亨利定律常數、自擴散系數這些。

還有吸附這一塊,雖說實驗資料庫範圍太小,占用率常常都不到 10%,可它們還是獲得了很出色的預測效能,而且比物理基準方法還好。

這些 MCM 學習的潛在特征能當成一種新的純組分描述符(單純由混合物數據來確定)。

它們能跟物理純組分描述符產生關聯,還能讓人明白在分子層面描述混合物裏組分行為的關鍵要素

註意哈,就像上面說的那樣,把無監督學習用到模型的輸出上可不是常見的情況,而是個例外。它用在模型的輸入上的時候更多。

在模擬熱物理性質的時候,這就相當於基於 ML 的組分描述符分析,比如說,用它來辨識並減少冗余,或者降低輸入參數空間的維數,這種辦法還能用來分析現有的數據集。

這種分析能夠把系統的依賴性給揭示出來,進而產生認知方面的後果。

討論中提到把 ML 用到熱物理性質建模的諸多具體難題,天然就制約了純數據驅動的 ML 在這個領域取得成功。

不過呢,往好的方面想,咱們這個領域在領域知識這塊特別充足,像高度發展的物理模型都包含在裏面。

所以,特別重要的事兒就是把這些知識跟 ML 弄一塊兒,建立出混合模型。

混合模型或許能把兩個方面的好處結合起來:在 ML 方面,演算法以及復雜訓練策略有著很高的靈活性;在物理學方面,遵循物理定律,還有相關的預測能力。

接下來的小節裏,咱們講了四種把 ML 和物理建模結合起來的通用辦法,還有最近研究裏的例子。

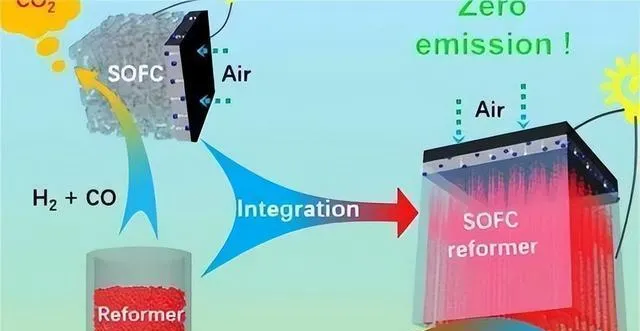

應對實驗數據稀疏性難題的直接手段,就是在 ML 模型的開發以及訓練裏納入物理模型生成的數據。

這種方法示意性地呈現出來。

一個重要的問題存在於這種混合當中,那就是不同型別數據的加權情況。

要是給物理模型的結果加了太多的權重,弄出來的混合模型就會重現物理模型,而不是實驗數據。

這種方法有時會拿來預測混合物的熱物理性質。另外,用最大似然預測去擬合物理模型,並且只拿物理模型的結果去訓練 ML 模型,這事兒已經被舉報了。

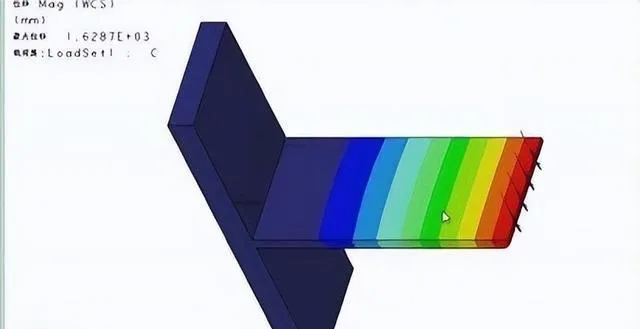

表明了這種混合手段對亨利定律常數的預估,針對溶質 i 在溶劑 j 中的情況,在 298 K 這個條件下,物理模型是 PSRK EOS ,而 ML 模型是一個 MCM 。

PSRK 模型的合成數據並非像實驗數據那樣被使用,而是先用來生成 MCM 參數的資訊。

然後在貝葉斯框架裏把它跟實驗數據擬合,跟物理基準測試一比,這種混合辦法有了很明顯的改進。

另外一種開發混合模型的策略是運用所謂的整合辦法,它的想法是把多個弱學習器組合起來,從而得到一個強學習器。

講了一個模型並列互連的辦法。

這種方案在 ML 文獻裏叫裝袋,其結果能夠透過不一樣的方式進行組合。

一個挺簡單的辦法是加權平均,不過呢,也能像這樣,比如說,檢視兩個模型是不是在特定範圍內一致,只有在這種情形下,才接受預測。

這種增強的辦法已經順利地用在預測活度系數和自擴散系數上,其方法的變種,像是多個 ML 模型依次相互連線來預測瓦斯溶解度或者傳輸內容的情況,也有被報道過。

展現出了這種推進方式的成果。

任務在於預測自擴散的系數

溶質 i 在溶劑中無限稀釋 j ,所以要在 SEGWE 模型的殘留誤差上訓練 MCM ,讓它學會怎麽糾正這些預測。

然後把學到的校正用到 SEGWE 結果上,再把這個結果跟單獨的 SEGWE 結果作比較,就表明跟物理基準模型相比,這樣的混合有了很明顯的改進。

boosting 方法實質上是有幫著改進物理模型的可能的,原因在於它能給出有關物理模型系統性弱點的全面又有條理的資訊。

另外一種雜交的辦法是把 ML 方法嵌入到物理模型裏頭(好比說,透過 ML 演算法去學習,然後預測物理模型的參數)。維持物理框架能夠留住物理建模的長處。

要是符合一致性的標準,還有預測的能力;另外,人們能夠運用 ML 方法的靈活性。

用 ML 方法來開發分子模擬的力場,這是把 ML 嵌入到物理模型中的一個情況。

基本的想法就是開展量子化學計算,ML 演算法能從這些計算裏學到力場,接著就能拿來對材料的內容進行模擬。

好多近期的出版物都采用了這種辦法。另外,還有一些講用人工神經網路去預測狀態方程式參數的報告。

另外一個重要的嵌入例子是借助 MCMs 去預測交互作用。

因為好多物理模型都依照這個概念,所以它的適用範圍挺廣的。

展示了基於這種思想的混合模型的典型結果,此模型是把 MCM 嵌入到 UNIQUAC 模型裏,用來研究二元混合物的組分之間的對交互作用參數的結構。

接著就用推斷出的結構去預測那些新的、以前沒研究過的組分組合的相關參數。

這種辦法讓 UNIQUAC 能用到沒有數據的混合物裏,這一般是做不到的,原因在於交互作用參數得跟感興趣組分的每個二元組合的數據相匹配才行。

把這種混合方法得出的結果跟系統推廣的物理金標準做個比較,基團貢獻法對 UNIFAC (Dortmund)做了修正,同樣,混合模型的表現要比物理基準模型好。

MCM 成功地被用來預測 UNIFAC 交互作用矩陣裏缺失的參數。

這種辦法的好處是,把 MCM 嵌入到 UNIQUAC 模型裏,物理模型就能一直具備對狀態點(像溫度和組成)還有性質進行統一歸納的本事,也能擁有從二元混合物向外推算到多組分混合物的能力。

同時,MCM 能讓模型對沒研究過的二元混合物做出預測。

在這種混合模型裏,MCM 能透過不同的辦法建立,特別有意思的是,在混合模型中恢復交互作用能量的對稱性是有可能的。

這在 UNIQUAC 方程式的原始公式裏沒被考慮到,只引入了兩個(不對稱的)可調參數,而非一個,這是 ML 和建模裏認知問題密切相關的又一個例子。

最後要說的一點也挺重要,能照著跟中所示策略互補的那個策略來,把物理知識放到 ML 演算法裏面。

這種方法被示意性地進行了描述。

一個關鍵問題在於保證結果能符合物理定律;還有個問題是想辦法增強預測的能力。

在 PINNs 裏,模型的損失函式(純數據驅動的 ann 中,就只看模型結果跟訓練數據的偏差)還加上了一個用來懲罰跟顯式物理知識有偏差的項。

當下,PINNs 主要是把(已知的)微分方程式直接放到損失函式裏,再借助自動微分演算法。所以,在 PINN 訓練的時候,這個模型得重現訓練數據;同時,還得給出符合給定微分方程式的結果。

雖說用 PINNs 去模擬熱物理性質好像挺有盼頭,可它們很少被這麽用。

PINNs 有個天生的毛病,就是屬於軟約束的辦法。這意思是,它只能大概滿足約束條件,而不是精確滿足。在表示數據和遵循約束這兩方面,始終存在一個權衡。

所以啊,弄出來的模型在一定程度上偏離了約束(這裏說的是物理理論),每回都得搞清楚這種差別能不能行。

就算從實際操作的層面來說,這些差異沒啥壞處,可它們或許會讓模型不那麽容易被接受。

所以啊,嚴格落實物理邊條件那種硬約束的辦法(得直接改動演算法架構)挺有意思的,可在這方面的研究還特別少。

在科學與工程的實際操作裏,把 ML 演算法中的領域知識嚴格落實是構建 ML 模型的一個大難題。

這些限制的引入會對結果產生怎樣的影響,這還是個沒答案的問題。

喪失靈活性到底是有害處呢,還是對預測有好處?另外,從實踐以及認識論的層面來講,選擇去執行啥樣的規則,這是個挺有意思的問題。