作者:洛洛 | 來源:3DCV

在公眾號「 3DCV 」後台,回復「原論文」可獲取論文pdf和程式碼連結

添加v:dddvision,備註:結構光,拉你入群。文末附行業細分群

1、導讀

傳統的相位測量偏折測量技術在測量低反射率的表面和復雜曲面時存在一些問題。低反射率表面的捕獲的條紋圖案品質很差,無法正確提取相位。而復雜曲面會產生包含閉環和開環特征的復雜反射條紋圖案,使得傳統的單次拍攝相位測量方法難以獲取相位。因此,本研究旨在利用深度學習技術解決這些問題,提出一種基於深度學習的單次拍攝相位測量偏折測量方法,以實作對復雜自由曲面的 三維測量。

2、研究內容

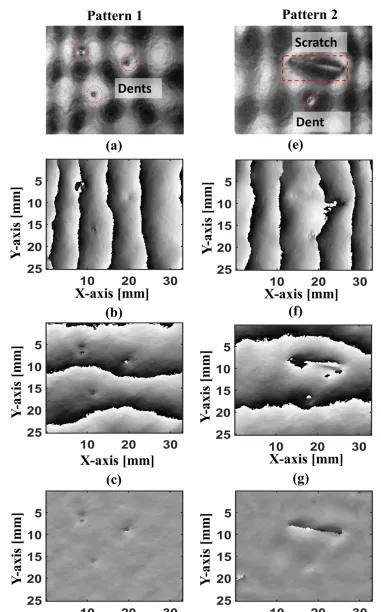

一種基於深度學習的單次拍攝相位測量偏折測量法用於復雜自由曲面的三維測量。文章介紹了目前單次拍攝偏折測量法存在的兩個主要問題: 低反射率鏡面表面的測量 和 復雜曲面的測量 。為了解決這些問題,研究團隊采用了低頻率的復合光柵圖案來提高低反射率表面的光柵可見度,並利用深度學習方法處理復雜曲面的相位測量。透過深度學習網路的訓練和最佳化,可以實作單次拍攝下復雜曲面的三維測量和缺陷檢測。

3、方法

利用深度學習網路模型DYnet++從單個復合圖案中獲取相位資訊。為了訓練深度學習模型,作者使用了一個具有九個致動器的可 變形鏡來生成各種表面形狀的大量數據。透過將測量結果與16步相移法的結果進行比較,驗證了所提出的基於深度學習的單次拍攝偏轉測量方法的可行性。該方法的優點是可以在單次拍攝中獲取復雜表面的相位資訊,避免了傳統相移法需要多張影像的缺點。深度學習網路模型能夠學習並理解復雜的圖案特征,從而準確地提取相位資訊。這種方法在工業環境中具有廣泛的套用前景,可以提高測量效率和準確性。需要註意的是,該方法目前還處於研究階段,可能還存在一些局限性和改進空間。但是,基於深度學習的單次拍攝偏轉測量方法在解決復雜表面測量問題方面具有很大的潛力,並且在實際套用中可能會得到更多的發展和改進。

3.1、偏轉法表面測量原理

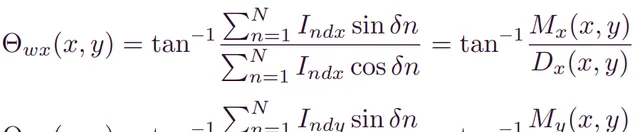

偏轉法表面測量是一種用於測量光滑自由曲面的斜率測量技術。它使用螢幕(LCD螢幕)來顯示調變的正弦條紋圖案,該圖案投射到被測曲面上,然後由相機接收反射的條紋圖案。透過這種方式,我們可以獲得曲面的斜率進行分析。如果我們可以獲得兩個正交的曲面斜率,就可以透過積分來重建曲面的形狀和尺寸。對於缺陷檢測,不僅需要檢測曲面上的缺陷,還需要確定缺陷的形狀和尺寸。因此,我們需要將兩個正交的條紋圖案(稱為 和 圖案)投射到被測曲面上,以獲得曲面的斜率進行積分。傳統上,使用相移方法來獲取 和 方向上的曲面相位,因為它具有像素級的相位恢復和高分辨率。捕獲的條紋圖案可以透過以下數學運算式表示:

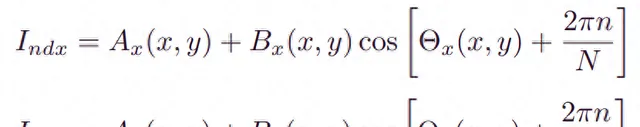

其中, 和 分別是捕獲的 和 條紋圖案的光強度; 是相機的像素座標; 和 是背景, 和 是條紋調變; 和 是 和 方向上的相位; 是相移數( ), 是相移的總數。透過這些捕獲的條紋圖案,可以透過以下公式恢復 和 方向上的相位:

其中, 和 是 和 的包裹相位。它們需要使用空間相位展開演算法進行展開。 是相移值。通常情況下,如果相移步數N越大,恢復的相位精度越高。

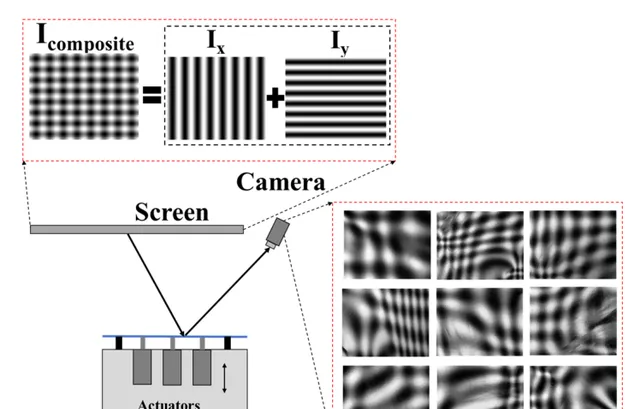

3.2、DYnet++

DYnet++是一種基於深度學習的單次拍攝相位測量偏折測量方法,用於測量低能見度和復雜鏡面表面。DYnet++深度學習網路,用於從單個低頻復合條紋圖案中獲取相位進行表面測量。DYnet++網路接受一個輸入,即捕獲的低頻復合條紋圖案,並輸出每個解碼器路徑中的兩個分子和兩個分母項。透過訓練過程,每個解碼器路徑將具有預測分子和分母的最佳參數。然後,透過這些量的反正切計算出x和y的包裹相位。DYnet++網路的結構受到Ynet和Unet++的啟發。我們試圖結合這些網路的優點來進行相位檢測。DYnet++網路在Unet++的基礎上添加了一個解碼器路徑,使其對稱化。

3.3、DM

在這篇論文中,作者使用了可變形鏡面(DM)來生成訓練數據集。DM是一個可以透過施加力來改變形狀的金屬板。透過改變DM的形狀,可以改變捕獲到的條紋圖案。使用DM生成訓練數據的優點是可以快速生成大量的訓練數據,只需改變鏡面的形狀即可。作者首先在液晶顯示器上顯示復合圖案,然後透過相機捕獲反射的圖案作為訓練數據的輸入。然後,作者使用相位移方法在x和y方向上顯示16步的相位移影像,作為訓練數據的真值。對於每個輸入復合圖案,相應的輸出將是 , , 和 。透過改變 的形狀,可以生成不同的訓練數據。作者透過改變每個致動器的位置1000次來隨機改變 的形狀,從而生成了總共4000個訓練影像和真值。使用這種方法生成訓練數據,網路可以學習如何從單個復合圖案中預測正確的分子和分母。

4、實驗結果

使用TensorFlow和Keras 2.8.0深度學習庫實作了DYnet++。訓練過程在一台配備Intel Core i9-12900K CPU、64 GB RAM和Geforce RTX-3090 GPU(NVIDIA)的台式電腦上進行。他們使用了不同形狀的變形鏡(DM)生成了訓練數據集,總共生成了4000個訓練影像和對應的地面真值。訓練數據集的大小為320×240像素。他們使用了均方誤差作為損失函式,並使用 平均絕對誤差作為評估指標。訓練總共耗時約12小時。

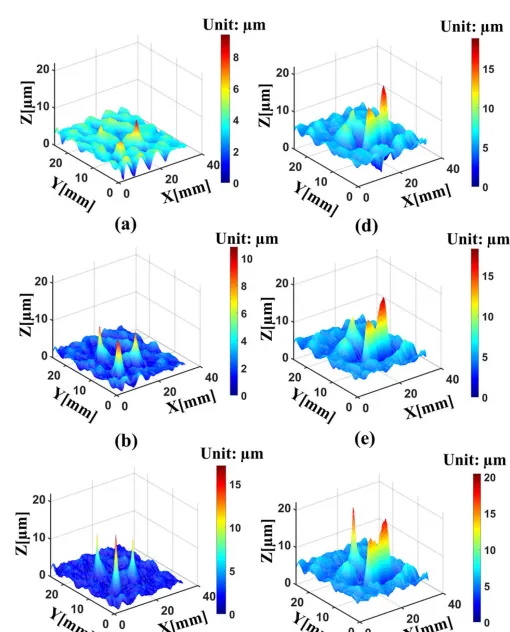

在測試中,他們使用了與訓練和驗證數據不同的變形鏡生成的復合圖案作為輸入。他們展示了一些測試結果,並與地面真值進行了比較。結果顯示,DYnet++方法在形狀重建方面與傳統的16步相移方法相比具有相似的效能,而16步相移方法需要32張相移影像。此外,他們還進行了低可見度表面的測量和缺陷檢測實驗,結果表明DYnet++可以從單次復合圖案中檢測出小的缺陷。總的來說,DYnet++方法透過深度學習實作了單次拍攝相位測量偏折測量,具有較好的效能和套用潛力。

5、總結

我們的研究提出了一種基於深度學習的單次偏轉測量方法DYnet++,能夠測量和檢測復雜自由曲面。這種方法具有廣泛的適用性和高效的效能,可以在即時或高速環境下進行復雜曲面的測量和檢測。

3D視覺交流群

大家好,群裏會第一時間釋出3D電腦視覺方向的最前沿論文解讀和交流分享,主要方向有:

視覺 SLAM 、雷射 SLAM 、 ORB-SLAM 、 Vins-Fusion 、 LOAM/LeGo-LOAM 、 cartographer 、 VIO 、語意SLAM、濾波演算法、多傳感器融合、多傳感器標定、 MSCKF 、動態 SLAM 、 MOT SLAM 、 NeRF-SLAM 、 FAST-LIO 、 LVI-SAM 、 LIO-SAM 、事件相機、 GPS / RTK / UWB / IMU /碼盤/ TOF ( iToF 、 dToF )、雷射雷達、氣壓計、公釐波雷達、RGB-D相機、超音波等、機器人導航、相機標定、立體匹配、三維點雲、結構光(面/線/散斑)、機械臂抓取(2D/3D)、2D缺陷檢測、3D缺陷檢測、6D位姿估計、相位偏折術、 Halcon 、光場重建、攝影測量、陣列相機、偏振三維測量、光度立體視覺、雷射雷達、 NeRF 、多檢視幾何、 OpenMVS 、 MVSNet 、 colmap 、紋理貼圖、深度估計、 Transformer 、公釐波/雷射雷達/視覺網路攝影機傳感器、多傳感器標定、多傳感器融合、自動駕駛綜合群等、目標檢測、3D目標檢測、路徑規劃、軌跡預測、3D點雲、3D點雲分割、模型部署、車道線檢測、 Occupancy 、目標跟蹤、四旋翼建模、無人機飛控、求職、硬體選型、視覺產品落地、最新論文、3D視覺最新產品等綜合交流群。

添加v: dddvision,備註:研究方向+學校/公司+昵稱(如3D點雲+清華+小草莓), 小助理會拉你入群。