作者|武靜靜

編輯|鄧詠儀

1月11日,阿裏雲升級第八代企業級通用計算例項ECS g8i產品。新產品依托於英特爾在2023年12月釋出的第五代至強可延伸處理器,以及阿裏雲自研的「飛天+CIPU」架構體系所搭建。

升級之後,新產品的在算力、網路、效能、套用場景方面有能力提升:

面對目前火熱的大模型需求,新升級的ECS g8i例項進行了升級最佳化 ,讓大模型跑在CPU上,並有效降低了模型搭建成本。

這對於大模型的商業化落地意味著全新的嘗試。一般而言,CPU在浮點、並列維度和記憶體寬頻上都與GPU能力相差甚遠,讓模型跑在CPU上是一件困難的事。

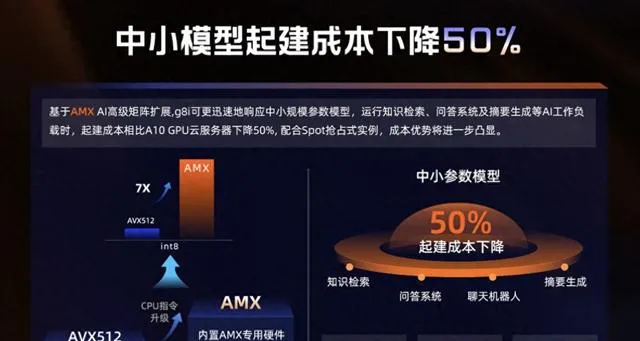

在技術,ECS g8i上做了一次新的嘗試。為了解決首包延遲和吞吐效能技術難題,ECS g8i例項進行了針對性的技術最佳化,其內建指令集從AVX512升級到了Intel AMX高級矩陣擴充套件加速技術,可以加速模型執行。

有了加速能力之後,模型推理過程在CPU上也能跑通,大大降低了大模型搭建和推理成本。此外,CPU相較GPU而言,更容易獲取,成本也更低,所以,這也為解決算力短缺難題開啟了新可能。

阿裏雲彈性計算產品線總經理張獻濤表示 : 「g8i可更迅速地響應中小規模參數模型,執行知識檢索、問答系統及摘要生成等AI工作負載時, 起建成本相比A10 GPU雲伺服器下降50% 。」

阿裏雲新釋出的ECS g8i產品

目前,在CPU上,ECS g8i不僅能支持中小模型的推理計算,還可以支撐72B參數級別的大語言模型分布式推理。以阿裏雲通義千問開源的Qwen-72B大模型為例,它可在g8i例項eRDMA網路構建的集群實作高效執行,輸入小於500字時,首包延時小於3秒,每秒可生成7個Token。

此外,ECS g8i還能支持超過32batchsize的超大參數規模的AI模型負載,涵蓋目前市面上的文生圖、AI生成程式碼、虛擬助手以及創意輔助工具等多類模型。

在實際的模型落地中,要結合場景端的需求,綜合考量效果和成本。根據阿裏雲的測試,透過CPU做超高並行,可以充分利用算力,進行長時間計算和推理。目前,ECS g8i在一些對即時性要求不高的離線場景,比如創意廣告生成、離線視訊摘要生成等AI功能方面,已經有良好的效果。