他曾经参与Q*项目,是这个创新技术的创造者之一。

当记者追问Lukasz Kaiser关于Q*的更多细节时,OpenAI的公关人员差点跳起来捂住他的嘴。他们显然不想让这个话题继续下去。

奥特曼在接受采访时,很干脆地拒绝了有关问题的回答,他说:「我们现在还不想说这个话题呢。」意思很明确,他们还没准备好公开讨论这件事。

OpenAI现在得把神秘Q*当作头等大事来保密。这玩意儿太重要了,一旦泄露出去,后果不堪设想。所以,大家都得紧咬牙关,打死也不能说出去!

Noam Shazeer,也就是现在Character.AI的创始人,其实才是谷歌在生成式AI领域最大的功臣。早在2012年,他就参与了谷歌的生成式AI搜索项目。到了2017年,他还提出了训练万亿参数大模型的建议,不过可惜,这个建议没得到公司高层的认可。总的来说,他提供的信息比那些在商业论坛上互相吹捧的大佬们有价值多了。

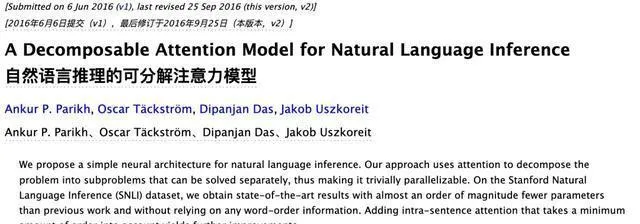

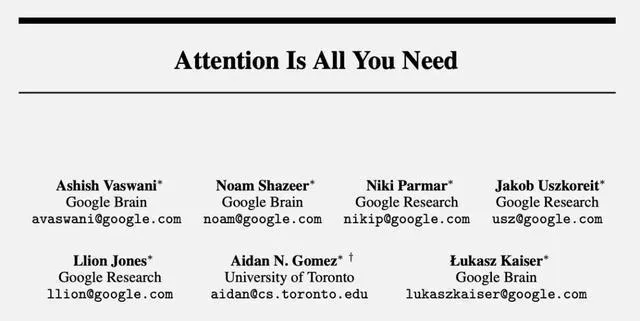

【Attention is all you need】这篇文章是在2017年发表的,现在已经被引用了超过11万次,可见它的影响力有多大。简单说,这篇文章就是告诉我们,只要我们集中注意力,就能做好很多事情。所以,大家要记得哦,注意力可是成功的关键呢!

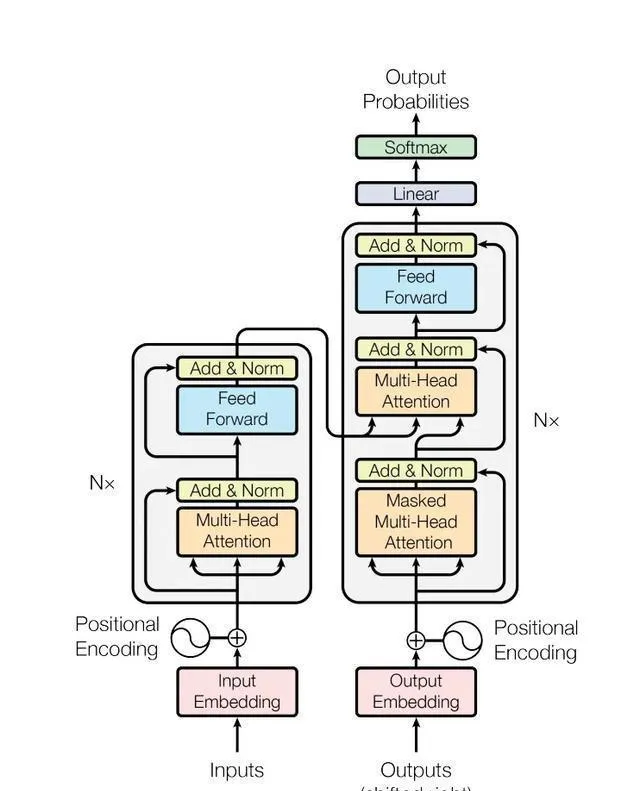

这不仅仅是大模型技术的起源之一,像是ChatGPT这样的。它里面提到的Transformer架构和注意力机制,也都用在了许多让世界发生改变的AI技术上,比如Sora和AlphaFold。这真的是个传奇,毫无疑问!

谷歌为什么能取得这么棒的成果呢?但为啥后来在大模型比赛中又没能保持领先呢?

2012年,整个故事就此展开。

【谷歌害怕Siri抢饭碗】

2011年底,苹果发布了Siri,它的目标就是在对话中回答你的问题。Siri可以帮你解决各种问题,你只需要跟它对话就可以了。

谷歌高层现在超级紧张,觉得Siri可能会把他们的搜索流量给抢走了。

2012年那会儿,有个团队挺拼的,他们就想着在搜索页面上直接回答大家的问题,不用再点击啥链接跑到别的网站去。就这样,他们努力开发新功能,希望能给大家提供个更方便的搜索体验。

最后,这些努力终于催生出了Transformer架构,这个架构真的很神奇,它能在数据和算力上不断扩展,给整个AI领域带来了巨大的突破。简单来说,就是因为这个架构,AI变得更加强大和灵活了。

在那个时候,Jokob Uszkoreit(现在是AI生物技术公司Inceptive的联合创始人)决定放弃攻读博士学位,加入了这个团队。他的加入,可以说是Transformer项目的最初起点。

他是个地道的德国人,硕士学历,是在柏林工业大学完成的。他老爸Hans Uszkoreit,在语言学界可是个响当当的人物,不仅是个著名的计算语言学家,还是欧洲科学院的院士呢。

乌兹哥现在回想起来,觉得谷歌高层当初对Siri那么紧张真是小题大做了。事实上,Siri从来就没能给谷歌带来什么真正的威胁。不过话说回来,他也挺高兴有这个机会深入钻研人工智能和对话系统的。

2012年,AlexNet在计算机视觉领域大放异彩,引领了神经网络的复兴。谷歌公司看到了这个机会,于是鼓励员工尝试类似的技术。他们希望利用这些技术,开发出能够自动补全电子邮件的功能,或者创建一些相对简单的客户服务聊天机器人。可以说,谷歌在那一年里,对神经网络和人工智能充满了期待和热情。

那个时候,大家都觉得长短期记忆网络LSTM是个挺好的方案,但这个办法有个问题,就是它只能一个接一个地处理句子,不能提前看到文章后面可能有啥线索。这样一来,它就不能充分利用文章里的所有信息了。

大约在2014年,乌兹哥开始尝试一种新方法,也就是现在大家所熟知的「自注意力」方法。

【注意力机制诞生】

乌兹哥觉得,自注意力模型或许比循环神经网络还要快、还要好使,而且它处理信息的方式特别合GPU的胃口,因为GPU擅长并行处理嘛。

不过那时候,很多人包括他的那个学术大神级别的老爸都觉得这是个不靠谱的选择,觉得放弃循环神经网络就像是走上了歪路。

乌兹哥费了不少劲,终于让几位同事同意尝试他的新想法,并在2016年成功发表了一篇论文。

这个研究其实只用了很少的文字训练,就是那个SNLI数据集,里面大概有57万个英语句子,都是人写的。

别的研究人员就像是参加答题闯关游戏,答对一题就拿了点小奖金然后走人。但乌兹哥不一样,他觉得自注意力机制还有更大的潜力。于是,他在公司里到处找人,想把他的想法推销出去。

在2016年的一天,他终于遇见了志趣相投的Illia Polosukhin,也就是现在区块链公司NEAR Protocol的创始人。

【集齐8位圆桌骑士】

菠萝哥在谷歌已经打拼了三年,他所在的团队是专门负责给搜索问题提供直接答案的。

菠萝哥碰到了一些挑战,因为用户希望他们的问题能在几毫秒内得到回应。但是,那时候还没有一个能满足这么快速回应需求的解决方案。所以,菠萝哥的工作进展就没那么顺利了。

乌兹哥和菠萝哥一起吃饭,聊着聊着就听说这事儿了。乌兹哥一听,立马就大力推荐他的自注意力机制。他觉得这个方法真的很不错,所以就毫不犹豫地安利给了菠萝哥。

菠萝哥曾经说过,他觉得A自注意力特别像科幻小说【你一生的故事】和电影【降临】里那种外星人「七肢桶」的语言。那种语言没有先后顺序,而是像几何图案那样排列的。他觉得特别有意思,就像是一种全新的思考方式。

总之啊,菠萝哥最后不仅答应试试看,还找来了第三位小伙伴Ashish Vaswani一起合作。他们俩一起先后创办了Adept AI和Essential AI,真是挺厉害的!

瓦斯哥是个印度人,他在南加州大学读完博士之后,就加入了谷歌大脑。他觉得神经网络这东西特别厉害,能帮助人类更好地理解这个世界。

这三位研究人员一起制定了Transformer的设计文档。从一开始,他们就决定使用「变形金刚」这个名字,这个名字有两层意思。一方面,他们希望这个系统能像变形金刚一样,能够灵活地改变接收到的信息。另一方面,这个名字也来源于菠萝哥小时候喜欢玩变形金刚玩具的经历,算是他们之间的一个小插曲。

菠萝哥在谷歌待了没多久,就决定离开去创业了。与此同时,其他的小伙伴们也陆续加入了这个小团队。大家一起努力,一起奋斗,为了实现共同的梦想而不断前进。

2017年初,有个叫Niki Parmar的人(我们就简称她为帕姐)加入了进来。她和瓦斯哥都是印度人,也都上过南加州大学,之后两人还一起创业。

后面几位成员加入的方式都有点儿出乎意料,挺有戏剧性的。

英国小伙子Llion Jones(我们亲切地叫他囧哥)2009年从伯明翰大学硕士毕业,但刚开始那几个月找工作挺费劲的,只能靠着救济金过日子。不过,他并没有放弃。2012年,他先加入了Youtube团队,后来又进了谷歌研究院,可以说是混得风生水起。

他是团队里最后一个离开谷歌的,去年在日本创建了Sakana AI这家公司。

囧哥是从同事Mat Kelcey那里听说Transformer的,但Kelcey对这个项目并不太看好。

Kelcey是个贝叶斯理论的信徒,他的头像显示AI认为他有60%的几率是个技术高手。但后来他意识到,自己没能加入Transformer团队,才是他这一生中最大的遗憾。

话说回来啊,那个Aidan Gomaz,就是第六位大佬,大家都叫他割麦子。他可是现在AI公司Cohere的创始人哦。这个割麦子可真是个天才,他在多伦多大学读大三的时候就加入了Hinton的实验室。他可不是那种等着别人来找他的人,他主动给谷歌里那些写过超有趣论文的大佬们发邮件,申请合作。这就是割麦子的厉害之处,年纪轻轻就这么有干劲和眼光!

有一天,Lukasz Kaiser(我们简称他为凯哥,他现在在OpenAI当研究员)找到割麦子,说想让他来实习。过了几个月后,割麦子才后知后觉地发现,原来这个实习是专门给博士生准备的,他一个本科生本来是没资格参加的。

凯哥是从波兰来的,他原本从事的是理论计算机方面的工作。但后来,他和另一位合作伙伴发现,自注意力这个概念对他们正在研究的分布式计算的大型自回归模型问题来说,是个非常有前途并且比较激进的解决方案。于是,两人决定加入Transformer团队,一起探索这个新的方向。

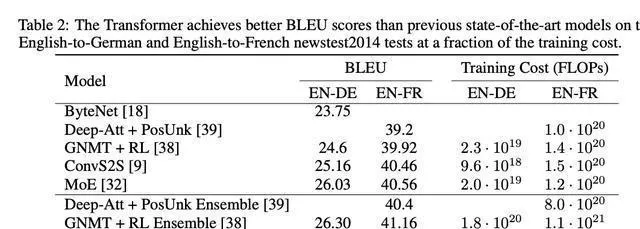

当这六个人(菠萝哥已经开始了自己的创业之路)聚在一起时,团队决定把研究的焦点放在机器翻译上。他们用BLEU基准测试来对比机器翻译的结果和人工翻译的效果,以此评估模型的性能。这样,他们就可以知道机器翻译的效果如何,并与人工翻译做个比较。

早期版本的Transformer表现还挺不错的,但跟LSTM方案比起来,其实也就差不多,没有特别突出的优势。

这时,我们的第八位重要人物Noam Shazeer(我们就叫他沙哥吧)闪亮登场了。他在杜克大学读完书后,2000年就加入了谷歌,那时候整个公司才200人左右,

后来他成了谷歌内部的传奇大佬,参与了谷歌搜索的拼写修改功能,还管过早期的广告系统。在2021年,他离开了谷歌,创办了Character.AI。

沙哥说,他当时正在办公楼走廊里闲逛,刚走到凯哥旁边,就听见瓦斯哥和帕姐在激烈讨论。瓦斯哥在解释怎么运用自注意力,帕姐听起来特别激动。

沙哥原先就觉得,这是一群既聪明又有趣的人在搞一个很有前途的项目。后来,在凯哥的一番劝说下,沙哥决定加入他们,一起干这件大事。

经过漫长的等待,现在,8位传奇人物都已经亮相了,真是让人兴奋啊!

【冲刺NIPS】

沙哥的作用太关键了,他凭借自己的想法对整个代码进行了大改造,直接让系统焕然一新,上了一个新台阶。

团队一下子变得斗志昂扬,大家都开始全力以赴,想要在2017年NIPS(后来更名为NeurIPS)的截止日期5月19日之前完成任务。他们充满了动力,都在拼命努力,希望能够按时完成工作。

离截止日期还有两周时,他们几乎整天都待在办公室,就在咖啡机旁边,几乎没怎么睡过觉。

作为实习生,割麦子在不断地尝试和调试,像疯了一样探索各种技巧和网络模块的排列组合,希望能找到最佳的组合方案。他认真地对待每一个细节,不断尝试,以期望能够在这个领域获得更好的表现。

最后啊,在沙哥的指导下,我们搞出了现在这个大家都熟悉的Transformer架构,真的是超级「简约」啊,比试验中其他的方案都简洁多了。他们都说:

Noam,我们都叫他沙哥,他可是个有魔法的家伙,就像巫师一样!

沙哥真是个高手,但他自己可能都没意识到。当他看到论文的草稿,发现自己竟然是第一作者时,他还真挺吃惊的。

商量了半天,他们决定不按照学术界那种一作二作通讯作的规矩来了,而是随机排个序。为了表示大家都做出了平等的贡献,他们还在每个人的名字后面都加了个星号,并在脚注里特别说明大家都是平等的贡献者。这样一来,谁也别想争个高下,大家都平等对待。

在大家讨论论文标题的时候,英国小哥出了一个主意,他觉得可以借用披头士乐队的歌【All You Need Is Love】,然后改成【Attention is all you need】。大家觉得这个想法不错,就一致通过了。

他们开发了两个模型,一个叫基础版,一个叫大杯版。基础版虽然只有65M,但却能把其他同级选手都甩在身后。而那个213M的大杯版呢,更是厉害,它打破了BLEU测试的纪录,而且运算起来还特别快。简单说,这两个模型都很棒,但大杯版尤其出色!

直到截止时间快到了,他们还在紧急地整理实验结果。最后一刻,英法翻译的数据才搞定,论文也是在最后关头,只剩下两分钟的时候才提交的。

那次学术会议上的审稿人反应各不相同。第一个审稿人觉得论文还不错,第二个审稿人评价非常高,而第三个审稿人只是简单说了句「还可以」。

到了12月,当会议真的在线下举行时,这篇论文瞬间引发了热议。那个4小时的会议场地,简直挤满了渴望深入了解的科学家们。

谷歌当年的开放包容文化,对于Transformer的诞生历程来说,是不可或缺的。可以说,正是这种文化氛围为Transformer的诞生提供了肥沃的土壤。所以,要感谢谷歌的开放包容,才有了Transformer的今天。

这八个人能够聚在一起,其实都是因为走廊里偶然的一次相遇和午餐时的几句闲聊。

【OpenAI摘桃子】

有一天,瓦斯哥在写论文的时候,实在是太累了,整个人瘫在办公室的沙发上。他眼睛盯着窗帘看,竟然看出了幻觉,觉得那窗帘上的图案看起来就像是大脑里的突触和神经元一样。

那天他突然醒悟,他们正在做的事情不只是简单的机器翻译,而是有着更大的潜力和意义。

最终的目标就是能像人脑那样,把语音、视觉等各种信息都整合到一个统一的架构里。这样,我们就能更好地理解和处理各种信息,让机器变得更加智能和高效。

沙哥真是很有远见啊,在应用方面他想得特别远。就在他发表论文前后,他就给谷歌的高管写了一封信,展示了他的想法。真是佩服他的勇气和眼光!

他觉得公司应该放弃整个搜索索引,然后训练一个超大的神经网络,这个神经网络用的是Transformer架构。他这个想法基本上是要谷歌彻底改变他们组织信息的方式。简单来说,他就是建议谷歌大刀阔斧地改革一下。

当时凯哥他们都觉得这个想法挺离谱的。可现在一看,谷歌不就是往这个方向使劲儿吗?就是时间早晚的问题了。

乌兹哥后来想了想,其实在2019年或者2020年,谷歌本来是有机会推出像GPT-3,甚至是GPT-3.5这么牛的模型的。然后他提出了一个让人深思的问题:

我们看到了希望,为啥就不试着去实现呢?

结果出乎意料,对手OpenAI的首席科学家Ilya Sutskever在论文发布的那天就意识到了这个成果的重要性,他觉得「这正好是我们一直想要的」,于是他鼓励同事Alec Radford立即开始对这个项目进行深入研究。

Radford最初搞出了GPT的雏形,后来OpenAI调集了一大帮人马,有的是搞机器人的,有的是玩DOTA游戏的,大家都转行过来一起开发。于是就有了GPT-1、GPT-2……这些就是另外一回事儿了。

Transformer架构的初衷,就是要设计出一个能在数据和算力上都实现扩展的模型,而这也正是它成功的秘诀。简单说,就是要让它既可以处理更多的数据,又可以应对更大的计算量,这样模型才能更加强大、准确。

但如果没有高层的规划和推动,谷歌可能就只能停留在这个阶段了。单靠员工自己的努力,已经无法满足「Scaling Law」持续发展所需的人力、物力和财力了。换句话说,如果没有高层的支持和指导,谷歌的发展可能会受到限制,因为单靠员工的力量是不足以支撑整个公司的发展需求的。

OpenAI的组织方式真是独特,它既能做到从下往上那种灵活多变,又能保持从上往下那种一心一意。有了这种结合,他们在这条路上走得更远,那几乎是板上钉钉的事儿了。

OpenAI的CEO奥特曼曾经说过,他觉得谷歌的高层好像都没明白Transformer到底有多重要。

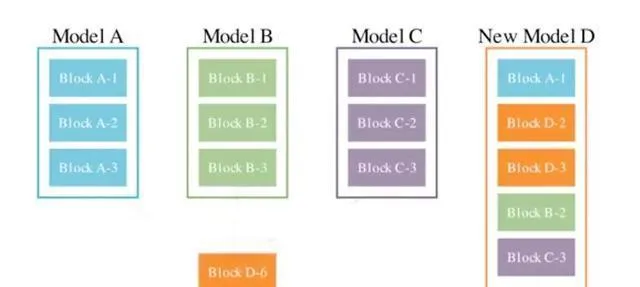

除了菠萝哥那家最早退出的区块链公司,其他成员后来都加入了和Transformer有关的项目。

2019年那会儿,有个实习生才刚毕业没多久,就带头搞起了Cohere这个公司。他们主要给企业提供大模型的解决方案,现在这家公司已经值22亿美元啦!真是个挺厉害的小伙子!

从2021年开始,团队成员陆续选择离开。

瓦斯哥和帕姐可真是不简单,他们俩一块创办了Adept AI公司,这家公司现在估值已经达到了10亿美元呢!后来,他们又合作搞了一个Essential AI,这次他们融到了800万美元的资金。这两个公司都是做自动化工作流程的,厉害吧!

沙哥是个超厉害的人,他搞了个AI角色扮演聊天平台叫Character.AI,现在这家公司可值钱了,差不多有50亿美元呢!最酷的是,它的用户活跃度和留存率都比OpenAI还要高,真是太牛了!

乌兹哥回到了德国,他创办了一家名为Inceptive的生物AI技术公司,这家公司现在的估值达到了3亿美元。不仅如此,乌兹哥还透露说,他的父亲,一位资深的计算语言学家,也在筹备一家新的AI公司,这家公司也是基于Transformer技术的。真是太厉害了!

凯哥是唯一一个没有创业的人,但他在2021年加入了OpenAI,后来还参与了GPT-4和Q*项目,真是太厉害了!

最后走的是囧哥,他可真是个牛人。23年前,他跑到日本去创了个叫Sakana AI的公司,现在竟然估值2亿美元了!真是让人佩服。他最新搞出来的东西也特厉害,就是把擅长不同领域的大模型都融合在一起,然后再加上进化算法,就搞出了个更强大的模型。这简直就是黑科技啊!

许多在谷歌工作多年的老员工都说,谷歌好像变了。以前那里是个充满创新精神的乐园,现在却变得越来越像一个只看重利润、讲究规矩的官僚机构了。

就算是在2020年谷歌发布了Meena聊天机器人之后,沙哥还是发了一封内部信,标题就是「Meena吞噬世界」。他在这封信里得出的关键结论是:

简单来说,语言模型将逐渐深入我们生活的各个角落,而且在全球的算力里面,它也会变得特别重要。我们可以预见,它在未来会扮演非常重要的角色。

这简直就是未卜先知啊,几乎完全预测到了现在ChatGPT时代正在发生的事情。真是让人惊叹!

不过,那时候谷歌的高层还是不为所动,重要的决策者们不仅没当回事,还嘲笑了他。

谷歌以前就像是掌握了整个AI世界的所有密码,但是呢,他们不小心把整个密码串都弄丢了。真是让人吃惊啊!