晶圆级AI芯片WSE-3性能揭晓:80亿参数模型每秒生成1800个Token

WSE-3 磁盘式人工智能芯片的性能公告:每秒通过 80 亿个参数模式生成 1800 个字符。

今年 3 月,Cerebras Systems 推出了第三代人工智能芯片 WSE-3,其性能是前代产品 WSE-2 的两倍,可用于训练业界最大的人工智能模型。在最近举行的 Hot Chip 2024 会议上,Cerebras Systems 详细介绍了该芯片的人工智能功能。

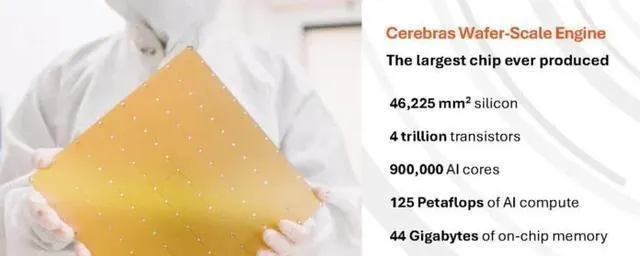

根据官方数据,WSE-3 采用基于台积电 5nm 工艺的 12 英寸晶圆制造,芯片面积为 46,225 平方毫米,拥有 4 万亿个晶体管、90 万个人工智能内核、44 千兆字节片上 SRAM、21 PB/s 的内存带宽和 214 PB/s 的结构带宽,峰值性能为 125 FP16 PetaFLOPS。WSE-3 的峰值性能为 125 FP16 PetaFLOPS,是其前身 WSE-2 峰值性能的 1 倍。

相比之下,WSE-2 芯片的表面积同样为 46,225 平方毫米,采用 7 纳米台积电工艺,拥有 2.6 万亿个晶体管、85 万个人工智能内核、40GB 片上 SRAM、20 PB/s 的内存带宽和高达 220 PB/s 的结构带宽。

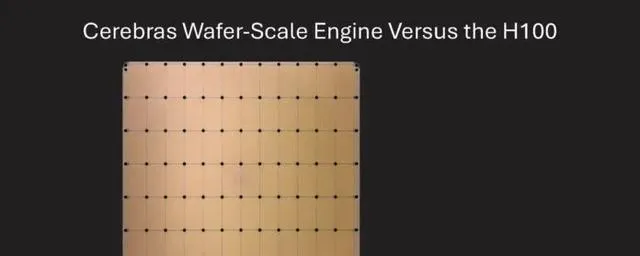

与英伟达™(NVIDIA®)的 p00 相比,WSE-3 的面积增加了 57 倍,内核增加了 52 倍,片上内存增加了 880 倍,内存带宽增加了 7000 倍,结构带宽增加了 3715 倍(p00 的 HBM3e 仅为 4.8 TBps)。

在 Hotchpotch 2024 会议上,Cerebras 详细介绍了 WSE-3 在运行大规模人工智能模型方面的性能。

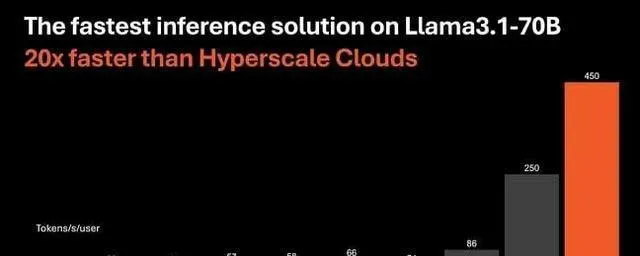

Cerebras声称,Llama 3.1-8B的推理速度是微软Azure等使用英伟达p00的公司的20倍。值得注意的是,在许多现代生成式人工智能工作负载中,推理性能通常更多受益于内存带宽,而非计算能力本身:内存带宽越高,模型推理速度越快。

据 Cerebra Systems 首席执行官安德鲁-费尔德曼(Andrew Feldman)介绍,WSE-3 使用具有 16 位分辨率和 44GB 片上 SRAM 的 Llama 3.1 8B,每秒可生成超过 1800 个字符,而基于英伟达™(NVIDIA®)p00 的最高性能实例每秒只能生成超过 242 个字符。字符数

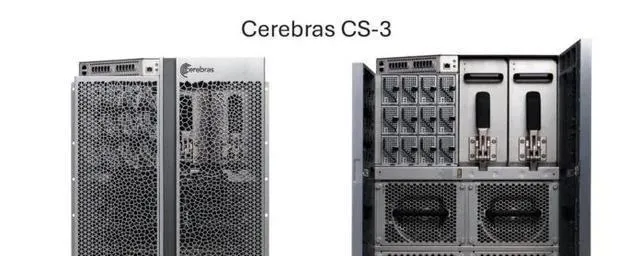

与此同时,Cerebras 推出了基于 WSE-3 的 CS-3 超级计算机,能够训练多达 24 万亿个参数的人工智能模型,与 WSE-2 和其他基于现代人工智能处理器的超级计算机相比,这是一个重大进步。该超级计算机支持 1.5 TB、12 TB 或 1.2 PB 的外部内存,可将大量模型存储在单一逻辑空间中,无需分区或重新配置,从而简化了训练过程,提高了开发人员的效率。

Cerebras的最新软件框架内置了对多模态模型、视觉转换器、专家融合和扩散以及PyTorch 2.0等最新人工智能模型和技术的支持,是唯一一个为动态和非结构化稀疏性提供内置硬件加速的平台,与英伟达DGX-100计算系统相比,训练速度最多可提高8倍。与英伟达 DGX-100 计算系统相比,最高可提高 8 倍。

此外,通过使用分布在四个 CS-3 加速器上的 700 亿个喇嘛 3.1 大参数,它还实现了每秒 450 个字符的速度。相比之下,p00 加速器每秒最多只能处理 128 个字符。

费尔德曼认为,宽带等这些发展将为人工智能带来新的机遇。他说,"我认为我们正处于通用人工智能时代,"他指的是通用人工智能的早期应用,在这些应用中,呼叫响应可能会出现明显的延迟。

他认为,如果处理请求的速度足够快,就可以建立基于多个模型的代理应用程序,而不会因为延迟而难以为继。Feldman 认为具有性能优势的另一个应用是,LLM 可以分几个阶段迭代响应,而不是只提供第一个响应。如果标签的处理速度足够快,就可以在后台进行进一步处理。

在使用 16 位分辨率的 Lama 3.1 8B 时,WSE-3 每秒可生成超过 1,800 个字符,但如果系统不受计算限制,生成字符的速度会更快。

该产品标志着 Cerebras 的改变,它以前主要专注于人工智能培训。现在,它专注于人工智能推理,但硬件并没有太大变化:据费尔德曼称,它使用相同的 WSE-3 芯片和 CS-3 系统进行推理和训练。

"费尔德曼解释说:"我们已经扩展了编译器的功能,可以同时在芯片上安装多个层。

SRAM 的速度更快,但会增加 HBM 的容量。

与 HBM 相比,SRAM 内存在性能方面具有明显优势,但在容量方面却落后于 HBM。对于大型语言模型 (LLM) 而言,44 GB 的容量并不算大,而对于 WSE-3 目标的大容量批处理而言,必须考虑键值缓存所占的大量空间。

Metan 的 Llama 3 8B 型号是 WSE-3 的理想方案,因为 16 GB 型号(FP16)适合整个芯片的 SRAM 内存,为键值高速缓存留下了约 28 GB 的空间。

据 Feldman 称,WSE-3 不仅吞吐量非常高,而且可以扩展到更大的批量规模。关于可扩展性和支持用户特定令牌吞吐率的能力,具体细节没有透露。"我们目前的批量规模经常波动。我们预计第四季度的批量规模将达到两位数,"Cerebras 说。

当被问及更多信息时,Feldman 回答说:"由于实施规模尚未确定,我们目前不想提供更多细节。该系统架构设计用于处理大批量数据,我们希望在未来几周内能够实施。

与现代图形处理器一样,Cerebras 通过将模型并行到多个 CS-3 系统来解决这一问题,特别是通过使用流水线将模型层分成多个系统。

就需要 140 GB 内存的 Llama 3 70B 而言,该机型的 80 层被划分为四个 CS-3 系统,通过以太网链路相互连接,因此数据必须通过这些链路,从而导致性能下降。

由于单个 WSE-3 只有 44 千兆字节的 SRAM 内存,因此必须将多个加速器组合起来才能支持更大的模型。

不过,费尔德曼认为,节点之间的延迟并不像人们想象的那么大:"延迟是真实存在的,但它非常小,因为信号通过芯片的所有其他层时,延迟是分布式的。"最终,信号只占总延迟的 5%。"所以只占 5%左右"。

据 Cerebras 估计,在大型模型中,例如最近推出的拥有 4500 亿个参数的 Lama 3 模型,12 套 CS-3 系统每秒可处理约 350 个字符。

使用速度更快的片上 SRAM 替代 HBM 并不是什么新鲜事,Cerebra 的竞争对手 Groq 也采取了同样的做法。

Groq 的语言处理单元(LPU)实际上使用的是片上 SRAM 存储器,不同之处在于,单个 Groq LPU 的 SRAM 存储器容量较小,这意味着需要在光纤上连接更多加速器,以支持大型设计。

Cerebras 称,需要四台 CS-3 才能以每秒 450 个字符的速度运行 Lama 3 70B,Gruk 称,需要 576 个 LPU 才能达到每秒 300 个字符的速度,而 Cerebras 引用的人工智能分析公司 Gruk 估计的数字略低,为每秒 250 个字符。

费尔德曼还指出,Cerebras 可以在没有量化的情况下做到这一点。Groq 声称使用 8 位量化实现了减少模型大小、计算开销和内存负荷的性能目标,但准确性略有下降。

但是,仅仅比较性能而不考虑总成本是不公平的;毕竟,单个晶圆级 WSE-3 芯片的成本也远远高于 Groq LPU 的成本。