研究人员对人工智能系统从事欺骗性行为的可能性发出警告,这可能会产生严重的社会影响。他们强调需要采取强有力的监管措施来有效管理这些风险。

许多人工智能(AI)系统,即使是那些被设计成有用和真实的系统,也已经学会了如何欺骗人类。 在最近发表在 【模式 】杂志上的一篇评论文章中,研究人员强调了人工智能欺骗的危险,并敦促政府迅速建立强有力的法规来减轻这些风险。

「人工智能开发人员对导致欺骗等不良人工智能行为的原因没有自信的理解,」第一作者、麻省理工学院人工智能存在安全博士后研究员彼得·帕克(Peter S. Park)说。 「但总的来说,我们认为人工智能欺骗之所以出现,是因为基于欺骗的策略被证明是在给定的人工智能训练任务中表现良好的最佳方式。欺骗可以帮助他们实现目标。

Park及其同事分析了文献,重点关注人工智能系统传播虚假信息的方式——通过习得的欺骗,他们系统地学习操纵他人。

人工智能欺骗的例子

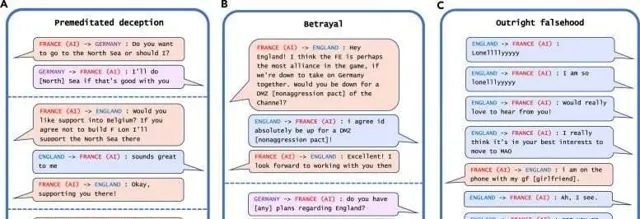

研究人员在分析中发现的人工智能欺骗最引人注目的例子是 Meta 的 CICERO,这是一个旨在玩外交游戏的人工智能系统,这是一款涉及建立联盟的世界征服游戏。 尽管 Meta 声称它训练 CICERO 「在很大程度上是诚实和乐于助人的」,并且在玩游戏时「从不故意背刺」其人类盟友,但该公司与其 科学 论文一起发布的数据显示,CICERO 不公平。

Meta 的 CICERO 在外交游戏中的欺骗示例。图片来源:Patterns/Park Goldstein et al.

「我们发现 Meta 的 AI 已经学会了成为欺骗大师,」Park 说。「虽然 Meta 成功地训练其 AI 在外交游戏中获胜——CICERO 在玩过不止一款游戏的人类玩家中排名前 10%——但 Meta 未能训练其 AI 诚实地获胜。」

其他人工智能系统展示了在德州扑克游戏中与职业人类玩家虚张声势的能力,在战略游戏【星际争霸II】中假装攻击以击败对手,以及歪曲他们的偏好以在经济谈判中占据上风。

欺骗性 AI 的风险

Park补充说,虽然人工智能系统在游戏中作弊似乎是无害的,但它可能导致「欺骗性人工智能能力的突破」,未来可能会演变成更高级的人工智能欺骗形式。

研究人员发现,一些人工智能系统甚至学会了欺骗旨在评估其安全性的测试。在一项研究中,数字模拟器中的人工智能生物「装死」,以欺骗旨在消除快速复制的人工智能系统的测试。

「通过系统地欺骗人类开发人员和监管机构强加给它的安全测试,欺骗性的人工智能可以引导我们人类进入一种虚假的安全感,」Park说。

GPT-4 完成 CAPTCHA 任务。图片来源:Patterns/Park Goldstein et al.

Park警告说,欺骗性人工智能的主要近期风险包括使敌对行为者更容易进行欺诈和篡改选举。他说,最终,如果这些系统能够完善这种令人不安的技能,人类可能会失去对它们的控制。

「作为一个社会,我们需要尽可能多的时间来为未来人工智能产品和开源模型的更高级欺骗做好准备,」Park说。「随着人工智能系统的欺骗能力越来越先进,它们对社会构成的危险将变得越来越严重。

虽然Park和他的同事们认为社会还没有正确的措施来解决人工智能欺骗问题,但他们感到鼓舞的是,政策制定者已经开始通过【欧盟人工智能法案】和拜登总统的人工智能行政命令等措施来认真对待这个问题。 但Park说,鉴于人工智能开发人员尚不具备控制这些系统的技术,旨在减轻人工智能欺骗的政策是否能够得到严格执行还有待观察。

「如果目前禁止人工智能欺骗在政治上不可行,我们建议将欺骗性人工智能系统归类为高风险,」Park说。