如果你走到一个长着人头的机器人面前,它先对你微笑,你会怎么做?你可能会回以微笑,也许会觉得你们两个正在真诚地互动。但机器人如何才能知道让你回以微笑呢?

虽然我们已经习惯了熟练的语言交流的机器人,这主要依靠ChatGPT等大型语言模型的进步,但它们的非语言交流技能,尤其是面部表情,却很令人期待。设计一个机器人,可以展现类人的面部表情,并且知道何时使用它们是一项艰巨的任务。

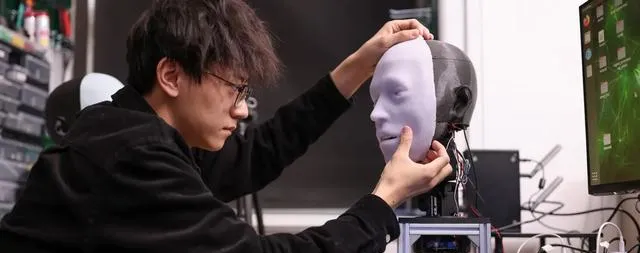

Emo包含26个执行器来帮助模仿人类微笑

在过去的五年里,哥伦比亚大学创意机器实验室的工程师们一直在将机器人的反应能力提高到毫秒级。他们的研究结果详细发表在【科学机器人】杂志上的一项新研究中。

Emo机器人头部能够在840毫秒内预测和镜像模仿人类面部表情,包括微笑。人工智能非常擅长模仿人类对话——重点强调「模仿」。但当谈到情感时,机器人仍然有很多工作要做。机器误判何时微笑不仅会造成尴尬,还会引起人们对其人工行为的关注。

相比之下,人类大脑非常擅长实时解释大量视觉线索,然后对各种面部动作做出相应的反应。除了让人工智能机器人学习表情的细微差别变得极其困难之外,构建一个能够进行逼真的肌肉运动的机械脸也很困难。

Emo的创造者试图解决其中一些问题,或者至少帮助缩小人类和机器人表达能力之间的差距。为了构建他们的新机器人,由人工智能和机器人专家Hod Lipson领导的团队首先设计了一个逼真的机器人人体头部,其中包括26个独立的执行器,以实现微小的面部表情功能。 Emo的每个瞳孔还装有高分辨率摄像头,可以追踪人类对话伙伴的眼睛——这是人们的另一个重要的非语言视觉提示。最后,Lipson的团队在Emo的机械部件上覆盖了一层硅胶「皮肤」,使其变得不那么……毛骨悚然。

在此基础上,研究人员构建了两个独立的人工智能模型来协同工作——一个通过目标面部的微小表情来预测人类表情,另一个则快速对机器人面部发出运动反应。 Emo的人工智能利用人类面部表情的样本视频,逐帧学习复杂的情感。在短短几个小时内,Emo就能够观察、解释和响应人们开始微笑时容易做出的细微面部变化。更重要的是,它现在可以在大约840毫秒内完成此操作。

「我认为准确预测人类面部表情是人机交互的一场革命」,哥伦比亚大学工程博士生兼研究主要作者胡宇航(音)本周早些时候表示。「传统上,机器人的设计并没有考虑人类在互动过程中的表情。现在,机器人可以整合人类面部表情作为反馈。」

目前,Emo缺乏任何语言解释能力,因此只能通过分析人类面部表情进行交互。Lipson、Hu和其他合作者希望很快将身体能力与ChatGPT等大型语言模型系统结合起来。如果他们能做到这一点,那么Emo将更加接近自然的人类互动。当然,除了微笑、傻笑和咧嘴大笑之外,相关性还有很多,而科学家们似乎正在关注这些。例如,应谨慎对待噘嘴或皱眉等表情的模仿,因为这些可能会被误解为嘲笑或传达意想不到的情绪。