自从生成式人工智能的浪潮席卷全球以来,很多内容创作者一直声称他们的作品未经许可就被用于训练人工智能模型。但到目前为止,很难判定他们口中所说的作品内容是否真的被用于某些训练数据集。

如今,研究人员开发出了一种新的方法来证明这一点。近日,来自伦敦帝国理工学院的一个研究团队开发出「版权陷阱」(Copyright traps),这是一种隐藏文本,可以让作家和出版商巧妙地标记他们的作品,以便后期检测这些作品是否已被用于训练人工智能模型。这一想法与此前版权所有者使用的策略相似,比如在地图上添加虚假位置或在字典中添加虚假单词等。

这些人工智能版权陷阱引发了人工智能领域最大的争论之一。许多出版商和作家正在与科技公司打官司,声称他们的知识产权在未经许可的情况下被纳入人工智能训练数据集中。比如,【纽约时报】对 OpenAI 的诉讼可能是其中最典型的案例。

截至目前,生成和检测陷阱的代码已经在 GitHub 上线,接下来,该团队还打算开发一个工具让使用者自行生成和注入版权陷阱。

伦敦帝国理工学院的应用数学和计算机科学教授 Yves-Alexandre de Montjoye 领导了这项研究,他在本周在维也纳举行的人工智能顶级会议国际机器学习会议上表示:「目前关于使用哪些内容来训练人工智能模型方面完全缺乏透明度,我们认为这阻碍了人工智能公司和内容创作者之间找到适当的平衡。」

为了创建陷阱,他和团队使用单词生成器创建了数千个合成句子。这些句子很长,基本都是胡言乱语,比如,「当动荡时期到来时 ...... 什么在打折,更重要的是,什么时候是最好的,这个列表告诉你谁在周四开业。晚上有他们的常规销售时间和邻居的其他开放时间。你还在。」

Yves-Alexandre de Montjoye 解释说,「我们生成了 100 个陷阱句子,然后随机选择一个句子多次注入到文本中。」与此同时,该陷阱还可以通过多种方式注入到文本中,比如,在白色背景上使用白色文本,或嵌入到文章的源代码中。这个句子必须在文本中重复 100 到 1000 次。

为了检测这些陷阱,他们将生成的 100 个合成句子输入到大型语言模型中,并查看模型是否将它们标记为新的句子。如果模型在其训练数据中看到了陷阱句子,则显示较低的「困惑度分数」;但如果模型对句子感到「惊讶」,则意味着模型第一次遇到它们,因此这些句子不是陷阱。

在过去,研究人员曾建议利用语言模型记忆训练数据来确定数据中是否出现了某些内容。这项技术被称为「成员推理攻击」(Membership inference attacks),在先进的大模型中效果较好,因为这些模型往往会在训练过程中记住大量数据。

「相比之下,越来越受欢迎、可以在移动设备端运行的小模型,由于记忆数据量较少,因此不太容易受到成员推理攻击的影响。这使得确定它们是否针对特定受版权保护的文本进行训练变得更加困难。」滑铁卢大学计算机科学助理教授 Gautam Kamath 指出。他没有参与这项研究。

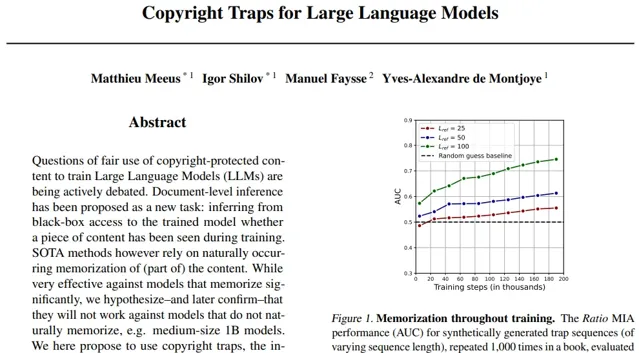

版权陷阱,作为一种进行成员推理攻击的方法,即便是在较小模型上也是如此。Yves-Alexandre de Montjoye 团队将他们的陷阱注入到 CroissantLLM 的训练数据集中。CroissantLLM 是一个新开发的法英双语语言模型,由伦敦帝国理工学院的研究团队与工业界和学术界的合作伙伴共同训练。CroissantLLM 拥有 13 亿个参数,仅为最先进的模型(例如,据报道 GPT-4 具有 1.76 万亿个参数)的一小部分。

「研究表明,确实可以将此类陷阱引入文本数据中,从而显著提高成员推理攻击的有效性,即使对于较小的模型也是如此。」Gautam Kamath 表示,但他补充说,现阶段仍然还有很多工作要做。

「在文本中重复 75 个字符的短语 1000 次对原文本产生很大影响。这可能使训练人工智能模型的训练师发现陷阱并跳过包含它的内容,或者直接删除它并对剩下的文本进行训练。这也会让原始文本难以阅读。」Gautam Kamath指出。

「这使得版权陷阱在目前看来不切实际。很多公司都会进行去重处理,换句话说,他们会清理数据,这些版权陷阱可能会被删掉。」加州大学欧文分校计算机科学教授、初创公司 Spiffy AI 联合创始人 Sameer Singh 表示。他也没有参与这项研究。

在 Gautam Kamath 看来,改进版权陷阱的另一种方法是,找到其他方法来标记受版权保护的内容,以便成员推理攻击对它们更好地发挥作用,或者改进成员推理攻击本身。

Yves-Alexandre de Montjoye 承认这些陷阱并非万无一失。「一个有动机的攻击者如果知道陷阱的存在就可以将其移除。」他表示。

「但他们能否将其全部移除还是一个未知数,这可能有点像‘猫捉老鼠’的游戏。」他说道,「即便如此,设置的陷阱越多,在不投入大量工程资源的情况下,移除所有陷阱就变得越困难。」

「重要的是要记住,版权陷阱可能只是一种权宜之计,或者仅仅是给模型训练师带来不便。任何人不可能发布一条包含陷阱的内容并保证它永远是一个有效的陷阱。」Gautam Kamath 说道。

原文链接: