引言

Gp169 合金是中国航空发动机的骨干材料,在航空发动机的高温部件使用率超过 50% ,随着航空发动机第四代和第五代的研制,对 Gp169 合金的使役性能也提出了更高的要求。 随着冶炼工艺与成型制备技术的精进,Gp169 合金虽已基本满足中国航空发动机的需要,但与国外 Inconel718 合金相比还存在着不小的差距,主要表现在冶炼工艺不合理或技术参数不精准造成的冶金黑斑以及合金组织均匀性较差造成的加工后的裂隙和浅坑[1]。

这些由于技术不成熟造成的缺陷很有可能成为应力集中的薄弱环节,成为破裂和腐蚀的根源。 因此,找到合金组织表面的缺陷对于分析这些缺陷的成因以及提高合金冶炼工艺有着重要的意义。 传统的检测都是由研究员使用扫描电镜人工检测组织表面存在的缺陷,这样不仅效率低下,而且很容易由于视觉疲劳出现错检漏检的情况。 传统的机器视觉检测方法如 Canny 边缘检测[2]、Prewitt 算子[3] 和小波变换[4]等通过手工设计提取特征,由于缺陷较小且有些缺陷颜色和背景相差不大造成鲁棒性较差,检测精度较低,无法满足实用要求。

卷积神经网络在提取特征方面有非常强大的能力,相比较手工提取的特征,卷积神经网络提取的特征可以达到更好的效果[5]。 因此,该文将 RetinaNet[6] 模型应用于 Gp169 合金组织表面缺陷检测上,并且针对 RetinaNet 网络对小目标检测不敏感的问题进行改进,提出了一种 CA - RetinaNet 检测算法。 首先, 在RetinaNet 网络模型中引入了一种 CA-Resnet 结构代替原来的残差结构[7],增强网络提取特征的能力;之后重新构建了特征金字塔网络[8] 的底层结构,删除了原来的 P7 有效特征层,重新构建了 P2 有效特征层,提高了网络模型对于小缺陷的检测能力。

1、模型设计

RetinaNet 结构上由特征提取网络、FPN( 特征金字塔网络)和两个 FCN 子网络共同组成。 ResNet 网络负责提取图像的特征,FPN 针对提取到的特征进行多尺度语义融合以获得表达力更强的特征图,最后将这些特征图输入到两个 FCN 子网络中,从而完成目标框的分类和回归任务。 由于 Gp169 合金组织表面缺陷形貌和一些伪缺陷接近并且大部分缺陷像素占比较少,因此使用传统 RetinaNet 检测算法进行检测效果并不理想。 该文提出的 CA-RetinaNet 网络在 RetinaNet的基础上,引用了 CA-Resnet 结构,并且重新构建了FPN 层,从而提高了缺陷检测的准确率。

1.1、 CA-Resnet 模块

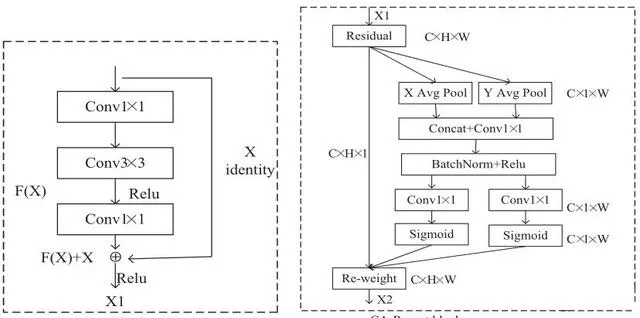

CA - Resnet模块是由Resnet 模 块 和 CA[9](Coordinate Attention)模块两部分构成的,其主要结构如图 1 所示。

Resnet 模块又被称为残差模块,其主要思想是提出了一种 shortcut 的形式将前后层直接相连,使得后层网络也可以得到前层网络提取到的信息。 这种方法可以更好地学习输入与输出之间的残差 H(X) - X[7],使得神经网络可以更好的被训练,在一定程度上解决了网络退化的问题。 但在使用 Resnet50 对合金组织表面缺陷进行特征提取时发现,较小缺陷在经过多次降采样 后,特征逐渐消失。 为了解决这个问 题, 在Resnet50 中插入了CA模块。

CA 模块可以优化神经网络学习到的参数,在强调有用特征的同时,抑制干扰性背景特征,以此来增加神经网络学习到的感兴趣的目标权重。 其主要结构如图 1 中 CA-Resnet 模块所示。CA模块主要分为Coordinate 信 息 嵌 入 和Coordinate Attention 生成两个步骤。 Coordinate 信息嵌入主要是为了注意力模块可以捕捉到精确的远程空间交互信息。 特征图经过特征提取网络后得到大小C ×W × H 的 X1 特征图,而后使用尺寸为( H ,1) 和(1, W )的平均池化函数分别沿水平方向和竖直方向对每个通道进行编码输出大小为 C ×1× W 的特征图。

Coordinate Attention 生成将以上的变换产生的两个特征图进行 concatenate 操作,接着使用一个共享的 1×1的卷积进行变换、经 BN 操作和 Relu 非线性变换后生成大小 C / r ×1×( W + H )的张量和,然后利用两个一维卷积变换将张量和变换为具有相同通道数的张量输入到 Sigmoid 激活函数中,使用适当的缩减比来降低模型的复杂度,最后将学习到的权重与原始特征图的每一个通道进行相乘,得到注意力权重的 X2 特征图。

这样 CA 模块不仅完成了通道权重的优化,同时也捕捉到了水平方向和竖直方向上目标的信息。 比起 SE-Net[10](Squeeze-and-Excitation Networks) 只注重通道之间的关系,CA 模块将位置信息与通道之间关系进行了互补,同时又避免了较大的计算开销。 该文在CA-RetinaNet 网络中使用 CA-Resnet 模块进行特征提取,对图像中的目标进行通道特征增强,提高了神经网络提取特征的能力以及检测精度。

1.2、 重建特征金字塔网络

特征金字塔网络是一种自顶向下且带有侧向连接的网络,它可以融合低层网络和深层网络提取到的语义信息,实现多尺度预测。 在卷积网络提取图像的过程中,大的目标特征点容易得到保留,小目标特征点容易被跳过,特别是经过很多层卷积和池化之后,小目标的特征信息会越来越少,这对于小目标检测非常不利。

而特征金字塔网络,在对特征点进行下采样后重新进行上采样,并且将下采样与上采样中长宽相同的特征层进行堆叠,这样就可以保证小目标的特征与信息不会完全丢失。

在 RetinaNet 网络中,特征金字塔网络由 P3 ~ P7五种尺度特征构成[11],其中 P3(75,75)和 P4(38,38)用来检测小目标,P5(19,19)、P6(10,10)、P7(5,5) 用来检测大目标。 该文所使用的数据集大都是中小类型的缺陷,而 FPN 网络所产生的 P7(5,5)有效特征层却是用来检测大目标。 因此,在 CA-Retinanet 中删去 P7有效特征层,重新计算 CA-Resnet 所提取到的 C2 特征图,将 P3 有效特征层进行上采样后与其融合得到一个新的有效特征层,该文将新建立起来的有效特征层成为 P2 有效特征层,用来检测较小尺度的目标。 具体如图 2 所示。

另外,为了配合 P2 有效特征层的检测尺度,将 anchor 的尺寸从(32,64,128,256,512) 调整为(16,32,64,128,256),以便网络更加精准地定位目标。

1.3、 Focal Loss 损失函数

Focal Loss 损失函数由常用的交叉熵损失函数(CE)变形而来,是为了平衡正负样本而提出来的一种新的 loss 计算方案,其具有两个特点:(1)控制正负样本的权重。(2)控制容易分类和难分类样本的权重。

其公式如下:

其中, y 表示真实值, Pt 表示估计概率, P 表示概率,通过设置 琢 值(0-1 之间)控制正负样本对 loss 的贡献,通过控制 Pt 的值来控制权重的大小, Pt 越大则权重较大, Pt 越小相应的权重也就越小,以此来抑制那些容易分类的样本权重,提高难分类样本的权重。 有效地解决了正负样本不平衡的问题。

2、 实验分析

2.1、 数据集

2.1.1、 数据集介绍

实验采用的 Gp169 合金来自于中航上大高温合金材料有限公司,采用真空感应-气氛保护-真空自耗「三联冶炼技术」及锻造工艺生产的大棒材。 从Gp169 合金锻件大棒上截取样品长条,经线切割、热镶、磨样、抛光后,使用配比为 20 ml 盐酸+20 ml 无水乙醇+1.5 g 五水合硫酸铜的腐蚀溶液进行化学腐蚀[12],再采用日本产尼康 LV100ND 金相显微镜进行图像数据采集,共获取1882 张图片。 检测的目标分别是由于技术原料原因造成的缺陷(defect)、在磨样过程 中 造 成 的 划 痕 ( scratch ) 以 及 沾 上 的 附 着 物

(attachment)。 图片分辨率大小为 512×512, 使 用LabelImg 软件对图像中的缺陷、划痕以及附着物进行标注,数据标注格式为 PascalVOC 格式。 采集到的数据图像如图 3 所示。

2.1.2、 小目标数据增强

小目标检测一直是目标检测领域中具有挑战性的问题,特别是在缺陷检测方面,小缺陷往往容易被忽略,这主要是因为小缺陷占比像素较少且标注面积占比较小,直接导致神经网络在训练的过程中会更加偏向于较大的物体。 该文引用文献[13] 的思想,采用oversampling(过采样)的方法改进离线数据增强方式。对于含有小缺陷的样本进行 2 次复制并且修改名字,

相当于对小缺陷样本进行三倍的过采样,从而引起神经网络的「注意」,提升小缺陷检测的准确率。 该文使用的数据集中原始数据共 1 882 张图片,采用过采样离线数据增强方式进行小缺陷数据增强后共 3 482 张图片,按照 8:2 的比例随机划分训练集和验证集。

2.2、 实验设置

2.2.1、 实验环境

实验环境在 windows10 操作系统下,采用 pytorch的深度学习框架,并使用 NVIDIA GeForce RTX2080S(8G)进行训练加速。

2.2.2、 实验细节

网络采用冻结训练方式进行训练,冻结次数设置为 50。 训练时采用 Adam 优化器进行迭代优化,未解冻部分训练输入批次 batch_size = 8,学习率 learning_rate= 0.000 1,解冻部分训练 batch_size = 4,学习率learning_rate= 0.000 01。 采用迁移学习训练方式,导入 ResNet 网络预训练模型,共计训练 150 个轮次。

2.2.3、 评价指标

为了评估模型检测的效果,采取 mAP(平均精度)对检测结果进行评价。

其中,TP 是分类器认为是正样本且确实时正样本的例子,FP 是分类器认为是正样本但实际上不是正样本的例子,FN 是分类器认为是负样本但实际上不是负样本的例子。 AP 是利用不同的 Precision 和 Recall 的组合计算得到的平均精度,mAP 就是所有类的 AP 值求平均。

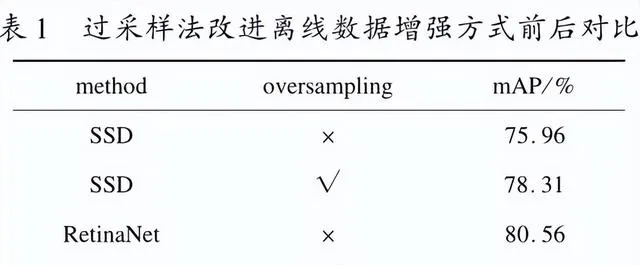

2.3、 过采样法改进离线数据增强实验

为了验证过采样法改进离线数据增强的有效性,分别在 SSD 模型上和 RetinaNet 模型上进行了实验对比,实验结果如表 1 所示。

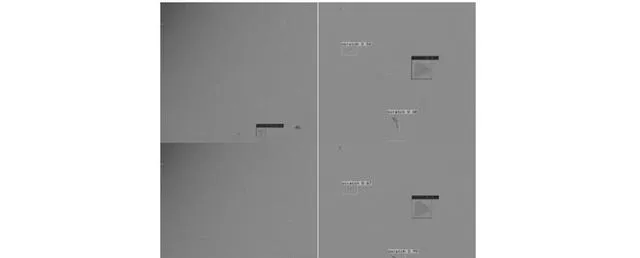

从实验对比结果可以看到,采用 oversampling 后的模型在三个种类的检测精度上均有所提高,不仅如此,采用 oversampling 后的模型在检测结果的标注上也更加的准确。 以 RetinaNet 的检测结果为例,使用oversampling 方法的 RetinaNet 模型能够检测出图像中更多的目标且置信度更高。 根据图 4 中第一列检测结果对比图 可 以 看 到, 没 有 使 用 oversampling 方 法 的RetinaNet 模 型 只 检 测 出 来 1 个 目 标, 而 使 用oversampling 方法的 RetinaNet 模型可以检测出来 2 个目标;根据图 4 中第二列检测结果对比可以看到,经过oversampling 方法后检测的置信度分别为( scratcp:0. 67, defect: 0.99, scratcp: 0.90 ), 而 没 有 经 过oversampling 方 法 检 测 的 置 信 度 分 别 为 ( scratcp: 0. 56, defect: 0.99, scratcp: 0.68 ), 很 明 显 经 过oversampling 方法后的模型检测目标的置信度要更高一些。

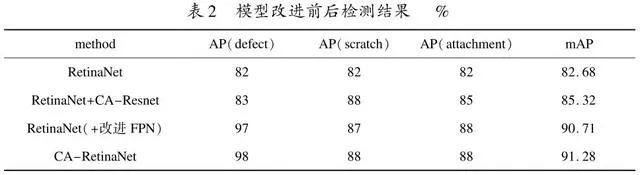

2.4、 模型改进前后实验对比

为了验证改进的模型对于 Gp169 合金组织缺陷检测的有效性,分别在 RetinaNet 模型,RetinaNet 加CA-Resnet,RetinaNet 加改进 FPN 以及 CA-RetinaNet上进行实验。 结果如表 2 所示。 由表 2 可以看出,针对 RetinaNet 做出的改进是非常有效的,CA-RetinaNet相比较 RetinaNet 的 mAP 提升大约 8.6% ;在加入 CA-Resnet 后模型 mAP 提升大约 2.64% ;对比改进前后特征金字塔网络的检测精度,可以看出 CA-RetinaNet 中的特征金字塔网络有更好的特征提取能力,对比改进前后的特征金字塔 网络的检测结果,可以看到重构后的特征金字塔网络拥有更好的特征提取能力,缺陷类AP 值大幅度提高。

在 Gp169 合金组织表面缺陷数据集的测试集中选取 200 张图片进行检测实验,部分检测结果如图 5所示。 从图中可以看出,原始 RetinaNet 模型仅仅可以检测图中少部分目标,而 CA-RetinaNet 几乎可以检测出图中所有目标。

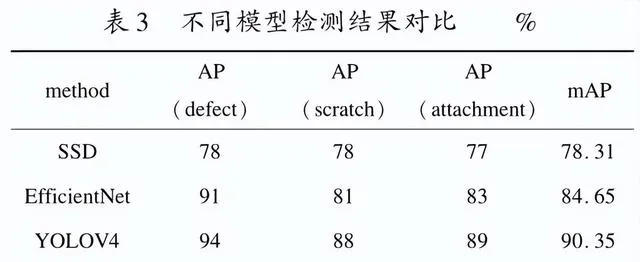

2.5、 不同目标检测模型对比

为了进一步验证所提方法的有效性,在过采样后的 Gp169 合 金 组 织 表 面 缺 陷 数 据 集 上, 将 CA -RetinaNet 算 法 与 当 前 主 流 目 标 检 测 算 法 SSD[14]、YOLO V4[15]及 EfficienNet[16]等算法进行了对比,结果如表 3 所示。 由表 3 可知,CA-RetinaNet 检测精度明显高于当前主流检测方法 SSD 以及 EfficientNet;和YOLO V4 相比,检测精度较高一些。

3、 结束语

针对 Gp69 合金组织表面缺陷较小,形貌不易区分造成传统原始 RetinaNet 检测算法错检漏检等问题,提出以下改进方法:

(1)过采样法改进离线数据增强方式,对小缺陷样本进行 3 倍过采样,不仅增加了目标的检测成功率,而且检测出来的目标置信度更高。

(2)提出一种 CA-RetinaNet 检测算法,一方面将CA-Resnet 结构引入到 RetinaNet 模型中,增强了网络提取特征的能力,另一方面重新构建了特征金字塔网络的结构。 通过在 Gp169 合金组织表面缺陷数据集上进行测试,CA-RetinaNet 算法相较于原始 RetinaNet检测算法 mAP 提高了 8.6% ,与其他目标检测算法相比也有较大的优势。

参考文献:

[1]杜金辉,邓群,曲敬龙,等.我国航空发动机用 Gp169合金现状与发展[C] //第八届(2011) 中国钢铁年会论文集.北京:中国金属学会,2011:5.

[2] CANNY J.A computational approach to edge detection[J].IEEE Transactions on Pattern Analysis and Machine Intelli-gence,1986,PAMI-8(6):679-698.

[3]PREWITT J.Object enhancement and extraction[C] //Ob-ject enhancement and extraction picture processing and psy-chopictorics.New York:Academic,1970:15-19.

[4]FARGE M.Wavelet transform and their application to turbu-lence[J].Annu.Rev.Fluid Mech.,1992,24:395-457.

[5] 周晓彦,王 珂,李凌燕.基于深度学习的目标检测算法综述[J].电子测量技术,2017,40(11):89-93.

[6]LIN T Y, GOYAL P, GIRSHICK R, et al.Focal loss fordense object detection[J].IEEE Transactions on Pattern A-nalysis & Machine Intelligence,2020,42(2):318-327.

[7] HE K,ZHANG X,REN S,et al.Deep residual learning forimage recognition[ C] //Proceedings of 2016 IEEE confer-ence on computer vision pattern recognition ( CVPR).LasVegas:IEEE,2016:770-778.

[8]LIN T Y,DOLLAR P,GIRSHICK R,et al.Feature pyramidnetworks for object detection[C] //2017 IEEE conference oncomputer vision and pattern recognition (CVPR).Honolulu:IEEE,2017:936-944.

[9] HOU Q,ZHOU D,FENG J.Coordinate attention for efficientmobile network design[C] //2021 IEEE conference on com-puter vision and pattern recognition (CVPR).[s.l.]:IEEE,2021.

[10] JIE H,LI S,GANG S.Squeeze - and - excitation networks[C] //2018 IEEE/ CVF conference on computer vision andpattern recognition (CVPR).Salt Lake City:IEEE,2018.

[11] 邱吕,任德均,郜明,等.基于改进 RetinaNet 的医用塑瓶装箱计数算法[ J].计算机与现代化,2020 (12):99 -103.

[12] 蒋世川.Gp169 高温合金热变形行为及组织演变[J].钢铁钒钛,2018,39(2):146-152.

[13] KISANTAL M,WOJNA Z,MURAWSKI J,et al.Augmenta-tion for small object detection[C] //9th international confer-ence on advances in computing and information technology.Rome:Institute of Research Engineers and Doctors,2019.

[14] LIU W,ANGUELOV D,ERHAN D,et al.SSD:single shotmultibox detector [ C] //European conference on computervision.[s.l.]:Springer,2016:21-37.

[15] BOCHKOVSKIY A,WANG C Y,LIAO H Y M.Yolov4:optimal speed and accuracy of object detection[ J].arXiv:2004.10934,2020.

[16] TAN M, LE Q.EfficientNet: rethinking model scaling forconvolutional neural networks[C] //Proceedings of the 2019international conference on machine learning.Long Beach:PMLR,2019:6105-6114.