2月18日,NVIDIA首次推出了基於GeForce硬件本地套用的生成式AI,也就是「Chat With RTX」,顧名思義,它是NVIDIA借助RTX加速等技術提供的一種對話機器人。它的技術演示版現已開放免費下載,使用RTX 30系或更高版本GPU(且視訊記憶體至少為8GB)的使用者可以進行本地部署使用。

目前全球已經有以千萬計人使用雲端的AI對話服務,Chat with RTX與現有的此類套用有哪些區別呢?

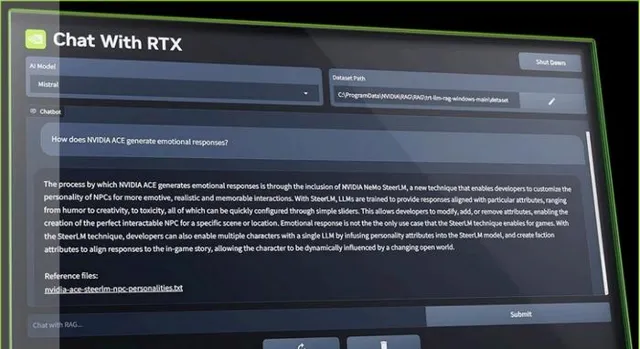

Chat with RTX 借助檢索增強生成(RAG)、NVIDIA TensorRT-LLM(大語言模型)軟件及 NVIDIA RTX加速技術,將生成式AI功能引入本地Windows PC。使用者可快速輕松地將本地資料作為數據集,連線到Mistral或Llama 2這一類開源大型語言模型。

具體而言,Chat with RTX可以承擔類似搜尋引擎的功能,類似於office中copilot的一部份,直接從選定的檔等資料中尋找內容,並為你歸納出解答。

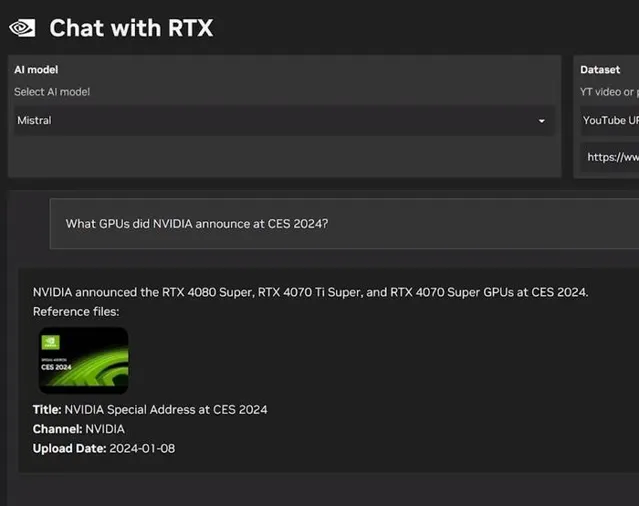

Chat With RTX支持多種檔格式,包括文字檔案、pdf、doc/docx和xml。使用者只需在該套用中指定包含目標文件的資料夾,該套用便會在幾秒內將目標文件載入到庫中。不僅如此,我們還可以提供油管等影片網站連結,然後該套用會自動載入影片與播放列表的資訊,使我們能夠直接查詢其中包含的內容。

Chat With RTX最主要的特點就在於本地部署,以及在多數時候使用本地數據,而不依賴雲端環境,這一點與AI繪圖套用Stable Diffusion類似,Chat with RTX能夠在 PC 桌面端幫助使用者處理敏感資料,無需分享給第三方或是連線到網絡。

NVIDIA表示,Chat With RTX技術演示版基於GitHub中的 TensorRT-LLM RAG開發者參考專案構建而成。開發者可以借鑒該參考專案,自行開發和部署面向RTX、基於RAG且由TensorRT-LLM加速的套用。

小結

伴隨著OpenAI Sora大模型、Chat with RTX等套用在近期誕生,我們對AI未來的想象力也日益豐富,無論是借助雲端還是依托本地數據,AI都從某個角度展現其套用前景,有望成為生產力的一環。

暢想一下,也許我們可以借助本地AI助手,就實作更加高效的編輯功能,不僅限於大段資料的歸納總結,也許還可以「基於這個表格內數據,幫我生成一個美觀的折線圖」,或是「概述這份文本資料,幫我做一個10頁的PPT」,又或者「幫我看完這部電影,描述一下它的劇情結構,並生成一份拉片(記錄每個鏡頭的分鏡、運鏡、景別、音效等內容)文件」之類的深度用法。

目前本地執行的Chat with RTX只是演示版本狀態,功能尚且比較簡單,支持的資料類別與網址也不夠多,期待這個專案能夠持續前進演化。如果能夠成為基於GeForce RTX硬件的本地版「Copilot」,將會對大量的使用者帶來更多價值。