克雷西 發自 凹非寺量子位 | 公眾號 QbitAI

不用p00,三台蘋果電腦就能帶動400B大模型。

背後的功臣,是GitHub上的一個開源分布式AI推理框架,已經斬獲了2.5k星標。

利用這個框架,幾分鐘就能用iPhone、iPad等日常器材構建出自己的AI算力集群。

這個框架名叫exo,不同於其他的分布式推理框架,它采用了p2p的連線方式,將器材接入網絡即可自動加入集群。

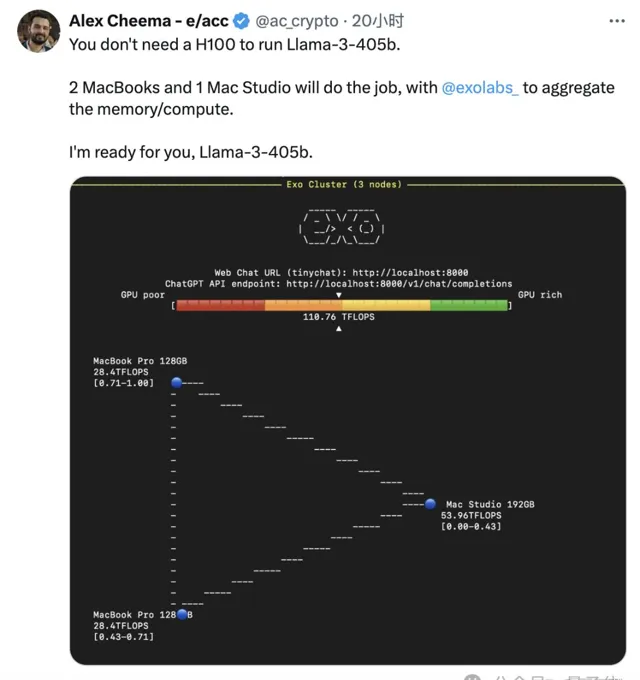

開發者使用exo框架連線了兩台MacBook Pro和一台Mac Studio,運算速度達到了110TFLOPS。

同時這位開發者表示,已經準備好迎接即將到來的Llama3-405B了。

exo官方也放話稱,將在第一時間(day 0)提供對Llama3-405B的支持。

而且不只是電腦,exo可以讓iPhone、iPad等器材也加入本地算力網絡,甚至Apple Watch也同樣能夠吸納。

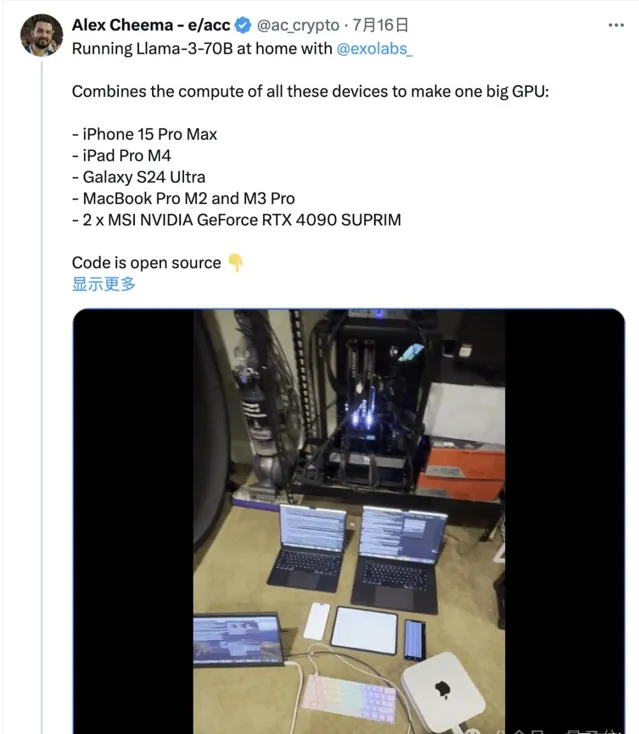

隨著版本的叠代,exo框架也不再是蘋果限定(起初只支持MLX),有人把安卓手機和4090顯卡也拉進了集群。

最快60秒完成配置

與其他分布式推理框架不同,exo不使用master-worker架構,而是點對點(p2p)地將器材進行連線。

只要器材連線到相同的區域網路,就可以自動加入exo的算力網絡,從而執行模型。

在對模型進行跨器材分割時,exo支持不同的分區策略,預設是環記憶體加權分區。

這會在環中執行推理,每個器材分別執行多個模型層,具體數量與器材記憶體成比例。

而且整個過程幾乎無需任何手動配置,安裝並啟動之後系統就會自動連線區域網路內執行的器材,未來還會支持藍芽連線。

在作者的一段影片當中,只用了60秒左右就在兩台新的MacBook上完成了配置。

,時長01:48

可以看到,在60秒左右時,程式已然開始在背景執行。

另外從上面這張圖中還能看出,exo還支持tiny chat圖形化界面,同時還有相容OpenAI的API。

不過,這樣的操作只能在集群中的尾節點(tail node)上實作。

目前,exo支持蘋果MLX框架和開源機器學習框架tinygrad,對llama.cpp的適配工作也正在進行。

美中不足的是,由於iOS實作更新跟不上Python,導致程式出現很多問題,作者把exo的手機和iPad端進行了暫時下線,如果確實想嘗試,可以給作者發郵件索取。

網友:真有那麽好用?

這種利用本地器材執行大模型的方式,在HakerNews上也引發了廣泛的討論。

本地化執行的優點,一方面是私密更有保障,另一方面是模型可以離線存取,同時還支持個人化客製。

也有人指出,利用現有器材搭建集群進行大模型運算,長期的使用成本要低於雲端服務。

但針對exo這個具體的專案,也有不少人表達了心中的疑問。

首先有網友指出,現有的舊器材算力水平無法與專業的服務商之間差了數量級,如果是出於好奇玩一玩還可以,但想達到尖端效能,成本與大型平台根本無法比較。

而且還有人表示,作者演示用的器材都是高端硬件,一個32GB記憶體的Mac器材可能要價超過2000美元,這個價格還不如買兩塊3090。

他甚至認為,既然涉及到了蘋果,那可以說是和「便宜」基本上不怎麽沾邊了。

這就引出了另一個問題——exo框架都相容哪些器材?難道只支持蘋果嗎?

網友的提問則更加直接,開門見山地問支不支持樹莓派。

作者回復說,理論上可以,不過還沒測試,下一步會進行嘗試。

除了器材自身的算力,有人還補充說,網絡傳輸的速度瓶頸,也會限制集群的效能。

對此,框架作者親自下場進行了解釋:

exo當中需要傳輸的是小型啟用向量,而非整個模型權重。對於Llama-3-8B模型,啟用向量約為10KB;Llama-3-70B約為32KB。本地網絡延遲通常很低(<5ms),不會顯著影響效能。

作者表示,目前該框架已經支持tinygrad,因此雖然測試主要在Mac器材上展開,(理論上)支持能執行tinygrad的所有器材。

目前該框架仍處於實驗階段,未來的目標是把這個框架變得像Dropbox(一款網盤)一樣簡單。

BTW,exo官方也列出了一些目前計劃解決的缺點,並進行了公開懸賞,解決這些問題的人將獲得100-500美元不等的獎金。

GitHub:https://github.com/exo-explore/exo參考連結:https://x.com/ac_crypto/status/1814912615946330473