西風 發自 凹非寺

量子位 | 公眾號 QbitAI

「比Sora還震撼」,AI可以即時生成遊戲了!

谷歌DeepMind打造出了首個完全AI驅動的即時遊戲引擎——GameNGen

。

在單個谷歌TPU上,它以每秒20幀

模擬起了經典射擊類遊戲DOOM(淪陷戰士)。

所有遊戲畫面都是根據玩家操作,與復雜環境進行互動,即時生成

。

也就是說你走進一道門之前,門後的內容還不存在。

質素不輸事先儲存的那種,能「以假亂真」,人類評估者都難以察覺。

各種操作都能絲滑轉換:

GameNGen的背後是大家熟悉的擴散模型

。

從論文題目就重新定義了遊戲引擎:擴散模型是即時遊戲引擎

。

網友們看到這項研究一時間炸開了鍋,推特、Reddit上相關貼文熱度持續不減,誰發誰火。

不少人表示它提供了一條全新的技術路徑:

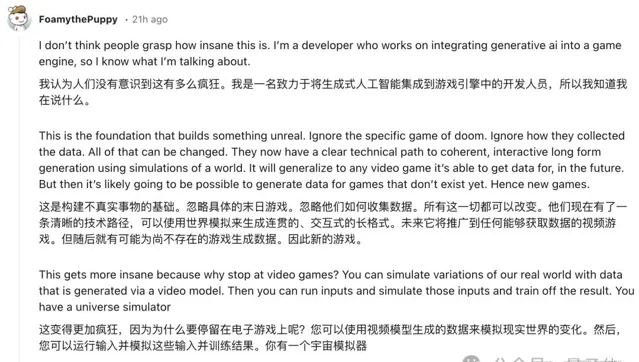

我覺得人們還沒有意識到這有多瘋狂。我是一名開發人員,專門負責將生成式AI整合到遊戲引擎中,所以我很清楚我在說什麽。

這是構建虛擬事物的基礎。未來它或許能夠普及到它能夠獲取數據的任何影片遊戲,隨後,可能還能為尚未存在的遊戲生成數據,創造新遊戲。

作者Shlomi Fruchter也開麥了:

這對我來說是一個個人裏程碑,也是從手工編寫在GPU上執行的顯式渲染程式碼到訓練同樣在GPU上執行的神經網絡的完整回環,感覺圓滿了。

那麽,GameNGen究竟是如何做到的?

用擴散模型造AI DOOMers

GameNGen訓練過程分為兩個主要階段。

首先,訓練一個強化學習Agent來玩遊戲

,並記錄過程中所有動作、技能和觀察數據。這些記錄成為第二階段的訓練數據集。

為生成盡可能貼近人類遊戲行為的訓練數據,研究人員設計了一個簡單的、特定於環境的獎勵函數,根據一系列特定的遊戲情況來分配分數,條件包括:

玩家被擊中、敵人被消滅、撿起物品或武器、生命值變化、彈藥變化……

在第二階段,基於預訓練的Stable Diffusion v1.4

來預測下一幀,模型以過去的幀序列和動作作為條件輸入,並進行了一些關鍵修改。

具體來說,首先移除了所有文本條件,替換為動作序列

。每個動作被編碼為一個單一的token,透過交叉註意力機制與模型互動。

歷史觀察(即之前的幀)被編碼到潛在空間,並與當前雜訊化的潛在表示在通道維度上拼接。

為了解決自回歸生成中的誤差累積,即自回歸漂移問題,GameNGen引入了雜訊增強

技術。

在訓練時,模型對輸入的上下文幀添加不同程度的高斯雜訊,並將雜訊級別作為額外輸入提供給模型。這使得模型能夠學習糾正之前采樣中的錯誤,對維持長時間序列的影像質素至關重要。

此外,為了提高影像質素,特別是在細節和HUD(平視顯視器)方面,研究者對Stable Diffusion的預訓練自編碼器的解碼器部份進行了微調。這個過程使用MSE損失,針對目標幀像素進行最佳化。

在推理階段,GameNGen使用DDIM采樣方法

,並采用了無分類器引導技術,但僅用於過去觀察的條件。研究者發現,對過去動作條件使用引導並不能提高質素。

值得註意的是,模型僅使用4步DDIM采樣就能產生高質素的結果,這大大提高了生成速度。

GameNGen在TPU-v5硬件上執行,單個去噪器步驟和自編碼器評估各需要10毫秒。

透過使用4步采樣和單次自編碼器評估,系統能夠達到每秒20幀的生成速度

,足以實作即時互動式遊戲體驗。

人類難以分辨真實和AI生成

實驗中,在短時軌跡上,人類評估者幾乎無法區分模擬畫面與實際遊戲畫面。

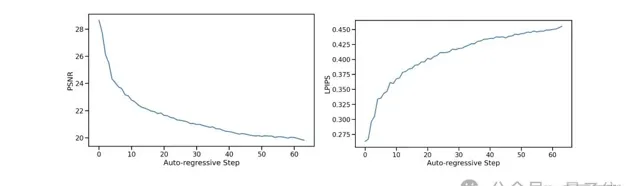

研究人員使用了兩種主要的影像質素評估方法:基於感知的影像相似度度量方法LPIPS和衡量影像質素的常用指標PSNR。

在teacher-forcing設定中,模型單幀預測質素PSNR為29.43,LPIPS為0.249。PSNR的值與20-30質素設定下的失真JPEG壓縮相似。

換句話說,GameNGen在模擬影像時能夠在一定程度上保持較高的視覺質素,盡管可能存在一些壓縮帶來的細節損失。

影片質素方面,對於長度為16 幀(0.8 秒)和32幀(1.6 秒)的模擬,FVD分別為114.02、186.23。

在人類評估方面,研究人員為10 名人類評估者提供了130個隨機短片段(1.6秒和3.2 秒的長度),並將模擬與真實遊戲並排展示。

在1.6秒和3.2秒的片段中,人類僅有58%、60%的概率能正確區分真實遊戲和模擬

。

基於Diffusion的最新突破

除了被效果驚艷到,不少研究者還表示這項研究沒有那麽簡單,它是一種基於擴散模型的最新突破。

動作條件化的世界模型已更進一步!神經網絡模擬在擴充套件實際互動數據方面具有巨大潛力,特別是在物理模擬器表現不佳的領域。

不過,在一片好評聲中,也有網友指出,論文很好,但稱其為「遊戲引擎」不太妥當:

希望他們能說「渲染引擎」而不是「遊戲引擎」。

遊戲引擎是一個讓一群人創造東西的工具,它將繼續存在,特別是與任何整合的超級AI共存。顯然,今天的遊戲引擎已經過時,但我們已經在構建下一代引擎了。

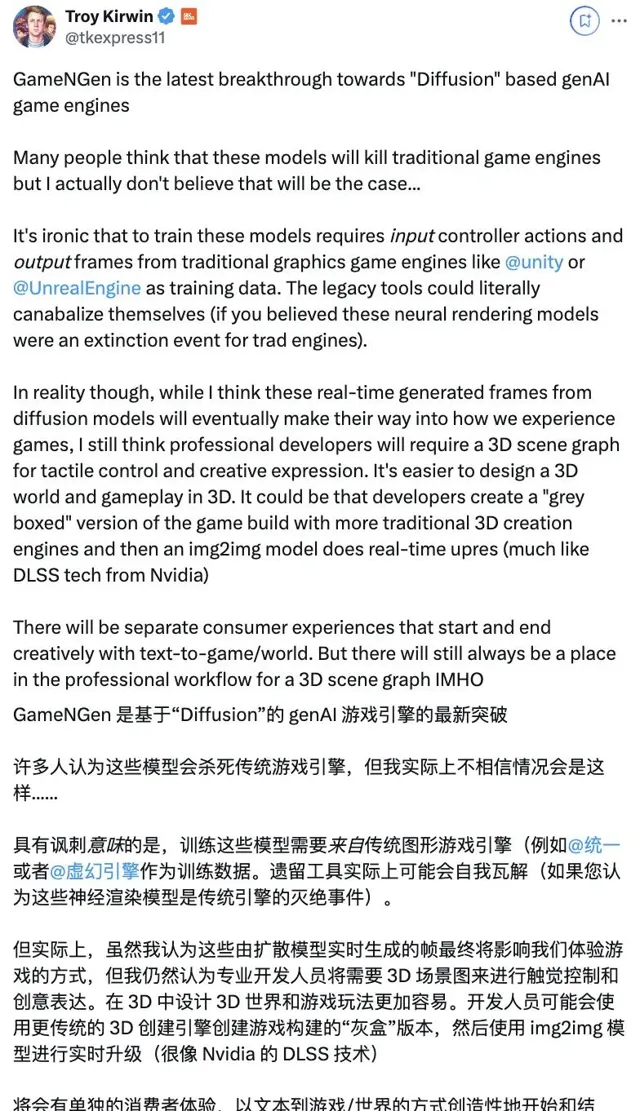

對於一些人評論這些模型將取代傳統遊戲引擎,也有網友持不同的觀點。

一位a16z的遊戲和3D技術領域投資人、前Unity員工給出了他的看法:

諷刺的是,訓練這些模型需要從傳統遊戲引擎輸入控制器動作和輸出幀作為訓練數據。

雖然我認為這些由擴散模型即時生成的幀最終會改變我們體驗遊戲的方式,但我仍然認為專業開發者需要一個3D場景圖來進行觸感控制和創造性表達。

開發者可能會使用更傳統的3D創作引擎建立遊戲的「灰盒」版本,然後一個影像到影像的模型即時提升分辨率(類似於輝達的DLSS技術)。

未來,消費者將能體驗從文本直接創造遊戲或虛擬世界的全新方式。但在我看來,專業工作流程中仍然會有3D場景圖的一席之地。

你怎麽看GameNGen這項研究?它會給未來遊戲行業帶來何種改變?

專案主頁:https://gamengen.github.io/

論文連結:https://arxiv.org/pdf/2408.14837

參考連結:

[1]https://www.reddit.com/r/singularity/comments/1f3055r/google_deepmind_we_present_gamengen_the_first/

[2]https://x.com/_akhaliq/status/1828631472632172911

[3]https://x.com/imxiaohu/status/1828732438056755383