西風 發自 凹非寺

量子位 | 公眾號 QbitAI

ICML 2024時間檢驗獎出爐,賈揚清共同一作論文獲獎!

論文題為「DeCAF: A Deep Convolutional Activation Feature for Generic Visual Recognition

」,是賈揚清及其團隊10年前在UC柏克萊期間完成的工作。

ICML官方第一時間發推文表示祝賀,賈揚清回應道「深感榮幸DeCAF獲ICML2024時間檢驗獎,這是人工智能發展驚人的十年」,並把其他作者艾特了個遍。

作者之一、現谷歌DeepMind副總裁、Gemini專案聯合負責人Oriol Vinyals

也開麥表示「非常感謝這個獎(讓我感覺自己老了)」:

DeCAF是AlexNet的首個開源版本,我們透過它測試了這個卓越的ImageNet分類器學習到的特征是否能廣泛套用於其他視覺任務。事實證明,這個想法在今天仍然與最好的多模態模型非常相關!

兩位老搭檔也在評論區敘上了舊:

ICML今年是其舉辦的第41屆,投稿量9000+,接受率27.5%。除了時間檢驗獎,最佳論文獎也已出爐,Stable Diffusion 3論文等上榜

。

獲得時間檢驗獎的這篇論文,目前谷歌學術被引6012次:

先來看這篇論文都講了什麽。

著名框架Caffe的前身

這篇論文提出了一種名為DeCAF

(Deep Convolutional Activation Feature)的深度摺積啟用特征,用於解決通用視覺辨識問題。

主要是探索了在ImageNet等大規模標記數據集上預訓練的深度摺積神經網絡,其中間層特征是否能夠有效遷移到其他視覺任務中,即transfer learning的可行性

。

作者采用了Geoffrey Hinton、Alex Krizhevsky、Ilya Sutskever2012年提出的AlexNet

摺積神經網絡架構,包含5個摺積層和3個全連線層。在ImageNet數據集上進行預訓練後,凍結網絡權重。

提取了不同層的啟用作為特征,具體包括DeCAF5、DeCAF6和DeCAF7(最後一個隱藏層的啟用)。並在新任務上僅訓練簡單的線性分類器,同時保持DeCAF特征不變。

為了驗證這種方法的有效性,作者在多個標準電腦視覺基準測試上進行了實驗,包括物件辨識(Caltech-101)、域適應(Office數據集)、細粒度辨識(Caltech-UCSD鳥類數據集)和場景辨識(SUN-397)。

實驗結果顯示,DeCAF在所有這些任務上都取得了優秀的表現,常常超越當時的最佳方法。

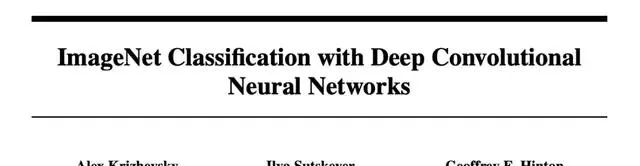

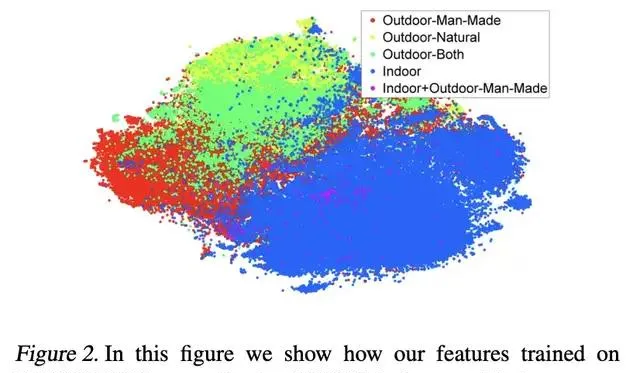

使用t-SNE演算法將高維特征對映到2D空間,展示了DeCAF特征在語意聚類方面優於GIST和LLC等傳統特征。

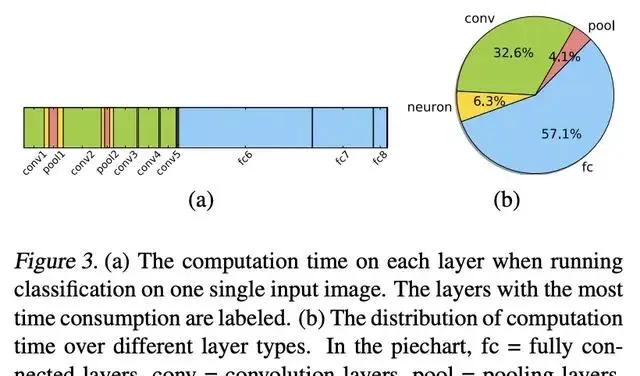

即使在訓練樣本稀缺的情況下,如單樣本學習,DeCAF仍然表現出色。論文還詳細分析了網絡各層的計算時間分布,發現全連線層占用了大部份計算時間。

此外,論文還探討了dropout等正則化技術的影響,特別是在DeCAF6和DeCAF7層上的套用。

最終作者開源了DeCAF特征提取工具和預訓練模型。

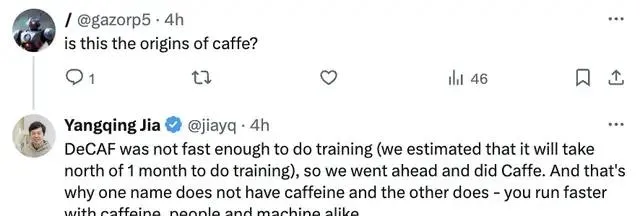

有網友看到這篇論文在十年後的今天獲獎後,突然反應過來「這是不是Caffe的起源?」

賈揚清也做出了回復:

DeCAF的訓練速度不夠快

(我們估計訓練時間需要超過一個月),因此我們轉而使用了Caffe。這就是為什麽一個名字中含caffeine(咖啡因)成分為零而另一個有的原因——無論是人還是機器,含caffeine都執行得更快。

最佳論文獎

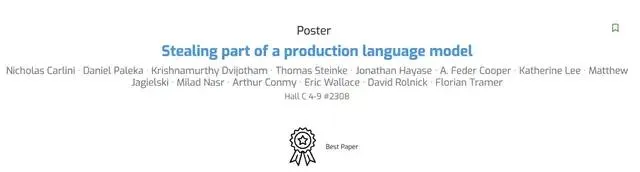

除時間檢驗獎,ICML 2024最佳論文獎也出爐了,今年獲獎論文共有10篇。

其中包括Stable Diffusion 3論文「Scaling Rectified Flow Transformers for High-Resolution Image Synthesis

」。

Pika聯合創始人兼CTO Chenlin Meng參與的「Discrete Diffusion Modeling by Estimating the Ratios of the Data Distribution

」這項工作也獲獎了。

參考連結:

[1]https://icml.cc/virtual/2024/awards_detail

[2]https://arxiv.org/abs/1310.1531

[3]https://x.com/jiayq/status/1815653822028738667

[4]https://x.com/jiayq/status/1815862939569774796