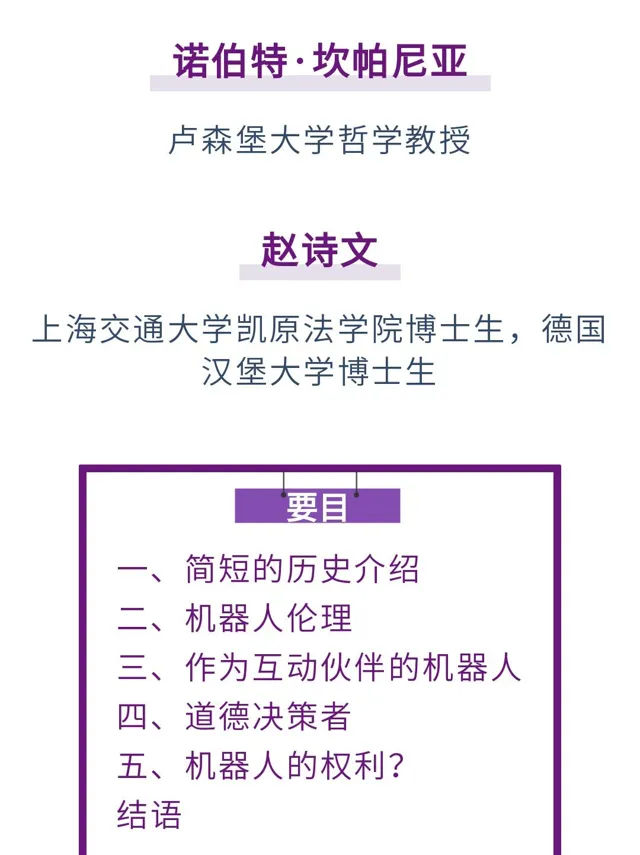

在過去幾十年裏,機器人技術經歷了迅猛發展,其中尤其引人註目的是機器人與人類以及動物之間日益增長的相似性。這種相似性不僅僅限於外部外貌,還涉及行為和越來越多的內部過程。機器人技術的發展導致套用倫理學中出現了一個新的分支,即機器人倫理學。本文將涉及機器人倫理學的一些基本問題,例如我們是否應該讓機器越來越類似於人類。我們應該意識到,隨著機器人與人類的相似性日益增加,遲早會出現一個問題,即我們是否應該像對待人類一樣對待機器人,是否應當給予它們權利。

一、簡短的歷史介紹

您進入一家麪包店,向櫃台後面的人打招呼,她以友好的方式回應您的問候,然後您下了訂單。當這個人為您服務時,他會對和您一起的兒子(5歲)非常友好地微笑,並給他一塊糖果。您的兒子向那位女士表示感謝。在她給了您想要的東西後,您也表示感謝。您付了錢,出去時祝麪包師「今天過得愉快」,她也祝您過得愉快。

以上場景每天都在世界各地上演。社會學家會談到三個人之間按照既定社會準則運作的互動——我們幾乎自動地按照這些準則行事,而一些憤世嫉俗者則聲稱這些準則只是套話。但無論這些套話多麽空洞,它們所傳達的東西遠比它們本身內容更重要。用康德的語言來說,透過它們,我們不僅將對方視為純粹的工具,而且將其視為目的本身。因此,這些準則表現了綜合性的功能,可以這麽說:我們向他人表達的每一個行為,都意味著我們將此存在視為道德共同體的一部份,與我們平等對待。

但現在我們假設,當您離開麪包店,在人行道上被攔住時,被告知櫃台後面的「女人」實際上是一個高度復雜的機器人,它不僅看起來像真正的女人,還被編程為根據前述社會規範而行事,即在我們的例子中,至少在日常社互動動的層面表現得像一個真人。幾個月來,科學家們一直在研究麪包店裏發生了什麽,然後對機器人進行編程,讓其按照人類正常的方式對常見情況做出反應。您作為測試物件,並未意識到這一事實。

現在您會被問到以下問題:「下次您再次進入這家麪包店,機器人站在櫃台後面,而且您不會混淆機器人和真人,此時您會如何行為呢?」您會像第一次那樣向機器人打招呼嗎——就像第一次您以為是在和一個人打招呼那樣?您會讓您的兒子在有人給他東西時說謝謝嗎,如果您的兒子沒有這樣做?您會希望在離開時,機器人祝您有美好的一天嗎?或者從現在開始,您會像對待普通atm機一樣對待機器人嗎?因為當您從atm機取款時,您不會對atm機說謝謝。而且,您在放入錢並按下按鈕後,也不會對彈出罐頭的飲料自動售貨機這樣做。如果麪包店裏不是一個高度復雜的機器人,而是一個簡單的麪包機,您可能也不會這樣去做。除了您實際上將如何行為的問題之外,我們還需探討與道德哲學相關的問題,即面對一個長著人臉、在一般社會互動層面也與人類相似的機器人時,您應該或能夠如何行為。機器人的外觀和行為是否會引起道德上相關的差異?如果答案肯定,從哪一點以及為什麽?它是否主要與機器人本身有關,即如果我們不以某種方式與之互動,即構成對它的不尊重,或者是否與我們和真人互動的方式方法有關,如果我們對長著人臉的機器人表現得不尊重?再假設一種情形,您進入麪包店並且第一個情形中的機器人不再站在櫃台後面。您怎麽知道立於櫃台之後的是人類,而不是一個看起來像人類的新機器人?

事實是,機器人在我們的生活中發揮著越來越大的作用。然而,這一事實是否受歡迎是道德哲學的一個重要問題,不僅因為機器人可能引發嚴重後果,還因為它們的數量和類人度不斷增加,引發了對道德基礎的質疑。實際上機器人可能還需要很長時間才能像前述麪包店的機器人一樣完善——現實是,我們已經不得不問自己,此類機器人的存在會對道德產生什麽影響。這些和類似的問題是所謂機器人倫理的核心。

在接下來的內容中,我將首先對機器人倫理學作為套用倫理學的一個新分支進行概述,並在此背景下區分機器人倫理學的兩種主要模型,即人類中心模型和我所說的機器人中心模型。然後,我將討論作為互動夥伴的機器人。這是機器人與人們長期使用的普通機器之間的一個關鍵區別。在第三部份中,我將討論作為潛在的道德決策者的機器人。具體而言,機器人越來越多地被置於此種境地,即它必須作出道德決定,也就是涉及生死的決定。最後一部份涉及這樣一個問題:有一天,我們是否能夠以及在多大程度上賦予機器人——即使不是全部,那麽也是特定的——權利——而且,機器人已經走在這條道路之上。

以下考慮主要是為了辨識機器人倫理中的重要問題並將其中出現的問題進行總結和抽象。為這些問題提供現成的解決方案超出了本文的範圍。其中一些問題已經以非常尖銳方式出現。現在,我們有機會制造出外表與人類非常相似的機器人,並且可以與人類進行相對復雜的互動程式。而且,我們已經可以選擇按照結果論或道義論對機器人進行編程,至少在非常初級的層面上是這樣。至於其他問題,目前還不確定它們是否會變得嚴重。例如,人們可能會想到這些問題:機器人是否應該有道德良知——或者至少具有同等的功能。不過,即使一些問題還沒有出現——也許永遠不會——這也不應妨礙我們現在討論它們,這樣當科學家提供了技術可能性時,我們也不會完全不知所措。

二、機器人倫理

由於過去二十年機器人領域的快速發展,實踐哲學的一個新分支也隨之發展:機器人倫理學。機器人倫理當然可以被視為技術倫理的一個分支,因為機器人最終是技術的產品。然而,它給技術倫理帶來了一個新的維度,這個維度也存在於所謂的電腦倫理中。雖然傳統的技術產品看起來不像人類,社交行為也不像人類,但機器人看起來越來越像人類,社交行為也越來越像人類。30年前,社會學家雪莉·塔克爾(sherry turkle)在其研究中提出,帶有人工智能的電腦器材會影響我們對自己的看法。塔克爾關於電腦的說法更適用於機器人,因為它們不僅具有人工智能,而且通常還具有與人類相似的特征。就像其他以「-ethik」字尾組成並表示特定領域倫理學術語一樣,機器人倫理學一詞也具有固有的模糊性,因此人們可以區分對此概念的激進和不那麽激進的兩種理解。此時,值得考慮的是與動物倫理學的概念進行簡要比較。動物倫理學作為套用倫理學的一個分支,專註於研究人類對動物的行為,自彼得·辛格(petersinger)的著作【動物解放】(animal liberation)出版近40年來,在套用倫理學中占據了核心地位。一方面,動物倫理學是實踐哲學的一個分支,用康德的話來說,它僅僅描述了我們尊重動物世界的義務。但是,動物倫理學也可以指實踐哲學的這樣一個分支,即它描述了我們對動物世界的義務。在第一個模型中,沒有賦予動物任何道德權利,然而在第二個模型中肯定有此類權利的空間,甚至面對動物之義務歸屬的基礎不必以權利為前提條件。第一個模型仍然停留在以人類為中心的框架內,主要將動物視為其福祉與人類福祉相關的存在。例如,我不應虐待狗,可能是因為它屬於他人,其主人會因我的行為而痛苦,或者因為我的行為可能反映出殘忍,這種習慣可能對我的其他行為產生負面影響。在這兩種情況中,他人的痛苦才是核心。狗作為狗,不是因其本身而被愛護。就此而言,我們可以稱之為一種以人類為中心的動物倫理模型。與此相對,第二種模型是以動物為中心的模型,因為它考慮動物本身的福祉。我不應虐待狗,這主要是因為人們能以狗的名義提出道德主張——正如人們所說,倡導性的——不能因為是狗而虐待它。

在機器人倫理學中,人們可以類似地區分以人類為中心的機器人倫理學和(如果表達允許的話)以機器人為中心的機器人倫理學。第一個模型只關心人類的福祉,第二個模型也(甚至並非第一性地)關心機器人本身的福祉。當機器人被摧毀時,你是否只看到它對其主人造成的傷害(也可能是情感性質的傷害),或者你是否也(也許主要是)考慮機器人本身的傷害或者痛苦,這是完全不同的事情。然而,我們首先需要確定機器人是否真的能夠受到傷害或感受痛苦。毫無疑問,今天許多動物物種都能感受痛苦。但這也適用於機器人嗎?如果我們不跟前述麪包店的機器人打招呼,它會不會感到被冒犯呢?如果沒有顧客向它打招呼、沒有人對它說好話時,它是否會陷入深深的沮喪之中——就和那些處於這種境遇的人類一樣?

然而,就機器人倫理而言,還能想到第三個模型。雖然將動物變為依道德而行事的存在似乎不可能,但這對於機器人至少原則上並非不可能。主要是因為機器人可以智能行事。人們無法教會動物進行道德思考;對於機器人,人們可以嘗試透過演算法來實作這一點。有些作者認為,我們應該盡快教會機器人進行道德思考和行事,將它們培養成「有道德的機器」(moralische maschinen)——就像我們教會我們孩子進行有道德的行為那樣。這種觀點認為,機器人融入社會互動過程的次數越頻繁,教會它們社會互動過程的核心要素(我們稱之為道德)就越重要。還有一個原因,即機器人變得越來越自主。過去的機器人基本上都是靜止的,只有在人類引導下才能在空間中移動,現在則可以自主移動。這意味著機器人正在變得越來越獨立於人類,不僅限於制造過程。某些電池供電的機器人(主要是吸塵器)已經能夠自己連線電源進行充電。機器人不再需要等待人類將其重新連線電源;它可以自行完成此操作。但自主性也意味著機器人始終會做出未事先編程的反應。不同於對機器人進行編程、使其始終執行某項操作,人們可以對機器人如此編程:它自己處理大量變量,然後以特定方式行事。

三、作為互動夥伴的機器人

眾所周知,「機器人」一詞源自捷克語,意思是「體力勞動」或「強迫勞動」。就此而言,機器人可以被視為一種機器,其主要目的在於從事體力勞動,從而使人類從這些勞動中解放出來。在此種視角下,機器人與人類幾個世紀以來制造的許多其他機器並無區別。然而,機器人的獨特之處在於其擬人化特征。並且,即使沒有擬人化特征,它們至少有動物化的特征。

機器人與人類或動物之間的相似性主要在於其外觀。近年來,機器人設計師成功地制造出了非常像人類的機器人(至少從一定距離來看),以至於人們不會註意到它們不是真正的人類。在從外部感知的行為層面,(機器人)與人類或動物的相似性也取得了巨大進展,例如機器人可以移動、說話等。在對外部刺激的反應方面,同樣也取得了顯著的進步。機器人可以執行口頭命令,甚至可以與人類言語互動。此外,機器人可以「辨識」一個人所處的情緒狀態,然後根據這種狀態做出相應的反應。前述最後兩個領域的進展提出了一個問題:是否有一天人們將無法制造出有情感的機器人,它也可以就自己的行為自主作出事先未編程的決定。

不過,為什麽我們要制造越來越像人類的機器人呢?在此,人們必須區分外部和內部相似性;在外部相似性情形,則必須區分外觀和行為相似性。然而,這兩類相似性不僅僅涉及技術能力的證明。如今,類人或動物的機器人不僅是一次性設計,其目標在於大規模生產。預計未來幾十年,此類機器人將越來越多地出現在我們的日常生活中。如果這樣,那就意味著在我們的日常生活中,我們不僅看重機器承擔任務的能力,還非常重視它們盡可能地不再僅被視為純粹的機器。

這在性領域尤為明顯。非人類的性伴侶越像人類,人們就越相信自己正在與人類發生性交,並且性滿意度可能就越高(至少推定如此)。人們可以在充氣娃娃領域發現類似的發展,但這種發展有其局限性。其中一些限制可以透過完善機器人來消除,例如玩偶的性被動性。機器人可以被編程為主動進行性交。一些作者認為,此類機器人的開發可以為賣淫問題提供長期解決方案。

對相似性的願景在醫療領域也能被較容易地解釋,此時,重點主要是與動物的相似性。使用類動物機器人進行治療比使用純粹「類機器」機器人更有效。因此,類動物機器人將取代在治療中偶爾使用的靜態毛絨動物玩具或真實動物。這同樣適用於類人機器人——它可以照顧病人或老人。

在性和醫療領域,機器人能夠避免自然生物中常見的、可能妨礙目標實作的問題。因此,女機器人永遠不會患偏頭痛——除非她被編程為有時會假裝患上偏頭痛——而且她也不會懷孕。此外,性病的傳播風險也被消除。還有一點,人們對機器人沒有義務——至少現在還沒有。看看用作治療的機器貓,它具有不會意外抓傷任何人或突然逃跑的優點。進而言之,從經濟角度考慮,在護理領域投資機器人雖然初期成本較高,但長期來看,其維護成本低於人類護理人員,因此投資回報較快。

如果機器過去主要用於狹義上的工作,那麽今天它們越來越多地用於服務,並且在許多此類服務中,「服務者」的外觀會對服務的成功起到作用。如果我們只是要將一件貨物從地點a運送到地點b,那麽機器是否類似於馱畜對我們來說並不重要。然而,對於某些服務來說,情況並非如此。如果我們因此決定不再由真人,而是由機器人提供相關服務,通常情況下,除了讓機器人與人類或動物之間的相似度越來越大,似乎我們沒有其他選擇——假如我們對可能的最有效的服務感興趣(通常可以假設如此)。然而,正如前文所暗示的那樣,這種相似性通常只限於與所涉服務重要的內容,並因此不考慮可能妨礙成功完成服務的所有其他內容。當我們使用機器人提供某些服務時,我們不僅希望它們能夠將我們從相關服務中解放出來,而且還希望它們能夠比普通人一樣好地完成工作,甚至不會更好——即沒有瑕疵的。如果因此談論到最大可能的相似性,那麽應明確,這只是最大可能的選擇相似性。

四、道德決策者

當我們想到,機器人須作出與道德相關的決定或從我們的角度來看與道德相關的決定時,選擇相似性的問題就會以一種尖銳的方式出現——機器人是否也將這些決策視為具有道德相關性,這是另一個問題。特別是用於軍事目的的機器人可能會面臨一些人類可能經歷的情況,而這些情況可能會引發道德困境。一個著名的案例是,一小群美國士兵在阿富汗山區執行秘密特殊任務時被一名牧羊人發現。這些士兵面臨的抉擇是:是否冒著牧羊人可能通知塔利班的風險放他離開,或者選擇殺害他?想要抓住他是不可能的。士兵們決定放他走。幾個小時後,他們遭到塔利班的襲擊。

此時,我們面臨的問題是,什麽決定了我們的道德決策,以及應當由什麽來決定這些決策。大致上,這裏可以區分兩種模型:邏輯中心論和情感中心論。第一個模型將實踐理性視為道德行為的唯一合法起源,與此同時,第二個模型將這種行為直接與情感或更一般性地與感性動力聯系起來,例如斯密的同情或叔本華的憐憫。如果我們從道德決策過程的純粹邏輯中心論模型出發,像康德那樣,將一種行為的道德性取決於我們是否會在沒有傾向的情況下執行它,那麽我們可能會考慮設計沒有情感和傾向(即不受情感性決策因素影響)的機器人。盡管康德沒有斷言情感性決定因素不能在行為決定中發揮作用,但他確實說,它們無論如何不能是必要的決定因素。這些因素在決策過程中的存在可能會引起人們對該行為道德性的懷疑,因為我們無法確定,即使我們沒有這些因素,是否還會進行該行為。如果機器人僅受理性決策因素影響,而不受情感性決策因素影響,那麽這種質疑就不會存在。

康德將只能由理性原因決定的存在稱為自主記憶體在。對他而言,自主記憶體在因其價值而非價格而具有尊嚴,因而應受到絕對尊重。在此意義上,機器人是自主記憶體在嗎,或者有一天可以建造出這種自主記憶體在的機器人嗎?新機器人與舊機器人的區別在於,新機器人能夠進行人類在類似情形中預期采取的行為,而該行為完全能被視為有道德的行為。

讓我們透過以下三種場景來比較美國士兵的情況:

情景1:阿富汗山區的人類必須自己決定如何對待牧羊人。

場景2:阿富汗山區有遙控機器人,它們行為的決定是由處於幾百公裏外控制中心的人作出。

場景3:阿富汗山區有一些機器人,它們經過編程,可以根據外界提供給它們的資訊作出「決定」。它們的程式說:不殺害任何不對你們構成威脅的人!

在前兩種情況下,直接作出決定的是人類。然而,存在一個關鍵區別。無論第一個場景中的士兵多麽勇敢,都很難假設他們不會擔心自己的生命安全,也不能假設他們不會憐憫牧羊人。在第二種情況下,控制者不會擔心自己的生命安全,因為他們不直接面臨決策的後果。然而,人們可以假設他會憐憫牧羊人。

接下來我們來看第三種情況。此時,機器人會如何行動?它們會不會射殺牧羊人?它們肯定會考慮牧羊人通知塔利班它們存在的可能性。它們也會為這種可能性計算出一定的概率。但這個概率是多少,又是如何確定的?它們以多大的概率得出存在危險的結論?假設它們確定了這樣的危險:他們會射殺牧羊人嗎?最後,它們被編程為不會殺害任何不對它們構成威脅的人,也不會殺害每一個對它們構成威脅的人。當然,人們可以將它們進行這樣的編程,就像對它們可能以兩種方式進行編程一樣。但是,在這種情況下,一個機器人可能如何決定,尤其是它可能如何作出一個決策呢?一個機器人內部具有兩個相互矛盾的行動指令,但沒有明確規定優先級,會發生什麽情況呢?

諾埃爾·夏基(noel sharkey)認為,人們不應允許自控軍用機器人執行殺戮任務,因為機器人無法區分戰鬥人員和非戰鬥人員,也無法區分危險和非危險對手。具體而言,這種區別的前提是人們能夠認識到對方的意圖,根據夏基的說法,這就預設了人們具有一種(即使是隱含的)心理理論。以我們所提案例為例,機器人應能辨識出阿富汗牧羊人的身份;它們還應能夠推測阿富汗牧羊人的意圖,這又要求它們對地緣政治局勢和當地人對塔利班的態度有足夠的了解。此時就提出一個問題,一方面,機器人是否能夠擁有必要的資訊,另一方面,它是否擁有處理這些資訊的必要經驗。無論人們在倫理決策中賦予資訊擁有的重要性有多大,經驗仍然是一個不可忽視的因素。它構成了我們處理資訊、然後作出決定的背景。

雖然夏基認為不應該建造用於殺人的軍用機器人,但洛克豪斯特(g. j. lokhorst)和凡·登·霍芬(j. van den hoven)認為機器人比人類人能夠遵循明確規則,但它們並不擅長理解社會背景和預測可能的意圖。」更可靠,而且總的來說,它們殺死的人數比人類士兵少。他們確信,我們對機器人行為的編程控制比對訓練有素的人類士兵的控制更為精確。如果人們對機器人進行編程,使其不會殺死任何沒有直接用武器威脅它的人,那麽它就不會殺死這樣的人。這對於人類士兵就不同了,他們承受著持續的壓力,有時會「神經失常」。

在我們討論是否應該賦予機器人權利的問題之前,這裏最後需要問的一個問題是,我們可以做些什麽來保護我們面對機器人的自己的權利。朔伊茨(m. scheutz)認為,純粹理性的機器人可能利用我們的情感聯系來操縱我們。也就是,雖然我們可以在情感上與機器人建立聯系,但機器人對我們卻不如此。為避免這種情況,他建議:「此時可能需要采取(一個)激進的步驟,即為未來的機器人賦予類似人類的情感和感覺。」朔伊茨的想法是,情感最終會阻止我們傷害他人,哪怕這樣做對我們有利。人們如果希望避免機器人操縱我們,就必須為賦予它們類似人類的情感或與人類情感同等的功能。若機器人有一天要成為道德決策者,那麽僅僅擴充套件它們的人工智能以使其也包括道德上的智能是不夠的,還必須賦予它們人工情感——或至少在功能上等同。因此,我們可能擁有一個機器人可能遭受苦難的世界,這將引發我們是否也須賦予它們權利的問題。朔伊茨認為,保護我們免受機器人傷害的同時,也應考慮保護機器人免受我們的侵害。

五、機器人的權利?

傑里米·邊沁(jeremy bentham)認為,一個存在是否會思考或說話並非與倫理相關的問題,而是它是否可以感覺,尤其是否可以感受痛苦。在他眼中,許多動物都是有感受痛苦能力的存在,因此在功利主義計算中須考慮到它們的福祉。

機器人會感受痛苦嗎?我們可以將痛苦概念化,使其只能套用於具有例如神經系統的有機元件(hardware)存在。因此,透過語意上的巧妙手段解決了一個形而上學問題——或已經解決了。

但現在的情況是,人們在意識到其他生物的痛苦能力之前,並沒有等待解剖學和生理學的發現。通常的痛苦概念是現象學的,即它基於我們體驗環境中眾生的方式方法以及我們與它們之間的相互認同程度。人類之所以覺得某些未知動物會感到痛苦,而不認為某些未知植物會痛苦,並不是因為我了解這些生物的內部構造,而是因為我所觀察到的現象。這裏必須考慮的另一個因素是互動,它既是認同的結果,也進一步加深了認同。

我們不應該像邊沁那樣問一個存在是否會感受痛苦,而應該問我們是否以及在多大程度上可以與一個存在互動和認同,其中外表和行為都發揮著作用。恰恰由於這種互動和認同,我們才認為生物具有感受痛苦的能力。此存在是否能真正感受痛苦的問題實際上無關緊要。正如康德所言:我們在一個存在中所感受的並非痛苦本身,而只是對於我們的痛苦,而對於我們的這種痛苦顯現於與該存在可能的互動中。這個存在的內部發生了什麽,首先取決於該存在與我們的關系。這種關系部份是由前進演化過程中出現的先天機制決定。

我們對動物的外觀和互動方式的認識非常有限。我們可以飼養和訓練動物,最近還可以對它們進行基因操縱,但目前我們還無法創造出一種動物,使其像一些現在的機器人一樣擁有類人的外觀和行為。我們必須接受動物的自然狀態。然而,在談到機器人情形,我們面臨著一個基本的選擇:我們有能力創造機器人且遲早須賦予其權利,因為至少對我們來說,它們滿足作為權利歸屬依據的條件。無論機器人作為一個本體性存在是什麽以及它與我的本體性自我有多大的不同——作為一個我所能接觸到的面對我的現象性存在,它有朝一日在所有相關方面都可能與我賦予其權利的那些現象性存在相似。

人們肯定會反駁說,機器人由無機物構成,而迄今為止我們賦予權利的存在始終是由有機物組成。但構成生命體的物質本質是否應與道德相關呢?如果有一天我們能夠接觸到來自另一個星系的生物,並且事實證明我們可以與這些生物如同人類同胞之間一樣進行最重要的互動,那麽我們真的會將對權利的認可取決於生化分析嗎?即使構成生物的物質性質與道德相關,仍可指出,人們已經在嘗試建造其中央控制系統(其大腦,如果可以這樣說)由有機物質構成的機器人。最遲當第一批生物機器人到來時,我們將面臨這樣的問題:我們應該如何有道德地對待它們以及我們是否也應賦予它們權利。

從康德的角度來看,人們可能會反對說,只有能夠將自己視為本體存在的現象性存在才值得被視為道德存在。但我們如何知道一個現象性存在是否可以將自己視為本體性存在呢?這些知識難道不是來自我們與這個存在的互動嗎?但對於我們來說,互動總是在世界上發生,即在現象層面。因此,關鍵不在於現象性存在是否能真正自我認同為本體存在,而在於它的行為是否讓我們有理由相信它能如此認同。當機器人在其與我們日常互動中的行為方式使得我們不再有充分的理由否認它們的本體自我時,我們就會將其歸為本體性存在。

但是,正如另一個可能的反對意見,機器人最終不也只是一台機器嗎?這表明,機器人不具有任何典型的人類特征。我們有時不也會形容某些人像機器一樣行動機械、可預測,缺乏感情和自發性嗎?毫無疑問,目前機器人實際上還只是機器。然而,現在機器人領域的進步讓我們面臨著一個問題:我們是希望擁有僅作為機器的機器人,與之互動有限,還是繼續沿著現有道路前進,最終可能達到一個點——斯帕羅(r. sparrow)描述如下:「當我們無法讓機器人死亡時,機器人將成為人類,無需面對我們在 考慮是否讓一個人類死亡時所面臨的相同道德困境。」然而,這裏必須問 的問題是讓一個機器人死亡到底意味著什麽。斯帕羅至少應該為「死亡」這個詞用引號標註。

這裏所提及的問題只出現在哲學家身上,這一事實可以從美國防止虐待機器人協會(aspcr)的存在——自1999年以來——以及南韓在近10年將機器人免受破壞和虐待的保護納入法律的考慮中看出。

結語

今天,我們面臨著一個根本問題:我們是否應該繼續努力制造最終在道德方面或至少在本質上與人類沒有區別的機器人,或者我們是否應該追隨當前的趨勢終止機器人技術。另一個相關問題是:我們是否希望機器人承擔越來越多以前只有人類才能執行的工作和服務,因為這些工作和服務的完成以前需要只有人類擁有的技能?我們仍然可以將病人護理中不太有吸重力的方面留給人類,但我們也可以將這些服務交給機器人。但若我們將這些服務交給機器人,我們就須面臨一個問題,我們是否應該讓這些機器人盡可能類人,以便病人在所有相關方面都能得到同等的服務——如果不是更好的服務。在裝配線上制造汽車的機器人是否與人類相似並不重要。但照顧病人的機器人是否看起來像人類、行為是否像護士,則至關重要。

凱特·達林(kate darling)在接受【世界報】采訪時表示,玩具行業正推動制造能夠與我們建立情感聯系的機器人。回想前二三十年,當時所謂的「電子寵物(tamagochi)」讓那些忘記「餵」它們的孩子們淚流滿面,因為電子寵物「死了」。對於達林來說,玩具行業——但有人可能會補充說,整個機器人行業——擁有如此強大的力量,以至於人們再也無法停止其發展。孩子們越早在互動中與機器建立情感聯系,他們對機器的認同感就越強。

無論我們如何重視探討如何保護自己免受機器人的傷害,我們都應該將這個問題與另一個問題聯系起來,那就是我們如何保護自己免受生產這些機器人的工業的影響,而這些機器人對我們的影響也將受到保護。因此,機器人倫理超越了人類如何塑造未來的問題。也許達林和其他人正確認識到發展勢不可擋。但必須註意到,這種不可阻擋並不具有純自然事件的特征。然而,如果人們共同努力,這種趨勢仍有可能被改變。

往期精彩回顧

趙丹|國際投資仲裁裁決的司法審查及中國企業應對——以新加坡司法實踐為例

池梓源|國企改制後股份合作制企業性質刑事認定的困境及解決路徑

王殷舟|刑事被害人精神損害賠償:正當性證成與實作進路

目錄|【上海法學研究】2024總第11卷

雷娜特·肖伯 張韜略 譯|使用人工智能構成義務侵害?論使用生成式人工智能的註意義務

彼得·霍莫基等|大型語言模型及其在法律中的可能用途

上海市法學會官網

http://www.sls.org.cn

上觀號作者:上海市法學會