如果你走到一個長著人頭的機器人面前,它先對你微笑,你會怎麽做?你可能會回以微笑,也許會覺得你們兩個正在真誠地互動。但機器人如何才能知道讓你回以微笑呢?

雖然我們已經習慣了熟練的語言交流的機器人,這主要依靠ChatGPT等大型語言模型的進步,但它們的非語言交流技能,尤其是面部表情,卻很令人期待。設計一個機器人,可以展現類人的面部表情,並且知道何時使用它們是一項艱巨的任務。

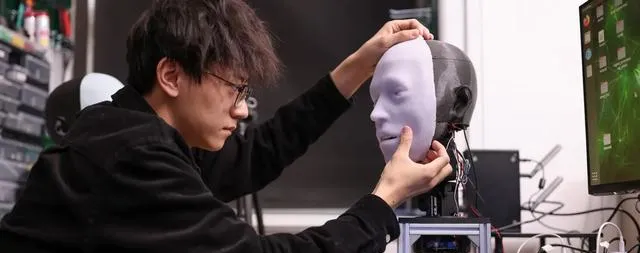

Emo包含26個執行器來幫助模仿人類微笑

在過去的五年裏,哥倫比亞大學創意機器實驗室的工程師們一直在將機器人的反應能力提高到毫秒級。他們的研究結果詳細發表在【科學機器人】雜誌上的一項新研究中。

Emo機器人頭部能夠在840毫秒內預測和映像模仿人類面部表情,包括微笑。人工智能非常擅長模仿人類對話——重點強調「模仿」。但當談到情感時,機器人仍然有很多工作要做。機器誤判何時微笑不僅會造成尷尬,還會引起人們對其人工行為的關註。

相比之下,人類大腦非常擅長即時解釋大量視覺線索,然後對各種面部動作做出相應的反應。除了讓人工智能機器人學習表情的細微差別變得極其困難之外,構建一個能夠進行逼真的肌肉運動的機械臉也很困難。

Emo的創造者試圖解決其中一些問題,或者至少幫助縮小人類和機器人表達能力之間的差距。為了構建他們的新機器人,由人工智能和機器人專家Hod Lipson領導的團隊首先設計了一個逼真的機器人人體頭部,其中包括26個獨立的執行器,以實作微小的面部表情功能。 Emo的每個瞳孔還裝有高分辨率網絡攝影機,可以追蹤人類對話夥伴的眼睛——這是人們的另一個重要的非語言視覺提示。最後,Lipson的團隊在Emo的機械部件上覆蓋了一層矽膠「皮膚」,使其變得不那麽……毛骨悚然。

在此基礎上,研究人員構建了兩個獨立的人工智能模型來協同工作——一個透過目標面部的微小表情來預測人類表情,另一個則快速對機器人面部發出運動反應。 Emo的人工智能利用人類面部表情的樣本影片,逐幀學習復雜的情感。在短短幾個小時內,Emo就能夠觀察、解釋和響應人們開始微笑時容易做出的細微面部變化。更重要的是,它現在可以在大約840毫秒內完成此操作。

「我認為準確預測人類面部表情是人機互動的一場革命」,哥倫比亞大學工程博士生兼研究主要作者胡宇航(音)本周早些時候表示。「傳統上,機器人的設計並沒有考慮人類在互動過程中的表情。現在,機器人可以整合人類面部表情作為反饋。」

目前,Emo缺乏任何語言解釋能力,因此只能透過分析人類面部表情進行互動。Lipson、Hu和其他合作者希望很快將身體能力與ChatGPT等大型語言模型系統結合起來。如果他們能做到這一點,那麽Emo將更加接近自然的人類互動。當然,除了微笑、傻笑和咧嘴大笑之外,相關性還有很多,而科學家們似乎正在關註這些。例如,應謹慎對待撅嘴或皺眉等表情的模仿,因為這些可能會被誤解為嘲笑或傳達意想不到的情緒。