蘋果的人工智能研究揭示了一種模型,將把對Siri的命令更快、更高效地轉換為文本,便於大型語言模型解析。

在即將於6月的WWDC公開釋出其人工智能計劃之際,蘋果進行了人工智能研究。到目前為止,蘋果已經釋出了各種各樣的研究,包括一個影像動畫工具。

最新的研究論文由VentureBeat首次釋出。這篇論文詳細介紹了一種稱為ReALM(Reference Resolution As Language Modeling)的方法。

根據模糊的語言輸入執行任務的電腦程式被稱為參考解析。這是一個復雜的問題,因為電腦不能像人類那樣解釋影像,但是蘋果可能已經找到了一種使用LLM來簡化解析的方法。

當與Siri等智能助手交談時,使用者可能會參考許多上下文資訊進行互動,如背景任務、顯示的數據和其他非對話實體。傳統的解析方法依賴於非常龐大的模型和影像等參考資料,但是蘋果透過將所有內容轉換為文本來簡化解析。

蘋果發現,其最小的ReALM模型表現與GPT-4類似,但參數更少,因此更適合器材上使用,例如 iPhone。增加ReALM中使用的參數使其明顯優於GPT-4。

這種效能提升的原因之一是GPT-4依賴於影像解析來理解螢幕上的資訊。大部份影像訓練數據是基於自然影像而不是充滿文本的人工程式碼網頁,因此直接的OCR效率較低。

將影像轉換為文本使ReALM無需使用這些先進的影像辨識參數,從而使其更小、更高效。蘋果還透過包含約束解碼或使用簡單的後處理功能來避免錯誤。

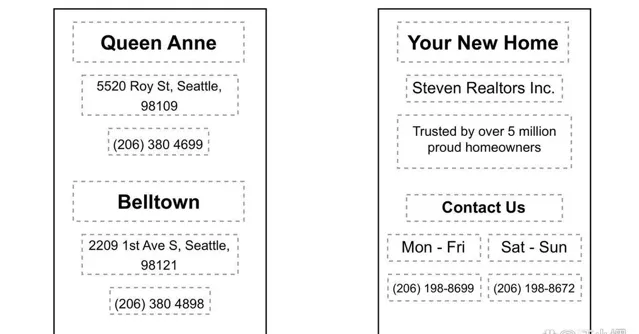

例如,如果你瀏覽網站並決定想要打電話給某個企業,只需說「打電話給企業」,Siri就會解析你的意圖並找到頁面上標記為企業號碼的電話號碼,並自動撥打,無需進一步提示使用者。

蘋果正在努力在2024年的WWDC釋出一項全面的人工智能戰略。一些傳言表明,該公司將依靠更小的器材上的模型來保護私密和安全,同時為問題更多的離線處理特許其他公司的LLM。