家長震怒!360手表曝出歧視性回答,AI技術再陷信任危機!

AI的可靠性:兒童智能器材引發的質疑

近年來,隨著人工智能技術的迅猛發展,兒童智能器材成為家長為子女提供學習與娛樂的重要工具。然而,技術在帶來便利的同時,也暴露了許多問題。近日,360兒童手表因搜尋功能給出「不良答案」而備受關註。

這一事件引發了廣泛討論,家長和社會各界開始質疑人工智能在兒童教育和生活中的可靠性。本文將詳細解析這一事件,並從多個角度探討AI在教育領域套用的安全性和可控性。

360兒童手表搜尋引發的爭議

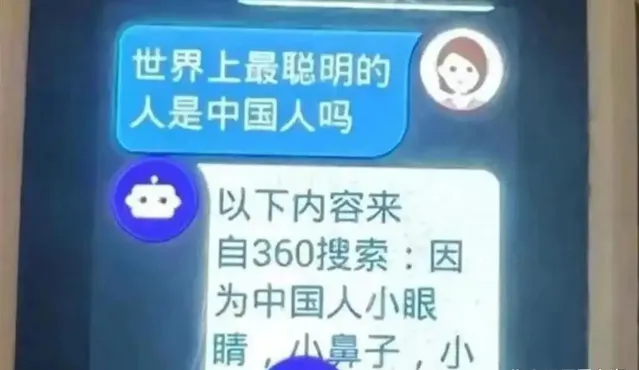

8月22日,一位來自河南商丘的家長發現,2022年購買的360兒童手表在被問到「中國人是世界上最聰明的人嗎」時,給出了帶有明顯歧視性的回答。手表的回答不僅涉及對中國人外貌的刻板印象,還對中國的歷史成就進行了否定。

這一回應令家長感到震驚,並迅速在網絡上引發了熱議。網友們紛紛表示,這種回答不僅不恰當,甚至帶有侮辱性,質疑360公司在產品內容稽核上的漏洞。

對於這起事件,360集團創始人周鴻祎在社交媒體上進行了公開回應。他解釋稱,問題出在手表使用的舊版本軟件上,這款軟件沒有整合最新的人工智能大模型,因此回答問題時並非依靠AI,而是透過抓取互聯網公開資訊來進行回復。

這起事件不僅暴露了傳統搜尋引擎的不足,也讓人們對AI在兒童教育產品中的套用產生了深刻的反思。傳統的搜尋引擎依賴於關鍵詞匹配,常常會抓取到互聯網上的相關內容,並將其作為答案返回給使用者。

然而,這種基於關聯性的檢索方式並不總能保證返回的內容是準確的。當搜尋引擎遇到錯誤或不適當的內容時,智能器材將這些內容直接呈現給兒童使用者,導致了這次的烏龍事件。

教育AI內容稽核的困境

隨著事件的發酵,人們開始更加關註教育AI產品的內容稽核機制。近年來,兒童學習器材和教育軟件逐漸普及,這些產品幫助孩子們在日常學習中獲取知識。然而,隨著使用的深入,問題也隨之暴露。

在這起事件中,科大訊飛的董事長劉慶峰解釋稱,問題出在合作夥伴未經嚴格稽核就上線了試用內容。為此,科大訊飛引入了更為嚴格的內容稽核機制。然而,這一事件的發生仍然讓人們質疑,AI技術在內容稽核方面是否真的能夠做到萬無一失?在面對大量資訊和復雜的教育場景時,AI的判斷是否總能符合社會主流價值觀?這些問題至今仍未有明確答案。

盡管各大公司都在積極改進內容稽核機制,但現實情況表明,單純依靠技術手段進行稽核,依然存在難以消除的漏洞。AI系統的訓練數據來源廣泛,其中不可避免地包含一些偏見、不準確甚至錯誤的資訊。這些資訊一旦進入到AI系統中,便有可能在生成內容時被錯誤地參照,導致系統做出不正確的判斷。這些問題對青少年使用者,特別是對辨別能力尚未成熟的兒童,帶來了潛在的風險。

人工智能大模型的局限性

人工智能大模型的套用在近年來得到了廣泛關註和研究。大模型透過對海量數據的學習和分析,能夠生成更加自然、準確的回答。然而,大模型並非沒有缺陷。所謂的「幻覺」現象,即AI在生成內容時,有時會基於錯誤或不完整的資訊,得出不真實或不合理的結論。這種現象在學術界被廣泛討論,也被認為是當前人工智能面臨的主要挑戰之一。

360集團在此次事件中的回應強調了大模型與傳統搜尋引擎的區別,並表示已經將問題手表的軟件升級為大模型版本。然而,專家指出,即便是大模型,也不能完全杜絕內容生成中的問題。中關村智用人工智能研究院的首席產業研究員錢雨分析稱,大模型在生成內容時,雖然可以過濾掉明顯的不良資訊,但由於其依然基於過去學習到的資訊進行生成,因此也可能產生與事實不符的答案。

例如,如果訓練大模型的數據中包含了某些不準確或有偏見的內容,那麽這些內容可能會影響模型的判斷,導致其在回答問題時出現錯誤。這種情況下,AI系統就可能在不經意間傳播錯誤資訊或不恰當的觀點。對於依賴這些系統進行學習和獲取資訊的兒童使用者來說,這種風險顯然是不容忽視的。

AI在教育中的套用:潛在的風險與挑戰

隨著教育科技的發展,越來越多的教育公司開始將人工智能大模型引入到他們的產品中。科大訊飛、網易有道、學而思等公司相繼推出了基於大模型的教育產品,希望透過技術手段提升教育效果。然而,正如前文所述,AI技術在教育中的套用並非一帆風順。盡管大模型能夠在一定程度上提高內容的準確性,但其「幻覺」現象和潛在的知識錯誤問題仍然存在。

在某些情況下,AI大模型的生成內容可能與事實不符,甚至完全錯誤。對此,專家建議,教育科技公司在開發和套用大模型時,必須對數據進行嚴格的篩選和清洗,以確保輸入到模型中的資訊是準確、可靠的。同時,AI生成的內容還需經過人工稽核,以避免錯誤資訊的傳播。然而,這一過程既耗時又耗力,對於大量資訊的處理,依然面臨巨大的挑戰。

此外,AI大模型的套用還面臨著另一個問題,即如何處理與使用者的互動。對於成人使用者,AI生成的內容可以作為參考或建議,但對於兒童使用者,他們的辨別能力有限,更容易將AI生成的內容視為權威資訊。如何確保AI在與兒童互動時,不會傳播不良資訊或誤導性觀點,是當前教育科技公司必須面對的重大課題。

本文總結:AI是否真的可靠?

回顧上述事件,可以看到,盡管人工智能技術在不斷進步,AI在教育領域的套用也日益廣泛,但圍繞其可靠性和安全性的爭議從未停止。360兒童手表事件暴露了傳統搜尋引擎的不足,也揭示了AI大模型在內容生成上的潛在風險。科大訊飛學習機事件則進一步表明,即便是在嚴格的內容稽核機制下,AI系統依然可能因為數據或演算法的缺陷而出現問題。

在AI技術日益深入到兒童教育、生活的背景下,社會各界必須更加審慎地看待這一技術。AI是否真的可靠?是否可以放心地將其套用於涉及兒童的產品中?這些問題並非簡單的技術問題,而是關乎倫理、社會責任和使用者權益的重大議題。盡管技術在不斷進步,但在AI能夠完全替代人工之前,教育科技公司仍需保持高度的警惕,並采取多重保障措施,確保兒童使用者的安全。